(不骗你)CMU 召开 SIGBOVIK 2017 大会,生成对抗网络被轰下神坛

新智元推荐

来源:知乎,作者授权转载

作者:罗浩、吴晓辉、许九祀、Yivan

整理:张易

【新智元导读】SIGBOVIK 2017 大会昨天在 CMU 召开, 会议论文《抵制暴力 GAN 》引起广泛关注。

我对深度学习、深度森林和深度贝叶斯起誓,我下面说的都是真的。

昨天(2017年3月31日)下午五点半,SIGBOVIK 2017 年度大会在CMU 的Rashid Auditorium ( Gates-Hillman Center 4401) 那个房间里如期召开了。

作为小众研究的年度盛会,SIGBOVIK 已经连续举办11年了。它没放过的小众领域包括神经网络、困惑理论和毛虫因果论等等。

是的,神经网络这么热,可它还是没放过。

按大会组织者的说法,他们欢迎三类研究:搞笑想法的搞笑实现;严肃想法的搞笑实现;搞笑想法的严肃实现。

好了,还是说些大家关心的:本届会议最出名的论文——《抵制暴力GAN》(Stopping GAN Violence)。

作为SIGBOVIK 2017的评审论文,《抵制暴力GAN》此前已搞得满城风雨。今天,我们特地转载了几位高人对此文的解读和评论。祝你在这个特殊的日子里,用深度学习辨别谎言,用 AI 呼唤和平。

震惊!生成对抗网络走下神坛,竟是这等原因?

作者:罗浩.ZJU

链接:https://www.zhihu.com/question/56841301/answer/150790748

来源:知乎

这是个搞笑论文会议,我还一本正经的review的文章,当我啥也没说,难受.

谢邀,早上粗粗看了一下

赤露露的标题党,我看中文标题可以这样取:震惊!生成对抗网络走下神坛,竟是这原因?

看到标题我是满怀期待,以为是个创举,看完之后特么这是来搞笑的吗。

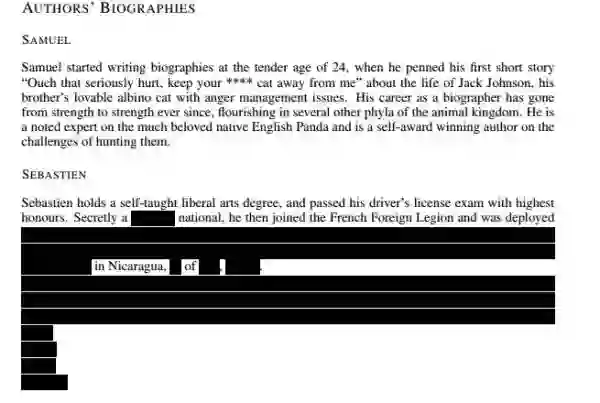

先来看下作者简介

这特么什么鬼个人简介,一个考到了驾照的军人?黑人问号脸。这一坨黑色的神奇马赛克又是什么鬼。还有发表短片小说也是神奇,我...

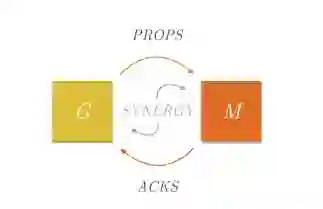

然后内容,文章提出GM模型,一个生产网络G,一个监视网络M,不想GAN的GD互相对抗成长一样,GM讲究和谐统一,互相成长互相进步(恩,身为党员这种思想我是很赞同的)。

然后训练思想,M最大化G,G最大化M,话说这样训练真的不会出现M,G一直互相怼高对方然后最后都奔着无穷大去了吗?这种正正促进的系统难道不是不稳定的吗?

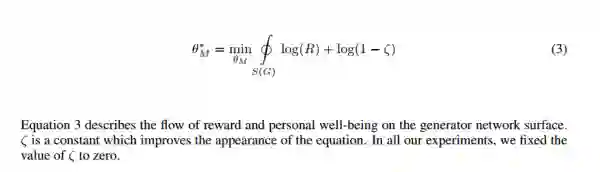

然后下面又是一个槽点,log(1-s),s解释到是一个固定值,我们取S=0,特么log(1-0)不就是0吗,这你写进来干嘛,强行增加公式长度?另外这个R是什么东西,我好像整篇文章没找到

接下来我们来看下cost,首先我看到这个$美元符号的时候我有点懵逼,好像没看过这样的数学符号

直到我看到了下面这一句

这个花费(损失值)是1876美元,生动形象没毛病,最后我们来看下结果,首先结果没有任何具体的数字表面,只有一张图

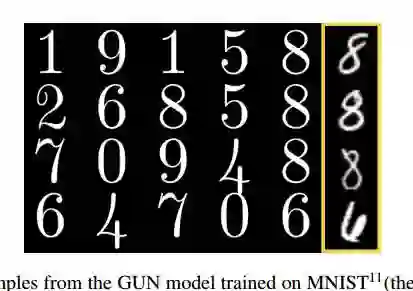

你们的mnist的数据集好像和我的不一样,我的mnist应该不会教我写出左边这样的数字,左边那些打印字体是个什么样的神奇存在

心疼一下这个会议的reviewers。

吐槽了这么多,还是给点正能量,这样一篇"民科"气质的搞笑文章,看得我简直不知该如何评论。不过深度学习确实现在很火了,大家不管水平高低都在捣鼓着深度学习,挺好的,对这篇文章的作者们给点鼓励吧,下次弄个正统一点的文章,不过SIGBOVIK的审稿人还是拒了这篇文章吧,bengio,hinton和lan fellow et al.都在我心中是神一样的存在。

搞笑我们是正经的,可惜有很多梗看不懂

作者:吴晓晖

链接:https://www.zhihu.com/question/56841301/answer/150632327

来源:知乎

作者提出了GUN,抵抗暴力,宣扬和平(其实是来搞笑的),还特意搞了个NoN表情上去。

一整篇论文都在宣扬道德、仁爱、协作,抵抗暴力的GAN。动机就是看了部什么鬼电影,还扯上了TCP协议握手协议。(一本正经地胡说八道)

算法就是用一个生成器G和一个监视器M,共同进步,互爱互助(听起来就很gay有没有),然后每一步迭代,要放把结果放到PPT上展示(还温馨提醒要记得带U盘和准备投影仪)。

还说后续要结合 nurtural gradients、k-dearest neighbours这些什么鬼东西。然后放出实验结果(全是很好看的打印字,一看就是假的好吗!)。

结果实验证明,GAN的暴力是不道德并且是没必要的。然后还说GUN这玩意儿的潜力很大,它的潜力在于你认为结果很好它就很好(啥玩意...)

最后还安利别人来填坑(填你妹~)。居然还附了搞笑代码(我有点怀疑作者会不会被打死)

其实里面还有很多没看懂的梗(隐约地感受到那是个梗)

经过知友提醒,我之前把Motivator看成了Monitor,所以译成了监视器M。我认为Motivator在这里应该译为鼓励师M(程序猿们听了有没有一丝小兴奋呀~)

有些梗很偏啊,我来按顺序解释一下

作者:许九祀

链接:https://zhuanlan.zhihu.com/p/25651305

来源:知乎专栏

就在三分钟之前,我看到微博上的一名同学转载了一篇论文:《Stopping GAN Violence: Generative Unadversarial Networks》,好像是CMU发的(评论区指出,一作是Oxford的,但是这个会是CMU的)。看到这个名字就莫名其妙的有一种不祥的预感。

点开之后,果然。

由于这篇文章写的实在是画风诡异,因此完全无法总结,总结就是罪过,就是剧透,就毁掉了三位作者的杰出工作。

推荐各位科学算命小能手们干活干不动的时候看一下,真的,深深的被打动了,21世纪人工智能领域最伟大的论文之一,Literally“人类群星他妈的闪耀时”了。

刚才又看了一遍,发现有的梗还是挺偏的,在这里按顺序解释一下。

abstract

winner-shares-all,winner-takes-all在我印象中是博弈论里面的一个模型,和经济学里的“马太效应”类似。

both the moral and log-likelihood high ground:moral high gound,道德高地,记得那张图吗,“你站在道德高地上就不冷吗”那张。

最后一句话是谐音梗,the optimal solution to NoN (none) violence is more GUNs.

作者顺序是按照欧冠上各自国家的表现排的。

Introduction

circa:拉丁文,“大约,大概”的意思。

intractorable:typo梗,tractor是拖拉机的意思,intractable这个词儿这么一打有种说不出来的喜感。让我想起了我的兄弟给人发套瓷儿信的时候开头就是一个“Deer Professor”(后续:该人的兄弟,which is 我的二阶兄弟,发邮件的时候写的是“Dear Processor”,怎么说,江山自有才人出,各领风骚数百年吧。)

“……demonstrate that methaphorical tractors could in fact be driven directly through the goddamn centre of this previously unploughed research field”:呼应谐音梗和typo梗,methaphorical应该是metaphorical,centre应该是center(评论区小伙伴指出center的英式拼法是centre,由于该文章用词采用英式拼法,因此这个词在这是对的),unploughed:未开垦的,荒凉的,后面那句Subject to 欧洲农业安全和三不管管理局……

GANs,GANGs,CAPONEs——Gang什么意思应该都知道,但是Capone就是那个因为逃税被IRS和FBI联合拿下的黑手党老大。

counterfeit currency:假币,十二个硬币拿天平秤的那个问题好像有时候就叫做counterfeit problem。

Back-of-the-envelope calculation:草草估算,拿纸划拉一下的那么算。

Related Work

Smith & Wesson:美国军火制造企业,“生成模型”。

Fabbrica d’Armi Pietro Beretta:16世纪的意大利军火制造商,“one shot learning”。

Generative Unadversarial Network

公式3和注释9:喷了信息几何臭名昭著的数学要求,信息几何原版教科书是创始人用日语写的,第一章第一节:可微分流形。

Experiments

gut feeling:直觉,但是和intuition意思有细微的区别,intuition可以表示那种灵光乍现,而gut feeling就是那种一拍脑门,“就TM这么整,来!”的感觉。

warm-start:对cold start,推荐系统里这个问题是很操蛋的,不知道这几年有没有什么进展。

fight-or-flight:跑路还是作战。

Conclusion

注释12:While we have exhaustively explored the topic of machine learning GUNs, we leave the more controversial topic of machine GUN learning to braver researchers……给跪了。

一个领域出现了这样的论文,反映了这个领域研究的火热和困境

作者:Yivan

链接:https://www.zhihu.com/question/56841301/answer/150934968

来源:知乎

生成模型领域极具启发性的工作,提名2017年搞笑诺贝尔奖计算机奖项及和平奖项。

看论文看累了看了这篇,简直畅快淋漓通俗易懂令人感动。每一句每一段每条脚注都是梗,不想失去找梗乐趣的同学们请戳原文。列几条我觉得有意思的:

———————GUN———————

network-on-network (NoN)

NoN谐音none。

PROPS ACKS

受到TCP三次握手协议的启发,示意图宜在远距离低分辨率下观看哈哈哈哈。

intractorable

谐音intractable,贝叶斯统计中难以计算的积分的问题

D,G:=G,D simultaneous assignment

backwards compatability, four-space equation indentation

这一段梗有点密集啊,先是多变量同时赋值的问题,然后说“数学的版本”v42.1不向后兼容(什么鬼),因为科特•"Tab-Liebehaber"•哥德尔不受限于四空格缩进(这是在黑Python么)。

值得注意的是脚注3引用的是哥德尔1931年建立第一第二不完备性定理的论文On Formally Undecidable Propositions of Principia Mathematica and Related Systems,的德语原文。这参考文献的范围也是够广的。

spanned by all mattresses stuffed with U.S. dollars

matrices?美刀填满的床垫张成的空间(╹◡╹)

Neuroscience tells us that human brains are AlexVGGIncepResNets almost-everywhere

做 deep learning 的各位都很熟悉的Alex网络 VGG inception 残差网络,没错神经科学告诉我们人类的大脑中几乎处处都是这样的结构。

the machine learning and the machine forgetting communities

机器学习及机器遗忘... 不过说实话这确实是个值得研究的领域啊(认真脸)

one-shot learning

双关 一枪/一次(?)学习 指的是少样本学习在最极端的情况下只用一个样本就能学到概念

Levenshtein edit distance

一堆*GAN是按编辑距离排序的(╹◡╹)

(Amari & Nagaoka, 2000)

(牵强附会地)引用的是信息几何的经典教材,这一领域发展于80年代但早期工作仅存在于日语学界。脚注中说只需看奇数页,偶数页可以拿去叠纸鹤了哈哈哈

Note that these samples have been carefully cherry picked for their attractive appearance

这大概是说生成模型缺乏统一的评价标准的问题。确实现在很多工作看着很厉害论文里的图都蛮自然的,但就是很难复现很难泛化。cherry-picked精心挑选的生成数据也是很多论文被批的一点。神作后文表示GUN的评价标准是opportunities for improvement提升空间,那真是当之无愧的第一了哈哈哈。

ϵ-greedy updates with an ϵ value of 1

做强化学习的应该知道的epsilon-greedy,当epsilon是1的时候不就是纯随机么。

easy-positive mining

梗了物体识别中的hard-negative mining...

fight-or-flight behavior, which can result in vanishing gradients and runaway loss

原来战或逃反应是梯度消失问题的源泉,新知识get√

nurtural gradients, k-dearest neighbours

梗了natural gradient和KNN。自然梯度确实是上面提到的信息几何的方法,使得梯度下降中每次概率分布在黎曼流形上的距离改变相同。

———————GUN———————

总的来说,这篇文章行文流畅遣词有趣,用梗功力也算是够高了。个人感觉,如果一个领域出现了这样的论文,实际上反映了这个领域研究的火热和困境。一方面在GAN这一方向上诞生了许多有趣的具有启发性的工作,另一方面对于GAN缺少深刻理解缺少评价标准等问题确实是我们正面对的。但从最初的博弈论解释,到最近的拟合分布间的距离的解释,近来的工作正逐步地改变这一点。能产生这样的论文也算是好事吧。

至于推动世界和平的发展,我觉得可以(╹◡╹)

原文地址: https://www.zhihu.com/question/56841301

3月27日,新智元开源·生态AI技术峰会暨新智元2017创业大赛颁奖盛典隆重召开,包括“BAT”在内的中国主流 AI 公司、600多名行业精英齐聚,共同为2017中国人工智能的发展画上了浓墨重彩的一笔。

文字实录:

访问以下链接,回顾大会盛况: