【团队新作】自动化所在“读脑术”研究方面取得新进展

文章导读

自动化所何晖光研究员团队继去年关于“利用fMRI信号重建图像”的工作被MIT Technology Review头条报道后,基于以往的工作积累,提出了一种基于贝叶斯深度学习的大脑视觉信息解码模型,针对基于fMRI数据的视觉神经信息编解码问题, 提出了统一的多视图深度生成式模型,为基于大脑信号的视觉图像重建问题提供了有效的解决方案。

现代认知神经科学以及功能磁共振成像技术(functional Magnetic Resonance Imaging, fMRI)的不断发展使得采用科学手段对大脑视觉皮层信号进行解读成为可能。研究人脑视觉信息解码模型不仅可以加深我们对人脑视觉信息处理机制的研究,还可以有力地促进新一代脑-机接口(Brain-Computer Interface, BCI)技术的发展。

尽管现有的视觉信息解码模型在对大脑信号的分类、识别任务上表现良好,但是试图通过大脑视觉皮层信号精确重建视觉刺激内容仍然非常困难。阻碍人们有效地进行视觉信息解码的因素主要包括 fMRI 数据维度高、样本量小、噪声严重、解码模型不科学等。

传统的基于多体素模式分析(Multi-Voxel Pattern Analysis, MVPA)的视觉信息解码方法直接在高维的 fMRI 体素空间和视觉图像像素空间建立映射关系,这种解码方法很容易造成对冗余或噪声体素的过拟合。此外,现有的视觉信息解码方法大多数基于对视觉图像的线性变换,没有结合人脑视觉系统的信息处理机制,解码效果差并且缺乏生物学基础。

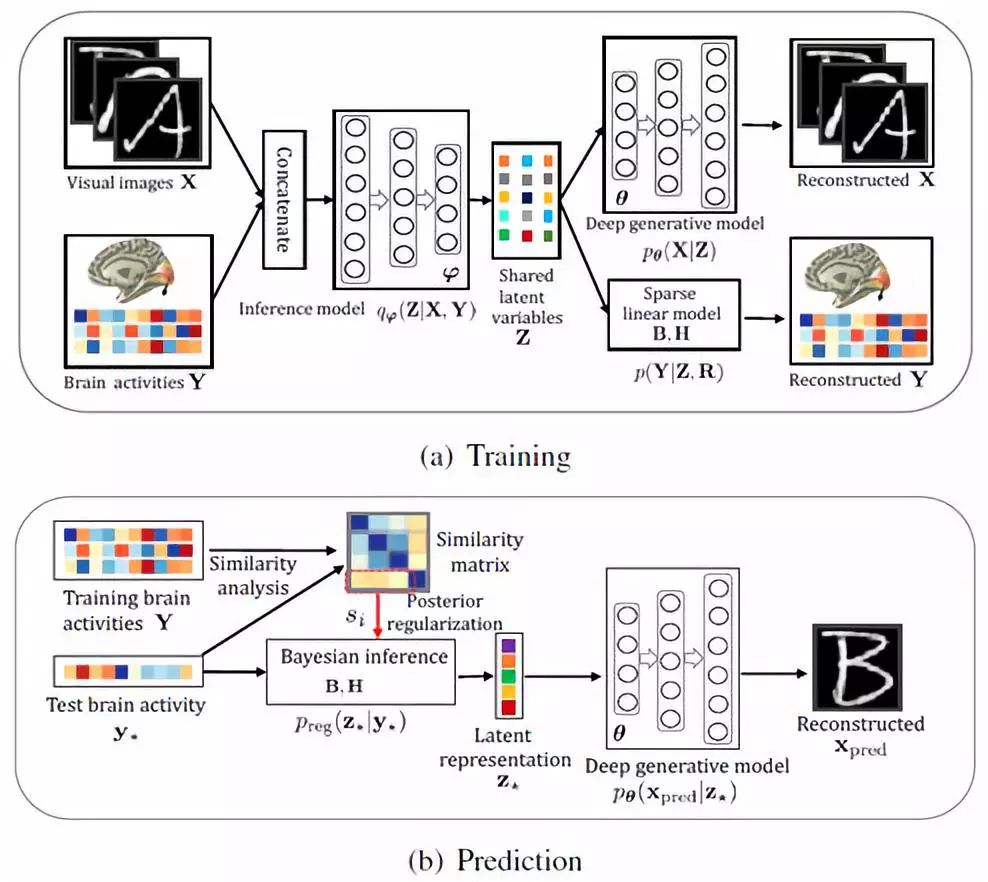

在国家自然科学基金重点项目《基于视觉信息编解码的深度学习类脑机制研究》的资助下,何晖光研究员团队结合 fMRI 成像技术的特点及人脑视觉信息处理的神经机制, 提出了一种基于贝叶斯学习及深度学习理论的视觉信息解码算法(如图1)。

图1 基于贝叶斯深度多视图学习的视觉信息编解码框架

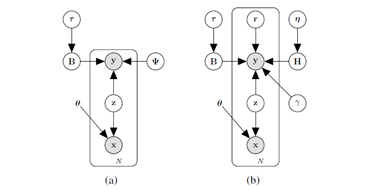

针对视觉信息解码技术中的视觉图像特征提取、fMRI 体素选择、体素噪声抑制、视觉图像重建等问题,该团队设计出了深度生成式多视图模型(Deep Generative Multi-view Model, DGMM)(如图2)。受人脑视觉通路中存在的 Bottom-up 和 Top-down 机制的启发,他们设计了一种基于自编码变分贝叶斯(Auto-Encoding Variational Bayes)技术的高效模型求解方法。在多个数据集上的视觉图像重建实验证明了所提新算法的优越性。

图2 深度生成式多视图模型

主要创新点

1.针对传统视觉信息编码方法在图像特征提取方面的不足,结合大脑视觉信息处理机制和贝叶斯深度学习的特点,提出利用深度变分自编码器(Variational Auto-Encoders, VAE)从原始图像刺激中逐层提取可解释性强的视觉特征,并在视觉信息解码实验中验证了该方法的优越性。采用基于VAE架构的深度生成式模型(Deep Generative Model, DGM)可以自动地从输入图像中学习到多种可解释的隐含表示,如描述物体的空间位置、尺寸大小、旋转角度等信息,这和人类视觉系统具有一定的相似性,对建立类脑智能视觉模型非常重要。

2.针对传统视觉信息解码方法在fMRI特征提取方面的缺陷,结合视觉区域的体素感受野和视觉信息的稀疏表达准则,采用稀疏贝叶斯学习理论从大量体素中自动筛选出对视觉信息解码贡献较大的体素同时去除冗余体素,并在视觉信息解码实验中验证了该方法的有效性。该方法能够以较少的体素保留原始体素集的绝大部分信息,减小了样本维数和样本个数的比值,有利于增强模型的稳定性和泛化能力,进而提升视觉信息解码的准确率。

3. 在抑制体素噪声提高泛化能力方面,充分挖掘利用了视觉皮层不同区域体素激活水平之间的相关性信息,并且通过对体素协方差矩阵施加低秩约束大大降低了计算复杂度。

4. 在视觉图像重建方法上,将视觉图像和与之对应的大脑响应看作是同一客体在不同空间中的外在表征,通过隐含变量共享机制,建立了多视图深度生成式模型,进而将视觉信息解码问题转化为多视图隐含变量模型中缺失视图的贝叶斯推断问题。

5. 为了进一步提高解码的准确性,通过贝叶斯后验正则化技术将大脑对不同视觉刺激响应的相似性分析作为先验知识融入到了预测模型中。

实验分析

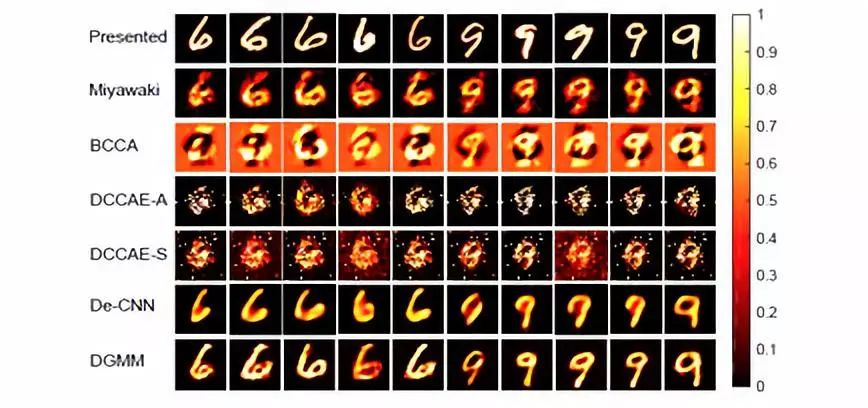

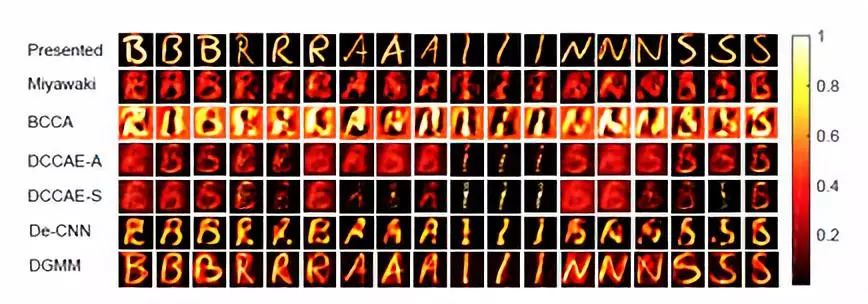

为了验证所提出的新算法的有效性,该团队分别使用来自Schoenmakers, Miyawaki 和 Van Gerven 等人的公开数据来做视觉图像重建实验。第一个数据集包含 360 张 56 x 56像素的手写字母灰度图(“B”, “R”, “A”, “I”, “N” 和 “S” 各 60 张),对应的 fMRI 数据来自三个被试的 V1 和 V2 区。实验中,视觉图像的分辨率从 56 x 56被降采样到 28 x28。第二个数据集包含 100 张 28x 28 的手写数字灰度图,其中数字 “6” 和数字 “9” 各 50 张。 这些手写数字图像选自于著名手写数字数据库 MNIST 的训练集。对应的 fMRI 数据来自于被试的 V1,V2 及 V3 初级视觉区域。

图3 手写数字的视觉重建

图4 手写字母的视觉重建

图3和图4分析对比了解码模型在多个数据集上的视觉重建效果。可以看到,大多数情况下的重建结果都较好地体现了对应图像刺激的特征。对相同的图像刺激,不同被试的大脑响应有所差异,因此三个被试的重建结果也有一定差异。个别情况下的重建结果不理想,这是由于重建图像所使用的 BOLD 信号与所呈现的图像刺激之间的同步性没有那么好,BOLD 信号存在一定的延迟。整体而言,DGMM 的重建效果很好,重建的图像质量较高。

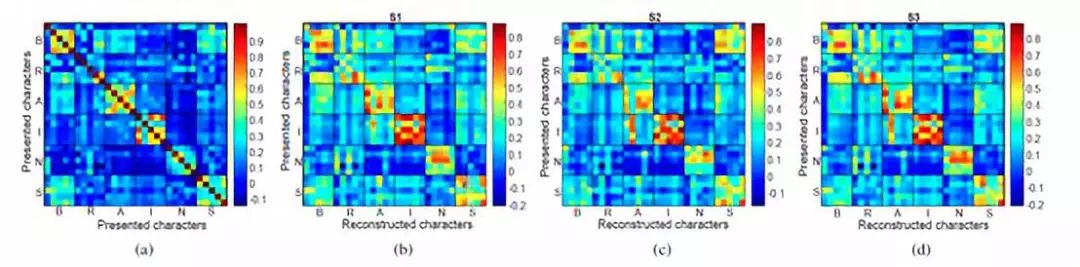

图5 相关性矩阵

为了进一步评估每个被试的图像重建效果,图5 展示了不同被试关于原始图像和重建图像之间相关性矩阵。其中子图 a 展示了原始图像之间的自相关矩阵。子图 b、c、d 展示了不同被试原始图像和重建图像之间的相关性矩阵。

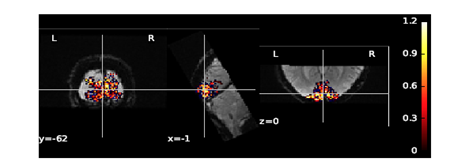

图6 初级视觉皮层位置可视化分析

大脑视觉皮层的不同位置可能包含了不同类型的信息,在视觉图像重建任务中我们除了要重建视觉刺激,还想要探究不同视觉区域对于视觉重建的影响及重要程度。图6可视化分析了对于大脑视觉信息解码起主要作用的初级视觉皮层位置。可以看到起主要作用的体素体现出聚集现象,并且主要分布在初级视觉区域V1。

总结

本论文基于贝叶斯深度学习提出了一种用于大脑视觉信息解码的新型算法 DGMM。通过隐含变量共享机制,DGMM 以一种科学合理的方式建立起了视觉图像和大脑响应之间的关系,将视觉图像重建问题转化成多视图隐含变量模型中缺失视图的贝叶斯推断问题。受人脑视觉信息处理机制(层次化、Bottom-up、Top-down)的启发,本论文采用了深度神经网络从视觉图像中逐层提取视觉特征和概念,提高了模型的表达能力和可解释性。

受视觉区域的体素感受野和视觉信息的稀疏表达准则的启发,本论文采用了稀疏贝叶斯学习从大量体素中自动筛选出对视觉信息解码贡献较大的体素,提高了模型的稳定性和泛化能力。DGMM 充分利用了 fMRI 体素之间的相关性信息,有效抑制了体素噪声的干扰,增强了算法的鲁棒性。得益于贝叶斯方法的优点,DGMM 能够方便灵活地融合先验知识,进而提升预测性能。大量的实验结果验证了DGMM 的优越性。

新算法为大脑信号解码问题提供了一个行之有效的通用框架,它具有很强的可扩展性,我们可以从不同角度对它进行扩展以适应不同任务。本论文不仅为探究大脑的视觉信息处理机制提供了一个强有力的工具,而且为脑-机接口的发展提供了技术支持。

目前何晖光研究员团队正在致力于更复杂刺激(如人脸,自然图像,乃至动态视觉刺激)的大脑解码工作,相信该研究能够为类脑智能的发展起到一定的促进作用。

全文信息FULL TEXT

Reconstructing Perceived Images from Human Brain Activities with Bayesian Deep Multi-view Learning

Changde Du, Changying Du, Lijie Huang, Huiguang He

论文链接:

https://ieeexplore.ieee.org/document/8574054

代码下载:

https://github.com/ChangdeDu/DGMM

Zero-shot Learning - 零次学习:假设这样一个情景,学习器已经读取了大量文本,然后要解决对象识别的问题。如果文本足够好地描述了对象,那么即使没有看到某对象的图像,也能识别出该对象的类别。例如,已知猫有四条腿和尖尖的耳朵,那么学习器可以在没有见过猫的情况下猜测该图像中是猫。

更多精彩内容,欢迎关注

中科院自动化所官方网站:

http://www.ia.ac.cn

欢迎后台留言、推荐您感兴趣的话题、内容或资讯,小编恭候您的意见和建议!如需转载或投稿,请后台私信。

作者:杜长德

审稿:何晖光

排版:翁宇琛

编辑:鲁宁