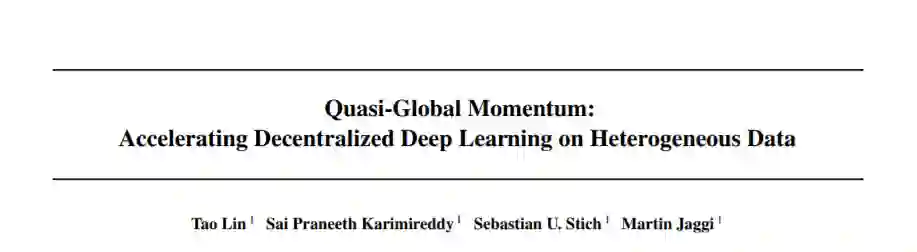

【ICML2021】加速异构数据的分散式深度学习

深度学习模型的分散训练是实现网络上数据隐私和设备上学习的关键要素。在现实的学习场景中,不同客户端局部数据集之间存在异构,这对优化提出了挑战,并可能严重影响泛化性能。在本文中,我们研究并识别了几种分散优化算法在不同程度的数据异构下的局限性。我们提出了一种新的基于动量的方法来缓解这种分散训练的困难。我们通过对各种CV/NLP数据集(CIFAR-10、ImageNet和AG News)和几种网络拓扑(Ring和Social network)的大量经验实验表明,与其他现有方法相比,我们的方法对客户数据的异构性更稳健,测试性能显著提高(1% - 20%)。我们的代码是公开的。

https://www.zhuanzhi.ai/paper/f22917494a3416d21630f426b07e5622

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DLHD” 就可以获取《【ICML2021】加速异构数据的分散式深度学习》专知下载链接

登录查看更多