LSTM之父再度炮轰Hinton:“本田奖”不该授予他,颁奖词有六大谬误

晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

LSTM之父Schmidhuber又来了,他和深度学习三巨头的战争从来没有停止过。

这次他把枪口对准了最德高望重的Hinton。

这一切要从半年前的一次颁奖说起。

去年9月,Hinton获得了当年的“本田奖”,该奖由本田汽车创始人设立,用于表彰对科技做出重大贡献的人士。而Hinton获奖的原因当然是他在AI领域做出的先驱性研究。

毫无意外,Schmidhuber又站出来反对了。

经过半年的准备,Schmidhuber旁征博引,用近百篇参考文献证明,本田奖颁给Hinton就是个错误。

Schmidhuber说:“我们必须停止将某个发明错误地归于某人。”上次他和GAN之父Goodfellow的论战也是这个主题,总之万物基于LSTM。

细数本田奖“六宗罪”

Schmidhuber在这篇长文中指出,AI中的一些重要技术,比如反向传播、无监督算法、Dropout等等都并非Hinton的首创。

本田奖的颁奖词言过其实,把其他人的研究成果算在了Hinton头上,存在着六处严重错误。

一

Hinton创造了许多技术,使AI得以更广泛地应用,其中包括反向传播算法,该算法构成了AI深度学习方法的基础。

Schmidhuber:

Hinton和他的同事们为深度学习做出了某些重要的贡献。但是,上述说法是完全错误的。

他是反向传播论文的三位作者中的第二位,但他没有提到3年前Paul Werbos建议用这种方法训练神经网络。

而且Hinton的文章甚至都没有提及Seppo Linnainmaa,这是网络中著名的信用分配算法(1970年)的发明者,该算法也被称为“自动微分的反向模式”。

二

2002年,他为受限玻尔兹曼机(RBM)引入了一种快速学习算法,使他们可以学习单层分布式表示,而无需任何标记数据。这些方法使深度学习能够更好地工作,并引发了当前的深度学习革命。

Schmidhuber:

Hinton的无监督深度神经网络预训练与当前的深度学习革命无关。在2010年,我们的团队表明,可以通过简单的反向传播对前馈神经网络(FNN)进行训练,并且对于重要的应用根本不需要进行无监督的预训练。

三

2009年,Hinton和他的两名学生使用多层神经网络在语音识别方面取得了重大突破,直接导致了语音识别的显著改善。

Schmidhuber:

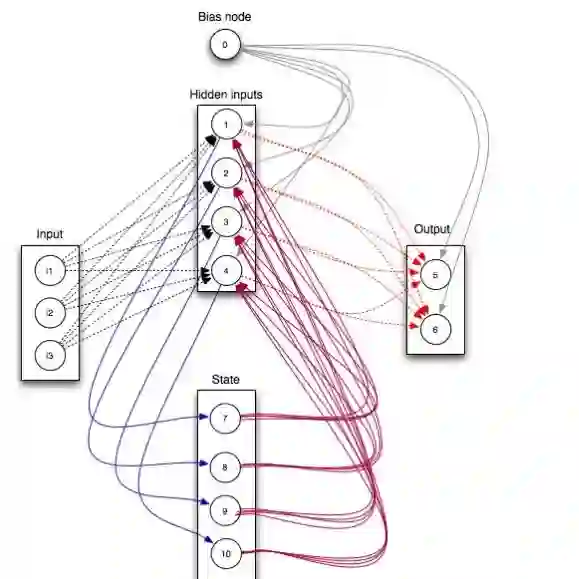

这是非常具有误导性的。我的实验室有两篇论文都应用到了神经语音识别中,分别是LSTM和CTC。

我们的团队在2007年 成功地将经过CTC训练的LSTM应用于识别。到2015年,当算力变得足够便宜时,CTC-LSTM大大改善了Google的语音识别,几乎所有的智能手机都支持这种功能。

四

2012年,Hinton和另外两名学生证明了深度学习比现有的最新技术识别图像中的对象要好得多,彻底改变了计算机视觉。

Schmidhuber:

计算机视觉革命靠的是Fukushima、LeCun等一大批70年代学者发展的卷积神经网络。Hinton团队2012年在ImageNet上的成功很大程度上要归功于GPU加速CNN运算,

我们的瑞士团队于2011年初创建了第一个基于GPU的顶级CNN——DanNet,在Hinton之前就证明了本田奖说明的这一点。

在IJCNN 2011上,DanNet赢得了比赛,并成为第一个在国际比赛中超过人类的视觉识别模型,而与Hinton经常合作的LeCun团队获得了第二名。

五

Hinton还发明了一种被广泛使用的新方法,称为“dropout”,该方法通过防止特征检测器的复杂配合来减少神经网络的过拟合。

Schmidhuber:

但是,“dropout”实际上是Hanson早先的随机Delta规则的一种变体。Hinton在2012年发表的论文并未引用这一点。

此外,我们已经在2011年证明,dropout对于赢得计算机视觉竞赛并获得超过人类的成绩并不是必要的 ,唯一真正重要的任务是使CNN在GPU上更深、更快。

六

“在全球无数的基于AI的技术服务中,毫不夸张地说,如果没有Hinton创造的结果,那将是不可能的。”

Schmidhuber:

大多数著名的AI应用都是其他人的成果,比如计算机视觉、语音识别、语言处理、手写识别、机器人技术、游戏、医疗影像等。

其中2~6都依赖于我们的LSTM。2016年,谷歌数据中心TPU四分之一以上算力都用于处理LSTM。LSTM已经成为20世纪引用最多的AI论文。

最后,Schmidhuber肯定了Hinton和他的同事们对神经网络和深度学习做出了重大贡献。

但是他认为:

Hinton最引人注目的工作是推广了其他人创造的方法,而且在论文里没有引用来源,一个重要的发明者应该奖励发明它的人,而不是是推广它的人。

本田应该纠正这一点,而不该让企业公关行为扭曲了科学事实。

不幸的是,Hinton不信任前人的重要工作,这不应该成为博士生的榜样,做研究要不惜一切代价避免丝毫的抄袭。这篇文章也是对Hinton和某些其他奖项的含蓄批评。

网友怎么看

很快这篇长文就在Reddit上的机器学习板块引起热议,而这已经不是第一次网友为Schmidhuber争论,都快要成为AI界的“月经贴”了。

有些网友早已对Schmidhuber的自说自话感到厌烦。

他觉得上次来Reddit宣传Schmidhuber观点就是小号,这类文章实在太多了,一遍遍看到类似话题让人感到乏味,建议将讨论关闭。

也有网友上来就硬核“打脸”:

比如ResNet赢得ImageNet竞赛时,Schmidhuber就出来发文说ResNet不过是HighwayNets的一种变体,实际上只是前馈LSTM。他还说Hochreiter在1991年首次发现梯度消失问题。

后来,有人挖出Lang和Witbrock在1988年发表的一篇论文已经发现了这一点。

每个人的想法都是对现有事物的改进,如果不停追溯下去,那么神经网络的源头是不是还要追溯到牛顿和莱布尼兹身上呢。

不过也有一些人对Schmidhuber表示理解,因为LSTM确实被广泛用在语音识别任务中。而本田奖的表彰词里把他的首创归功于Hinton,的确让人难以接受。

可以预料,未来Schmidhuber关于AI首创性研究的争论还会继续下去,你支持他吗?

参考链接:

http://people.idsia.ch/~juergen/critique-honda-prize-hinton.html

https://www.reddit.com/r/MachineLearning/comments/g5ali0/d_schmidhuber_critique_of_honda_prize_for_dr/

作者系网易新闻·网易号“各有态度”签约作者

— 完 —

如何关注、学习、用好人工智能?

每个工作日,量子位AI内参精选全球科技和研究最新动态,汇总新技术、新产品和新应用,梳理当日最热行业趋势和政策,搜索有价值的论文、教程、研究等。

同时,AI内参群为大家提供了交流和分享的平台,更好地满足大家获取AI资讯、学习AI技术的需求。扫码即可订阅:

了解AI发展现状,抓住行业发展机遇

AI社群 | 与优秀的人交流

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「在看」吧 !