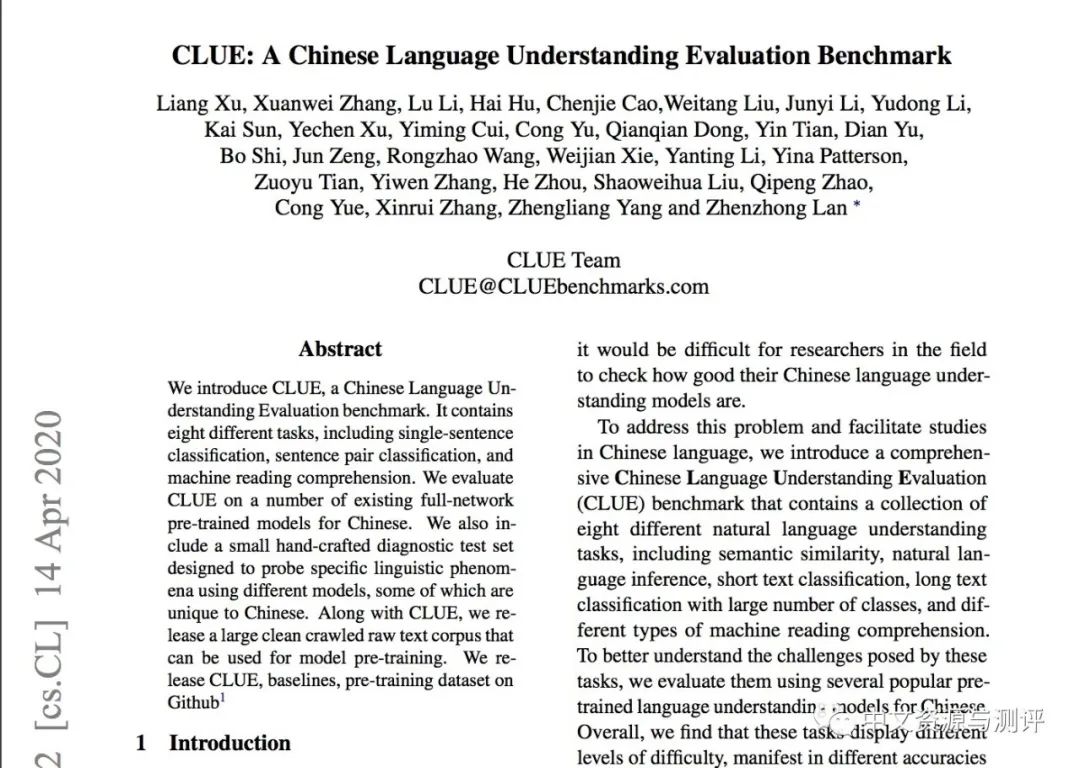

我们是中文任务基准测评小组,即Chinese Language Understanding Evaluation(CLUE)的成员。

我们收集、制作了一套中文自然语言理解评测平台:CLUE Benchmark。

CLUE Benchmark旨在综合形式不同、难度各异的中文自然语言理解数据集,制作一个

统一的

测试平台,以准确评价模型的自然语言理解能力。

目前我们已经收集了至少9大数据集,并制作了排行榜。包括华为、阿里、腾讯等公司,

以及中科院相关院所

等高校参与了测评。我们的GitHub repository已获得超过1000个星。

https://www.CLUEbenchmarks.com

https://arxiv.org/abs/2004.05986

https://github.com/CLUEbenchmark

![]()

现在,我们诚挚邀请中文自然语言理解方面的专家学者、老师同学、参与者为我们提供更多的中文自然语言理解数据集。这些数据集可以是您自己制作推出的,也可以是您认为很有意义但是是他人制作的数据集。我们计划在5月14日前完成筛选,推出正式的CLUE Benchmark。请您将推荐数据集的名称、作者、形式以及License情况发送至 CLUE@CLUEBenchmarks.com

【奖励】如果您推荐的数据集被选中,将能提高扩展数据集的知名度,并为学界、业界对自然语言理解的研究做出贡献。CLUE组织会引用和推广该数据集;我们也会结合数据集质量、意义、量级和标注难度、任务类型设置不同等级的奖励,给与1000--5000元现金奖励。

我们要求数据集能够测试模型是否理解了中文,模型可以是以研究为导向,也可以由实际应用为导向,重点是需要包含语言理解的成分。

任务本身质量还不错。

任务输入是一段文本(可长可短),具体任务可以是分类、

序列标注、

指代消歧、多项选择

、回归任务

,等等。任务最好能够使用基本的神经网络模型做出基线,方便测评

。

提交的任务需要有简单、客观的评测标准。如果是包含文本生成的项目,那么需要证明该项目有易行的可靠评测标准。

任务的训练数据和开发数据需要公开,并且能够由CLUE使用。

提交的任务不能太简单。具体来讲,目前的模型如BERT应该比训练过的普通标注者做的差很多。

![]()

https://www.CLUEbenchmarks.com

推荐阅读

AINLP年度阅读收藏清单

当当的羊毛,快薅,这一次要拼手速!

数学之美中盛赞的 Michael Collins 教授,他的NLP课程要不要收藏?

自动作诗机&藏头诗生成器:五言、七言、绝句、律诗全了

From Word Embeddings To Document Distances 阅读笔记

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

这门斯坦福大学自然语言处理经典入门课,我放到B站了

可解释性论文阅读笔记1-Tree Regularization

征稿启示 | 稿费+GPU算力+星球嘉宾一个都不少

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

![]()