揭秘|不听霍金警告,各国致命性自主武器系统已经泛滥

斯蒂芬·霍金老爷子逝世的消息迅速传遍世界,在全球为这样一位思想者、探索者的去世而沉痛时,各国却并没有在意霍金的那句警告——小心人工智能!反而为了在战争中取得优势,大力发展无人机、无人地面车辆、战斗机器人等在内的致命性自主武器系统。

图片:霍金反对大力发展人工智能,认为是人类为自己挖掘坟墓。

2015年7月一封公开信得到了2万人左右的签名,签名者是人工智能领域的专家以及其他对此话题颇为关切的人,其中包括著名物理学家斯蒂芬·霍金以及苹果公司联合创始人史蒂夫·沃兹尼亚克。这封公开信要求停止研发具有杀人能力的自主系统。

图片:霍金和他的伙伴们。

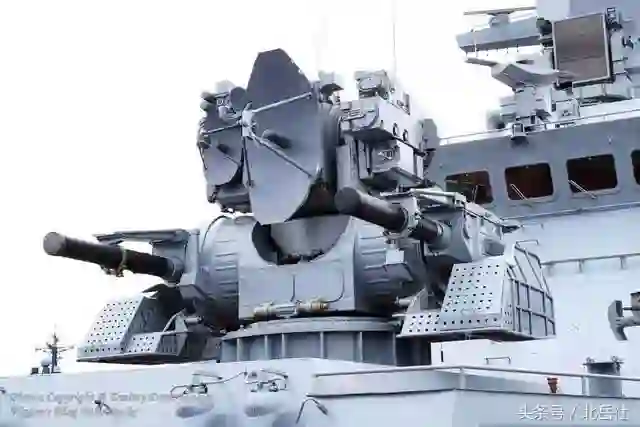

目前各国发展的各型无人飞行器、无人地面车辆、无人水面艇等能够自主运作的武器系统在某种程度上都属于LAWS的范畴。而其本质上是用于战争或者是杀人!

图片:俄罗斯“平台”-M战斗机器人已经在战场上崭露头角。

对于机器人的伦理问题,早在机器人刚刚发明的时候就有人提出了!

1942年,著名的美籍俄罗斯裔科幻作家艾萨克·阿西莫夫在《惊奇科幻小说》中首次提出了机器人伦理问题,这位被视为机械伦理学之父的大师在1942年出版的小说《转圈圈》中描述了机器人三定律。

第一定律:机器人不得伤害人类,或坐视人类受到伤害;

第二定律:除非违背第一法则,否则机器人必须服从人类的命令;

第三定律:在不违背第一及第二法则下,机器人必须保护自己。

此后,阿西莫夫又添加了一条定律:第零定律:机器人不得伤害人类族群,或因不作为使人类族群受到伤害。

图片:1936年苏联科学家研制的第一种机器人B2M,他的名称就叫“智能机器人”。

但是,机器人发展的方向并没有按照阿西莫夫的设想去进行。机器人设计越来越专业,分工越来越细化,或许机器人拥有很强的自主能力,但却并没有思维去理解阿西莫夫的三大定律,设计人员也不可能将这个定律灌输进机器人的头脑中。

图片:具有自主作战能力的近防系统,从某种意义上说也是一种战斗机器人。

图片:美国最新型“黄貂鱼”MQ-25无人机。

图片:俄罗斯乌兰-9战斗机器人可反坦克、防空并用温压弹消灭敌人有生力量。

目前,人们对于这些战斗机器人,无论是地面的,还是空中的,或者是海中的,都在赋予其一定自主权的情况下,对于打击等重要决策的选择权,仍然握在人类操作人员手中。

图片:《绝密飞行》中有人机与无人机的对抗。

图片:《终结者》电影中的机器人大军是人工智能与人类战争的最极端写照。

但是,对于世界各国来说,遵从霍金和阿西莫夫的思想,放弃自主性武器装备的研制是不可能的!无人战斗机械可以在战争中帮助己方获得战争的胜利,杀伤的也基本上都是敌方目标,而减少自己人员的伤亡。在如此巨大的效益诱惑下,没有哪个国家会停止对人工智能和自主性杀伤兵器的研制。

图片:《攻壳机动队》中就是一个充满人工智能机器人的时代。

未来究竟是这些战斗机器人继续为人类所用呢?还是像阿尔法狗那样战胜人类?或者是觉醒自主意识,成为与人类平等的另一种形态的生命?

霍金已经不能再给我们答案了!未来的道路需要人类自己去抉择!

☞来源:北岳社

工程院院士 蔡鹤皋丨北航教授 文力丨深醒科技 袁培江丨深之篮 魏建仓

一飞智控丨深醒科技丨发那科丨柔宇科技丨优傲机器人丨宇树科技丨臻迪科技丨iRobot

①工业 缝纫机器人丨无人智能采矿机器人丨中国饺子生产线自动化车间丨MIT 建筑机器人

②服务 索尼机器狗 Aibos丨叠衣机器人 FoldiMate丨日本 骑自行车机器人丨有触觉机械手 LUKE丨达芬奇机器人丨机器人乐队丨空中飞车丨日本护理机器人合集

③特种 丰田人形机器人丨水下机器人 探索号丨俄罗斯人形机器人 FEDOR丨美国重型机械 Guardian GT丨波士顿动Atlas 360度后空翻丨中国四足机器人 Laikago丨北理工 四轮足机器人丨佛罗里达研究院 “机械鸵鸟

④仿生 3D打印 仿生机器人 丨东京大学 流汗人形机器人丨柔性电池丨哈佛 柔软肌肉丨哈佛 折纸机器人丨哈佛 RoboBee

英特尔 宋继强博士 | 中民国际 刘国清丨陈小平教授 |驭势科技 姜岩丨浙大 熊蓉教授|长江学者 孙立宁丨上海大学 无人艇专家团|新松总裁 曲道奎丨北航 王田苗教授|863专家 李铁军教授丨北邮 刘伟教授|清华 邓志东教授丨清华 孙富春教授|天津大学博导 齐俊桐丨哈工大 杜志江教授|长江学者 王树新丨甘中学教授 | 硅谷创客 赵胜

意向合作,文章转载, 均可联系堂博士

商务合作:13810423387(同微信)

内容合作:15611695072(同微信)