LSTM之父开喷LeCun最新论文:为啥你不引用我的工作?LeCun沉默未作回应

明敏 发自 凹非寺

量子位 | 公众号 QbitAI

语不惊人死不休的LSTM之父Jürgen Schmidhube,又来了。

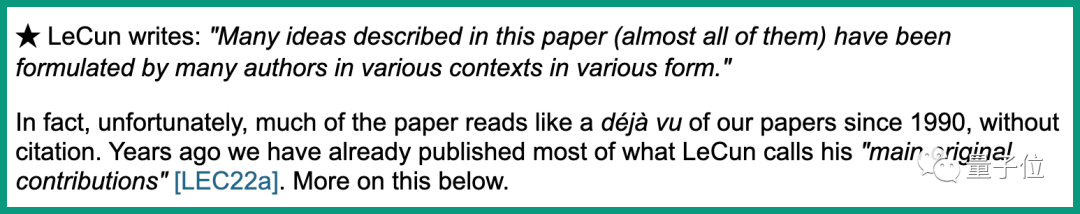

这一回,他把“矛头”对准LeCun,声称其前不久发表的最新62页论文中,没有正确引用自己实验室1990-2015年的成果。

没错,就是LeCun那篇介绍自己未来10年研究方向的论文《A Path Towards Autonomous Machine Intelligence》。

尽管LeCun已经在论文中声明,其中的很多想法都是来自不同作者。

但Jürgen表示,很多内容读起来似曾相识,“而他并没有正确引用我的论文”,并且列出10个方面论述了自己的观点。

其中不乏LeCun眼中的下一代AI架构世界模型、JEPA等引起热议的部分。

Jürgen直言,自己如此较真并不是因为存在利益冲突,而是希望自己的工作能够得到认可。

目前,LeCun对此还没有回应。

“他引用的论文都太新了”

在这次发文中,Jürgen表示LeCun引用的很多论文都太新了,却没有引用早年间的一些“最原创”的论文。

这些早年的研究,正是来自他的团队。

就拿LeCun此次重点提到的世界模型来说。

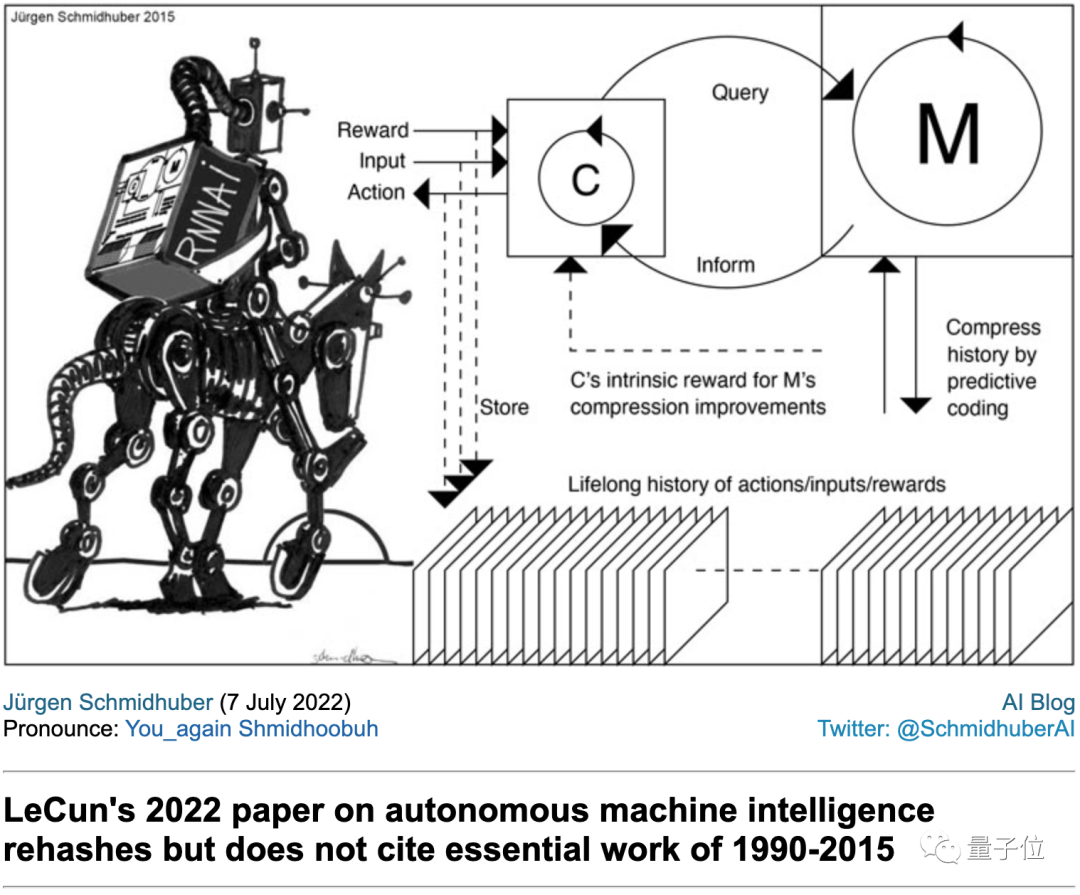

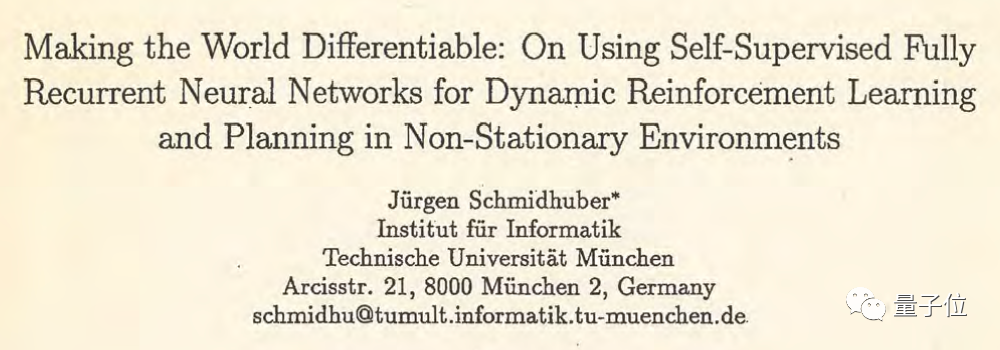

Jürgen表示,他1990年发表的一篇论文中,就介绍到了其中的几个概念。

这篇论文中,描述了两个循环神经网络,可以称为控制器(controller)和世界模型(world model)。

控制器负责尝试发出一系列动作,以在最初的未知环境中尽可能多地积累输入。

世界模型用来学习控制器发出动作后产生的结果。

这种模式也就是现在的rollout算法。

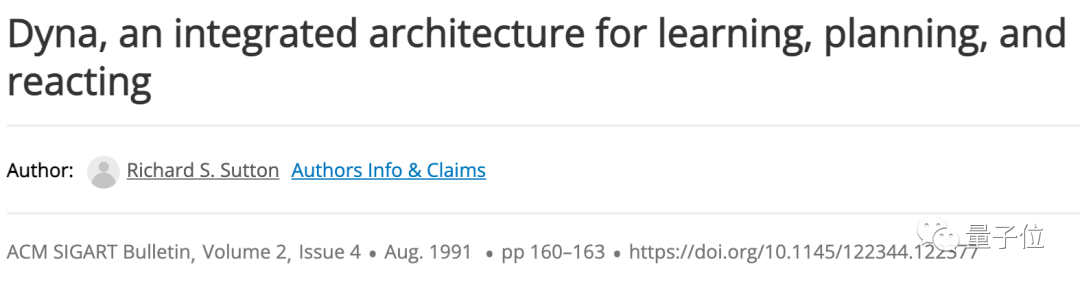

在LeCun的论文中,关于这部分的引用是来自论文“Dyna, an integrated architecture for learning, planning, and reacting”,发表于1991年8月。

但Jürgen认为,其中提到的集合学习、规划和反应的架构,在此之前就被提出了,正是来自于他们1990年的工作。

因此,LeCun的引用有问题。

除此之外,他还提到LeCun引用的2014年发表的论文Generative Adversarial Nets,也是基于他们的工作。

这一点在他之前的发声中就有提及过。

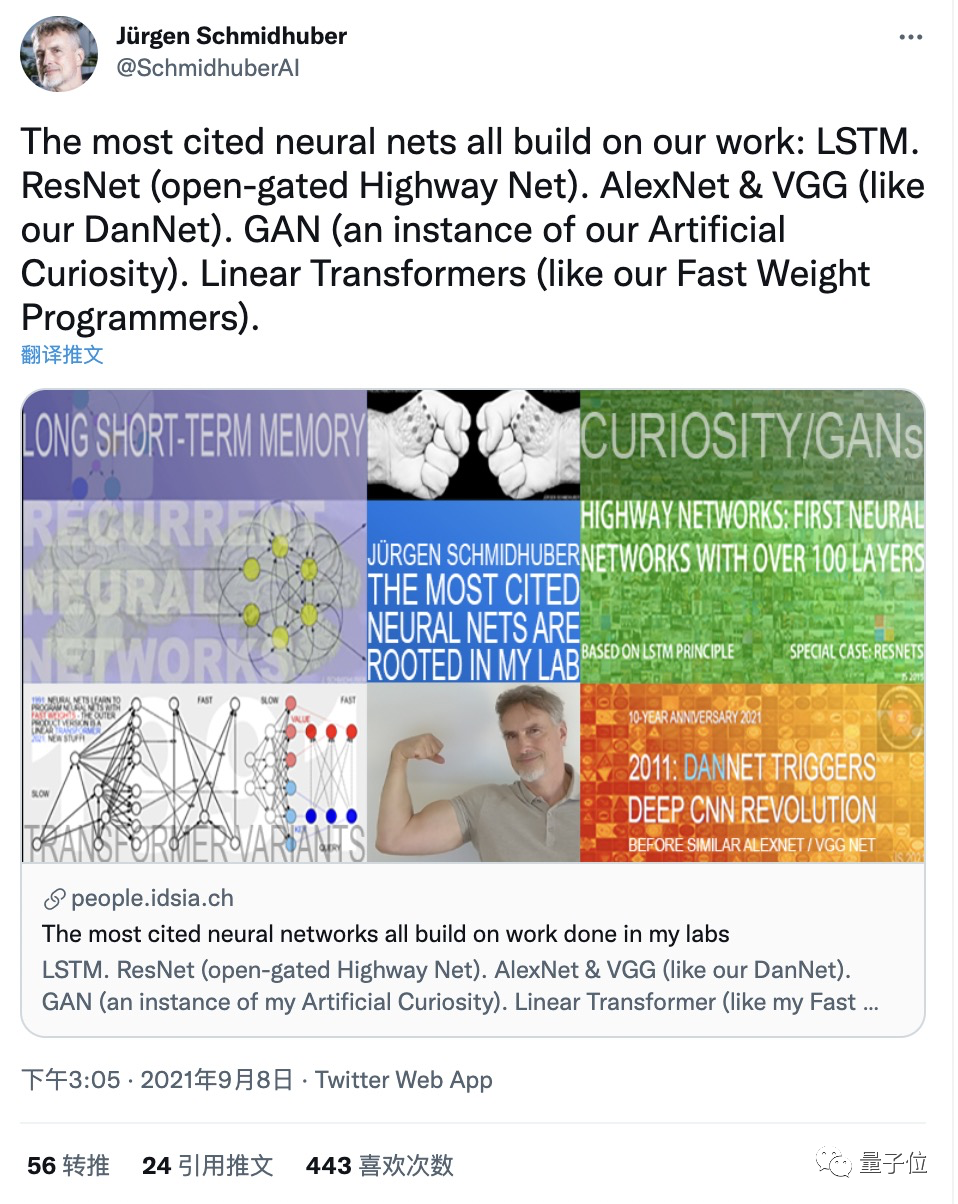

去年,Jürgen表示ResNet、GAN等五大网络都有他的功劳。

还有LeCun在论文中提到的核心——联合嵌入预测架构 (JEPA)。

Jürgen认为这是他在1997-2002年时提出过的工作。

诸如此类的问题,Jürgen在博客中列举了将近10处,并列出了大量论文进行论证。

网友:机器学习的所有工作都是他的注脚

Jürgen一波操作自然又引来了不少网友围观。

有网友觉得,LeCun也没有说这些想法都是他自己的,他的立场更多是综合了大家想法下提出一个愿景,而且也提供了适当的引用作为参考。

大概他也应该提到你的这些论文!

当然更多人是出来吐槽Jürgen了……

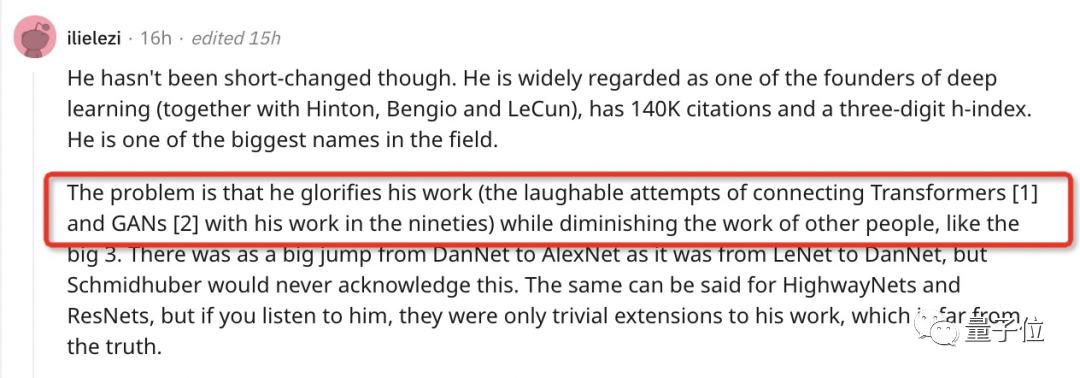

你的确是AI领域的一位大佬,但你更出名的是总出来说别人剽窃了你的想法吧。

机器学习的所有工作都是Jürgen的注脚。

更直接的调侃还有,“Jürgen发明了火”,“还有轮子”。

不过这也不能怪网友们嘴狠,毕竟Jürgen的嘴炮历史非常悠久。

去年他还提出“目前引用次数最高的5项神经网络工作都是基于我团队的成果”。

这五项工作分别是:LSTM、ResNet、AlexNet和VGG Net、GAN、Transformer。

当时就有不少人说,Jürgen太美化自己的贡献了。

不过不管咋说,Jürgen的成就还是有目共睹的,作为深度学习领域的开拓者,他提出的LSTM解决了一般RNN存在的长期依赖问题。

而对于Jürgen多年来的激烈表达,网友们似乎也习惯了。

甚至在当年图灵奖颁给“深度学习三巨头”后,还专门为Jürgen写了首歌来让他振作起来(doge)。

参考链接:

[1]https://people.idsia.ch/~juergen/lecun-rehash-1990-2022.html#DYNA90

[2]https://twitter.com/SchmidhuberAI/status/1544939700099710976

[3]https://www.reddit.com/r/MachineLearning/comments/vtcrej/d_lecuns_2022_paper_on_autonomous_machine/

— 完 —

「人工智能」、「智能汽车」微信社群邀你加入!

欢迎关注人工智能、智能汽车的小伙伴们加入我们,与AI从业者交流、切磋,不错过最新行业发展&技术进展。

ps.加好友请务必备注您的姓名-公司-职位哦~

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~