神经引擎这回行了吗?iPhone 14 Core ML性能测评已出

机器之心报道

你的 iPhone 14 到货了吗?有人已经把 Core ML 的性能测试出来了。

-

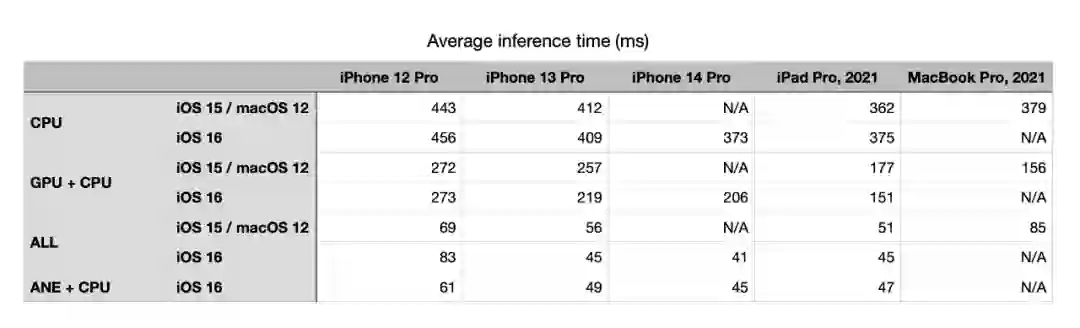

iPhone 12 Pro A14 Bionic (iOS 15 + iOS 16) -

iPhone 13 Pro A15 Bionic (iOS 15 + iOS 16) -

iPhone 14 Pro A16 Bionic (iOS 16) -

iPad Pro 2021 M1 (iOS 15 + iOS 16) -

MacBook Pro 2021 M1 Pro (macOS 12)

-

从 CPU 到 GPU 再到 ANE ,运行速度持续提升; -

当在 iOS 16 上从 ALL 转到 ANE+CPU 时,推理时间(几乎)持续增加,这表明模型中的一些层无法在 ANE 上运行,而是默认使用 GPU; -

操作系统版本对整体性能的影响似乎可以忽略不计; -

在 A 系列芯片(A14 Bionic - A15 Bionic - A16 Bionic)中,所有配置的性能都有缓慢而稳定的提升。苹果公司也称其新的 A16 Bionic 芯片(17 TFlops)比 A15 Bionic(15.8 TFlops)提高了 7.5%,使得推理时间从 iPhone 13 Pro 的 45ms 缩短到 iPhone 14 Pro 的 41ms; -

iPad Pro 的 M1 芯片与新的 A16 Bionic 相比,CPU 和 ANE 的性能相当,并其 M1 的 GPU 似乎更强一些。这也许和 M1 芯片比 A16 Bionic 具有更多 GPU 内核有关。

对于新发布的产品,iPhone 14 Pro 的推理时间缩短至 41ms,这是一个重要的突破。但这项测试也显示出苹果神经网络引擎还存在一些问题。

掌握「声纹识别技术」:前20小时交给我,后9980小时……

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

登录查看更多

相关内容

InteractE: Improving Convolution-based Knowledge Graph Embeddings by Increasing Feature Interactions

Arxiv

13+阅读 · 2019年11月1日