杨强申省梅等AI大咖共谈「跨域学习」,搞定小数据才是王道 | CNCC 2020

金磊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

「AI的力量来自大数据」,这句话确实不假。

理想虽好,但现实却是——哪有那么多高质量、标注数据可用,更多的依旧还是小数据。

这也正是工业界往往需要大量人力去收集、标注数据的原因。

即便如此,「隐私」、「法律」和「专业性」等种种约束,注定了这种方法跟不上AI落地的行进速度。

此局又该如何破解?

10月24日,由澎思科技组织的CNCC 2020分论坛《AI 落地的跨域学习技术和进展》在京成功举办。

就此议题,论坛邀请了业界众多专家共同探讨,包括:

微众银行首席人工智能官、香港科技大学讲席教授杨强,北京邮电大学人工智能学院教授、博士生导师邓伟洪,中国科学院计算技术研究所副研究员、硕士生导师阚美娜,澳大利亚国立大学讲师郑良,以及清华大学软件学院副教授、博士生导师龙明盛。

那么对于「玩转」小数据,学者、专家们又有何高招呢?

迁移学习、跨域学习、联邦学习、小样本学习,均为破解之道。

而更为重要的是,它们的发展正在为加速AI落地提供源源不断的动能。

杨强:保护数据隐私,打破数据孤岛

「大数据是AI的主要力量,但更多的是小数据」。

微众银行首席人工智能官、香港科技大学讲席教授杨强抛出了这样一个观点,并举了一些例子:

比如在法律层面,可能收集一个案例都需要从头到尾把这个案例走完,往往是需要几年的时间。

在医疗里面,我们知道医疗图象现在非常的多,但是高质量的图象和经过标注的图象是非常少,因为有经验的医生是非常珍贵的。

对此,杨强教授将问题拆分为二:

如何解决大数据迁移到小数据的问题。

如何解决数据分散的问题。

并提出了解决方案——迁移学习和联邦学习。

△ 微众银行首席人工智能官 杨强

迁移学习是比较传统的方法,因此,杨强教授主要针对联邦学习做了阐述。

杨强教授一句话对其概括为——数据不动,模型动,它的目的或者说是宗旨也非常直观,就是保护数据隐私,打破数据孤岛。

联邦学习旨在建立一个基于分布式数据集的联邦学习模型。主要包括模型训练和模型推理两个部分:

在模型训练过程中,模型相关的信息能在各方之间交换(或者是加密形式进行交换),但数据不能。

在模型推理过程中,模型可以应用于新的数据实例。

而根据训练数据在不同参与方之间的数据特征空间和样本ID空间的分布情况,可以将联邦学习分为三大类。

第一类是横向联邦学习。

适用于联邦学习的参与方的数据有重叠的数据特征,即数据特征在参与方之间是对齐的,但参与方拥有的数据样本是不同的。

第二类是纵向联邦学习。

适用于联邦学习参与方的训练数据有重叠的数据样本,即参与方之间的数据样本是是对齐的,但在数据特征上有所不同。

第三类是联邦迁移学习。

适用于当联邦学习的参与方拥有的数据集,在用户和数据特征上的重叠部分都比较小的情况。

以金融行业为例。因数据安全要求,银行和保险等金融机构在本地对数据进行建模。

使用联邦学习,各个机构的模型可以联合起来,能够打破数据之间的壁垒,提高反洗钱系统的准确度和审查人员的效率。

而联邦学习正是因为作为能够在不违反隐私和安全的前提下,使用分散于多方的数据来构建共享和定制化模型的一种创新建模机制,所以在诸多领域中都有较为广泛的应用。

除了上述提到的金融领域,联邦学习在医疗、教育、边缘计算、物联网、5G等,诸多数据无法直接被聚合用来训练的场景下使用。

邓伟洪:人脸识别,还有8%的提升空间

在杨强教授对迁移学习和联邦学习做了阐述之后,北京邮电大学人工智能学院教授、博士生导师邓伟洪,基于人脸识别技术做了《跨域人脸和表情识别》的主题演讲。

△ 北京邮电大学人工智能学院教授 邓伟洪

邓伟洪教授先对人脸识别的发展做了介绍。他认为,这个「小领域」经历了四代算法的发展。

第一代是注重全局的数字变化;第二代是以LBP为代表的局部手工设计的特征;第三代是层学习的局部特征;而到了第四代,随着深度学习的引入,开始了人脸识别的真正的大规模应用。

但其实,人脸识别的「遍地开花」,并不仅仅是深度学习的功劳,还有就是人脸识别的训练数据量的大幅增长——近5个数量级。

因此,人脸识别的准确率也是在逐年提升,目前主流的机器学习方法基本都能做到99%以上。

那么,是否可以说,人脸识别领域是否已经近乎完美了呢?

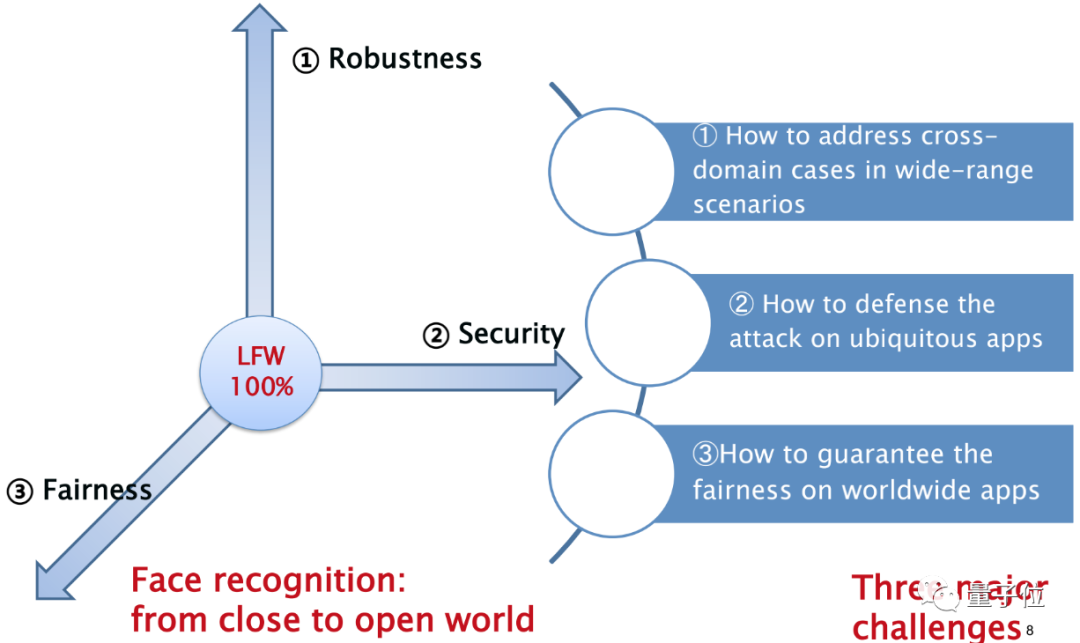

非也,邓伟洪认为,主要还有三大挑战需要克服:

第一个挑战是跨域可连接的问题。

第二个挑战是解决一些故意的攻击。

第三个挑战是保证在世界范围内应用时的公平性。

首先是第一个问题,为什么说识别问题如此之难。

邓伟洪认为,无论是人脸识别,亦或是图像识别,本质上是具有非常大的可变形——不同角度、不同像素,以及化妆、遮挡等等。

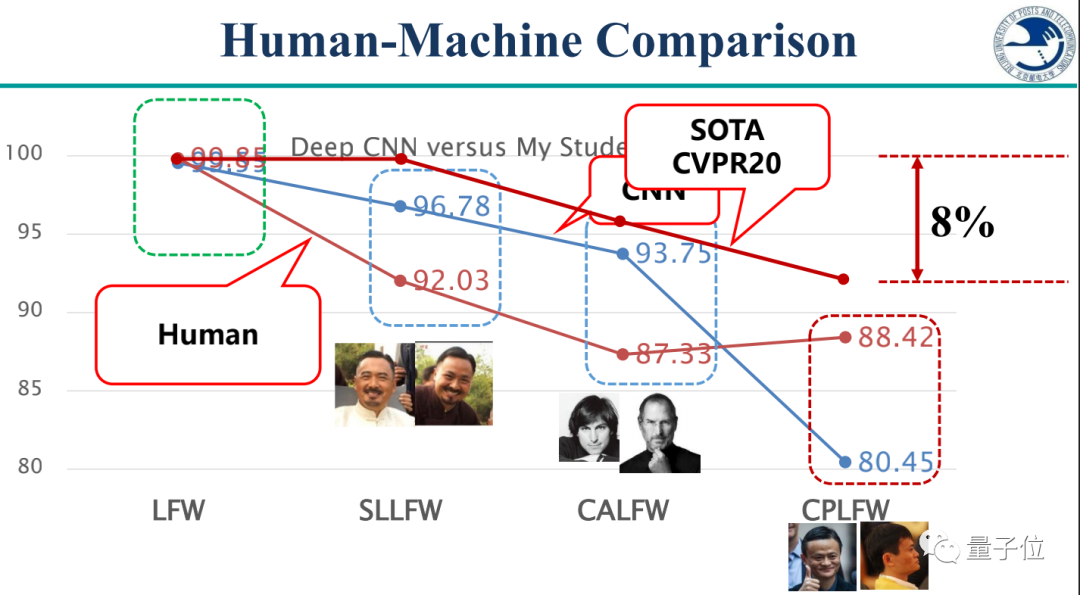

虽然现在的研究准确率动辄就飙到99%以上,但邓伟洪认为,是测试集选取图片的方法过于简单了。

于是,他们增加了难度,看看机器的能力到底有多强:选取了三组(长相相似、跨年龄、不同姿态)数据,重组了跟主流测试库(LFW)大小一致的数据集。

测试结果非常明显,在新组的数据集(CPLFW)面前,无论是人类亦或是机器,准确率都有所下降。

邓伟洪表示,「如果想发论文,还有8%的提升空间」。

对此,邓伟洪也给出了两种解决问题的思路:

一是归一化:通过一个网络,把不同的人脸、不同角度的人脸、不同光线下的人脸,甚至是不同模态下的人脸,都归一化到一个状态,然后去做识别。

二是生产一些低质量或者是很难识别的样本,扩充样本集,让深度学习能够把难的样本学到。

其次是第二个问题,如何抵御隐藏的攻击。

对于我们人类肉眼无法识别的「攻击」,对于机器来说却是致命的。

对此,邓伟洪认为,「未知攻,焉知防」——要防住这种攻击,首先要掌握最厉害的攻击方法。

于是提出了一种叫做迁移攻击的方法,只需要在实验室模型训练攻击样本,提交到四大主流公司API上,便可均可攻击成功。

有了这样的攻击方法之后,防御就非常简单了——把这些样本扔到训练数据集去,让它被重新识别。

第三个挑战,就是公平性问题。

不同人种的肤色是最为常见的一种偏见,还有就是数据集中不同地区人口比例,并不是按照现实世界来的。

对此,邓伟洪给出的解决方案是构建新的测试数据集,并且还有基于迁移学习、强化学习的人脸识别模型,相当于多个层次的人脸识别公平性的研究体系。

阚美娜:多粒度图像迁移建模

接下来,中国科学院计算技术研究所副研究员、硕士生导师阚美娜,针对图像迁移建模方面的工作,做了题为《多粒度图像迁移建模》的报告。

与其它讲者不同的是,她的工作是从不同的粒度进行迁移,包括域的层面、类别的层面和样例的层面。

针对这三个不同的层面,阚美娜提出了三种不同的方法。

△中国科学院计算技术研究所副研究员 阚美娜

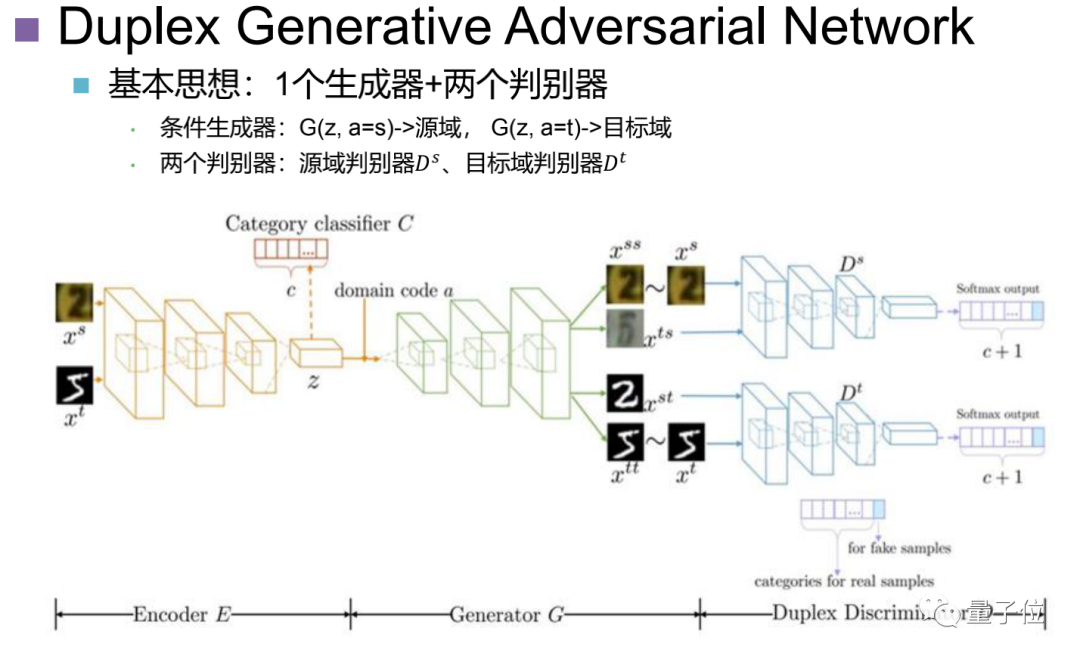

在域的层面上,阚美娜提出的方法叫做无监督的双向领域转换。

提出了一种Duplex Generative Adversarial Network:

利用带条件的生成器的,进行双向领域转换。

两个待分类的对抗器,保真的同时还能够做到保持类别。

并且,具有判别性的域不变特征。

网络结构如下图所示:

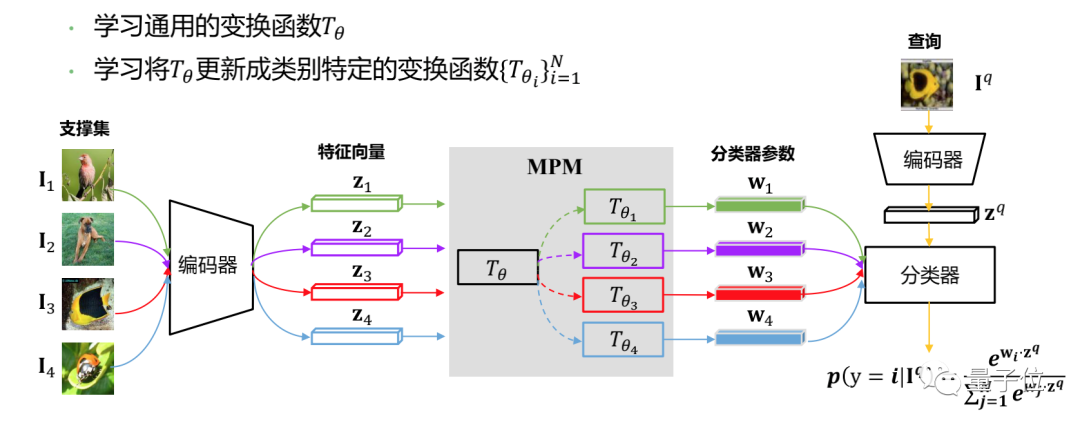

在类别的层面上,阚美娜提出的方法叫做基于元预测器的小样本图像分类。

改进的主要工作在下图中的MPM模块中。模型训练方面,采用内层-外层循环更新策略:

内层循环:更新学习器{Tθ}Ni=1。

外层循环:更新元学习器Tθ。

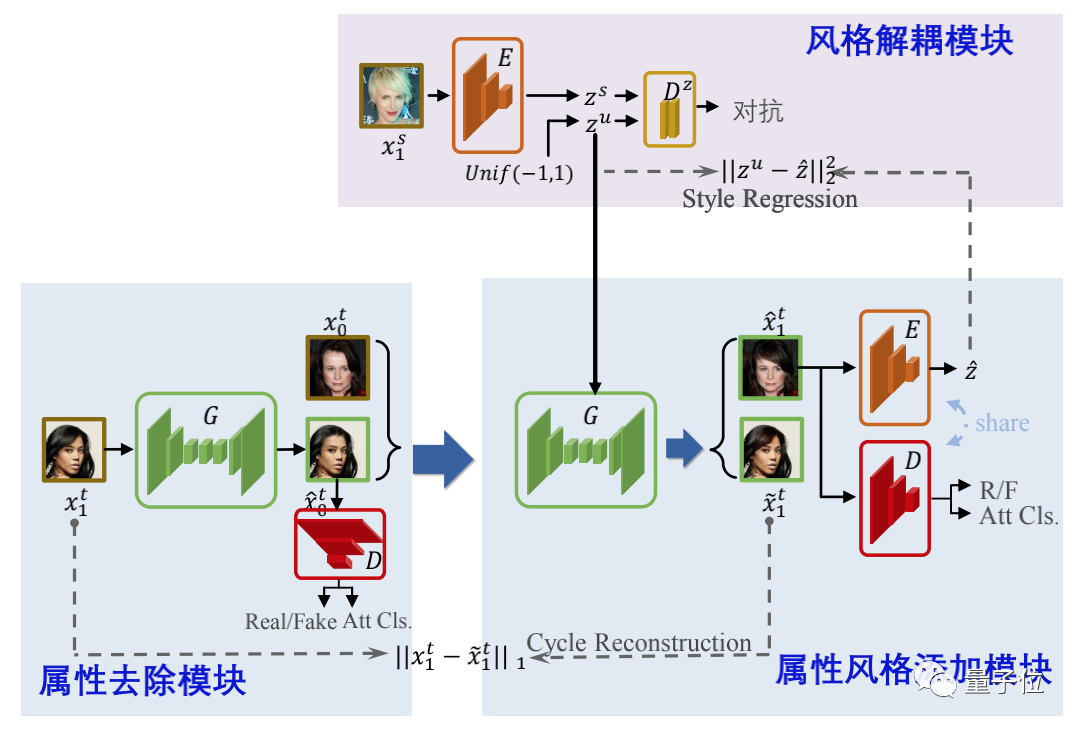

第三,在样例的层面上,阚美娜提出的方法叫做基于风格解耦的样例属性风格迁移。

主要分为两大模块:

一个是「两步法」模块,包括属性去除和属性风格添加。

一个是「风格解耦」模块,包括属性风格编码到均匀分布,以及最大化编码和风格的互信息。

最后,阚美娜总结道:

不同域间可迁移的信息存在多个层次。

不同信息的迁移方式是不同的。

郑良:测试集没有标注数据,也能评价模型性能

当测试集没有标注数据的时候,如何评价模型的性能?

这就是澳大利亚国立大学讲师郑良,在此次论坛中所做的报告内容——《Do We Really Need Ground Truths to Evaluate A Model?》。

△ 澳大利亚国立大学讲师 郑良

模型性能评估,可以说是机器学习中非常重要一步。

一般来说,在这样的过程中,是要求测试集包含测试样本与其标签, 并将测试标签与模型预测结果进行比较。

尽管学术界大多数数据集满足这个要求,但在实际情况中,往往只能获取测试数据而无法获取其标签。

对此,在本次报告中,郑良介绍了一个重要而较少讨论的问题:模型自动评估 (AutoEval)。

更具体地来说,问题可以描述为:

给定有标签的训练集和一个模型,目标是估计模型在一个没有标签的测试集上的性能。

为此,郑良给出了这样的思路。

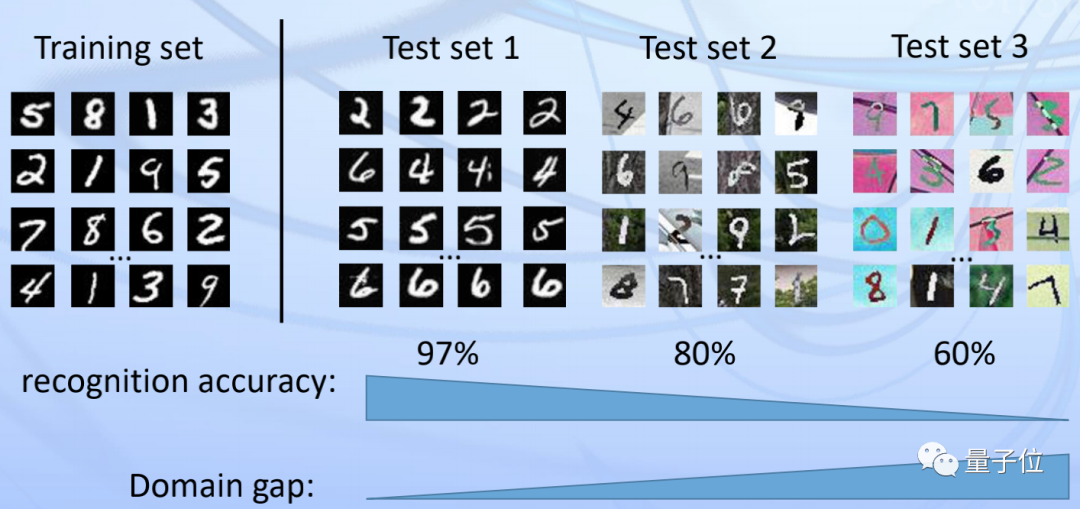

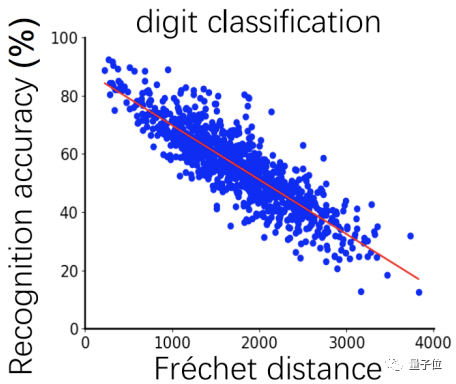

下图最左边的是一个训练集,不难看出,肉眼能看到的测试集和训练「长得」越像,识别的准确率就越高。

而这,实际上是一个domain gap的问题。换言之,识别的准确率会随着domain gap的增大而降低。

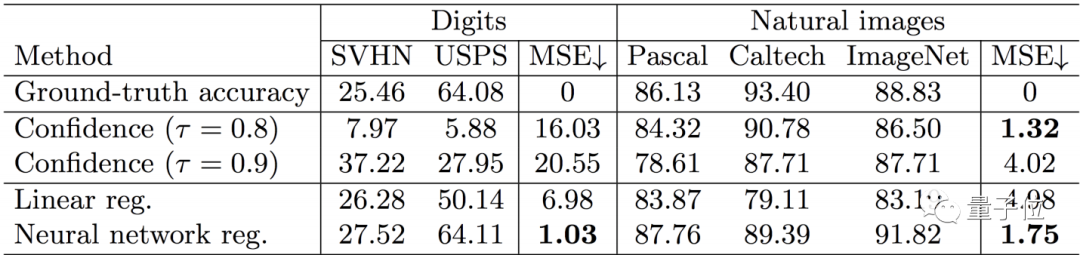

为此,郑良提出了一种 meta-dataset 的方法,从数据集层面上设计了一种回归模型。

并且在精度上也实现了较为理想的结果。

最后,郑良还表示,该方法在目标识别、检测和分割任务中,也有潜在的应用。

龙明盛:迁移学习理论

除了应用方面外,清华大学软件学院副教授、博士生导师龙明盛,从理论、算法角度对迁移学习进行了深入的思考,做了题为《迁移学习理论,算法及开源库》的报告。

△ 清华大学软件学院副教授 龙明盛

迁移学习一直是机器学习领域的难点问题,其目标是在数据分布变化的条件下实现强泛化能 力。

并且在迁移学习中,还经常会涉及源域和目标域,而它们的数据分布是不一样的。

这种情况下,若是在源域训练一个模型,无论是有监督或者无监督,在目标域的表现往往是不好的。

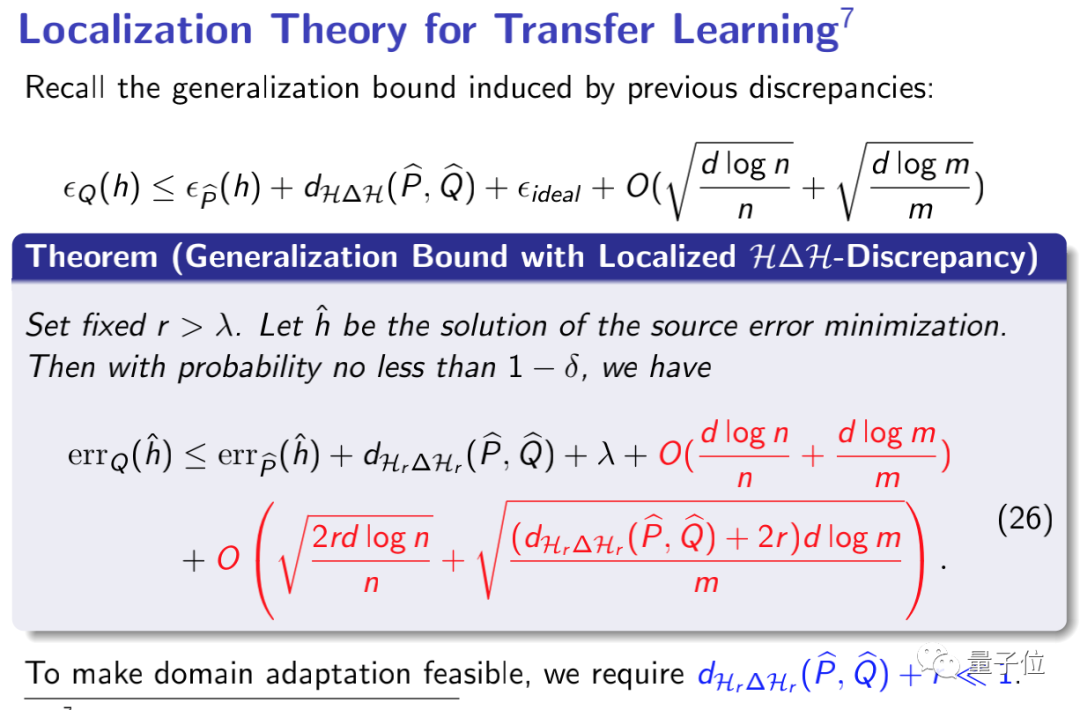

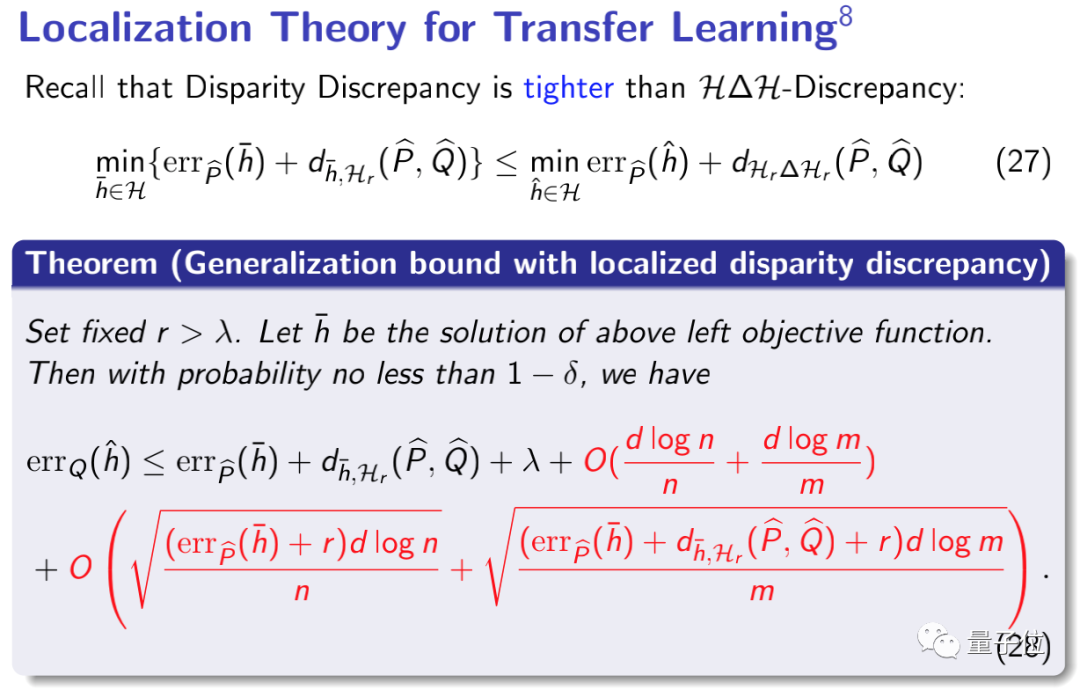

此时,假设源域的分布是P,目标域的分布是Q,因其分布的不同(即P(X)≠Q(X)),就会出现一种情况——协变量偏移(Covariate shift)。

在这种情况下,就会对应两类迁移学习的基本方法:

第一类就是基于距离的方法:定义分布P和Q的距离。

第二种就是基于对抗学习的方法:把P和Q分别当成两个domain,然后用对抗的方法让它们不分开。

但一般来讲,这2类方法在理论上是没有保证的。

龙明盛所做的工作,就是想要在此找到一个简单的理论和算法,来解释这样的一个现象——间隔泛化理论,如下公式所示。

申省梅:通用智能将会是下一代AI发展的必然趋势

最后,申省梅作为本届CNCC论坛主席,对《AI 落地的跨域学习技术和进展》分论坛做了总结。

△ 澎思科技首席科学家、新加坡研究院院长 申省梅

她认为,通用智能将会是下一代AI发展的必然趋势:

我感觉GPT3已经迈出了一大步,当然他们利用了大量的数据以及自监督学习。

我们今天讲到的迁移学习、联邦学习,再加上进展非常大的无监督学习、自监督学习,还有一些小样本学习、多模态学习等,这些技术相信在未来几年里,将会继续为AI的落地带来丰硕的成果。

这并不是申省梅第一次在CNCC组织这样的活动。

早在去年,她便在CNCC2019中组织了「计算机视觉技术赋能智慧城市」的技术论坛,还带来了主题为《视频图像智能化助力智慧安防建设》的演讲。

而作为澎思科技的首席科学家,申省梅也长期致力于监控与安全、智慧城市、自动驾驶、智能机器人以及AI 工厂自动化解决方案等领域的相关技术的开发部署和落地。

关于澎思科技

澎思科技成立于2018年9月29日,是一家AIoT生态平台公司,拥有全栈计算机视觉技术。

澎思科技以AI、IoT、SaaS闭环模式,为各细分行业提供智能物联设备、云服务以及场景化AIoT解决方案,赋能智慧城市、智慧人居、智慧商业等领域,推动AI产业化落地进程。

在成立短短2年时间里,澎思已经斩获15项计算机视觉技术相关世界冠军,并且于去年4月完成了1.5亿元A轮融资。

能够在这么短的时间里解锁如此成就,澎思的后发优势,正在展现出来。

— 完 —

本文系网易新闻•网易号特色内容激励计划签约账号【量子位】原创内容,未经账号授权,禁止随意转载。

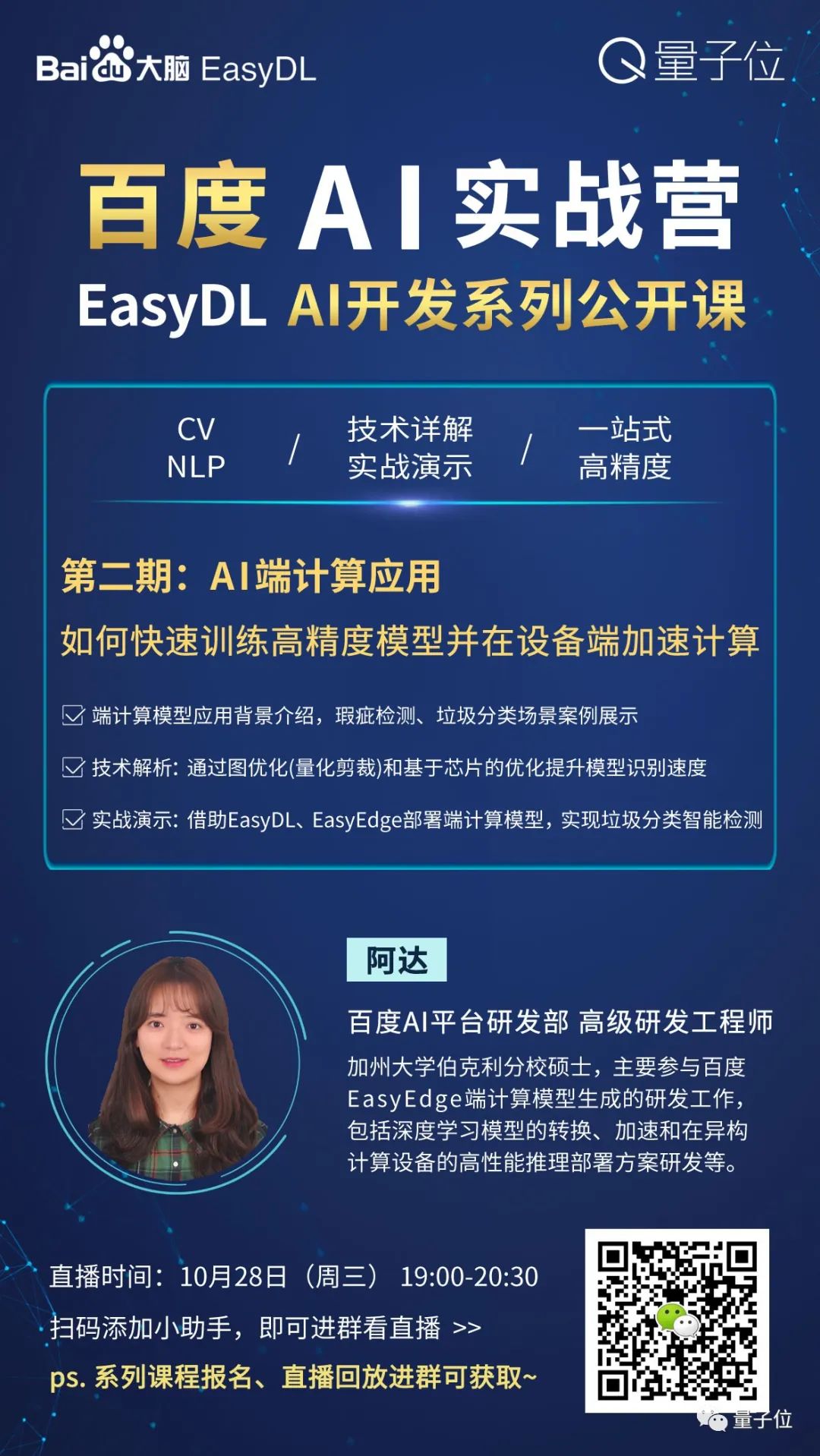

「百度AI开发系列课」免费报名!

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~