全球最大的图像识别数据库ImageNet不行了?谷歌DeepMind新方法提升精度

新智元原创

新智元原创

编辑:元子

【新智元导读】来自苏黎世谷歌大脑和DeepMind London的研究人员认为,世界上最受欢迎的图像数据库之一ImageNet需要改造。ImageNet是一个无与伦比的计算机视觉数据集,拥有超过1400万张标记图像。它是为对象识别研究而设计的,并按照WordNet的层次结构进行组织。层次结构的每个节点都由成百上千的图像描述,目前每个节点平均有超过500个图像。

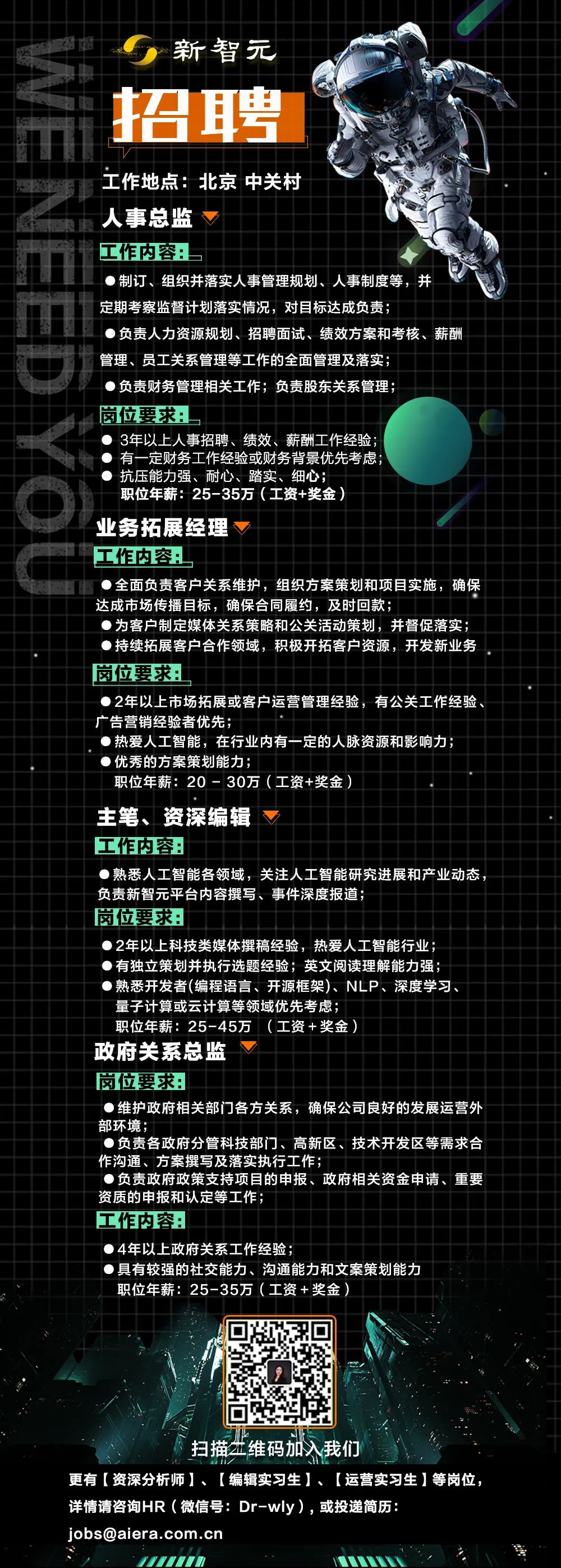

ImageNet标签出了哪些问题?

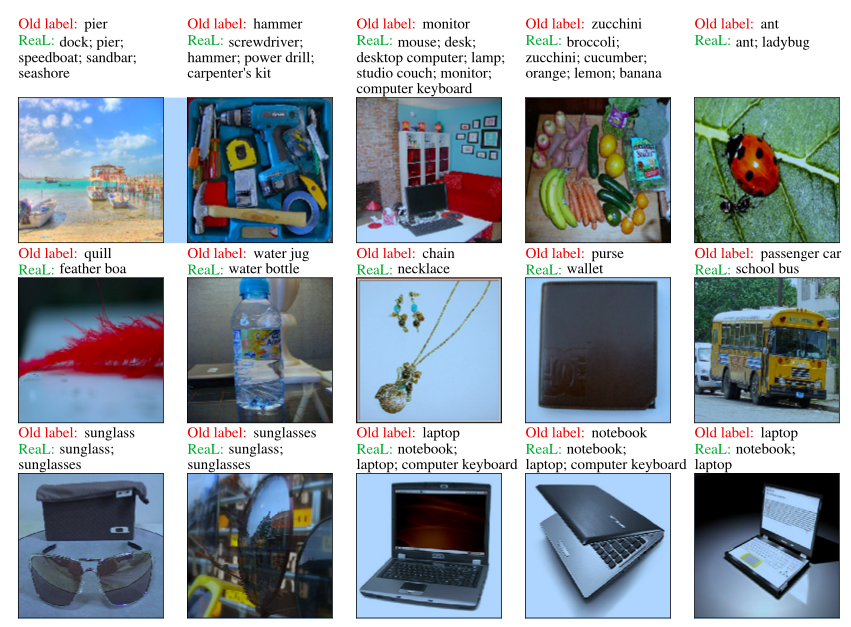

新方法如何改进ImageNet的缺陷

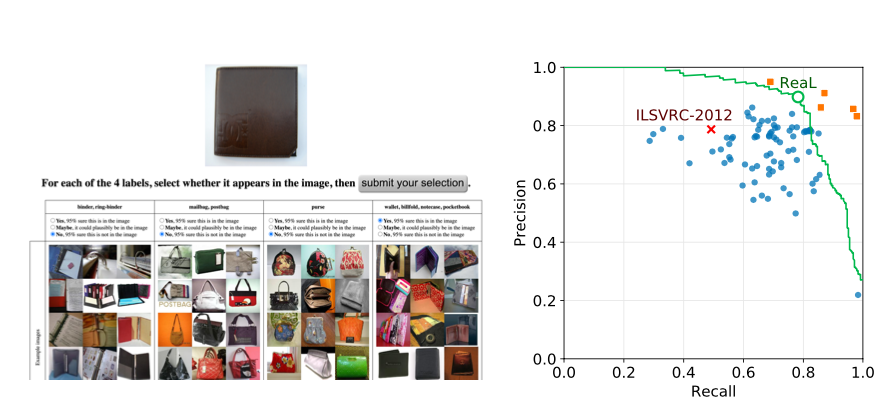

实验效果

登录查看更多

相关内容

ImageNet项目是一个用于视觉对象识别软件研究的大型可视化数据库。超过1400万的图像URL被ImageNet手动注释,以指示图片中的对象;在至少一百万个图像中,还提供了边界框。ImageNet包含2万多个类别; [2]一个典型的类别,如“气球”或“草莓”,包含数百个图像。第三方图像URL的注释数据库可以直接从ImageNet免费获得;但是,实际的图像不属于ImageNet。自2010年以来,ImageNet项目每年举办一次软件比赛,即ImageNet大规模视觉识别挑战赛(ILSVRC),软件程序竞相正确分类检测物体和场景。 ImageNet挑战使用了一个“修剪”的1000个非重叠类的列表。2012年在解决ImageNet挑战方面取得了巨大的突破,被广泛认为是2010年的深度学习革命的开始。