解码狗狗的视觉认知:眼里看到谁并不在乎,它们更关心看到的动作。

过去 15000 年,狗与人类共同进化。现在,狗狗常作为宠物栖息在人类生活环境中。有时狗狗像人一样在家中观看视频,仿佛是看懂了。

近日,来自埃默里大学的一项研究从狗的大脑中解码了视觉图像,首次揭示了狗的大脑如何重建它所看到的东西。这项研究发表在《可视化实验期刊》上。

![]()

论文地址:https://www.jove.com/t/64442/through-dog-s-eyes-fmri-decoding-naturalistic-videos-from-dog

研究人员记录了两只清醒的、不受约束的狗狗的 fMRI 神经数据,期间让它们分三次观看 30 分钟的视频,时长总共 90 分钟。然后他们使用机器学习算法来分析神经数据中的模式。

埃默里大学心理学教授、论文作者之一 Gregory Berns 表示:「我们可以在狗观看视频时监控它的大脑活动,并在一定程度上重建它正在看的东西。我们能够做到这一点是非常了不起的。」

Berns 及其同事开创性地将 fMRI 扫描技术用于犬类,并训练狗狗在测量神经活动时完全静止且不受约束。十年前,该团队发布了第一张完全清醒、不受约束的狗的 fMRI 大脑图像,为 Berns 所说的「The Dog Project」实验计划打开了大门。

![]()

Berns 和第一只在完全清醒且不受约束的情况下被扫描大脑活动的狗狗 Callie。

多年来,Berns 的实验室发表了多项关于犬类大脑如何处理视觉、语言、气味和奖励(例如接受表扬或食物)的研究。

与此同时,机器学习技术不断进步,使得科学家能够解码一些人类大脑的活动模式。然后 Berns 开始思考类似的技术能否应用到狗狗的大脑上。

此次新研究就是基于机器学习和 fMRI 技术完成的。fMRI 是一种神经影像学技术,其原理是利用磁振造影来测量神经元活动引发的血液动力的改变。这种技术是非侵入性的,在脑部功能定位领域具有重要作用。除了人类,该技术只应用于少数其他物种,包括一些灵长类动物。

实验中用到两只狗,它证明机器学习、fMRI 等技术可普遍用于犬科动物分析,研究人员也希望这项研究对其他人有所帮助,以便更深入地了解不同动物的思维方式。

实验参与者:Bhubo,4 岁;Daisy,11 岁。两只狗之前都参加过几项 fMRI 训练(Bhubo:8 项,Daisy:11 项),其中一些涉及观看投射到屏幕上的视觉刺激。这两只狗之所以被选中,是因为它们能够长时间呆在扫描仪内,而不会在主人看不见的情况下随便移动。

视频拍摄:以狗的视角拍摄视频,以捕捉狗生活中的日常场景。这些场景包括散步、喂食、玩耍、与人类互动、狗与狗的互动等。将视频编辑成 256 个独特的场景,每个场景都描绘了一个事件,例如狗与人类拥抱、狗奔跑或散步。根据其内容为每个场景分配一个唯一的编号和标签。然后将这些场景编辑成五个更大的汇编视频,每个视频大约 6 分钟。

![]()

实验设计:首先使用 3T MRI 扫描参与者,同时让参与者观看投射到 MRI 孔后部屏幕上的汇编视频。对于狗来说,通过事先训练,将它们的头放在定制的下巴托中,以达到头部稳定的位置,就像下图这样

![]()

实验分三次观看,每次观看 30 分钟的视频,时长总共 90 分钟。

实验过程中,同时使用 fMRI 对狗进行扫描,然后对数据进行分析,实验用到了 Ivis 机器学习算法,这是一种基于孪生神经网络 (SNN) 的非线性方法,已在分析高维生物数据上取得成功。此外,实验中还用到了 scikit-learn、RFC 等机器学习算法。

![]()

正在被扫描的 Daisy,耳朵被贴上胶带,用来固定耳塞,以消除噪音。

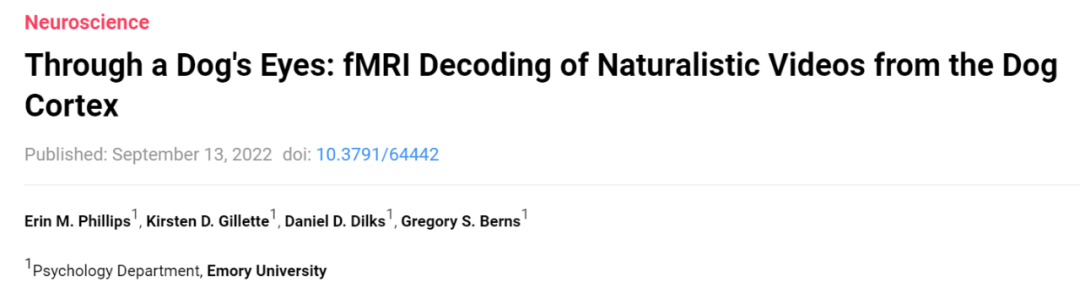

该研究比较了人类和狗的大脑工作方式。两个人类受试者的结果表明,使用神经网络开发的模型将大脑数据映射到基于对象和基于动作的分类器上的准确率达到了 99%;在解码狗的大脑模式时,同样的模型就不适用于对象分类器,而解码狗的动作分类时,准确率达到了 75% - 88%。这说明人类和狗的大脑工作方式存在重大差异,如下图人 ( A ) 和狗 ( B ) 的实验结果所示。对此,Berns 总结道:「我们人类非常关心看到的对象,而狗狗似乎不太关心他们看到的是谁或者看到了什么,而更关心动作行为。」

![]()

参考链接:https://news.emory.edu/features/2022/09/er_decoding_canine_cognition_14-09-2022/

掌握「声纹识别技术」:前20小时交给我,后9980小时……

《声纹识别:从理论到编程实战》中文课上线,由谷歌声纹团队负责人王泉博士主讲。

课程视频内容共 12 小时,着重介绍基于深度学习的声纹识别系统,包括大量学术界与产业界的最新研究成果。

同时课程配有 32 次课后测验、10 次编程练习、10 次大作业,确保课程结束时可以亲自上手从零搭建一个完整的声纹识别系统。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com