麻省理工学院的研究人员开发了一种机器学习技术,该技术学习以一种捕获在视觉和音频模式之间共享的概念方式来表征数据。他们的模型可以识别视频中某些动作发生的位置并对其进行标记。

背景

人类通过不同方式的组合来观察世界,例如视觉、听觉和我们对语言的理解。另一方面,机器通过算法可以处理数据来解释世界。

因此,当机器“看到”一张照片时,它必须将该照片编码为可用于执行图像分类等任务的数据。当输入有多种格式(如视频、音频剪辑和图像)时,此过程会变得更加复杂。

“这里的主要挑战是,机器如何调整这些不同的模式?作为人类,这对我们来说很容易。我们看到一辆汽车,然后听到汽车驶过的声音,我们知道这些是一回事。但对于机器学习来说,这并不是那么简单,”麻省理工学院计算机科学与人工智能实验室 (CSAIL) 的研究生、解决这个问题的论文的第一作者 Alexander Liu 说。

Liu 和他的合作者开发了一种人工智能技术,该技术学习以捕捉视觉和音频模式之间共享的概念方式来表征数据。例如,他们的方法可以了解到视频中婴儿哭泣的动作与音频剪辑中的口语“哭泣”有关。

利用这些知识,他们的机器学习模型可以识别视频中某个动作发生的位置并对其进行标记。

在跨模态检索任务中,它比其他机器学习方法表现更好,这些任务涉及查找一段数据,如视频,与以另一种形式(如口语)给出的用户查询相匹配。他们的模型还使用户更容易了解为什么机器认为它检索到的视频与他们的查询匹配。

有朝一日,这种技术可以用来帮助机器人通过感知来了解世界上的概念,就像人类一样。

与Liu一起参与论文的是 CSAIL 博士后 SouYoung Jin;研究生 Cheng-I Jeff Lai 和 Andrew Rouditchenko;Aude Oliva,CSAIL 高级研究科学家,MIT-IBM Watson AI 实验室主任;和资深作者James Glass,高级研究科学家和 CSAIL 口语系统小组的负责人。

该研究将在计算语言学协会年会(ACL)上发表。

学习表征

研究人员将他们的工作重点放在表征学习上,这是一种机器学习形式,旨在转换输入数据以使其更容易执行分类或预测等任务。

表征学习模型获取原始数据,例如视频及其相应的文本字幕,并通过提取特征或对视频中对象和动作的观察来对它们进行编码。然后它将这些数据点映射到一个网格中,称为嵌入空间。该模型将相似的数据聚集在一起作为网格中的单个点。这些数据点或向量中的每一个都由一个单独的单词表示。

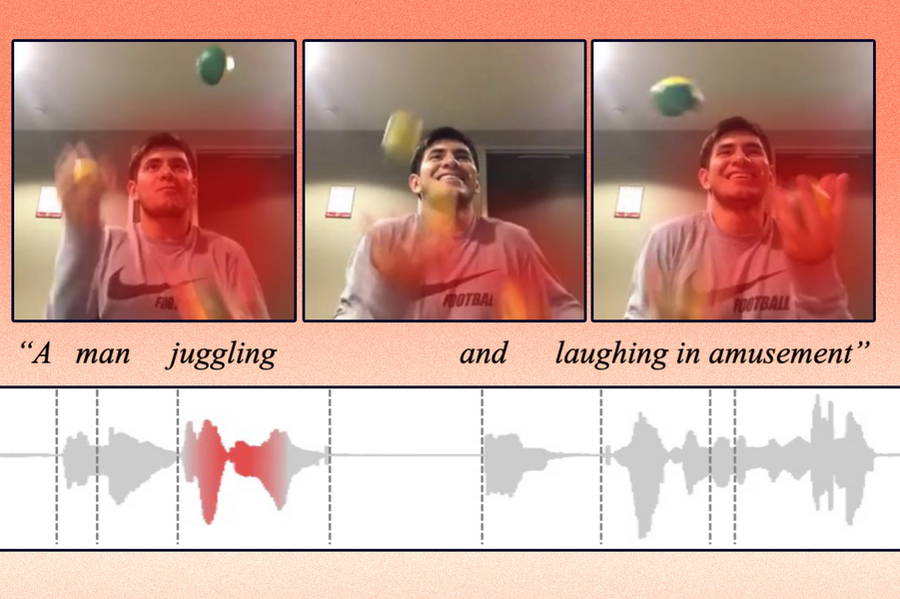

例如,一个人杂耍的视频剪辑可能会映射到一个标有“杂耍”的向量。

研究人员对模型进行了限制,使其只能使用 1000 个单词来标记向量。该模型可以决定要将哪些动作或概念编码到单个向量中,但它只能使用 1,000 个向量。模型选择它认为最能代表数据的词。

他们的方法不是将来自不同模态的数据编码到单独的网格上,而是采用共享的嵌入空间,其中两个模态可以一起编码。这使模型能够从两种模式中学习表征之间的关系,例如显示一个人杂耍的视频和一个人说“杂耍”的录音。

为了帮助系统处理来自多种模式的数据,他们设计了一种算法,引导机器将相似的概念编码到同一个向量中。

“如果有一个关于猪的视频,模型可能会将‘猪’这个词分配给 1000 个向量中的一个。然后,如果模型听到有人在音频剪辑中说出“猪”这个词,它仍应使用相同的向量对其进行编码,”Liu解释道。

更好的匹配结果

他们使用三个数据集在跨模态检索任务中测试了该模型:一个包含视频剪辑和文本字幕的视频-文本数据集,一个包含视频剪辑和语音音频字幕的视频-音频数据集,以及一个包含图像和语音音频的图像-音频数据集字幕。

例如,在视频-音频数据集中,模型选择了 1000 个单词来表示视频中的动作。然后,当研究人员向其提供音频查询时,该模型试图找到与这些口语最匹配的剪辑。

“就像谷歌搜索一样,你输入一些文本,机器会尝试告诉你正在搜索的最相关的内容。只有我们在向量空间中这样做,”Liu说。

与他们模型相比,他们的技术不仅更有可能找到更好的匹配,而且更容易理解。

因为该模型只能使用总共 1,000 个单词来标记向量,所以用户可以更容易地看到机器用来推断视频和口语相似的单词。Liu说,这可以使模型更容易应用于现实世界的情况,在这种情况下,用户了解它如何做出决策至关重要。

该模型仍有一些限制,他们希望在未来的工作中解决。一方面,他们的研究一次集中在两种模式的数据上,但在现实世界中,人类会同时遇到许多数据模式,Liu说。

“我们知道 1,000 个单词在这种数据集上有效,但我们不知道它是否可以推广到现实世界的问题,”他补充道。

此外,他们数据集中的图像和视频包含简单的对象或直接的动作;现实世界的数据要混乱得多。他们还想确定当输入的多样性更广泛时,他们的方法扩大规模的效果如何。

这项研究得到了 MIT-IBM Watson AI 实验室及其成员公司 Nexplore 和 Woodside 以及 MIT Lincoln 实验室的部分支持。

论文

表征学习的最新进展已经证明了在单个高级嵌入向量中表征来自不同模态(例如视频、文本和音频)信息的能力。在这项工作中,我们提出了一个自我监督的学习框架,该框架能够学习一种表征,该表征在不同的模态中捕获更精细的粒度级别,例如由视觉对象或口语表示的概念或事件。我们的框架依赖于通过向量量化创建的离散化嵌入空间,该空间在不同的模态中共享。除了共享嵌入空间,我们提出了一个跨模态代码匹配目标,它强制来自不同视图(模态)的表示在离散的嵌入空间上具有相似的分布,从而可以在没有直接监督的情况下执行跨模态对象/动作定位。在我们的实验中,我们表明所提出的离散化多模态细粒度表征(例如,像素/单词/帧)可以补充高级摘要表示(例如,视频/句子/波形),以提高跨模态检索任务的性能。我们还观察到离散化表征使用单个集群来表征跨模态的相同语义概念。