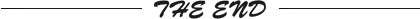

优酷用户触达平台技术大揭秘

优酷在用户运营场景上,沉淀了丰富的用户运营及营销触达策略。为了保障用户的持续活跃,当用户进入产品生命周期的后半段(预流失/流失状态)就需要精准洞察用户,在恰当的时机,通过正确的渠道,向用户推送个性化的内容达到召回、转化及促活的目的。但当我们深挖这些用户触达运营场景时,发现如下问题:

平台架构实现

一)人群及事件

离线人群

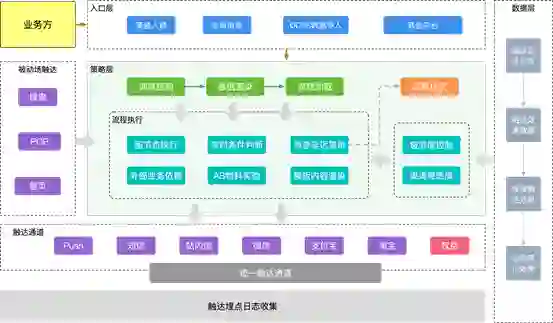

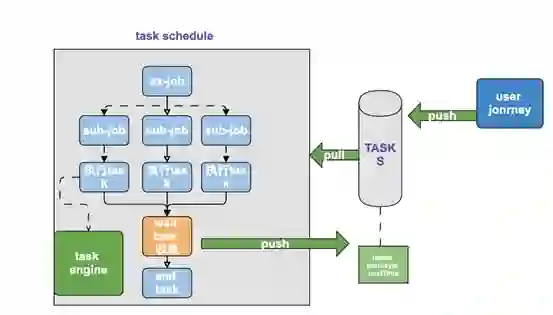

调度引擎也是基于任务调度的引擎。根据任务类型主要分为流程任务、等待任务;流程任务主要针对离线人群流程入口节点的调度,而等待任务是流程任务因在等待节点中断流程执行,在之后恢复执行的任务。目前支持多种调度策略,定时、立即发送,单次、周期任务,最终转化成调度表达式。流程任务的整体调度流程分3层:

-

获取人群类型、人群数量以及分页等基本信息; -

分页获取人群用户列表,并完善用户账户信息; -

根据配置细分成更小的人群分片,分片信息暂存 nosql。

人群任务及事件任务都支持流程等待,因为人群策略实现上略有差异,所以等待流程的实现也略有差异,但整体一致。任务暂存至 nosql 数据库,以任务需恢复时间时刻(分钟)为 key,等待任务的调度需要每分钟扫描以当前时刻为 key 的等待流程。

-

人群规模不可控,经常会有上亿的人群场景,人群信息预加载内存后,短时间对内存产生了极大的开销。为了解决这个问题,我们引入了 nosql 进行了人群信息的暂存,在子任务执行时,再预加载人群数据; -

人群任务触发时,执行引擎线程都是满负载运行;最初我们考虑运行效率,在触达渠道节点又引入了一层异步线程,但事与愿违,异步线程池的等待任务队列在短时间打满,并又占用大量内存,最终取消了异步发送逻辑。另一方面,除了渠道服务,触达的物料素材可能会依赖于外部数据源,在高并发服务调用下,对下流业务服务产生了极大的压力。为此,我们引入匀速器模式,针对各个业务提供的预设 qps 执行调用。

消息事件

-

消息过滤器,通过 MVEL 表达式提取目标消息; -

目标字段映射,规范触达内部的消息格式; -

占位符及参数表达式,消息数据加工;

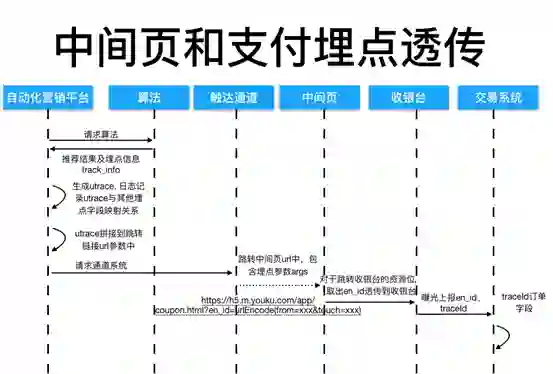

上面提到,离线人群的缺点是无法携带业务内容,这对一些千人千面的触达需求不能很好的支持。而业务消息在一些营销场景下也不能很好的支持,基于此我们引入了 ODPS 数据导入的能力。它有离线人群的业务特性,又有事件消息的业务能力,而且技术实现上统一将导入转化成消息事件,使其与消息处理逻辑保持一致。目前导入是针对一些特有的业务场景,使用频次会较低,但其自由度较高。导入人群实现方案结合了离线人群以及事件人群的能力,能在满足业务诉求的同时能有较高的发送效率。

二)策略执行引擎

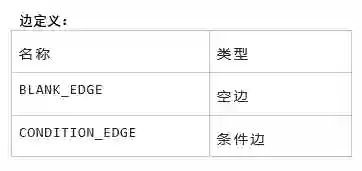

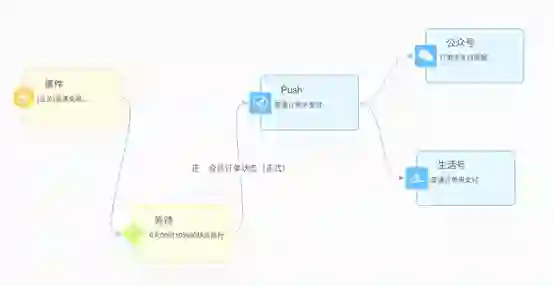

按照规范,我们产出了如下触达策略。实现层面,我们用 node,edge 两个列表进行存储,通过首尾相连,组成一个 Graph。节点以及条件边都有对应类型的控制器实现,通过解析后的 Graph,依次执行对应控制器。

在执行阶段,执行引擎根据策略编排规范,逐一执行各个节点。当然,前置数据预处理、调度逻辑已经在人群、事件入口已完成。执行引擎执行顺序如下:

-

接收人群分区任务、事件消息任务以及等待任务; -

获取流程对应节点流程图; -

执行上下文数据预处理,并进行执行引擎数据收集; -

定位首个执行节点,等待任务需要从上一次终端节点下一个节点开始执行; -

执行首个节点对应控制器; -

节点执行结束,获取后续节点列表,并逐一执行; -

节点中断或所有节点执行完成,更新相关计数,退出执行引擎。

三)物料及数据源

-

事件占位符只针对事件流程,可以对事件消息体内容进行逻辑加工处理,产出我们需要的占位符变量; -

数据源占位符相对通用,不局限于流程类型,对定义的数据源结果进行二次加工产出需要的占位符变量。这个的数据源一般是一个外部的服务,需要预先确认服务,方法,以及入参出参的映射。

数据源难点及实现

数据源入参不足

事件、导入人群,因人群本身就携带了业务参数,使用相对方便,一般数据源入参都能映射到人群消息变量上;离线人群本身只携带了用户id,所以在很多业务场景使用数据源能力会受限,非常受到限制;

实现方案

a) 任务配置环节,通过与其他平台的交互,引入对应的业务入参,业务参数在任务级别是静态的,通过数据源调用在实现消息个性化;

b) 通过ODPS业务数据表导入,人群信息同时携带业务信息;借助ODPS的开发能力以及数据动态更新能力,能覆盖各类负载的触达需求。

复杂业务配置受限

数据源能力目前仅支持在物料占位符上,一个数据源配置一个服务调用,对需要多个服务组合调用场景并不能很好的支持;目前需要通过硬编码的形式再产出一个新的服务

实现方案

a) 将数据源的能力扩展至前置节点中,通过串行编排,实现数据源链式执行的能力;

b) 支持数据源之间的联动,通过上下文传递数据源占位符等信息,作为后续节点的输入。

高并发场景

离线人群使用阿里分布式调度服务MapReduce模型,事件人群直接是对消息队列的消息消费。在流程执行中,对物料模块会产生极大的压力,数据源服务提供方的RT参差不齐

实现方案

a) 基于入口节点的高并发执行场景,数据源不适合异步化,异步执行在高并发场景时会使数据源任务场景大量的堆积,最终会产生大量的内存压力;

b) 权衡整体的平台负载及触达性能,我们采用了数据源的同步调用,针对多数据源场景进行并发调用以提高整体的执行效率。

数据能力

数据回流

总结及展望

更多精彩推荐

☞ 实用小技能 | 用 Word 和 Excel 自制一个题库自判断答题系统! ☞中国数据库产业的“高地战事” ☞ 融资 2000 万美元后,他竟将核心代码全开源,这……能行吗? ☞ Get了!用Python制作数据预测集成工具 | 附代码 ☞ 学会这10大高性能开发技术,轻松躲过裁员名单! ☞ 小心!你可能玩了假的DeFi ![]()

点分享 ![]()

点点赞 ![]()

点在看