首届欧洲NLP会议EurNLP2019落幕,有什么独特之处吗?

作者 | Wei Zhao

编译 | 杨晓凡

编辑 | 唐里

前有美国、加拿大引领理论创新,后有中国在实际应用上紧追猛赶,欧洲学术圈在深度学习时代的存在感并不怎么强。一个这样的会可以看做是报团取暖,更可以看做是鼓励更多交流和创新。

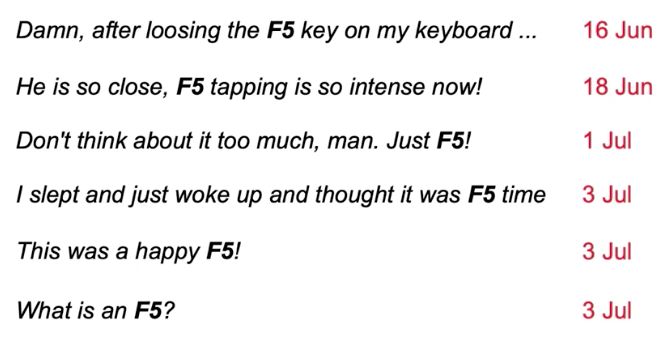

在深度学习的热潮推动下,人工智能的各个相关领域都展现出勃勃生机,学术会议也一个紧接着一个。今年十月上旬,在甘肃敦煌举行的以中文语言计算为特点的 NLPCC 2019 才刚刚落幕,首届欧洲 NLP 会议 EurNLP 就于 11 日在英国伦敦举行。根据会议官方介绍,EurNLP 关注学术界和工业界出现的真实世界 NLP 问题,让欧洲的青年学者和专家们齐聚一堂,讨论基础科研和实证研究话题。

点击“阅读原文”查看 更多顶会见闻

登录查看更多

相关内容

Arxiv

3+阅读 · 2019年8月22日

Arxiv

7+阅读 · 2018年4月17日