相信你的模型:初探机器学习可解释性研究进展

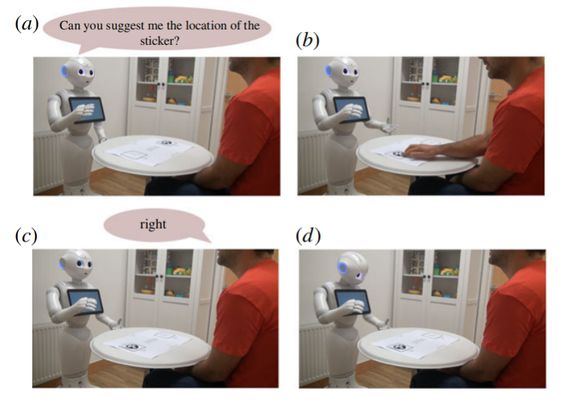

随着机器学习(ML)领域的深入发展,机器人在教育、引导、医疗方面都有巨大的应用。但如今人们不仅关注于机器人执行任务的准确和效率,更希望理解其决策的原因和行动,从而判断是否信任答案,而这正也是可解释人工智能(XAI)所要研究的问题。

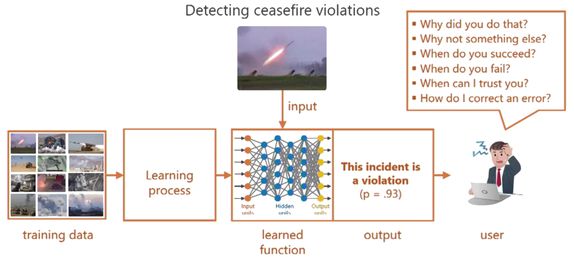

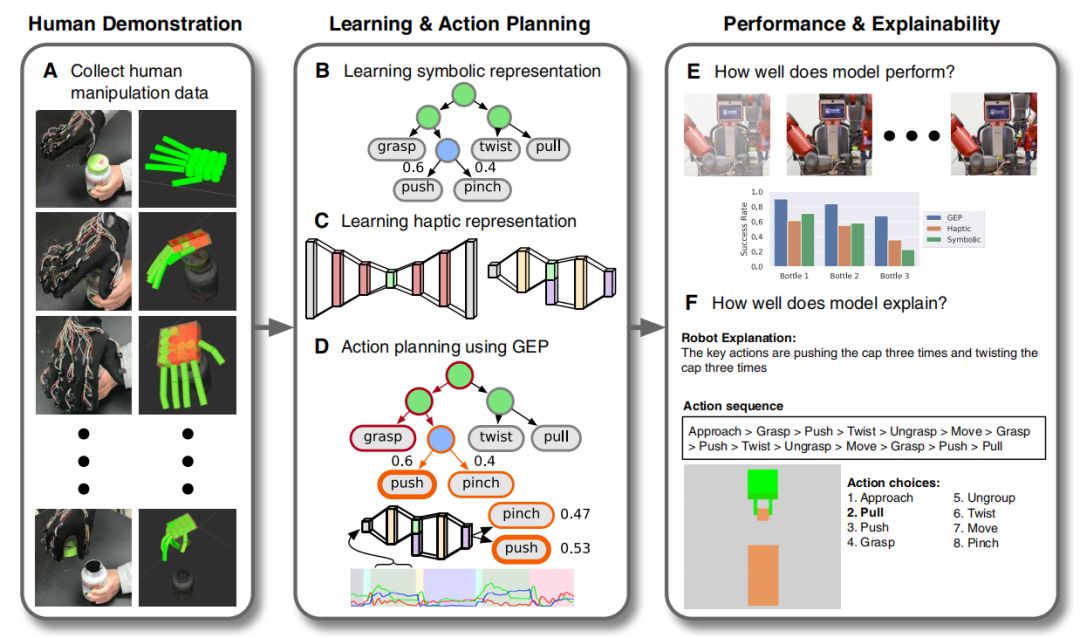

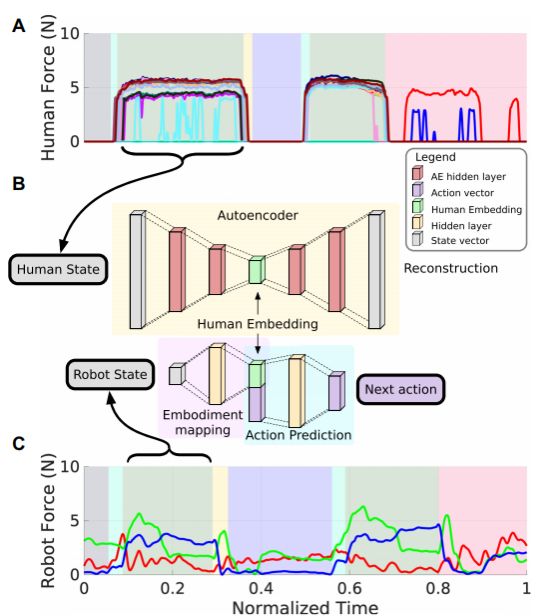

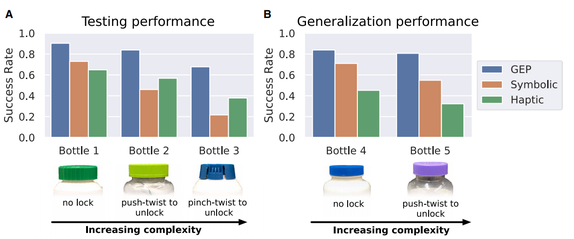

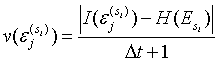

(1)

(1)

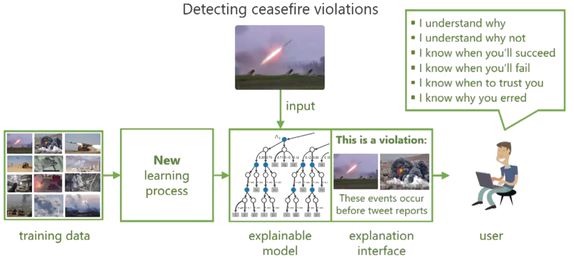

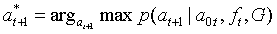

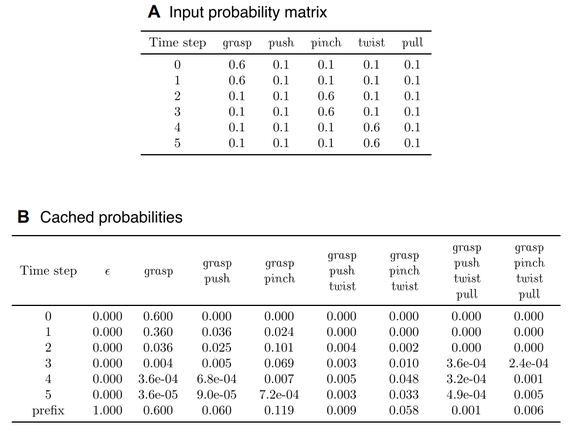

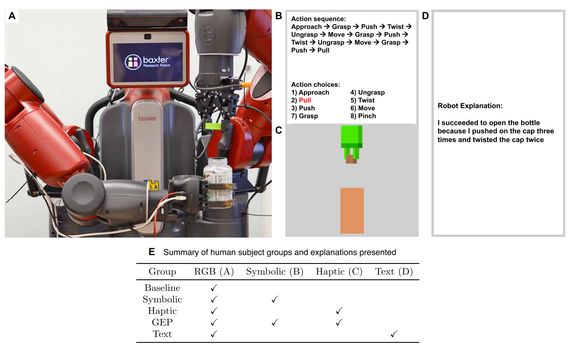

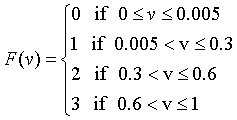

(2)

(2)

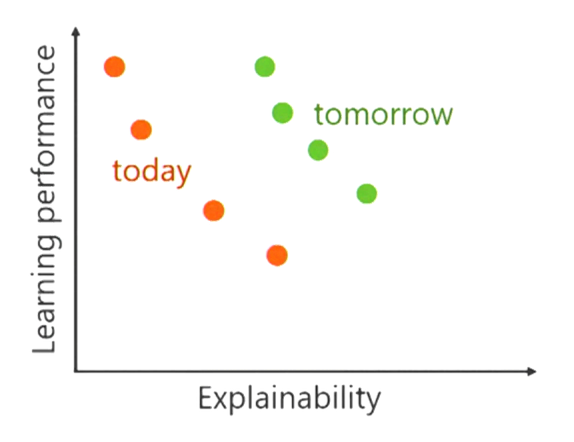

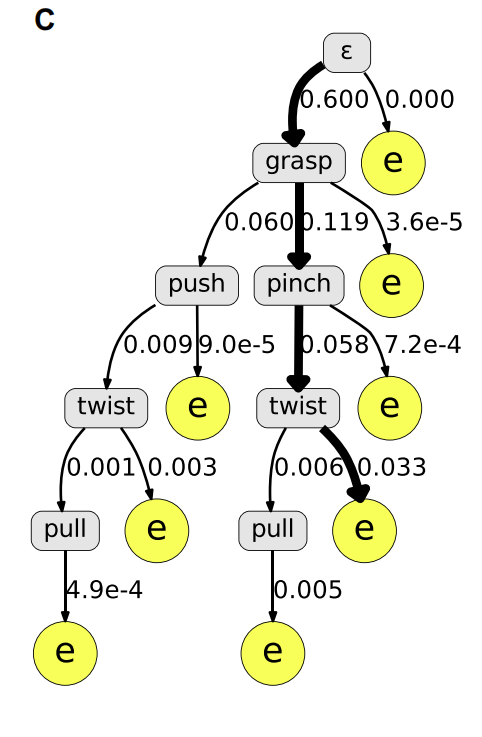

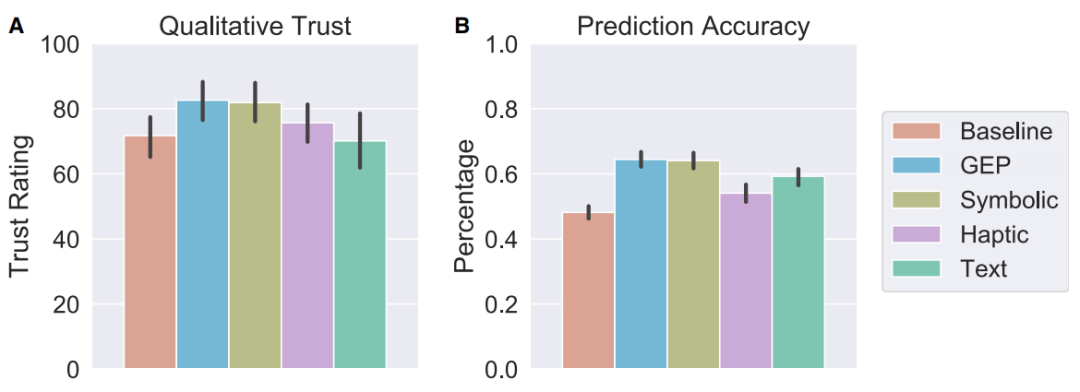

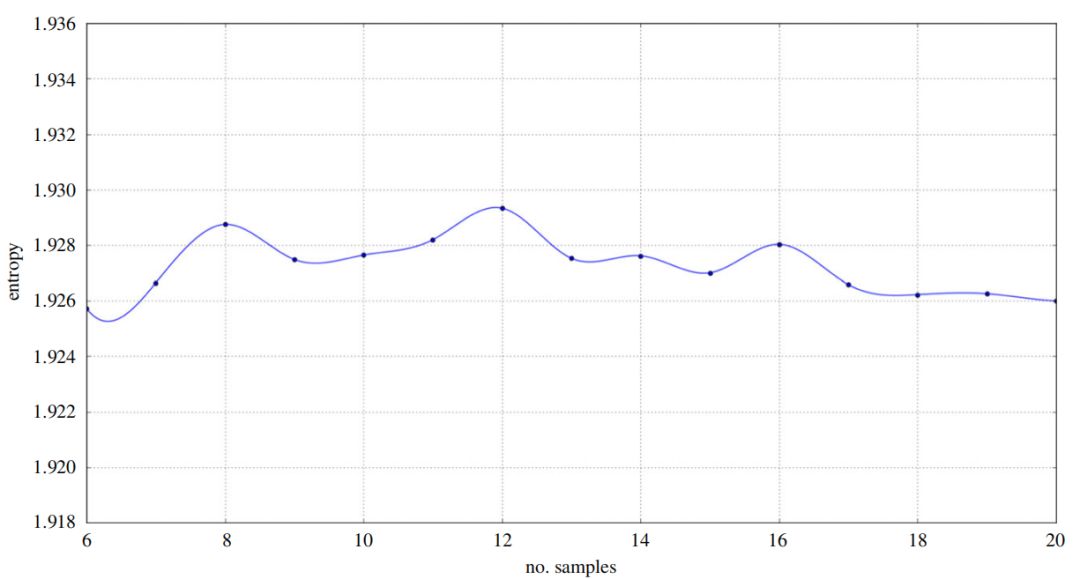

(3)

(3)

登录查看更多

相关内容

Arxiv

5+阅读 · 2018年5月23日