使用 Live Transcribe 进行实时连续转录

文 / Sagar Savla,机器感知产品经理

据世界卫生组织 (WHO) 估计,全球有 4.66 亿耳聋及听障人士。为了让这类人群获取全球资讯并与他人沟通,自动语音识别 (ASR) 这项关键技术应运而生,它使计算机能够检测有声语言,并将其转录成文本以供阅读。Google ASR 为 Youtube 的自动生成字幕功能、幻灯片演示以及电话通话提供了支持。然而,尽管 ASR 在过去几年进行过多次改进,但耳聋及听障人士仍主要依赖手动转录服务,如美国的 CART、英国的 Palantypist 或其他国家 / 地区的 STTR。由于此类服务颇为昂贵,而且通常需要提前很久预订,因而耳聋及听障人士很难有机会参与即兴对话和社交场合。但我们相信,技术能填补这个缺口,让此类人群能够轻松沟通。

今天,我们宣布推出 Live Transcribe,这项免费的 Android 服务将自动生成字幕的功能引入日常对话,使此类人群离现实对话更近一步。Live Transcribe 由 Google Cloud 助力,可实时提供对话字幕,支持 70 多种语言并覆盖全球 80% 以上的人群。只需轻点一下系统任务栏上的 “无障碍功能” 图标,即可在任意应用中启用此服务。

构建 Live Transcribe

过去,基于 ASR 的转录系统一般都需要计算密集型模型、详尽的用户研究以及昂贵的连接服务费用,所有这些因素都妨碍用户使用自动连续转录服务。为解决这些问题并确保实时转录足够准确,Live Transcribe 结合了广泛用户体验 (UX) 研究的成果,以及与语音处理服务器流畅和可持续的连接。此外,我们需要确保与这些服务器的连接不会给用户造成过多的流量消耗。

依靠云的 ASR 为我们提供了更高的准确度,但我们想减少 Live Transcribe 所需的网络流量消耗。为做到这一点,我们以利用 AudioSet 完成的先前工作为基础,实现了基于神经网络的设备上语音检测器。该网络是一种图像式模型,与我们已发布的 VGGish 模型类似,可检测语音并自动管理与云 ASR 引擎的网络连接,从而最大程度地减少长期使用过程中的流量消耗。

用户体验

为了使 Live Transcribe 尽可能直观,我们与加拉德特大学共同发起了用户体验研究,以确保满足核心用户需求,同时最大程度地发挥技术潜力。我们考虑了几种不同的模式:计算机、平板电脑、智能手机,乃至小型投影仪,以迭代方式显示听觉信息与字幕。最终,我们决定将重心放在智能手机模式,因为这类设备无处不在,其功能亦在与日俱增。

构建此模式后,我们需要解决另一个重要问题:显示转录置信度。从传统上看,此举对用户很有帮助,而我们的研究探索了是否真的需要显示单词级别或短语级别的置信度。

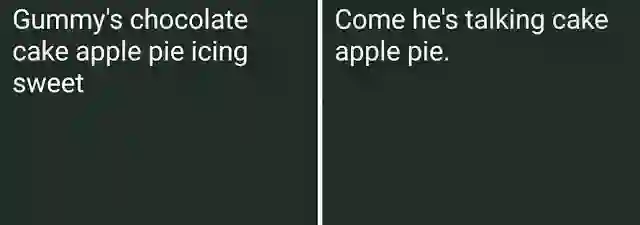

显示转录的置信水平。黄色代表高置信度,绿色代表中等置信度,而蓝色代表低置信度。白色单词为新文本,在最终确定置信度前等待语境处理。左图按每个短语进行着色,右图则按每个单词进行着色。1 研究表明,置信度着色分散了用户的注意力,却不会提供对话价值。

我们研究的表明,转录文字在不使用这些标志覆盖的情况下最便于阅读,同时这也巩固了之前在该领域的用户体验研究。而 Live Transcribe 侧重于更好地呈现文本,并使用语音以外的其他听觉信号加以补充。

另一种有用的用户体验信号则是用户当前所处环境的噪声级别。对计算机而言,在嘈杂房间内理解说话人所说的内容是一项重大挑战,这称为鸡尾酒会问题。为解决此问题,我们构建了一个指示器,用于显示相对于背景噪声的用户说话音量。当说话人讲话时,用户也可借此收到即时反馈,了解麦克风的接收状况,以便其调整手机位置。

响度与噪声指示器由两个同心圆构成。较亮的内部同心圆代表噪声层,它会让耳聋用户了解当前环境所处的噪声级别。外部同心圆表示麦克风对说话人声音的接收状况。将二者相结合后,相对差异便会一目了然

未来工作

针对基于移动设备的自动语音转录功能,未来可能作出的改进包括设备上识别、说话人分离和语音增强。仅仅依靠转录功能的话,可能会有些隐患,导致信息传达错误。我们与加拉德特大学的研究表明,如果将此功能与其他听觉信号(如语音检测和响度指示器)相结合,便会给用户的交流方式带来意义重大的改变。

Live Transcribe 现已在 Play 商店中分阶段推出,且所有 Pixel 3 设备均预装此功能的最新版本。您可以通过 “无障碍设置” 启用 Live Transcribe。如需更多相关信息,您也可以阅读 The Keyword。

致谢

Live Transcribe 由研究员 Chet Gnegy、Dimitri Kanevsky 及 Justin S. Paul 与 Android 无障碍团队成员 Brian Kemler、Thomas Lin、Alex Huang、Jacqueline Huang、Ben Chung、Richard Chang、I-ting Huang、Jessie Lin、Ausmus Chang、Weiwei Wei、Melissa Barnhart 及 Bingying Xia 共同打造。我们也要感谢来自加拉德特大学的亲密合作伙伴 Christian Vogler、Norman Williams 和 Paula Tucker。

1 眼尖的读者会发现,在以上视频中,Obeidat 博士使用的是短语级别的置信度模式。

更多 AI 相关阅读: