陶大程院士等最新《深度学习理论进展》综述论文,41页pdf255篇文献阐述六大方面进展

澳大利亚科学院院士、悉尼大学教授陶大程等撰写的关于《深度学习理论综述论文》,非常值得关注

深度学习通常被描述为一个实验驱动的领域,并不断受到缺乏理论基础的批评。这个问题已经部分地被大量的文献解决了,这些文献至今没有被很好地组织起来。本文对深度学习理论的最新进展进行了综述和整理。文献可分为六类: (1)基于模型复杂度和容量的深度学习泛化; (2)用于建模随机梯度下降及其变量的随机微分方程及其动力学系统,其特征是深度学习的优化和泛化,部分受到贝叶斯推理启发; (3)驱动动力系统轨迹的损失的几何结构; (4)深度神经网络的过参数化从积极和消极两个方面的作用; (5)网络架构中几种特殊结构的理论基础; (6)对伦理和安全及其与泛化性的关系的日益关注。

地址:

https://www.zhuanzhi.ai/paper/b5ac0f259b59817b890b6c253123ee84

概述

深度学习可以广义定义为使用人工神经网络从经验中发现知识以进行预测或决策的一系列算法[138]。经验的规范形式可以是人类注解的电子记录作为数据集,也可以是学习者或电子环境之间的交互作用,取决于场景[169]。在深度学习中,一般的人工神经网络通常是把一个由非线性激活函数组成的序列的权值矩阵连接成一个网络,这种网络具有相当大的参数大小。

深度学习的术语是由Dechter[62]引入机器学习,然后由Aizenberg等人[5]引入脑启发算法,其中几个主要概念可以追溯到20世纪40年代早期。深度学习的研究在20世纪40 - 60年代[162,111,199]和80 - 90年代[201]经历了两次上升后下降。第三次和当前的浪潮开始于2006年[24,114,196],一直持续到现在。最近的浪潮已经从本质上重塑了许多真实世界的应用领域,包括计算机视觉[110]、自然语言处理[63,184]、语音处理[64]、3D点云处理[98]、数据挖掘[232]、推荐系统[247]、自动驾驶汽车[152,215]、医疗诊断[135,209]和药物发现[43]。

然而,到目前为止,深度学习的发展严重依赖实验,缺乏坚实的理论基础。深度学习机制的许多方面仍然是未知的。我们不断地惊讶地发现启发式方法可以在广泛的领域实现出色的性能,尽管有时也相当不稳定。与此同时,直觉方法往往未被证实,甚至未被验证。这种做法是可以容忍的,并且在深度学习研究中已经变得普遍。这种黑盒特性给深度学习应用带来了未知的风险。这种不了解在很大程度上削弱了我们识别、管理和预防算法导致的灾难的能力,并进一步严重损害了我们将最近的进展应用于许多工业部门的信心,特别是在安全关键领域,如自动驾驶汽车、医疗诊断和药物发现。这也对深度学习算法设计的未来发展产生了冲击。

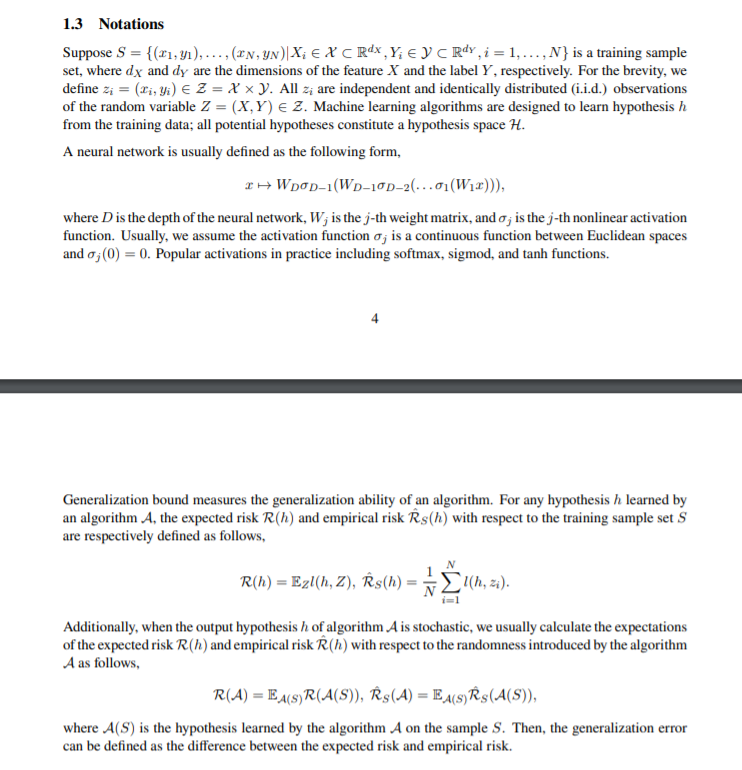

理论基础的一个主要部分是泛化,泛化是指通过深度学习算法对未见数据进行预测,在训练数据上训练好的模型的能力[224,169]。由于训练数据不能覆盖未来的所有情况,良好的泛化性保证了所学的模型能够处理未知事件。在长尾事件经常出现并有可能造成致命灾难的地方,这一点尤其重要。

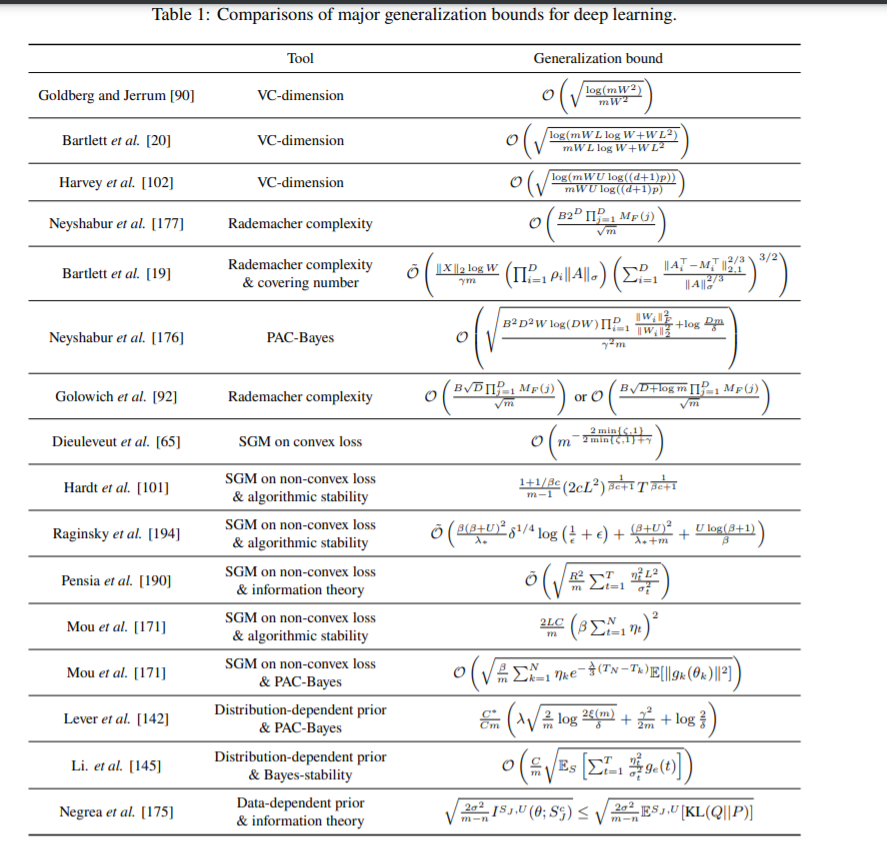

统计学习理论建立了基于假设复杂度的泛化理论[224,169]。这些工具能解决深度学习理论中的问题吗?答案是否定的。传统工具通常根据假设复杂度构建泛化边界,如vc维[28,223]、Rademacher复杂度[130,129,21]和覆盖数[73,104]。在经典的结果中,这些复杂性很大程度上依赖于模型的大小。这就引入了奥卡姆剃刀原理:

如无必要,勿增实体

即,只要模型能够拟合训练样本,就需要找到一个足够小的模型来防止过拟合。然而,深度学习模型通常具有非常大的模型规模,这有时会使泛化界甚至大于损失函数的潜在最大值。此外,根据Occam 's razor原理,可泛化性与模型大小之间存在正相关关系,而这在深度学习中已经不存在了。相比之下,更深更广的网络往往具有优越的性能[38]。深度学习卓越的泛化能力与其极端的过参数化之间的矛盾,就像传统复杂学习理论的一朵“云”。

早期的工作试图建立深度学习的理论基础[172,90,22,20,23,158,11],但很大程度上由于深度学习研究的广泛发展而停滞不前。

最近的研究始于Zhang等人在2017年的工作[244]。作者进行了系统的实验来探索深度神经网络的泛化能力。他们表明,即使训练标签是随机的,神经网络也能几乎完美地拟合训练数据。如何从理论上解释深度神经网络的成功,是学习理论界关注的一个重要话题。Kawaguchi等人[122]讨论了许多关于深度神经网络在容量大、复杂性、算法可能不稳定、非鲁棒性和极小值尖锐的情况下仍具有出色泛化能力的开放问题。作者也提出了一些解决问题的见解。从那时起,深度学习理论的重要性得到了广泛的认识。大量文献的出现建立了深度学习的理论基础。在本文中,我们回顾了相关文献,并将其归纳为以下六类:

基于复杂度和容量的方法分析深度学习泛化性。传统的统计学习理论根据假设空间的复杂度,建立了一系列泛化误差(泛化界)的上界,如vc维[28,223],Rademacher复杂度[130,129,21],覆盖数[73,104]。通常,这些泛化范围明确地依赖于模型的大小。他们认为,控制模型的大小可以帮助模型更好地泛化。然而,深度学习模型庞大的模型规模也使得泛化范围显得空洞。因此,如果我们能够开发出大小无关的假设复杂度度量和泛化边界是非常值得期待的。一种有前景的方法是刻画深度学习中可以学习的“有效”假设空间的复杂性。有效假设空间可以明显小于整个假设空间。因此,我们可以期望得到一个小得多的泛化保证。

随机梯度下降(SGD)及其变体模型的随机偏微分方程(SDE)在深度学习优化算法中占主导地位。这些SDEs的动态系统决定了训练神经网络中权值的轨迹,其稳定分布代表了学习网络。通过SDEs及其动力学,许多工作为深度学习的优化和泛化提供了保障。“有效”假设空间正是“SGD能找到的”假设空间。因此,通过SGD研究深度学习的普遍性将是直接的。此外,这一系列的方法部分受到贝叶斯推断的启发。这与前面的变异推断相似,后者以优化的方式解决了贝叶斯推断,以解决缩放问题。这种随机梯度方法和贝叶斯推断之间的相互作用将有助于这两个领域的发展。

高度复杂的经验风险曲面的几何结构驱动动态系统的轨迹。损失曲面观的几何形状在驱动SDEs的轨迹方面起着重要作用:(1)损失的导数是SDEs的组成部分;(2)损失作为SDEs的边界条件。因此,理解损失面是建立深度学习理论基础的关键一步。通常,“正则化”问题的可学习性和优化能力是有保证的。1“正则化”可以用许多术语来描述,包括凸性、李普希茨连续性和可微性。然而,在深度学习中,这些因素不再得到保障,至少不是很明显。神经网络通常由大量的非线性激活组成。激活过程中的非线性使得损失曲面极其不光滑和非凸。所建立的凸优化保证失效。损失曲面令人望而却步的复杂性,使社区长时间难以接触到损失曲面的几何形状,甚至深度学习理论。然而,损失面复杂的几何形状恰恰表征了深度学习的行为。通过损失曲面是理解深度学习的“捷径”。

深度神经网络的过参数化作用。过度参数化通常被认为是通过基于复杂性的方法为深度学习开发有意义的泛化边界的主要障碍。然而,最近的研究表明,过度参数化将对塑造深度学习的损失曲面做出主要贡献——使损失曲面更加光滑,甚至“类似”凸。此外,许多研究也证明了神经网络在极端过参数化情况下与一些更简单的模型(如高斯核)等效。

网络架构中几种特殊结构的理论基础。在前面的综述中,我们主要关注的结果一般代表所有的神经网络。同时,深度神经网络的设计涉及到许多特殊的技术。这些结构也对深度学习的卓越性能做出了重要贡献。我们回顾了卷积神经网络、递归神经网络和置换不变/等变函数网络的理论成果。

深入关注伦理和安全以及它们与深度学习理论的关系。深度学习已经被部署在越来越广泛的应用领域。其中一些涉及高度隐私的个人数据,如手机上的图像和视频、健康数据和最终记录。其他一些场景可能需要深度学习来提供高度敏感的决策,比如抵押贷款审批、大学入学和信用评估。此外,研究表明,深度学习模型容易受到对抗性例子的攻击。如何保护深度学习系统免受隐私保护、公平保护和对抗攻击等方面的破坏是非常重要的。

本文结构

本文综述了深度学习理论基础研究的最新进展。我们承认有一些论文回顾了深度学习理论。Alom等人[9]对深度学习中使用的技术进行了调查。Sun[214]综述了深度学习中的优化理论。E等人[81]总结了深度学习中最优化的近似和ademacher复杂性、损失面以及收敛和隐式正则化相关的结果和挑战。我们的调查是最全面的。我们以独特的视角组织文献,并为未来的作品提供新的见解。

深度学习的极好的泛化性就像传统复杂学习理论的“云”:深度学习的过度参数化使得几乎所有现有的工具都变得空洞。现有的工作试图通过三个主要途径来解决这一问题: (1)开发大小无关的复杂性测度,它可以表征可学习的“有效”假设空间的复杂性,而不是整个假设空间。第二节讨论了相关工作; (2) 基于随机微分函数和相关损失函数的几何性质,利用深度学习中占主导地位的优化器随机梯度方法对所学假设进行建模。有关的工作在第3及4节检讨; (3) 过度参数化出人意料地为损失函数带来了许多良好的性质,进一步保证了优化和泛化性能。相关工作在第5节中给出。与此同时,第6节回顾了网络体系结构特殊结构的理论基础。

机器学习的另一个重要方面是对道德和安全问题的日益关注,包括隐私保护、对抗鲁棒性和公平保护。具体地说,隐私保护和对抗鲁棒性与可泛化性密切相关:泛化性好通常意味着隐私保护能力强;更稳健的算法可能会有。本文还讨论了在深度学习场景中,如何理解这些问题之间的相互作用。相关工作将在第7节讨论。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DLTR” 可以获取《陶大程院士等最新《深度学习理论进展》综述论文,41页pdf255篇文献阐述六大方面进展》专知下载链接索引