Yann LeCun:深度学习已死,可微分编程万岁!

-欢迎加入AI技术专家社群>>

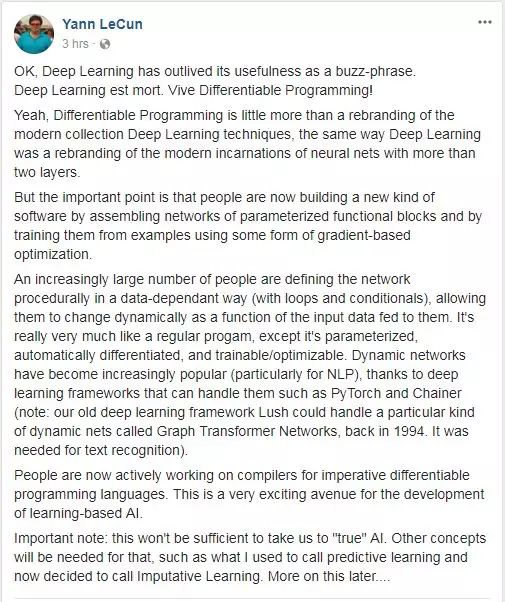

昨天,Yann LeCun在Facebook个人主页上写到:深度学习已死,可微分编程万岁! 这让不少人大吃一惊,莫非我们一直坚信的深度学习技术是假的“炒作概念”?

原文译文:

好,深度学习作为一个流行词,现在时效已过。深度学习已死,可微分编程万岁!

没错,“可微分编程”不过是把现代这套深度学习技术重新换了个叫法,这就跟“深度学习”是现代两层以上的神经网络变体的新名字一样。

但重要的一点是,人们现在正在将各种参数化函数模块的网络组装起来,构建一种新的软件,并且使用某种基于梯度的优化来训练这些软件。

越来越多的人正在以一种依赖于数据的方式(循环和条件)来程序化地定义网络,让它们随着输入数据的动态变化而变化。这与是普通的程序非常类似,除了前者是参数化的、可以自动可微分,并且可以训练和优化。动态网络变得越来越流行(尤其是对于NLP而言),这要归功于PyTorch和Chainer等深度学习框架(注意:早在1994年,以前的深度学习框架Lush,就能处理一种称为Graph Transformer Networks的特殊动态网络,用于文本识别)。

现在人们正在积极从事命令式可微分编程语言编译器的工作。这是开发基于学习的AI(learning-based AI)一条非常令人兴奋的途径。

原文截图:

对于LeCun的新想法,不少人都嫌弃这个新名字太长太难叫,甚至有人觉得LeCun越来越像美国现在的总统,一段时间不出来搞几个轰动的“概念”就觉怕别人不关注总结;不过也有人说“编程”的确比“学习”更为准确。

↓ 点击阅读原文,进入学院

登录查看更多

相关内容

杨立昆(法语:Yann Le Cun,英语:Yann LeCun,1960年7月8日-)(原中文译名:扬·勒丘恩)是一位计算机科学家,他在机器学习、计算机视觉、移动机器人和计算神经科学等领域都有很多贡献。他最著名的工作是在光学字符识别和计算机视觉上使用卷积神经网络 (CNN),他也被称为卷积网络之父。他同Léon Bottou和Patrick Haffner等人一起创建了DjVu图像压缩技术。他同Léon Bottou一起开发了Lush语言。

专知会员服务

87+阅读 · 2019年11月24日

Arxiv

4+阅读 · 2018年6月2日