斯坦福DAWNBench最新训练排名!华为云ModelArts用时10分28秒获全球最快

允中 发自 凹非寺

量子位 报道 | 公众号 QbitAI

还记得ModelArts吗?

这是今年华为最新发布的AI开发平台,可以提供包括数据标注准备、模型训练、模型调优、模型部署等AI应用开发服务。

其中,模型训练更是在发布之时就备受关注。

因为华为云称,ModelArts可以在模型训练阶段通过各类优化技术,尤其通过级联式混合并行技术,在同样的模型、数据集和同等硬件资源情况下,模型训练耗时都能大幅缩短。

但实际效果如何?现在有了国际权威成绩来参考。

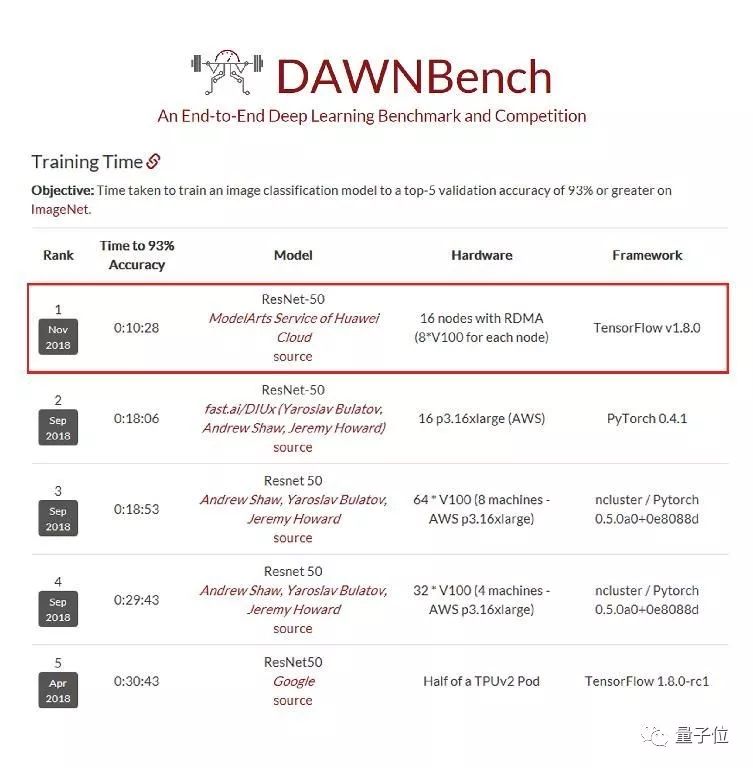

就在最新公布的DAWNBenchmark成绩排名中,在图像识别(ResNet50-on-ImageNet,93%以上精度)的总训练时间上,华为云ModelArts以10分28秒的成绩,比第二名提速近44%,拿下最新全球第一。

△DAWNBenchmark最新成绩

斯坦福DAWNBenchmark

DWANBench是斯坦福大学发起的国际权威基准测试平台,主要用来衡量端到端的深度学习模型训练和推理性能,相应的排行榜,也一直被视为全球业界深度学习平台技术的最新水准。

在深度学习模型构建中,计算时间和成本是最关键资源之一。

DAWNBench为此提供了一套通用的深度学习评价指标,用于评估不同优化策略、模型架构、软件框架、云和硬件上的训练时间、训练成本、推理延迟以及推理成本。

所以最新成绩公布后,华为云方面称,进一步证明了ModelArts可以实现更低成本、更快速度、更极致的AI开发体验。

此外,华为云方面也就此分享了成绩背后的模型打磨思路,介绍ModelArts用128块GPU,10分钟完成ImageNet训练的方法。

全文转载如下:

近年来,深度学习已经广泛应用于计算机视觉、语音识别、自然语言处理、视频分析等领域,可服务于视频监控、自动驾驶、搜索推荐、对话机器人等场景,具有广阔的商业价值。

为了达到更高的精度,通常深度学习所需数据量和模型都很大,训练非常耗时。

例如,在计算机视觉中,如果我们在ImageNet[1]数据集上用1块P100 GPU训练一个ResNet-50模型, 则需要耗时将近1周。

这严重阻碍了深度学习应用的开发进度。因此,深度学习训练加速一直是学术界和工业界所关注的重要问题,也是深度学习应主要用的痛点。

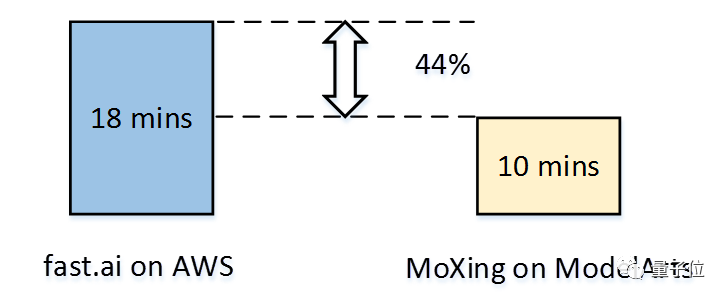

Jeremy Howard等几位教授领衔的fast.ai当前专注于深度学习加速,在ImageNet数据集上用128块V100 GPU训练 ResNet-50模型的最短时间为18分钟。

然而,最近BigGAN、NASNet、BERT等模型的出现,预示着训练更好精度的模型需要更强大的计算资源。

可以预见,在未来随着模型的增大、数据量的增加,深度学习训练加速将变得会更加重要。只有拥有端到端全栈的优化能力,才能使得深度学习的训练性能做到极致。

华为云ModelArts是一站式的AI开发平台,已经服务于华为公司内部各大产品线的AI模型开发,几年下来已经积累了跨场景、软硬协同、端云一体等多方位的优化经验。

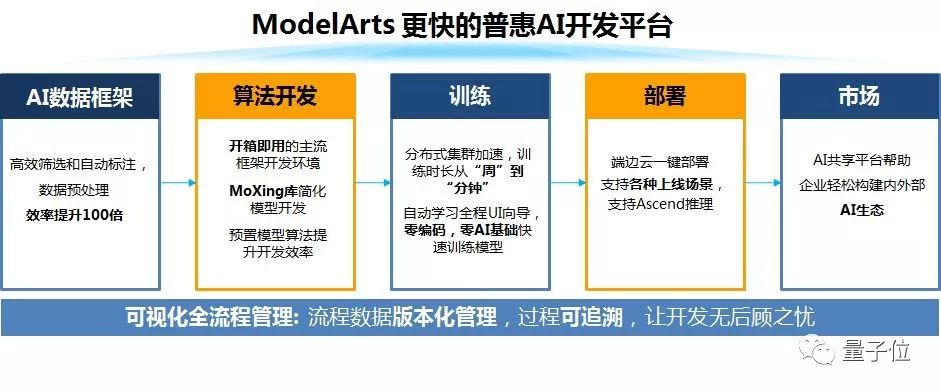

ModelArts提供了自动学习、数据管理、开发管理、训练管理、模型管理、推理服务管理、市场等多个模块化的服务,使得不同层级的用户都能够很快地开发出自己的AI模型。

△华为云ModelArts功能视图

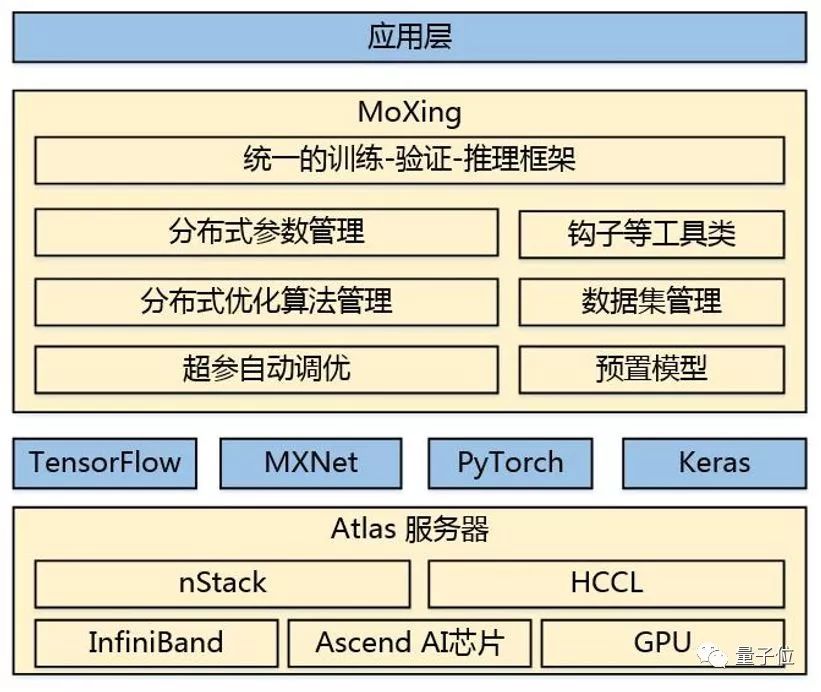

在模型训练部分,ModelArts通过硬件、软件和算法协同优化来实现训练加速。尤其在深度学习模型训练方面,华为将分布式加速层抽象出来,形成一套通用框架——MoXing(“模型”的拼音,意味着一切优化都围绕模型展开)。

采用与fast.ai一样的硬件、模型和训练数据,ModelArts可将训练时长可缩短到10分钟,创造了新的记录,为用户节省44%的时间。

△基于MoXing和ModelArts的训练速度提升

MoXing是华为云ModelArts团队自研的分布式训练加速框架,它构建于开源的深度学习引擎TensorFlow、MXNet、PyTorch、Keras之上,使得这些计算引擎分布式性能更高,同时易用性更好。

MoXing内置了多种模型参数切分和聚合策略、分布式SGD优化算法、级联式混合并行技术、超参数自动调优算法,并且在分布式训练数据切分策略、数据读取和预处理、分布式通信等多个方面做了优化,结合华为云Atlas高性能服务器,实现了硬件、软件和算法协同优化的分布式深度学习加速。

△华为云MoXing架构图

在易用性方面,上层开发者仅需关注业务模型,无需关注下层分布式相关的API,仅需根据实际业务定义输入数据、模型以及相应的优化器即可,训练脚本与运行环境(单机或者分布式)无关,上层业务代码和分布式训练引擎可以做到完全解耦。

两大指标看MoXing分布式加速关键技术

在衡量分布式深度学习的加速性能时,主要有如下2个重要指标:

吞吐量,即单位时间内处理的数据量;

收敛时间,即达到一定的收敛精度所需的时间。

吞吐量一般取决于服务器硬件(如更多、更大FLOPS处理能力的AI加速芯片,更大的通信带宽等)、数据读取和缓存、数据预处理、模型计算(如卷积算法选择等)、通信拓扑等方面的优化,除了低bit计算和梯度(或参数)压缩等,大部分技术在提升吞吐量的同时,不会造成对模型精度的影响。

为了达到最短的收敛时间,需要在优化吞吐量的同时,在调参方面也做调优。如果调参调的不好,那么吞吐量有时也很难优化上去,例如batch size这个超参不足够大时,模型训练的并行度就会较差,吞吐量难以通过增加计算节点个数而提升。

对用户而言,最终关心的指标是收敛时间,因此MoXing和ModelArts实现了全栈优化,极大缩短了训练收敛时间。

在数据读取和预处理方面,MoXing通过利用多级并发输入流水线使得数据IO不会成为瓶颈;

在模型计算方面,MoXing对上层模型提供半精度和单精度组成的混合精度计算,通过自适应的尺度缩放减小由于精度计算带来的损失;

在超参调优方面,采用动态超参策略(如momentum、batch size等)使得模型收敛所需epoch个数降到最低;

在底层优化方面,MoXing与底层华为自研服务器和通信计算库相结合,使得分布式加速进一步提升。

测试结果对比

一般在ImageNet数据集上训练ResNet-50模型,当Top-5精度≥93%或者Top-1 精度≥75%时即可认为模型收敛。

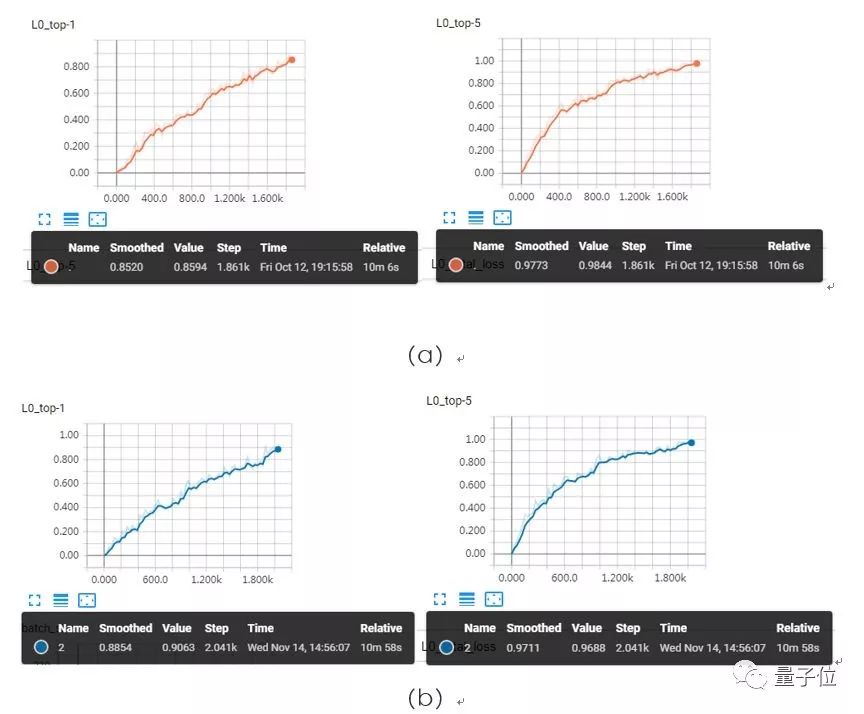

我们测试的模型训练收敛曲线如下图所示。此处Top-1和Top-5精度为训练集上的精度,为了达到极致的训练速度,训练过程中采用了额外进程对模型进行验证,最终验证精度如表1所示(包含与fast.ai的对比)。

图4(a)所对应的模型在验证集上Top-1 精度≥75%,训练耗时为10分06秒;图4(b)所对应的模型在验证集上Top-5 精度≥93%,训练耗时为10分58秒。

△ResNet50 on ImageNet训练收敛曲线

△MoXing与fast.ai的训练结果对比

未来:更快的普惠AI开发平台

华为云ModelArts致力于为用户提供更快的普惠AI开发体验,尤其在模型训练这方面,内置的MoXing框架使得深度学习模型训练速度有了很大的提升。

正如前所述,深度学习加速属于一个从底层硬件到上层计算引擎、再到更上层的分布式训练框架及其优化算法多方面协同优化的结果,具备全栈优化能力才能将用户训练成本降到最低。

后续,华为云ModelArts将进一步整合软硬一体化的优势,提供从芯片(Ascend)、服务器(Atlas Server)、计算通信库(CANN)到深度学习引擎(MindSpore)和分布式优化框架(MoXing)全栈优化的深度学习训练平台。

并且,ModelArts会逐步集成更多的数据标注工具,扩大应用范围,将继续服务于智慧城市、智能制造、自动驾驶及其它新兴业务场景,在公有云上为用户提供更普惠的AI服务。

[1] 文中所指的ImageNet数据集包含1000类个类别,共128万张图片,是最常用、最经典的图像分类数据集,是原始的ImageNet数据的一个子集。

传送门

DAWNBenchmark:

https://dawn.cs.stanford.edu/benchmark/

— 完 —

年度评选申请

加入社群

量子位AI社群开始招募啦,欢迎对AI感兴趣的同学,在量子位公众号(QbitAI)对话界面回复关键字“交流群”,获取入群方式;

此外,量子位专业细分群(自动驾驶、CV、NLP、机器学习等)正在招募,面向正在从事相关领域的工程师及研究人员。

进专业群请在量子位公众号(QbitAI)对话界面回复关键字“专业群”,获取入群方式。(专业群审核较严,敬请谅解)

诚挚招聘

量子位正在招募编辑/记者,工作地点在北京中关村。期待有才气、有热情的同学加入我们!相关细节,请在量子位公众号(QbitAI)对话界面,回复“招聘”两个字。

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态