独家 | EMNLP 2017 录用论文作者解读:深度残差网络下的弱监督关系抽取

AI 科技评论按:在今年的 EMNLP 2017 上,台湾大学黄意尧与加州圣塔芭芭拉大学 (UCSB)William Wang 教授有一篇合作论文被录用。受AI 科技评论邀请,黄意尧撰写了关于这篇论文的研究历程,以供学习与参考。AI 科技评论做了不改动原意的编辑与修改,将繁体字转换为简体,并将一些台湾常用表述转换为大陆的通用说法。

论文名称:Deep Residual Learning for Weakly-Supervised Relation Extraction

论文地址:https://arxiv.org/abs/1707.08866

近年来,越来越多人关注在关系抽取 (Relation Extraction) 的题目上,大部分的研究集中在使用更复杂、更结构化的神经网络,并测量在 SemEval 2010 的关系抽取数据库上。

但在这个数据库上,最大的问题是数据太少,总共只有 10,717 条数据,导致大部分的模型参数不能太多,要不然会有过度拟合 (over fitting) 的现象发生。

相较於另一个数据库,NYT dataset,总共有 695,059 条数据,採用半监督式学习:distant supervision 来收集数据。这个数据库有足够大的数量来进行大型神经网络的实验。

出於这个动机,本文进行大型神经网络在 NYT dataset 数据库的实验,并提出深度残差网络来解决 distant supervision 带来的噪声干扰。

问题探讨

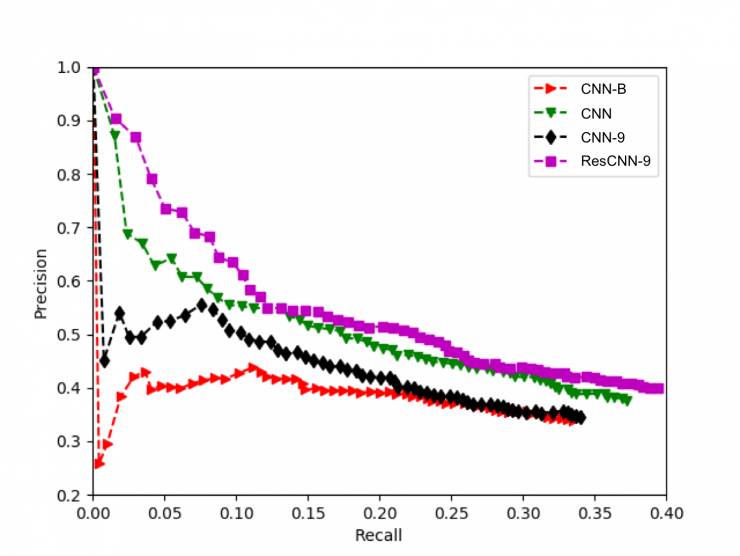

我们使用卷积神经网络来进行关系抽取,取经於计算机视觉与深度卷积神经网络的成功,我们透过增加层数,来增加神经网络的参数,希望可以帮助关系抽取的学习。结果如图一:

图一、各式卷积网络的结果

但我们却发现,使用 9 层卷积神经网络 (CNN-9) 的效果,并没有单层 (CNN) 的好。这个结果跟过往的经验违背。我们猜测原因是,在 distant supervision 的数据裡面,有太多错误标签的数据,这些数据带来太多的噪声,而这些噪声随著越深层的神经网络而被放大,导致 9 层卷积神经网络 (CNN-9) 的结果比单层 (CNN) 更差。为了解决这个问题,我们使用残差网络,来帮助网络的特征学习。

残差网络在半监督式学习的应用

基于上面的实验,我们知道浅层网络在 distant supervision 的数据库中,能学习到比较好的特征。于是,我们设法让浅层网络的特征,可以跳跃传递至深层网络。

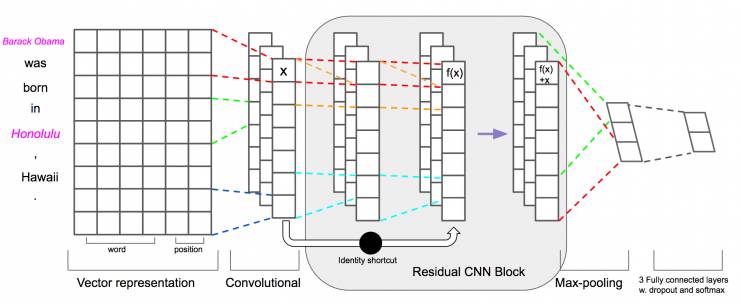

图二,残差网络在关系抽取的架构

如图二所示,我们使用拥有两层卷积网络的残差区块,将浅层网络的特征传到较深层的网络。特过这样的设计,我们可以依照数据库的大小,来堆迭网络架构,让网络可以选择较不被噪声影响的那层网络特征来进行关系分类。

结果

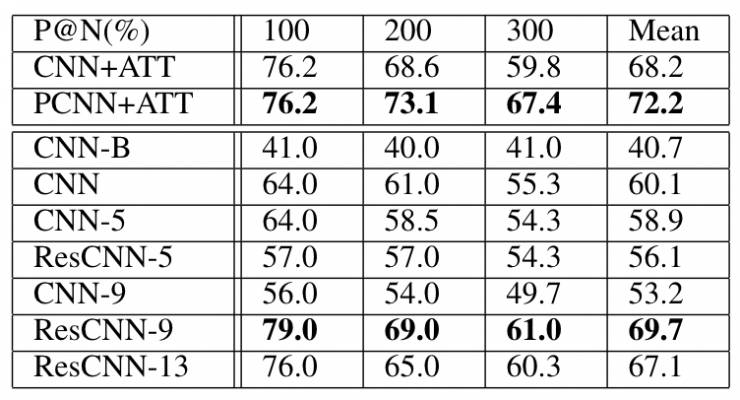

这篇文章,提出一种,解决 distant supervision 噪声对大型网络影响的方法。在表一,我们可以看到,9 层的残差网络,与 state-of-the-art(PCNN+ATT) 的模型,有差不多的结果,并在高顺位候选的关系上,有更棒的效能。证明,利用残差网络,可以在 distant supervision 的数据库中,抽取更有用的特征。

表一,残差网络与其它网络结构的结果比较

结论

本篇文章提供读者、研究人员可以在 distant supervision 的数据库使用大型深度神经网络。但要注意,此种半监督式学习的噪声,会影响到实验结果。利用残差网络可以解决这样的问题,这篇文章在关系抽取的研究上,证明其结果。

文章趣事

本篇文章是我在加州圣塔芭芭拉大学 (UCSB),做交换学生时完成的作品。其实圣塔芭芭拉是一个充满阳光,很美的海滩,每天都可以冲浪、晒太阳、玩水,加上当时课选很少的情况下,觉得生活过得太安逸,决定加入当时新晋教授 William Wang 的实验室,学习相关领域的知识。但没想到,我是实验室前 5 个进来的学生,导致所有知识都要靠自己来,自己吸收与学习。幸运的是,教授有许多时间,跟我讨论题目,但另一方面,我也好像在过一个博士班学生单独奋斗的生活,每天死盯著论文,想理解关系抽取到底发生了什么事。很幸运地,最后我把文章完成,并且顺利的投上 EMNLP。很感谢 William Wang 教授愿意给我机会,与我进行大量的讨论。William Wang 教授在知识图谱的相关研究很厉害,有兴趣的同学,可以申请到他的实验室进行研究。

原文:https://arxiv.org/abs/1707.08866

项目:https://github.com/darrenyaoyao/ResCNN_RelationExtraction

William Wang 教授主页:https://www.cs.ucsb.edu/~william

————— 给爱学习的你的福利 —————

3个月,从无人问津到年薪30万的秘密究竟是什么?答案在这里——崔立明授课【推荐系统算法工程师-从入门到就业】3个月算法水平得到快速提升,让你的职业生涯更有竞争力!长按识别下方二维码(或阅读原文戳开链接)抵达课程详细介绍~

————————————————————