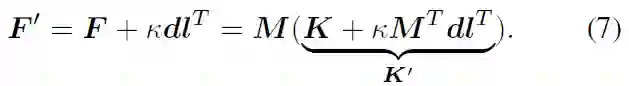

1 分钟的舞蹈动画,美术手工制作或需 20 多天,用 AIxPose 辅助制作仅需 3 天,整个流程缩短了 80% 以上。

不用动画师手 K、惯捕或光捕,只需提供一段视频,这个 AI 动捕软件就能自动输出动作。仅需短短几分钟,虚拟人的动画制作就搞定了。

![]()

除了单视角视频,还能支持多个视角的视频,相比其他只支持单目识别的动捕软件,该软件能提供更高的动捕质量。

![]()

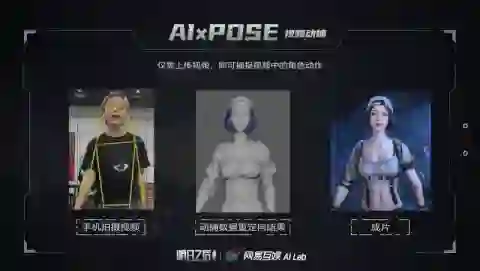

同时,该软件还支持对识别的人体关键点、平滑度、脚步细节等进行编辑修改。从普通玩家的兴趣体验,到硬核玩家的专业需求,它都可满足。

![]()

这就是网易互娱 AI Lab 深根多年、结合专业美术反馈不断迭代优化、低调开发的 AIxPose 视频动捕软件。据悉,该软件已经处理了超过数十个小时的视频资源,并应用于游戏剧情动画、热门舞蹈动画等资源的制作流程。经实际项目验证,1 分钟的舞蹈动画,美术手工制作或需 20 多天,用 AIxPose 辅助制作仅需 3 天,整个流程缩短了 80% 以上。

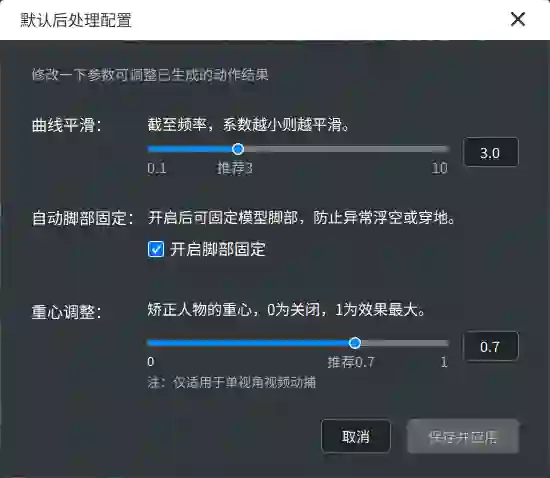

近日,网易互娱 AI Lab 基于开发该软件的经验,并结合在动捕领域的相关研究工作进行了整理,其所撰写的论文《Learning Analytical Posterior Probability for Human Mesh Recovery》被计算机视觉顶会 CVPR 2023 接收。

![]()

-

主页地址:https://netease-gameai.github.io/ProPose/

-

论文地址:https://netease-gameai.github.io/ProPose/static/assets/CVPR2023_ProPose.pdf

该论文创新性地提出了一种基于后验概率的视频动捕技术 ProPose,能够在单张图像、多传感器融合等不同设定下实现准确的三维人体姿态估计。技术精度比使用先验的基准概率方法高了 19%,且在公开数据集 3DPW、Human3.6M 和 AGORA 上均超越了过去的方法。此外,对于多传感器融合任务,该技术也能达到比基准模型更高的精度,且无需因为引入新传感器而修改神经网络的骨干部分。

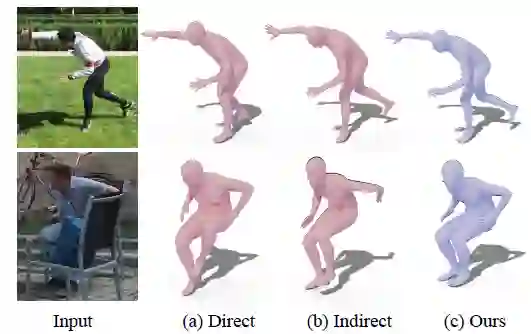

本研究的任务是从 RGB 图像中预测人体姿态和外形(human mesh recovery, hmr),现有的方法可以归纳为两类:直接法和间接法。直接法采用神经网络端到端地回归人体关节的旋转表示(如轴角、旋转矩阵、6D 向量等),而间接法先预测一些中间表示(如三维关键点、分割等),然后通过这些中间表示得到关节旋转。

然而,这两类方法都存在着一些问题。对于直接法而言,由于这类方法需要网络直接学习旋转这类抽象表示,与学习关键点、分割相比,学习旋转相对困难,因此网络输出的结果有时候很难和图像对齐,且无法完成一些大幅度的动作,如下图 (a) 第一行的右脚无法完全向后伸展。与之相比,间接法一般能产生更高的精度,但是这类方法的表现很大程度上依赖于中间表示的准确性,当中间表示由于噪声产生误差时,容易让最终的旋转出现相当明显的错误,如下图 (b) 第二行的左手所示。

![]()

除了前述这些确定性的方法,还有一些方法通过学习某些概率分布来建模人体姿态的不确定性,从而将噪声纳入考虑,提高系统鲁棒性。目前主要的概率建模方式包括多元高斯分布、标准化流、神经网络隐式建模等,但是这些非 SO (3) 上的概率分布无法真实地反映关节旋转的不确定性。比如在不确定性较大时,高斯分布在 SO (3) 上的局部线性假设不成立。近期的一篇工作直接用网络学习了 matrix Fisher 分布的参数,虽然这是一种 SO (3) 上的分布,但该方法的学习方式和直接法类似,收敛表现无法和现有的间接法相比。

为了同时兼顾高准确性和鲁棒性,提升概率方法的性能,ProPose 推导了关节旋转的解析后验概率,不仅能够受益于不同观测变量带来的高精度,也能衡量不确定性,尽可能减弱噪声对算法的影响。如下图所示,对于输入的图片,ProPose 可以通过输出的概率分布一定程度上度量该关节旋转在各个方向的不确定性,如右手沿着手臂轴的旋转、左手臂上下摆动的朝向、左小腿远近的程度等。

![]()

本研究对人体姿态进行概率建模,目标是求关节旋转 R 在一些观测变量条件下(如骨骼朝向 d 等)的后验概率 p (R|d,⋯)。

具体而言,由于人体的关节旋转位于 SO (3) 上,而子关节相对于父关节的单位骨骼朝向位于 S^2 上,因此可基于这两种流形上的概率分布进行分析。

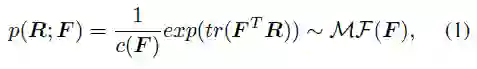

首先,SO (3) 上的 matrix Fisher 分布 MF (⋅) 可作为关节旋转 R 的先验分布,如下式所示,F∈R^(3×3) 是该分布的参数,c (F) 是一个归一化常量,tr 表示矩阵的迹。

![]()

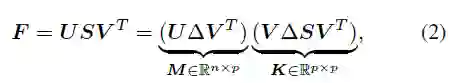

如下式所示,F 可以通过 SVD 分解直接求解均值 M 和一个表征分布聚集程度的聚集项 K。其中,Δ=diag (1,1,|UV|) 是一个对角正交矩阵,用于保证 M 的行列式为 1,从而能落在特殊正交群中。

![]()

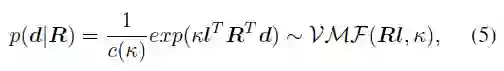

其次,考虑到骨骼的朝向能通过关节旋转计算得到,因此可将关节旋转 R 看作隐变量,骨骼朝向 d 作为观测变量,给定 R 的条件下,S^2 上的单位朝向 d 服从 von Mises-Fisher 分布:

![]()

其中,κ∈R 和 d∈S^2 分别是该分布的聚集项和均值,l 是参考姿态下(如 T-pose)的单位骨骼朝向,理论上满足 Rl=d,即通过关节旋转将参考骨骼朝向转到当前骨骼朝向。

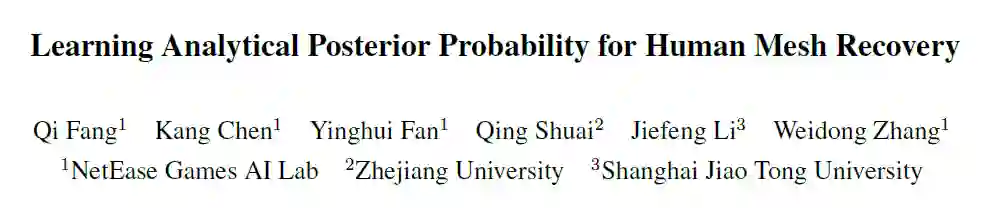

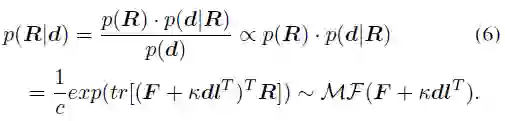

利用贝叶斯理论,给定先验分布 p (R) 和似然函数 p (d|R),可以计算以骨骼朝向为条件的关节旋转的后验概率 p (R|d) 的解析形式:

![]()

由此可得到结论:后验概率 p (R|d) 同样服从 matrix Fisher 分布,且其参数从 F 更新为 F^'=F+κdl^T。

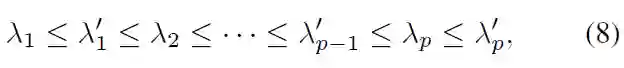

上述后验概率只考虑了人体骨骼朝向作为观测量,类似地,还可以推广到其它的方向观测量 d_i 或旋转观测量 D_j(可由别的传感器产生,如 IMUs 等),得到如下一般形式的解析后验概率:

![]()

其中 κ_i 和 K_j 是聚集项。g (⋅) 是一个 IK 形式的映射,能够将方向观测量转换到旋转估计,可以采用最简单的形式如 g (d_i )=dl^T。Z_1 和 Z_3 分别表示方向观测量和旋转观测量的集合。

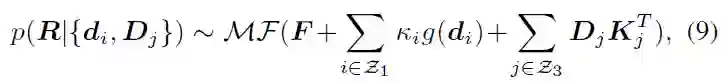

该部分进一步阐述后验概率分布相较于先验概率分布有更高的聚集程度。

前述部分介绍了人体关节旋转后验概率的解析形式,该概率由一个新的参数 F' 表征。可以从另一个角度理解后验参数 F^',即 F^' 是与 F 相同的均值项 M 和一个新的聚集项 K^' 的乘积:

其中 M^T dl^T=ll^T 是一个秩 1 实对称矩阵,而 K 也是一个实对称矩阵,即后验的聚集项 K' 同样是实对称矩阵。根据矩阵分析中关于实对称矩阵的交错定理,可以得到 K' 的特征值 λ_i' 和 K 的特征值 λ_i 具有如下不等式关系:

![]()

考虑到聚集项的特征值等价于分布参数的奇异值,而分布参数的奇异值能反映该分布的置信度,因此可以得到结论,当似然项非零时,后验估计比先验估计更集中,可以快速收敛到似然函数偏好的那个 mode 上,从而能更容易地被学习。

除了先验概率方法,另一类主要的基准方法是利用逆运动学(IK)直接通过骨骼朝向计算旋转,下面这张图可以直观地展示后验概率方法和确定性 IK 方法之间的对比。

![]()

上图以人体肘部关节为例。实的三维坐标轴表示真实值,透明三维坐标轴表示估计值。第一行表示确定性 IK 方法,这类方法背后的建模方式是一个表示骨骼朝向的向量,当骨骼朝向估计准确时,剩余的一个自由度(twist)便能缩小到一个圆上(图中球上的虚线圈);当骨骼朝向估计不准确时,则会使得所有可能的估计都与真实值偏离。第二行表示本研究的后验概率模型,由多个不同类型的模型融合而成,球面上的红色区域表示某个旋转的概率,即便骨骼朝向估计有误差,这种方式也有可能恢复到真实值,因为骨骼朝向的噪声能够被先验或其它观测量所尽可能缓解。

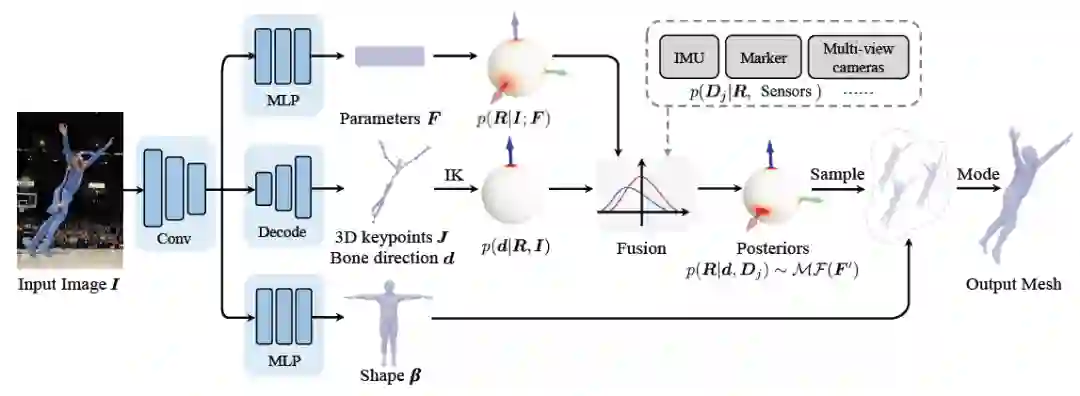

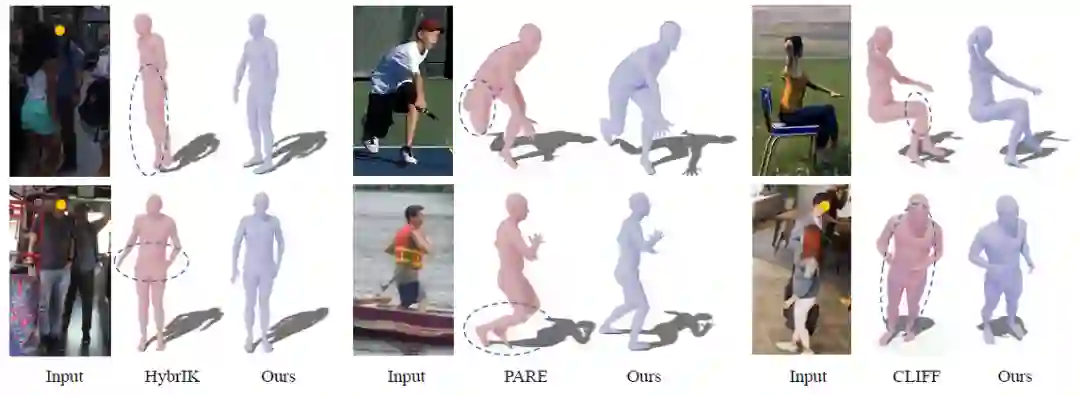

基于前述理论和推导,可以直接构建出下图所示的框架图。利用多分支网络从单张图片中估计先验分布参数 F、三维关键点 J(从中计算出骨骼朝向 d)、外形参数 β。通过贝叶斯法则计算得到后验概率,最终可从后验分布中得到姿态估计,从而输出人体 mesh。

![]()

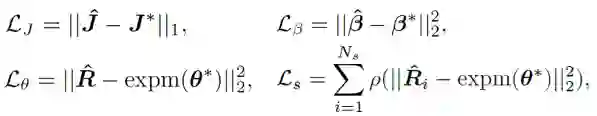

损失函数的选择比较直接,为如下四个约束的加权和,其中 L_J 表示关键点约束,L_β 表示外形参数约束,L_θ 表示矩阵形式的姿态参数约束,L_s 表示对分布进行采样后的姿态约束。关于对分布的约束,这里并未直接采用 MAP 是考虑了归一化参数的数值稳定性问题。关于采样策略,类似之前的工作,将 matrix Fisher 分布转为等价的四元数形式的 Bingham 分布,然后通过拒绝采样得到,其中拒绝采样的建议分布采用 angular central Gaussian 分布。

![]()

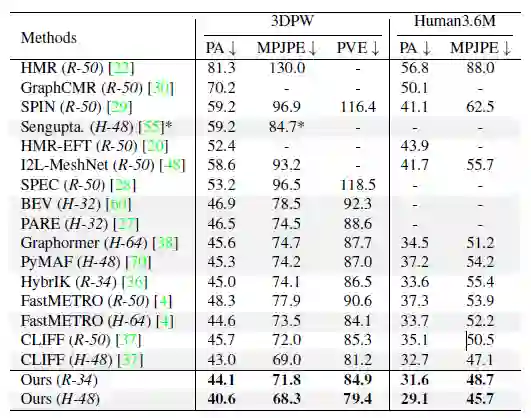

实验部分,本研究在公开数据集 Human3.6M、3DPW、AGORA、TotalCapture 上和过去方法进行了定量对比。可以看到,本研究的方法超越了过去的一众方法。其中右下表中最后灰色的两行是同期工作,这里为了榜单完整性也列了出来。

![]()

![]()

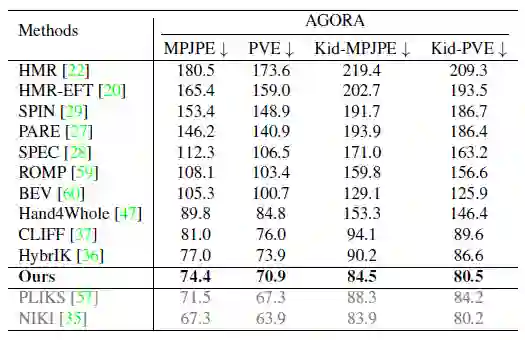

下图展示了和现有 SOTA 方法 HybrIK、PARE、CLIFF 的定性对比,可以看到对一些遮挡的情况,ProPose 可以得到更好的效果。

![]()

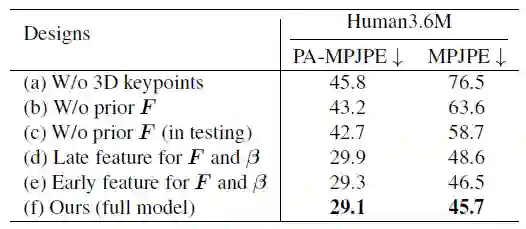

下表展示了一系列消融实验,主要展示 ProPose 的准确性和鲁棒性。基准方法包括不使用三维关键点、不使用先验、测试时不使用先验、骨干网络不同位置特征的选择等,下面左表充分验证了所提出的后验概率分布有着更高的精度。下面右表则展示了后验方法和确定性 IK 方法对噪声的鲁棒性比较,可以看到后验方法能够更大程度地抵御噪声的干扰。

![]()

![]()

除了上述 hmr 任务,本研究还在多传感器融合的任务上进行了评估,下面给出了一个单视角和 IMUs 融合的效果。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com