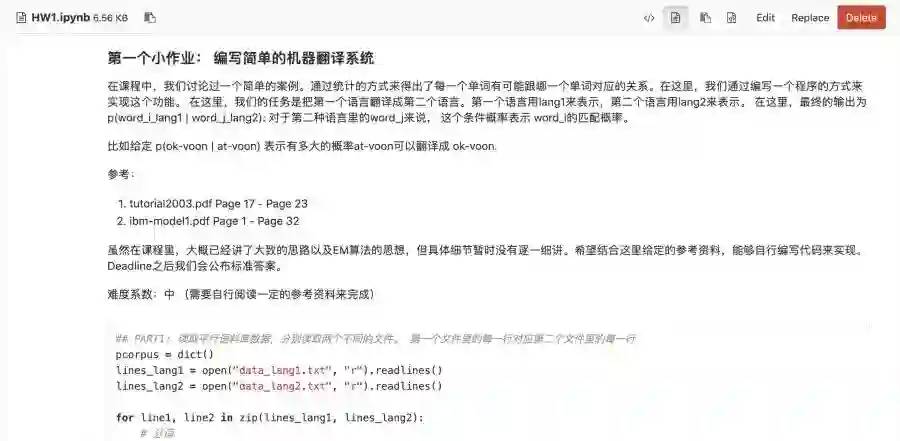

谷歌Lab近日发布了一个新的预训练模型"ALBERT"全面在SQuAD 2.0、GLUE、RACE等任务上超越了BERT、XLNet、RoBERTa再次刷新了排行榜!ALBERT是一种轻量版本的BERT,利用更好的参数来训练模型,但是效果却反而得到了很大提升!ALBERT的核心思想是采用了两种减少模型参数的方法,比BERT占用的内存空间小很多,同时极大提升了训练速度,更重要的是效果上也有很大的提升!

![]()

▲BERT 和 ALBERT 两者的参数量比较。

这次发布的模型由Google Lab的 Lan Zhenzhong博士来主导完成,而且Lan Zhenzhong博士正好也是贪心学院的顾问以及教研团队的成员。近期我们也会邀请Zhenzhong博士给大家做一次分享。

为了迎接NLP领域的各种变化,贪心学院的《自然语言处理》课程也在不断迭代更新,保证不错过任何2周之内出现的重要技术。自然语言处理无非是目前最大的风口,从Word2Vec、ElMo、GPT、Bert到XLNet, 我们见证了这个领域的高速发展以及未来的前景。互联网中的大量的文本以及IOT时代赋予我们的全新交互带来了这个领域的爆发。

那这样的训练营到底是怎么样的呢? 下面来详细介绍一下《自然语言处理高阶训练营》的内容,也可以添加我们专业的AI职业规划师来咨询,我们的咨询师也是顶级AI公司出来的哦~

. Master's Theorem,递归复杂度分析

. 动态规划以及Dynamic Time Warpping

. Projected Gradient Descent

. L0, L1, L2, L-Infinity Norm

. Grid Search, Bayesian Optimization

. Kernel Tick, Mercer's Theorem

. Kernelized Linear Regression、Kernelized KNN

. Linear/Quadratic Programming

. Integer/Semi-definite Programming

. NP-completeness/NP-hard/P/NP

. Constrained Relaxation、Approximate Algorithm

. Convergence Analysis of Iterative Algorithm

. 基于Sparse Quadratic Programming的股票投资组合优化策略编写

. 基于Earth Mover's Distance的短文本相似度计算

. 基于Projected Gradient Descent和非负矩阵分解的词向量学习

. 基于Linear Programming的机票定价系统

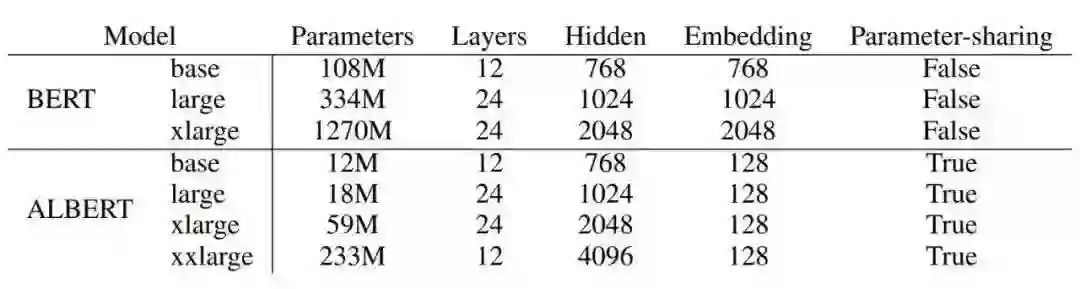

![]()

. 文本预处理技术(tf-idf,Stemming等)

. 常见的Smoothing Techniques

. Variational Autoencoder与Text Disentangling

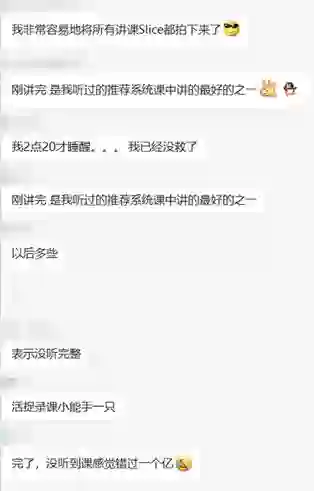

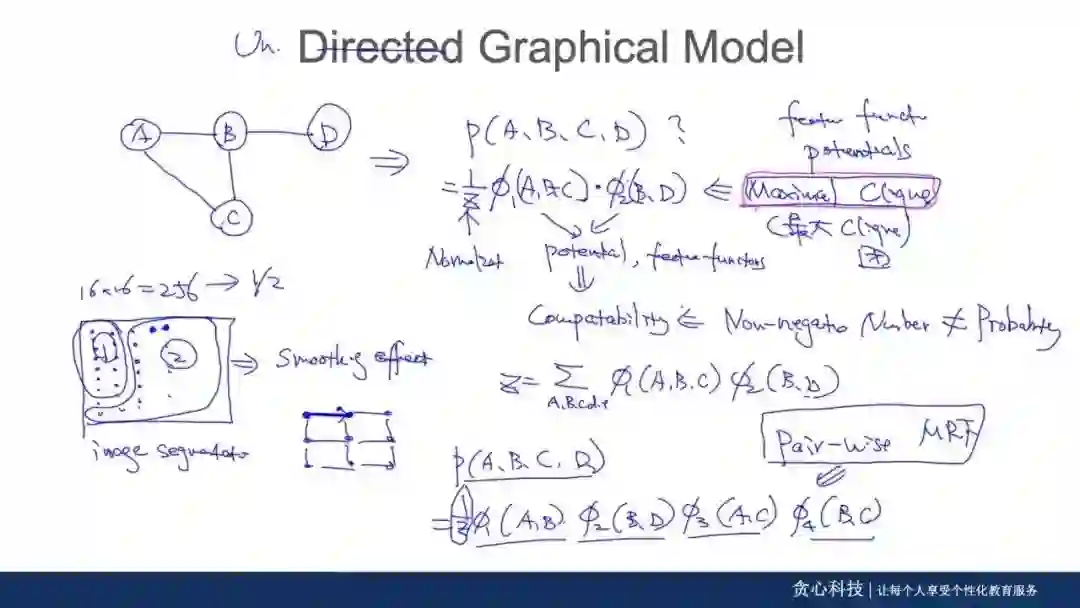

. Conditional Indepence、D-separation、Markov Blanket

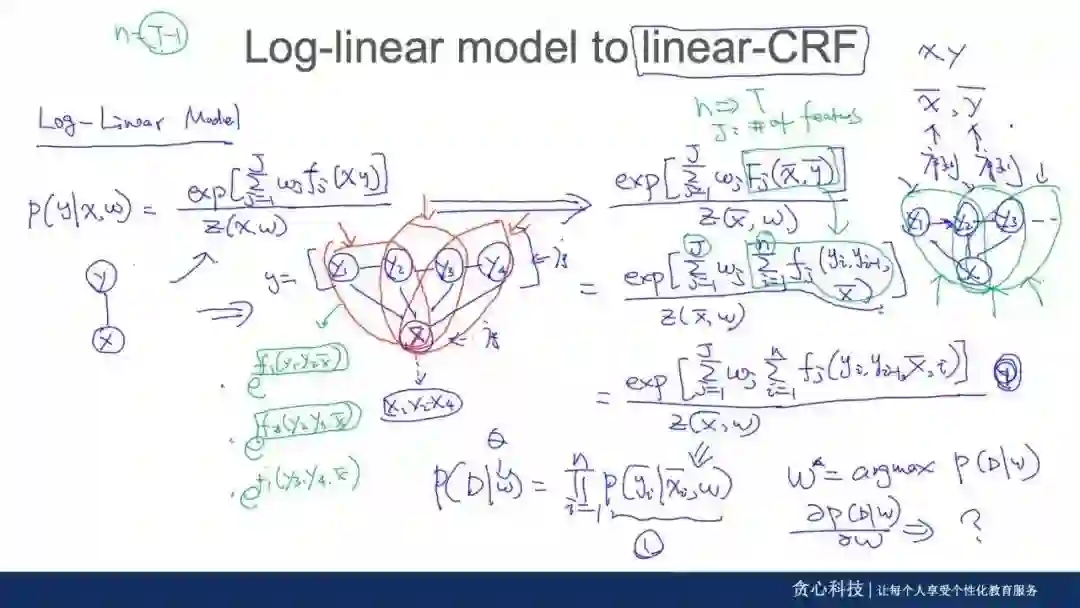

. CRF的Viterbi Decoding与参数估计

. 基于监督学习的Aspect-Based 情感分析系统搭建

. 基于CRF、LSTM-CRF、BERT-CRF 的命名实体识别应用

. 基于语言模型和Noisy Channel Model的拼写纠错

![]()

. Snowball, KnowitAll, RunnerText

. Distant Supervision, 无监督学习方法

. 词向量、Skip-Gram、Negative Sampling

. Contexualized Embedding与ELMo

. KL Divergence与Gaussian Embedding

. 非欧式空间与Pointcare Embedding

. Adversial Learning与KBGAN

. 包含Intent与Entity Extraction的NLU模块实现

. 基于SkipGram的推荐系统实现(参考Airbnb论文)

![]()

. Pytorch与Tensorflow详解. 表示学习,分布式表示技术

. RNN与Vanishing/Exploding Gradient

. Greedy Decoding与Beam Search

. Self Attention,Transformer以及Transformer-XL.

. Laywer-wise Relevance Propagation

. 基于Seq2Seq+注意力机制、基于Transformer的机器翻译系统

. 基于BI-LSTM-CRF和BERT-BiLSTM-CRF在命名实体中的比较

. 利用Laywer-wise RP可视化端到端的机器翻译系统

![]()

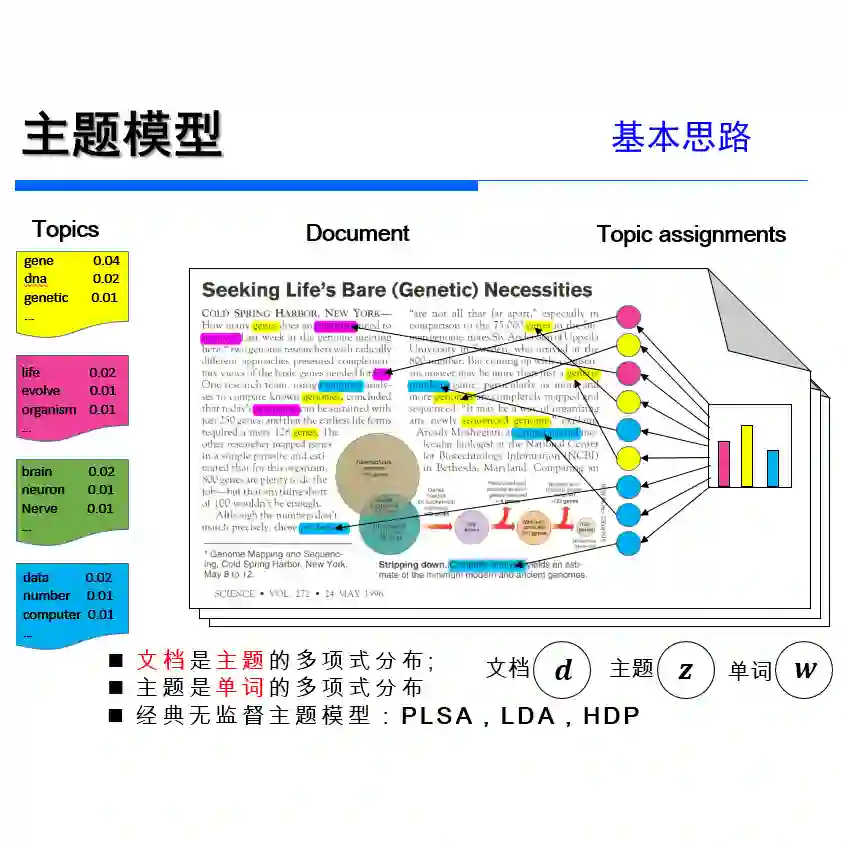

. Dirichlet分布、Multinomial分布

. Beta分布、Conjugate Prior回顾

. 主题模型与Collapsed Gibbs Sampling

. Metropolis Hasting, Rejection Sampling

. Variantional Inference, Stochastic VI

. Chinese Restarant Process

. Bayesian Deep Neural Network

. VAE与Reparametrization trick

. 利用Collapsed Gibbs Sampler和SGLD对主题模型做Inference

![]()

开放式项目又称为课程的capstone项目。

作为课程中的很重要的一部分,可以选择work on一个具有挑战性的项目。

通过此项目,可以深入去理解某一个特定领域,快速成为这个领域内的专家,并且让项目成果成为简历中的一个亮点。

Step 3: Short Survey Paper

Step 7: Technical Report/博客

完整PPT、代码和Conference-Style Technical Report 最为项目的最后阶段,我们将组织学员的presentation分享大会。

借此我们会邀请一些同行业的专家、从业者、企业招聘方、优质猎头资源等共同参与分享大会。

对课程有意向的同学

添加课程顾问小姐姐微信

报名、课程咨询

👇👇👇

![]()

课程设计

紧密围绕学术界最新进展以及工业界的需求,

涵盖了所有核心知识点,并且结合了

大量实战项目,

培养学员的动手能力,解决问题能力。

![]()

问答系统

从零开始搭建一个完整的问答系统。

给定一个语料库(问题和答案对),对于用户的输入需要返回最适合的答案。

涉及到的模块:

1. 对于用户的输入需要做拼写纠错,这部分会用到语言模型

3. 把文本转换成向量形式,这里需要用到tf-idf, word2vec等相关的技术。

![]()

情感分析系统

基于给定数据,来搭建一个完整的情感分析系统。

项目涉及到的模块:

3. 监督学习模型的选择与调参。

调参的过程需要尝试不同的优化策略。

![]()

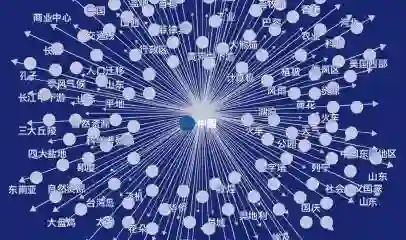

知识图谱系统

利用非结构化数据来搭建知识图谱。项目涉及到的模块:

![]()

对话系统中的NLU

基于给定的对话数据来构建NLU识别部分,并结果用于聊天机器人中。

项目涉及到的模块:

![]()

机器翻译系统

基于给定数据,来搭建一个完整的情感分析系统。

项目涉及到的模块:

3. 监督学习模型的选择与调参。

调参的过程需要尝试不同的优化策略。

![]()

任务导向型聊天机器人

搭建一个完整的聊天机器人,用来服务搜索餐厅。项目涉及到的模块:

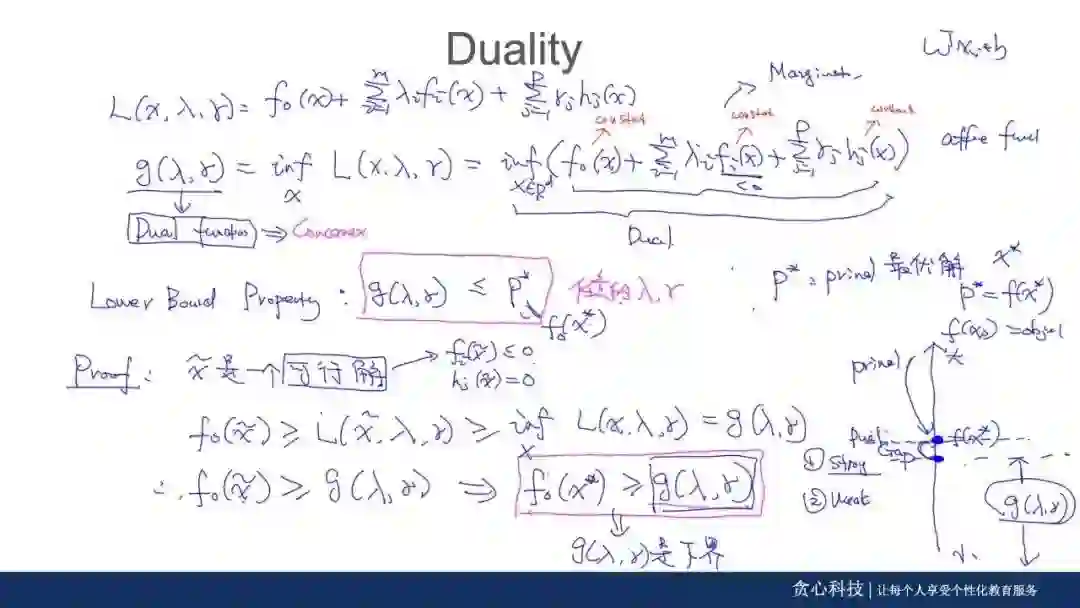

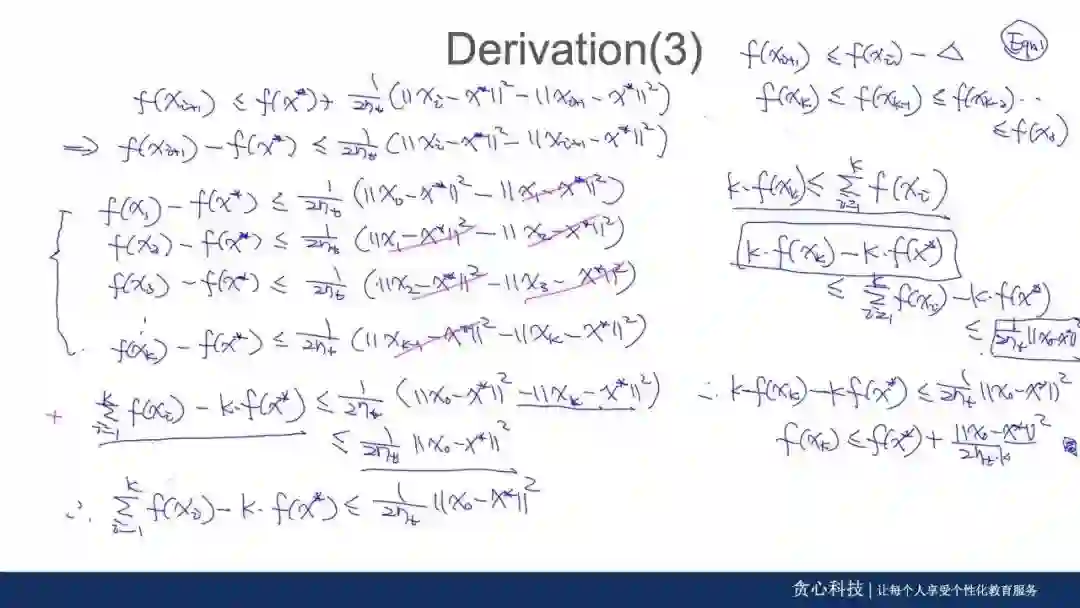

区别于劣质的PPT讲解,导师全程现场推导,

让你在学习中有清晰的思路,深刻的理解算法模型背后推导的每个细节。更重要的是可以清晰地看到各种模型之间的关系!帮助你打通六脉!

▲源自:Convex Optimization 讲解

▲源自:Convergence Analysis 讲解

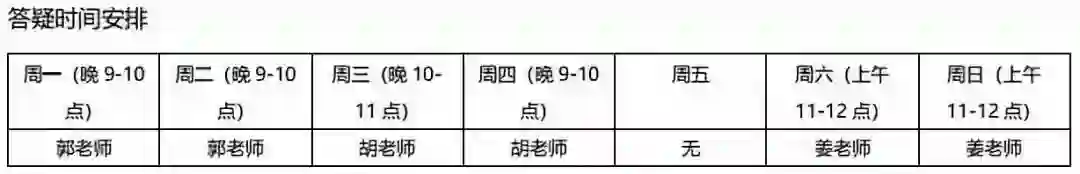

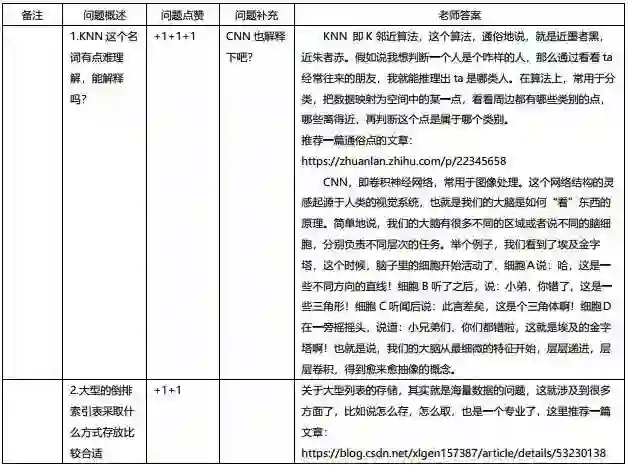

不管你在学习过程中遇到多少阻碍,你都可以通过以下4种方式解决:

4、共同的问题在Review Session里面做讲解

注:每次答疑,班主任都会进行记录,以便学员实时查阅。

对机器学习算法有基础了解,具备编程能力;

对数据结构与算法比较熟悉;

想申请国外名校AI相关专业的硕士/博士;

已从事NLP领域工作,想要升职加薪;

想加入顶级AI公司;

采用直播的授课方式,一周4-5次的直播教学, 包括2次的main lectures, 1-2次的discussion session (讲解某一个实战、必备基础、案例或者技术上的延伸), 1次的paper reading session (每周会assign一篇必备论文,并且直播解读)。教学模式上也参考了美国顶级院校的教学体系。以下为其中一周的课程安排,供参考。

每周一次的Review Session, 老师提前一周给出几个备选主题,由学生进行投票选择最心仪的主题,每周三次。

通过在知乎上发表相关技术文章进行自我成果检验,同时也是一种思想碰撞的方式,导师会对发表的每一篇文章写一个详细的评语。万一不小心成为一个大V了呢?虽然写文章的过程万分痛苦,学习群里半夜哀嚎遍野,但看一看抓着头发写出来的文章结果还是非常喜人的!看着自己收获的点赞数,大家都默默地感谢起导师们的无情!

![]() 个个都立刻变身成了知乎大牛~

个个都立刻变身成了知乎大牛~

除了文章,算法工程师的立命根本--项目代码,

导师更是不会放过的。每次在Gitlab上布置的作业,导师们都会带领助教团队会予以详细的批改和反馈。并逼着你不断的优化!

看了这么多,是不是非常崇拜设计出如此地狱式学习计划的大牛,那就来正式认识一下这位训练营中人人听了都闻风丧胆,但又让人崇拜+喜爱+欲罢不能的训练营大魔头:

NLP、知识图谱领域专家

美国南加州大学博士,曾任凡普金科(爱钱进)首席科学家,美国亚马逊/高盛高级工程师,AI量化投资公司首席科学家兼投资总监。

在AAAI, KDD, AISTATS等顶会上发表过15篇以上论文,其中3篇获得Best Paper Award,累计数百次引用。

在被大魔头们折磨了多个日日夜夜后,大家不但没有放弃学习,而且很快乐地学习着。来听听大家的心声吧:

这两天群里更是捷报连连。

我们前三期项目的已经有多名学员被一线AI企业录取,还有通过二面、三面等待着offer。

相信未来几周我们将会受到更多的好消息!

随便截了几个学员反馈,看看他们有多爱这个机智又严苛的大魔头:

我确定了我们的魔鬼训练营没有误人子弟,我们的课程真的帮助到大家实质的技能提升或帮助大家拿到offer。

这次我们迎来了第六期NLP的招生,千万不要觉得这是一个对标其他线上课程的普通的训练营。由于内容的专业性以及深度,在过去吸引了大量的全球顶级名府的学员,

这里不乏来自斯坦福、UCSD、USC、哥大、HKUST、爱丁堡等世界名府的学生;

在这里,你不仅可以享受到通往顶尖人才的快乐、也可以结识志同道合的AI从业者以及未来的科学家。

3、品质保障!正式

开课后7天内,无条件全额退款。

对课程有意向的同学

添加课程顾问小姐姐微信

报名、课程咨询

👇👇👇

![]()

个个都立刻变身成了知乎大牛~

个个都立刻变身成了知乎大牛~