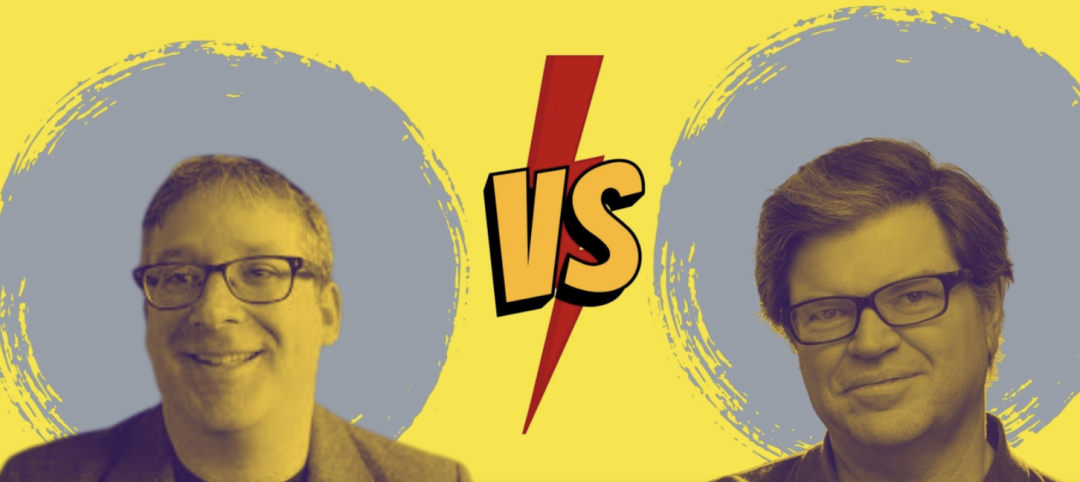

马库斯发文炮轰LeCun:只靠深度学习无法实现类人智能

新智元报道

新智元报道

【新智元导读】继提出「深度学习撞墙」后,马库斯再发长文称,仅靠深度学习并不能实现类人智能。

神经网络和符号操作的混合模型

Andrew Ng在3月表示支持此类系统。 Sepp Hochreiter——LSTMs 的共同创造者,领先的学习序列深度学习架构之一,也做了同样的事情,他在四月公开表示,最有希望的广泛人工智能方法是神经符号人工智能。

1、对我的立场的错误描述 2、努力缩小混合模型的范围 3、符号操作可能是通过学习而不是与生俱来的原因。

符号操作先天性

人们应该怀疑深度学习是否已经达到了极限。鉴于最近在 DALL-E 2 、 Gato 和PaLM中看到的任务持续增量改进,不要将一时困难误认为是「墙」似乎是明智的。深度学习不可避免的失败之前已经被预言过,但押注它是不值得的。

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年11月22日

Arxiv

22+阅读 · 2021年12月22日