教你在经典计算机上搭建一个量子神经网络,已开源

作者 | Sashwat Anagolum

编译 | 张大倩、陈彩娴

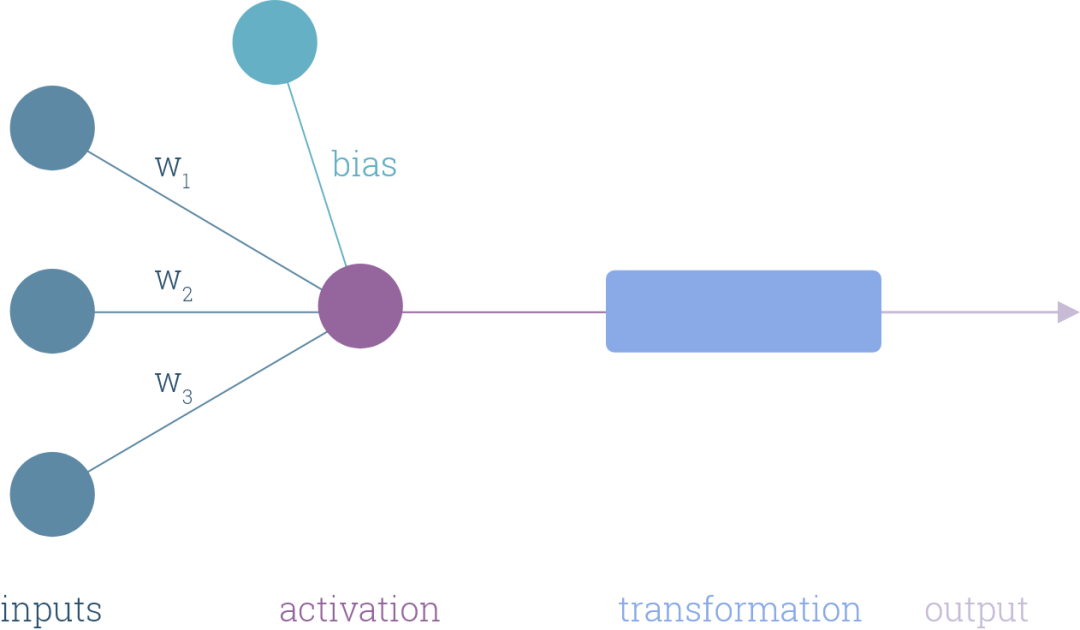

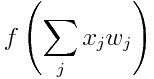

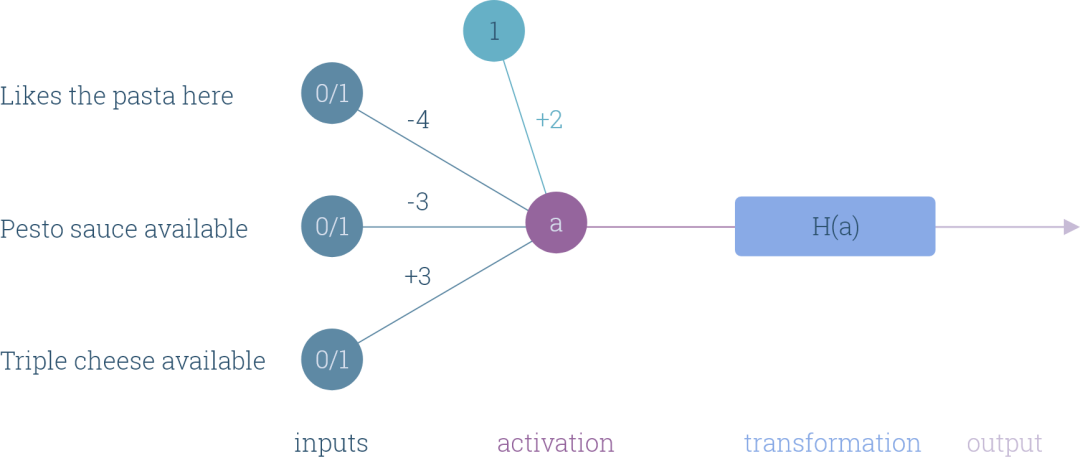

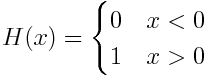

权重、偏差和构建模块

问题1:我喜欢这家餐厅的意大利面吗?

问题2:这家餐厅有意大利青酱吗?

问题3:这家餐厅有三层奶酪披萨吗?

决策1:如果我们喜欢这家餐厅的意大利面,我们就会点意大利面,除非青酱卖完,或者这家餐厅提供三层奶酪比萨。

决策2:如果我们不喜欢这家餐厅的意大利面,我们就会点披萨,除非还有青酱,或者没有三层奶酪披萨。

“以退为进”

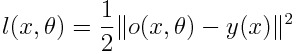

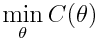

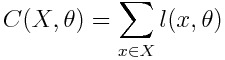

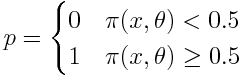

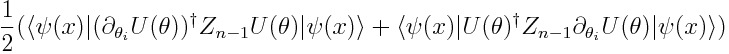

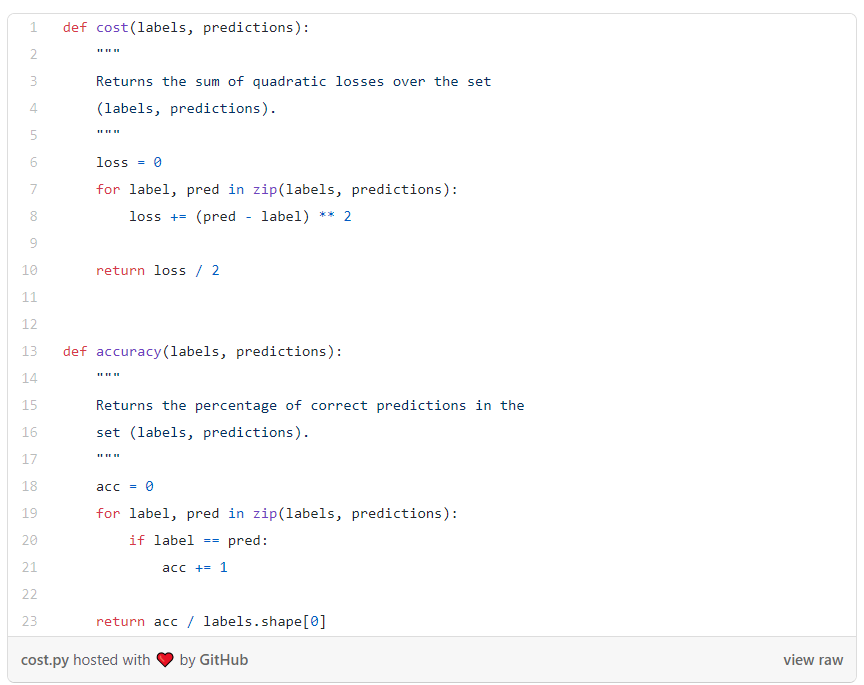

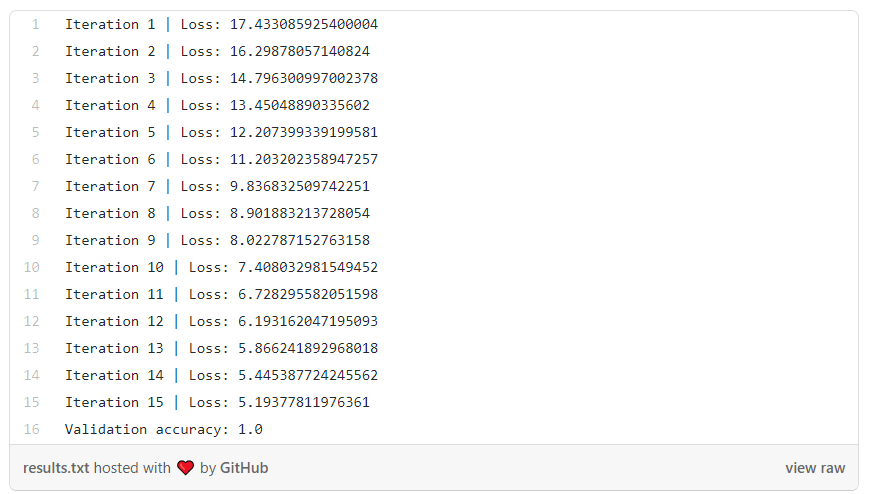

是神经网络的输出。由于损失始终为非负值,一旦取值接近于0,我们就知道网络已经学会了一个好的参数组。当然,这个过程中可能还会出现其他问题,例如过拟合,但这些可以暂时忽略。

是神经网络的输出。由于损失始终为非负值,一旦取值接近于0,我们就知道网络已经学会了一个好的参数组。当然,这个过程中可能还会出现其他问题,例如过拟合,但这些可以暂时忽略。

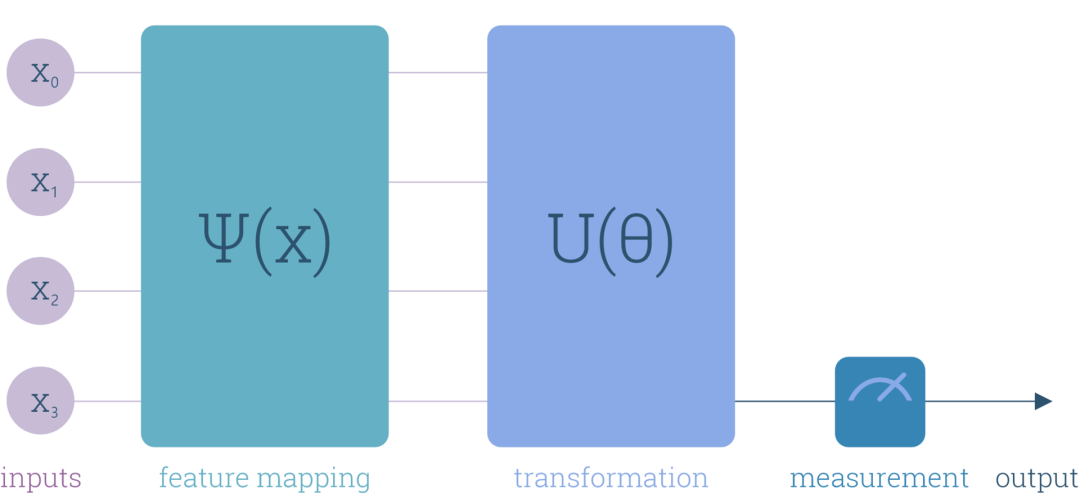

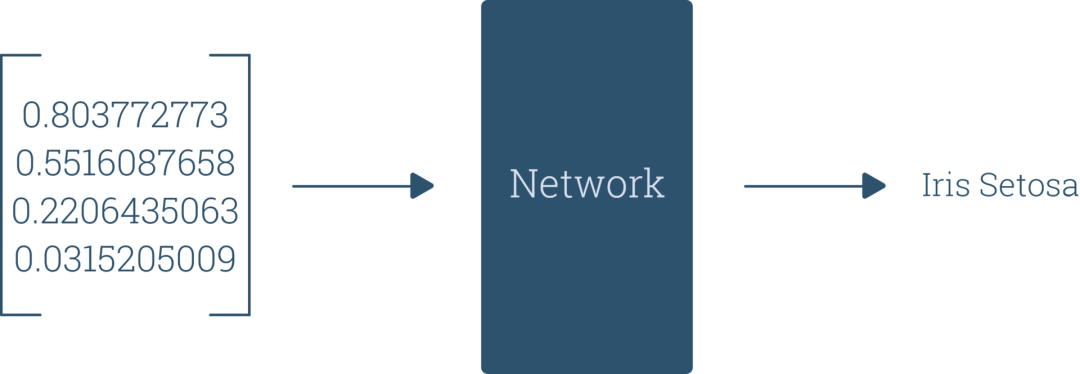

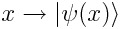

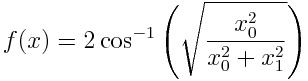

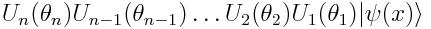

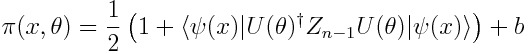

量子神经网络工作原理

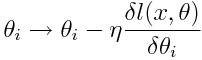

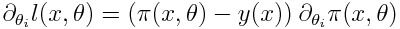

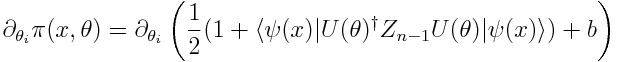

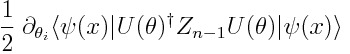

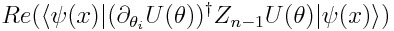

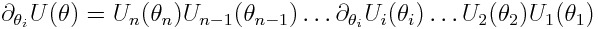

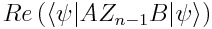

的梯度,当然完全可以使用传统的方法,但我们需要的是一种在量子计算机上计算的方法。

的梯度,当然完全可以使用传统的方法,但我们需要的是一种在量子计算机上计算的方法。

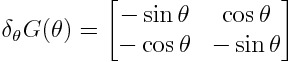

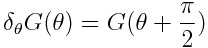

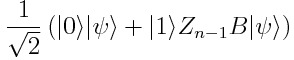

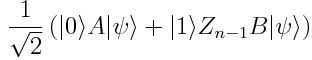

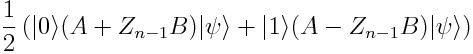

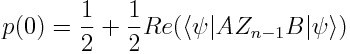

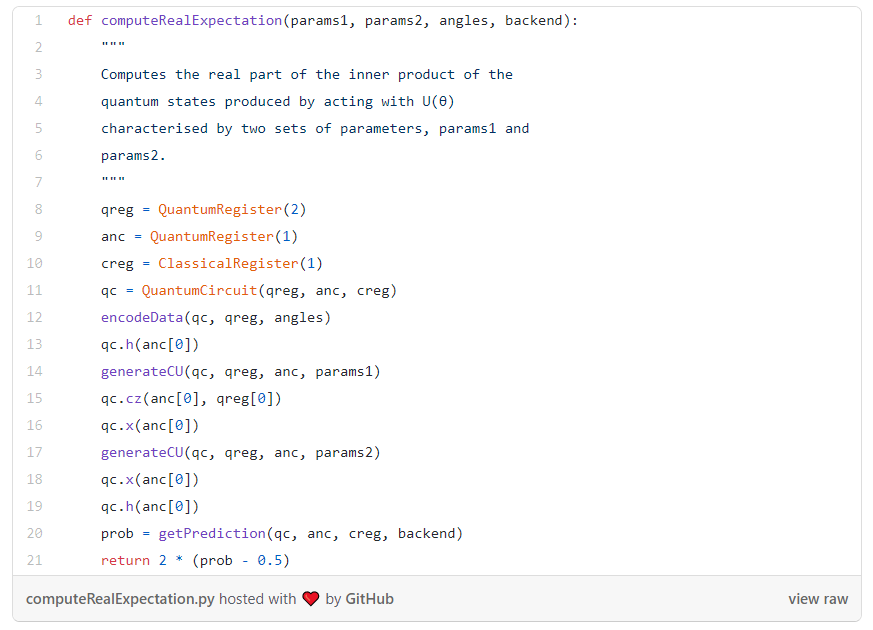

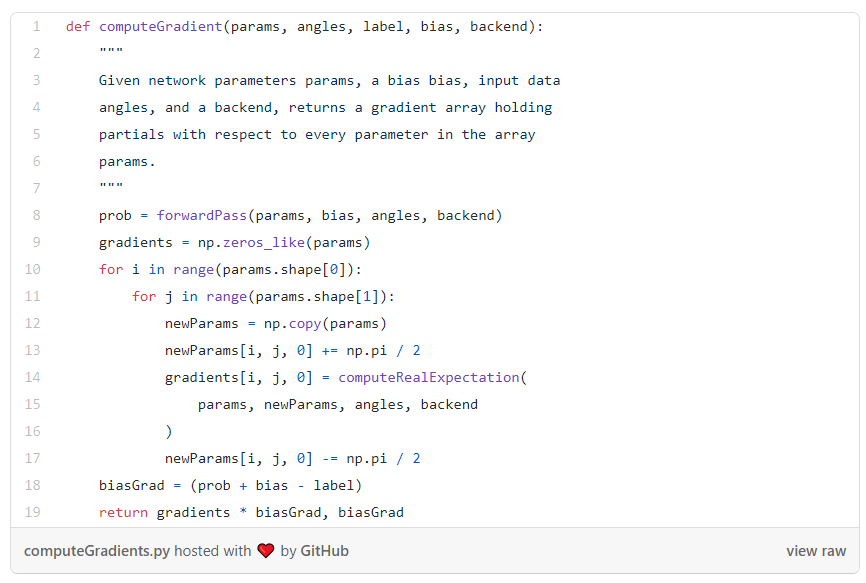

全新的计算梯度的方法

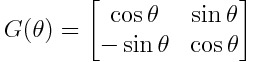

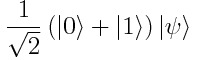

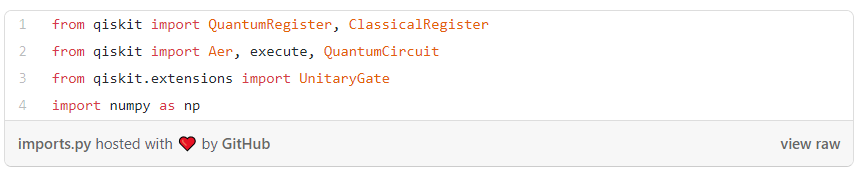

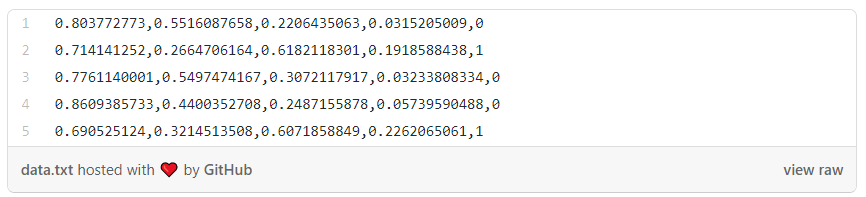

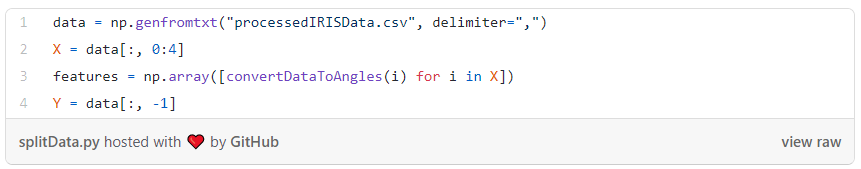

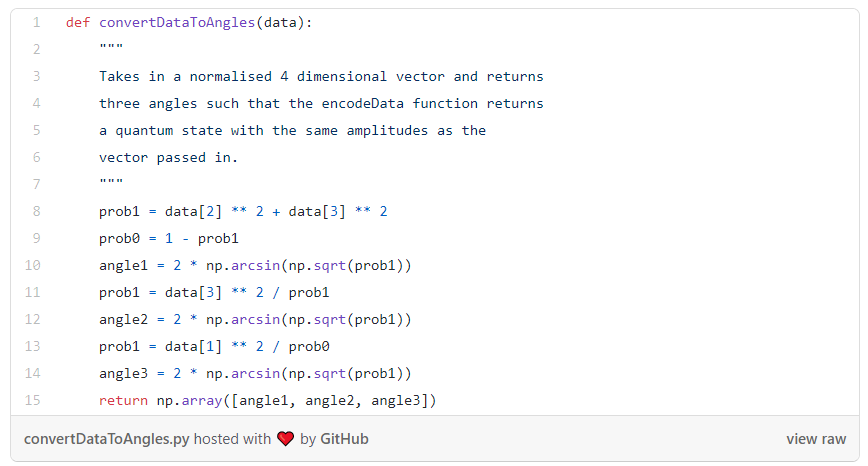

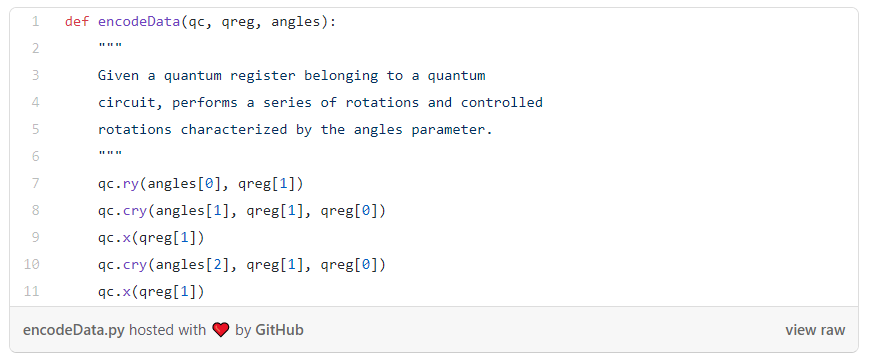

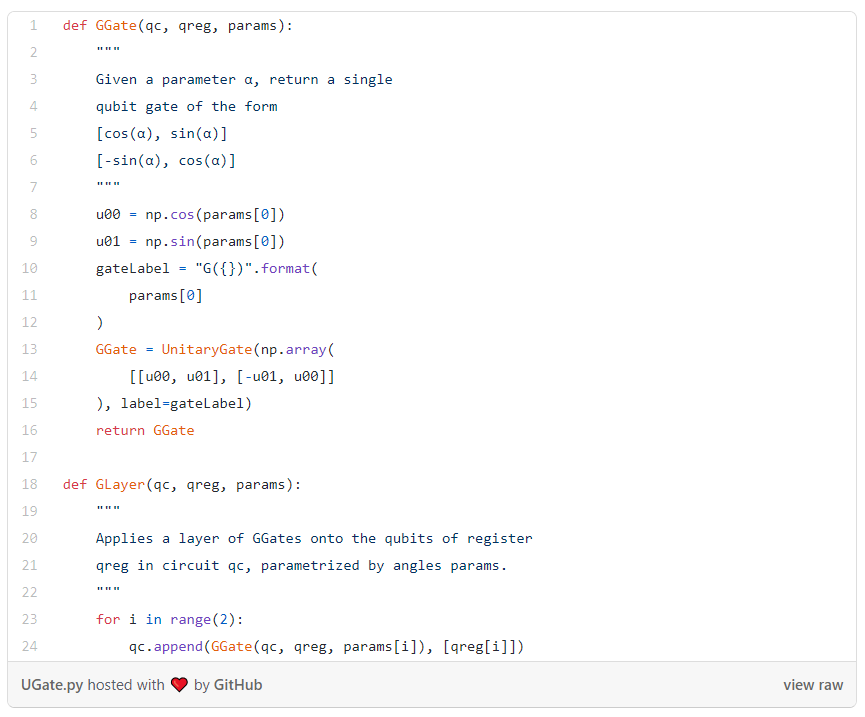

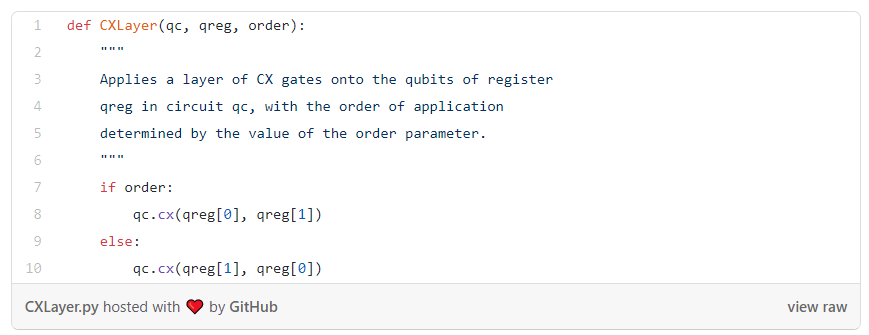

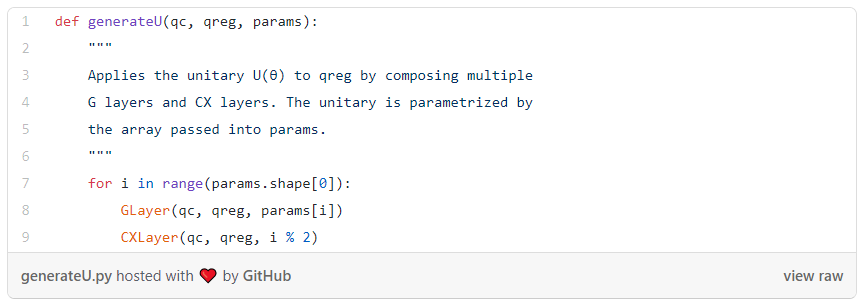

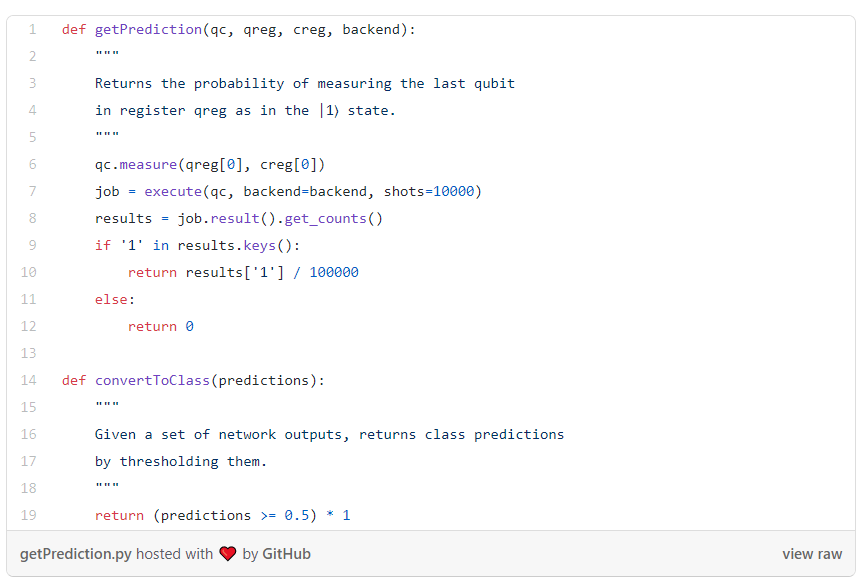

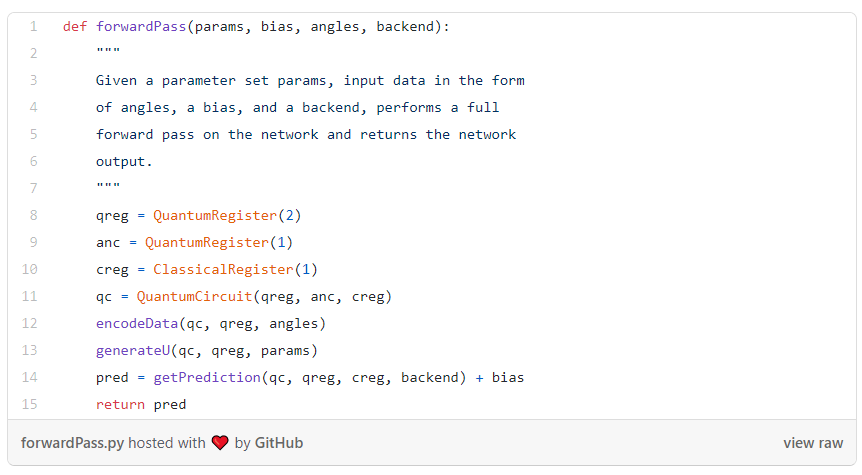

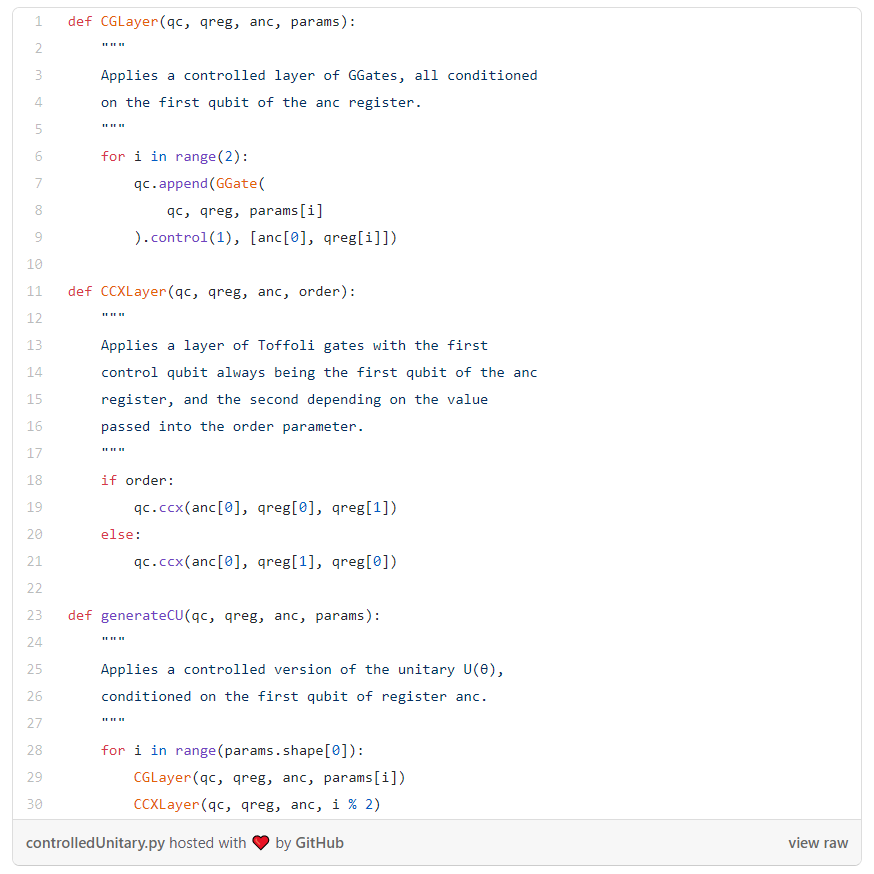

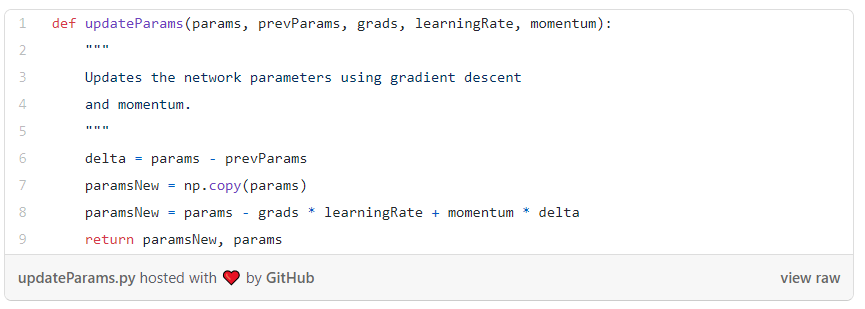

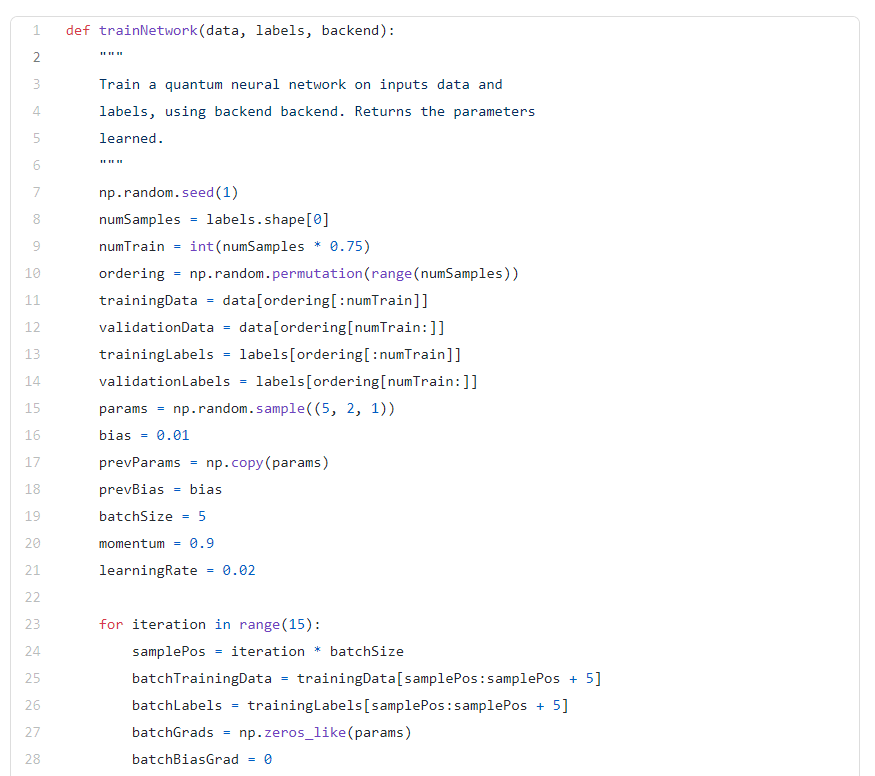

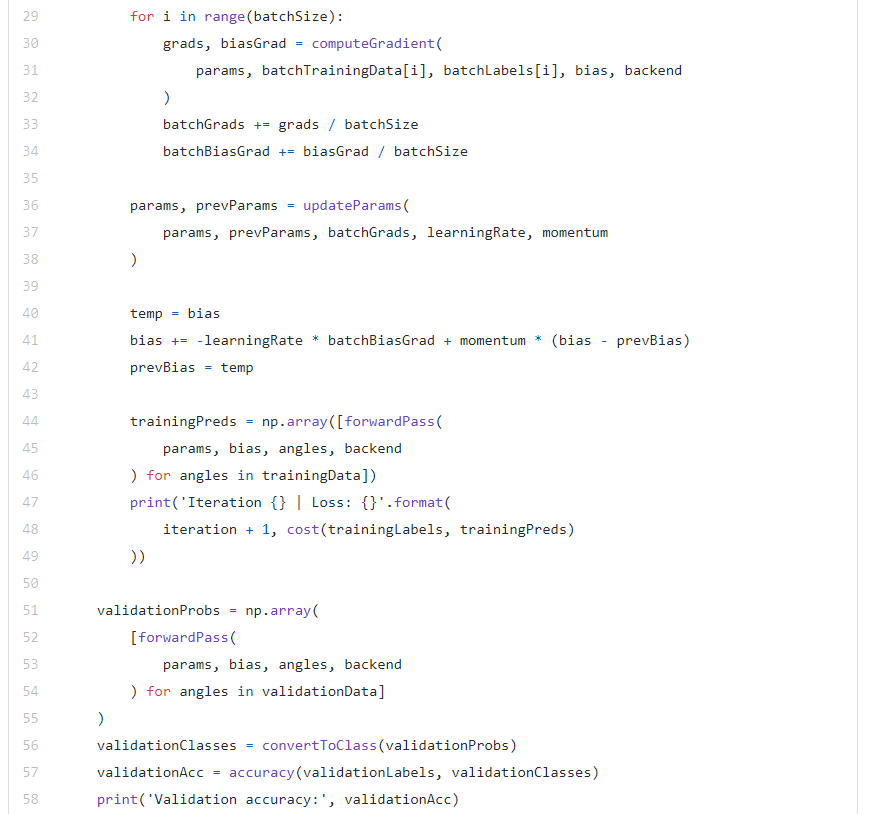

建立量子神经网络

结语

AI科技评论联合博文视点赠送周志华教授“森林树”十五本,在“周志华教授与他的森林书”一文留言区留言,谈一谈你和集成学习有关的学习、竞赛等经历。

AI 科技评论将会在留言区选出15名读者,每人送出《集成学习:基础与算法》一本。

活动规则:

1. 在“周志华教授与他的森林书”一文留言区留言,留言点赞最高的前 15 位读者将获得赠书。获得赠书的读者请联系 AI 科技评论客服(aitechreview)。

2. 留言内容会有筛选,例如“选我上去”等内容将不会被筛选,亦不会中奖。

3. 本活动时间为2020年8月23日 - 2020年8月30日(23:00),活动推送内仅允许中奖一次。

阅读原文,直达“ KDD”小组,了解更多会议信息!

登录查看更多