ACL 2019 | 将带推敲解码器的增量Transformer用于文档级知识对话

作者 | 徐家兴

编辑 | Camel

本文将对 ACL2019论文《Incremental Transformer with Deliberation Decoder for Document Grounded Conversations》进行解读,这篇论文提出了一个两步解码器(推敲解码器)可以在给定文档的内容时生成上下文连贯、正确利用知识的回复。

本文转载自「学术头条」公众号。

本文将对 ACL2019论文《Incremental Transformer with Deliberation Decoder for Document Grounded Conversations》进行解读,这篇论文提出了一个两步解码器(推敲解码器)可以在给定文档的内容时生成上下文连贯、正确利用知识的回复。

论文地址:https://www.aclweb.org/anthology/P19-1002

源码地址:https://github.com/lizekang/ITDD

论文作者:Zekang Li, Cheng Niu, Fandong Meng, Yang Feng, Qian Li, Jie Zhou

论文背景

基于序列到序列(Seq2seq)框架的深度模型被广泛应用在了对话系统任务中,这些模型大多是使用端到端(end-to-end)的方法在大规模的人人对话语料上进行训练的。虽然这些模型取得了巨大的成功,但距离对话系统“像人一样对话”的目标仍有很大差距。为了达到这一目标,很基本的一个想法就是将知识引入对话系统。

已有的一些工作主要集中于将事实知识(factoid knowledge)整合进对话系统,但这些事实知识需要大量的精力进行收集。文档是一种可以提供不同种类知识的知识资源,最近的一些研究将文档数据用于了问答任务。

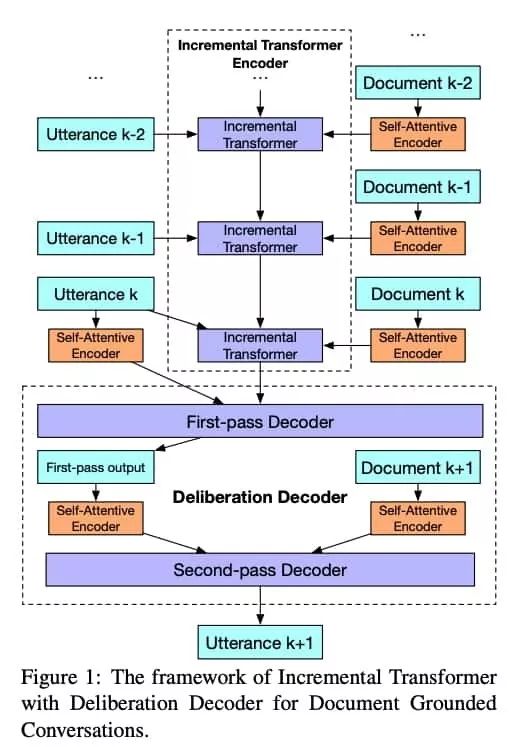

文档级知识对话需要将文档知识与多轮对话历史相结合,本文提出了一个带推敲解码器(Deliberation Decoder)的增量Transformer用于文档级知识对话。编码器采用一个Transformer来增量编码对话历史,并将文档知识合并进多轮上下文的编码过程。解码器包含两步,可以在给定文档的内容时生成上下文连贯、正确利用知识的回复。第一步的解码器关注于上下文相关性,而第二步的解码器通过查阅相关文档知识来细化第一步解码器的结果,因此增加了知识相关性和正确性。这与人类的认知过程是相符的,在现实世界的人类对话中,人们通常首先制定关于如何回应先前话语的草稿,然后使用背景知识来完善答案甚至提出问题。

本文提出的模型在Document Grounded Conversations Dataset[1]上进行了测试。实验结果表明,该模型能够产生更好的上下文连贯性和知识相关性的回复。自动和人工评估都表明该模型大大优于竞争基线。

论文模型

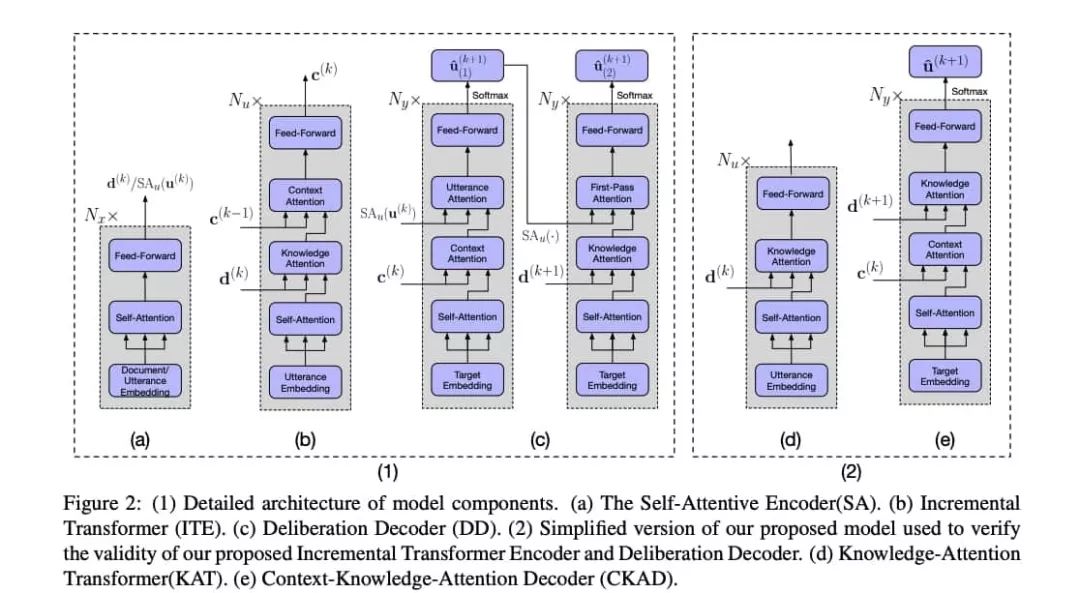

自关注编码器(Self-Attentive Encoder)是一个[2]提出的transformer编码器,该编码器可以独立的编码文档知识以及当前句子。

增量transformer编码器(Incremental Transformer Encoder)是一个统一的transformer编码器,其使用增量编码方案利用知识表示对多轮话语进行编码,该模块将先前的话语u(i)和文档s(i)的自关注编码器表示作为输入,并使用注意机制逐步建立相关上下文和文档知识的表示。

推敲解码器(Deliberation Decoder)是一个两步的统一transformer解码器,可以更好地生成回复。第一步解码器将当前句子u(k)的自关注表示和增量transformer编码器的输出作为输入,主要依赖对话上下文生成回复;第二步解码器将第一步输出的自关注表示和相关文档的自关注表示作为输入,使用文档知识进一步改善回复。

论文实验

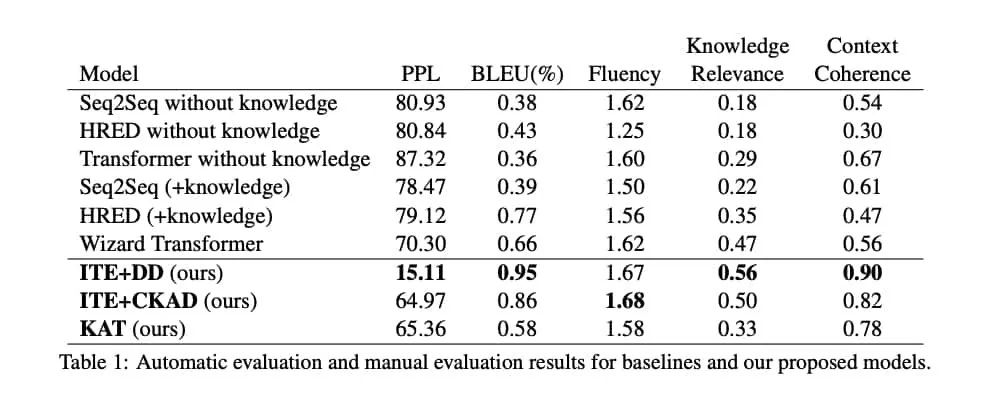

本文以Seq2seq[3]、HRED[4]、Transformer[5]等多个模型作为基线,在Document Grounded Conversations Dataset上考察了本文提出的方法的表现,本文提出的方法在自动评测指标和人工评测指标上都取得了更好的表现。

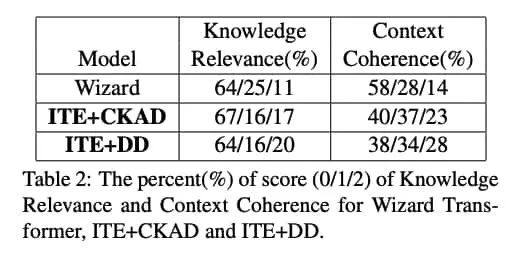

此外,作者还使用增量Transformer作为编码器(ITE),上下文知识知识关注解码器(CKAD)测试推敲解码器的有效性,实验表明本文提出的方法具有更高的知识相关性以及更好的上下文理解能力。

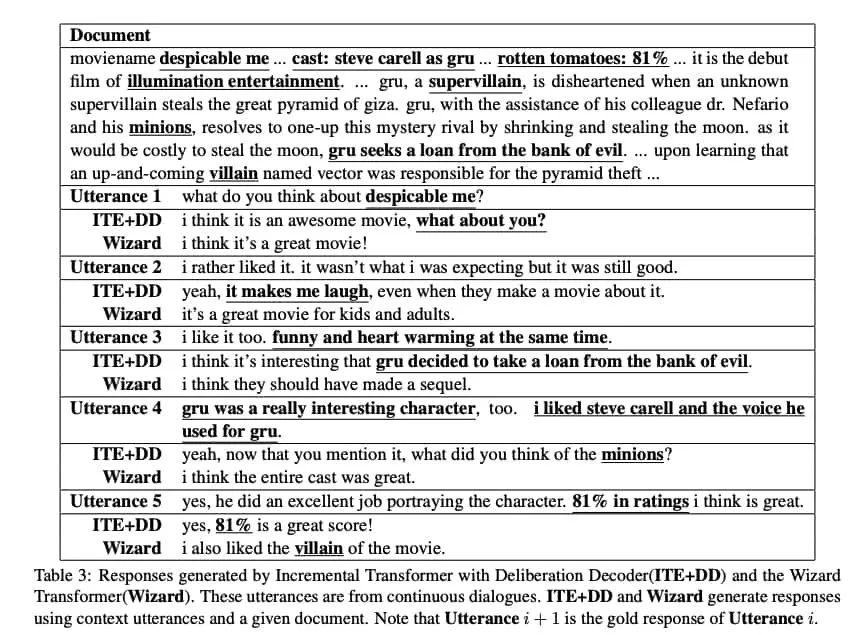

下图的几个例子也表明,通过本模型生成的响应具有更多的信息以及更好的连贯性。

结论

本文提出了一种带有推敲解码器的增量Transformer,通过模仿现实世界人类的认知过程来优化知识相关性和上下文连贯性,用于文档知识对话的任务。实验结果表明,与最先进的基线相比,本文所提出的模型可以产生具有更多相关性、正确性和一致性的响应。接下来还可以应用强化学习来进一步提高效果。

参考文献

[1] Kangyan Zhou, Shrimai Prabhumoye, and Alan W Black. 2018. A dataset for document grounded conversations. In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, pages 708–713.

[2] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, ?ukasz Kaiser, and Illia Polosukhin. 2017. Attention is all you need. In Advances in Neural Information Processing Systems, pages 5998–6008.

[3] Lifeng Shang, Zhengdong Lu, and Hang Li. 2015. Neural responding machine for short-text conversation. In Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing (Volume 1:Long Papers), volume 1, pages 1577–1586.

[4] Iulian V Serban, Alessandro Sordoni, Yoshua Bengio, Aaron Courville, and Joelle Pineau. 2016. Building end-to-end dialogue systems using generative hierarchical neural network models. In Thirtieth AAAI Conference on Artificial Intelligence.

[5] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, ?ukasz Kaiser, and Illia Polosukhin. 2017. Attention is all you need. In Advances in Neural Information Processing Systems, pages 5998–6008.

张钹院士:人工智能的魅力就是它永远在路上 | CCAI 2019

Facebook 自然语言处理新突破:新模型能力赶超人类 & 超难 NLP 新基准

巴赫涂鸦创作者 Anna Huang 现身上海,倾情讲解「音乐生成」两大算法

点击“阅读原文”加入 ACL 顶会交流小组