【CVPR2020-Oral】用于任务感知的持续学习的条件信道门控网络

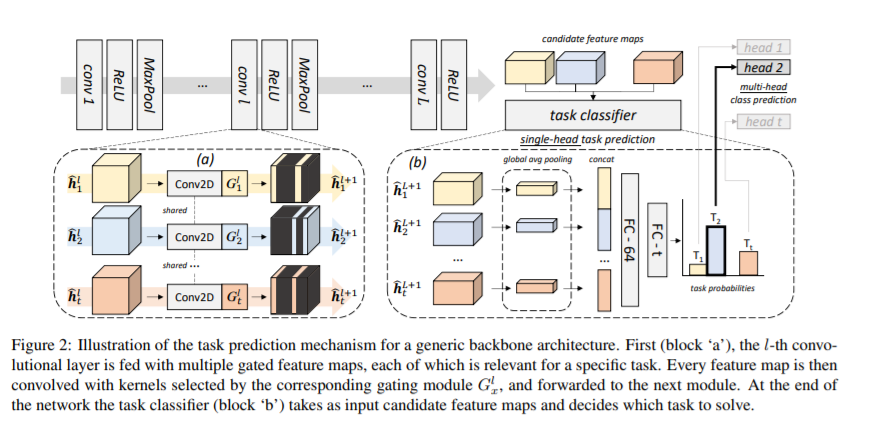

当对一系列学习问题进行优化时,卷积神经网络会经历灾难性的遗忘:当满足当前训练示例的目标时,它们在以前任务中的性能会急剧下降。在这项工作中,我们介绍了一个基于条件计算的新的框架来解决这个问题。

https://www.zhuanzhi.ai/paper/0e9c6a1fc2201cfc6c07d4d961e73e33

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“TACL” 就可以获取《【CVPR2020-Oral】用于任务感知的持续学习的条件信道门控网络》专知下载链接

登录查看更多

相关内容

专知会员服务

44+阅读 · 2020年3月26日

Arxiv

8+阅读 · 2018年5月12日