你说“神马”?非正式汉语数据集资源上线,帮你训练网络语言处理

晓查 发自 凹非寺

量子位 出品 | 公众号 QbitAI

NLP是个好东西,但是汉语文化实在是博大精深,连长辈都看不懂网络词语,想让机器理解它们就更难了。

如果我们还用“正经”训练数据集,那就明显不够用了。

为了解决这个问题,有人从有人收集了3700万条图书评论和5万条bbs回帖,作为大型非正式汉语数据集(LSICC)。

内容来源分别是“豆瓣读书”和Chiphell论坛。

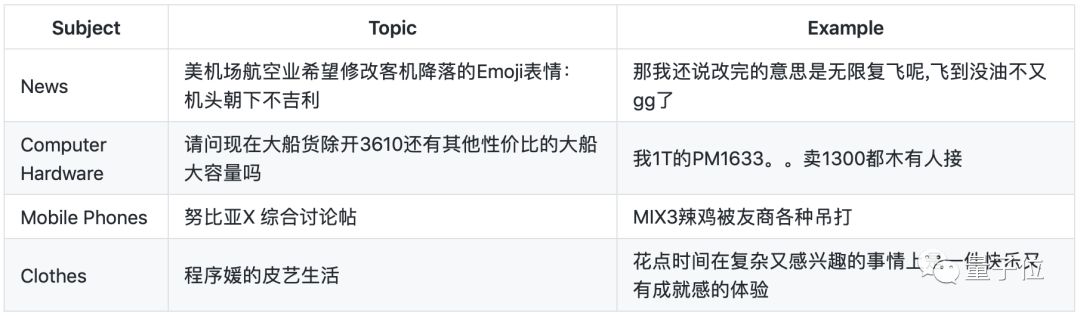

下面请从数据集中感受一下网络论坛文化的洗礼:

作者从Chiphell中选取了几个主题的回帖,其中有大量的网络用语,甚至还有中英文混用。

“辣鸡”当然不是辣味的鸡,“木有”也不是说木头。如果用正经训练集得到的模型去识别它们,结果恐怕会惨不忍睹。

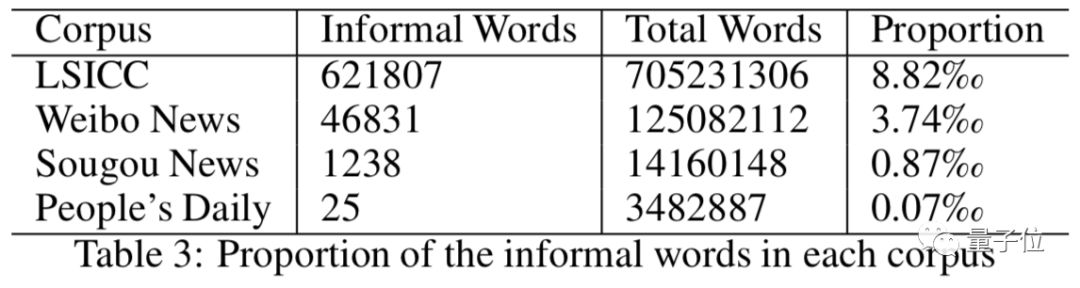

据统计,这个数据集中非正式用语的比例远远高于一般其他数据集,在7.5亿词语中,非正式用语出现了62万次。比例远高于人民日报这样的官方媒体。

结果表明,现实世界自然语言模型处理和现有语料库的语言之间差距明显。

如果使用从正式汉语语料库中提取的向量表示作为单词嵌入,可能导致不良的表现。

所以,如果你需要训练模型去识别网络语言,那一定要尝试一下这个数据集。

这些抓取内容也并非直接可用,好在作者进行了一些预处理,删除了其中较短的句子,另外也对文中的英文单词做了识别。

资源地址:

豆瓣读书评论:

https://github.com/JaniceZhao/Douban-Dushu-Dataset.git

Chiphell回帖:

https://github.com/JaniceZhao/Chinese-Forum-Corpus.git

作者将豆瓣读书评论的内容整理成csv表格,Chiphell回帖则整理成json文件格式。

登录查看更多

相关内容

Arxiv

8+阅读 · 2018年8月22日

Arxiv

4+阅读 · 2018年1月11日