直接对梯度下手,阿里达摩院提出新型优化方法,一行代码即可替换现有优化器

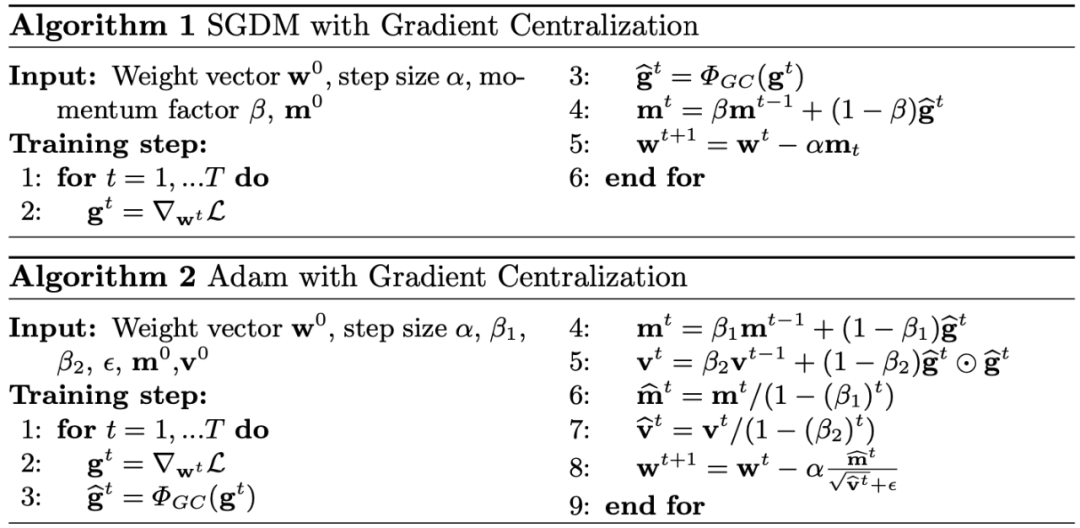

优化技术何其多也!比如批归一化、权重标准化……但现有的优化方法大多基于激活或权重执行,最近阿里达摩院的研究者另辟蹊径,直接对梯度下手,提出全新的梯度中心化方法。只需一行代码即可嵌入现有的 DNN 优化器中,还可以直接对预训练模型进行微调。

论文地址:https://arxiv.org/pdf/2004.01461.pdf

-

项目地址:https://github.com/Yonghongwei/Gradient-Centralization

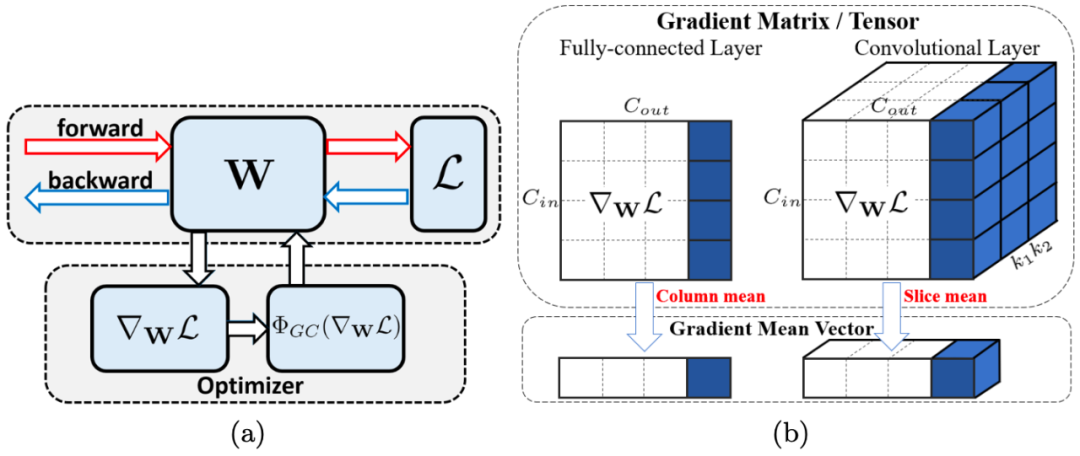

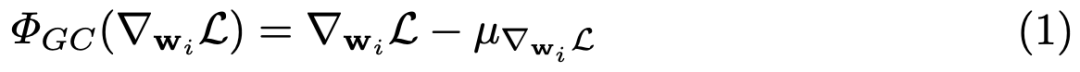

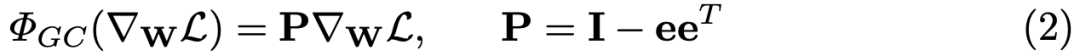

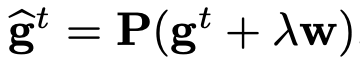

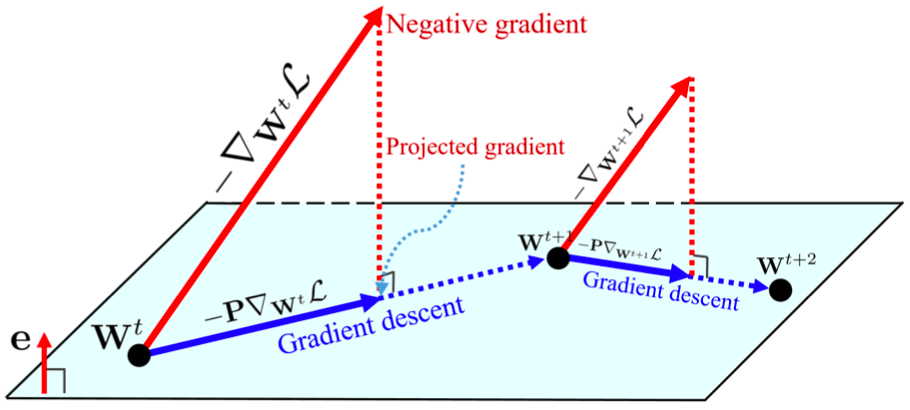

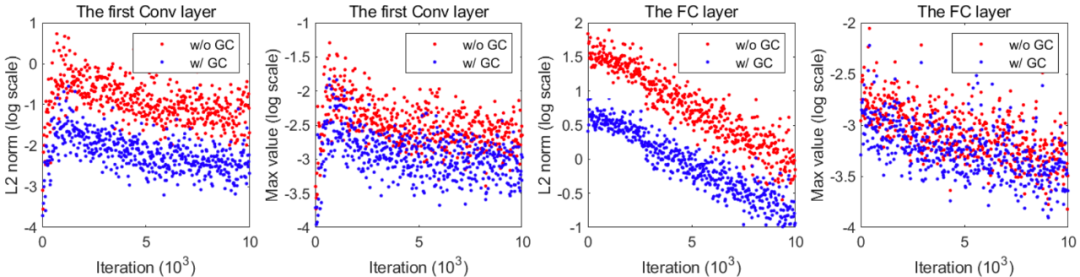

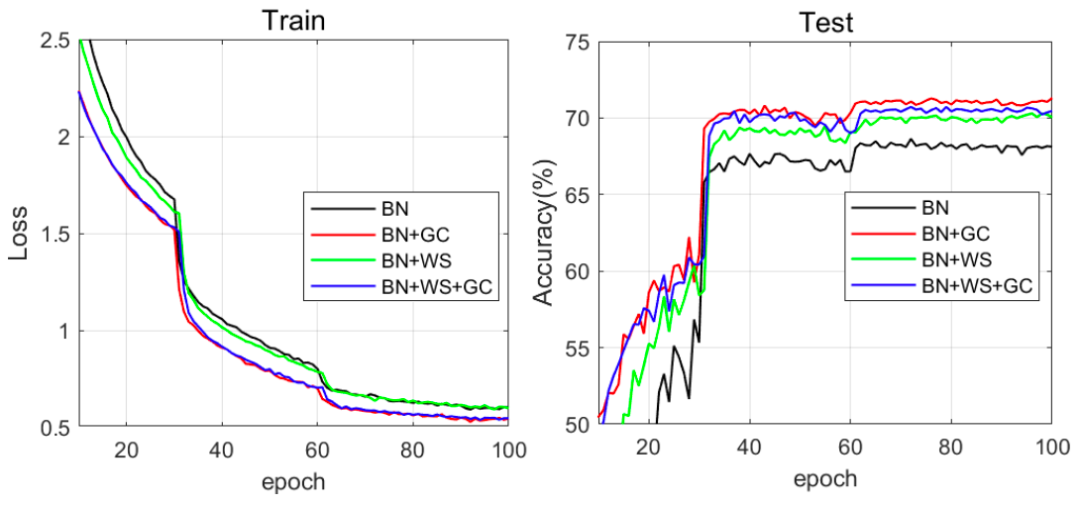

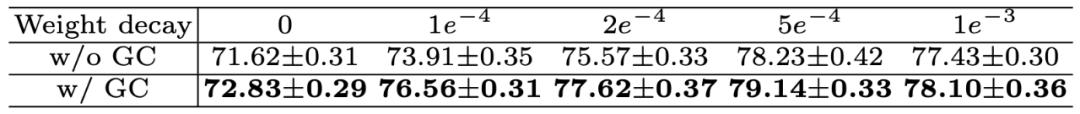

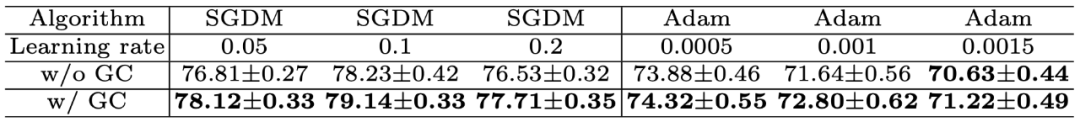

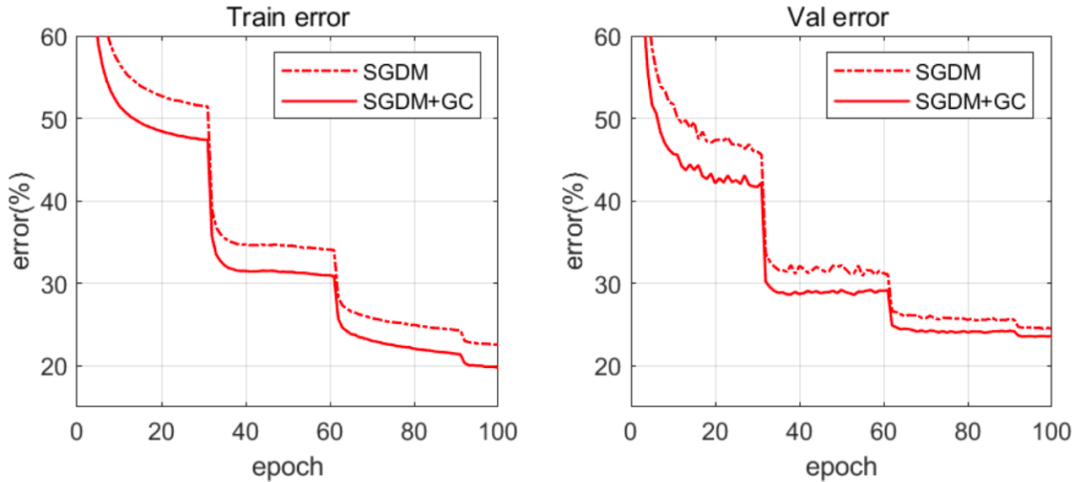

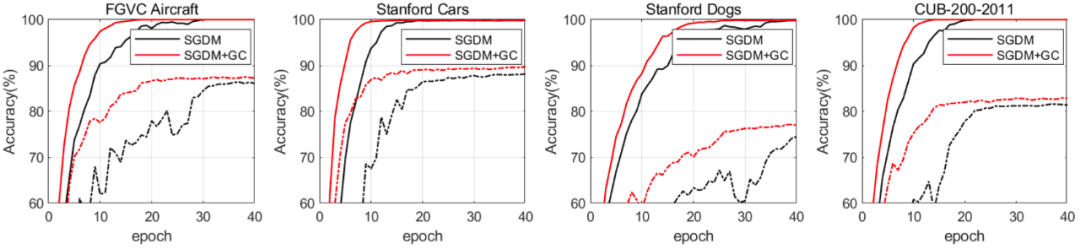

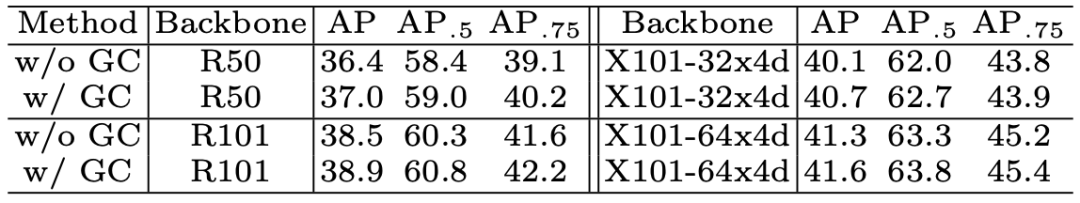

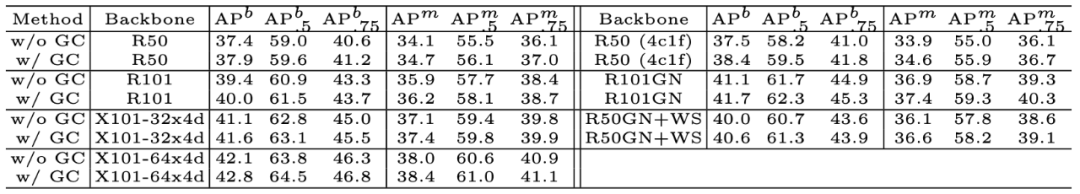

提出了一种通用网络优化技术——梯度中心化(GC),GC 不仅能够平滑和加速 DNN 的训练过程,还可以提升模型的泛化性能。

分析了 GC 的理论性质,指出 GC 通过对权重向量引入新的约束来约束损失函数,该过程对权重空间和输出特征空间进行了正则化,从而提升了模型的泛化性能。此外,约束损失函数比原始损失函数具备更好的利普希茨属性,使得训练过程更加稳定高效。

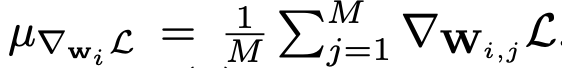

from SGD import SGD_GC

登录查看更多

相关内容

Arxiv

5+阅读 · 2018年4月5日

Arxiv

6+阅读 · 2018年3月28日