想入门图深度学习?这篇55页的教程帮你理清楚了脉络

意大利比萨大学的研究者发表论文,介绍了图深度学习领域的主要概念、思想和应用。 与其他论文不同的是,这篇论文更像一份入门教程,既适合初学者作为学习材料,也可以帮助资深从业者理清该领域的脉络,避免重复造轮子。

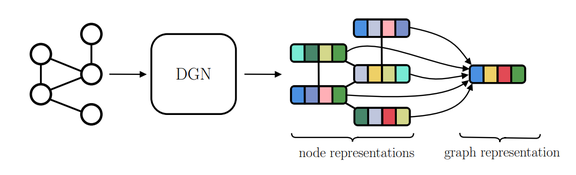

图 2:所有图学习方法共享的机制。向深度图网络(DGN)输入图,它将输出节点表示 h_v, ∀_v ∈ V_g。将此类表示聚合起来,即可得到图表示 h_g。

图 2:所有图学习方法共享的机制。向深度图网络(DGN)输入图,它将输出节点表示 h_v, ∀_v ∈ V_g。将此类表示聚合起来,即可得到图表示 h_g。

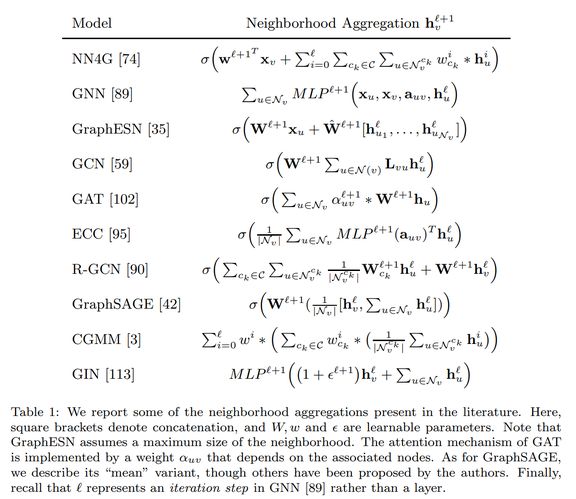

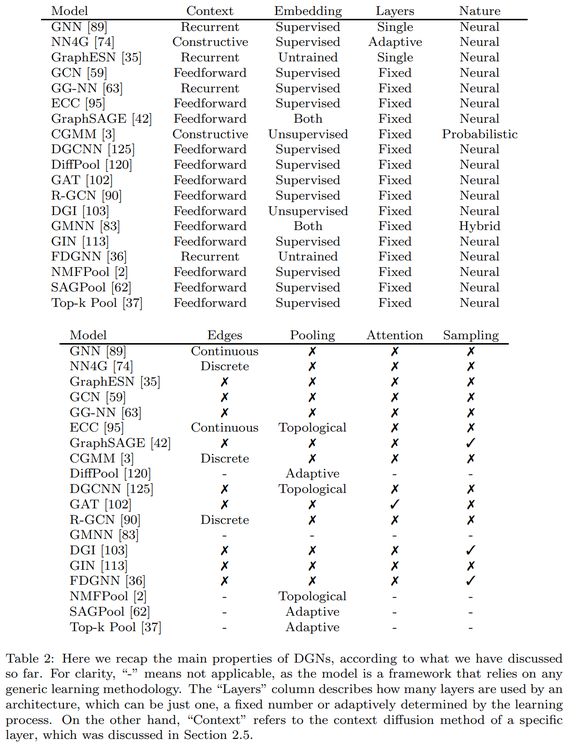

邻域聚合

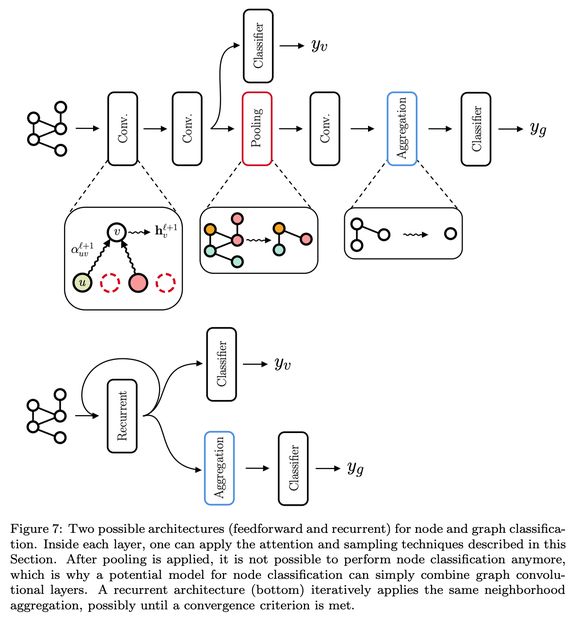

池化

执行节点聚合,以形成图嵌入

核

谱方法

随机游走

图对抗训练和攻击

图序列生成模型

时间演化图(Time-evolving graph)

偏差-方差权衡

合理利用边信息

超图学习(Hypergraph learning)

化学和药物设计

社交网络

自然语言处理

安防

时空预测

推荐系统

登录查看更多