深度牛顿!24岁博士小哥用图神经网络重新发现宇宙

新智元报道

新智元报道

编辑:白峰、舒婷

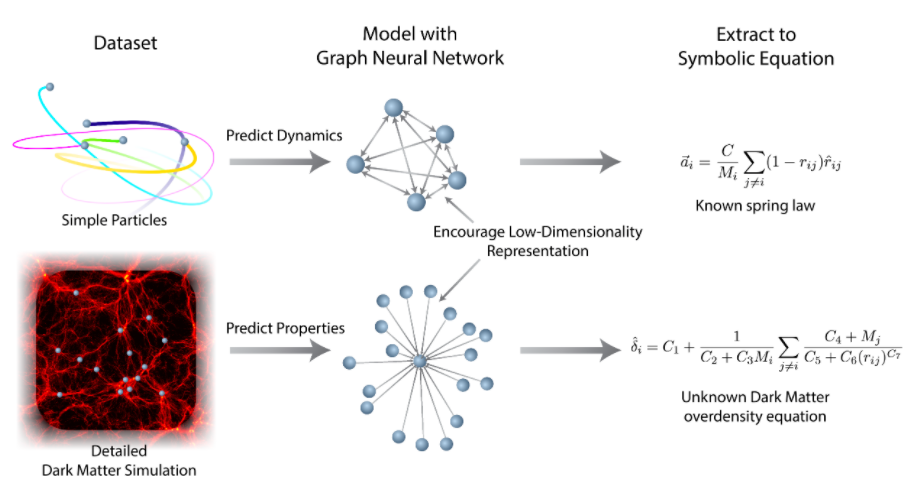

【新智元导读】深度学习模型取得了很大进展,但是依旧难以解释。传统的符号模型可以很好地解释和泛化,但高维数据又不好处理,那二者能否优势互补呢?近日,普林斯顿大学的博士Miles Cranmer发表了一篇论文,将符号模型和深度学习模型结合了起来,给天体物理学带来了新的惊喜!

Cranmer自己设计的个人主页,致力于用AI加速天体物理学进展

Cranmer自己设计的个人主页,致力于用AI加速天体物理学进展

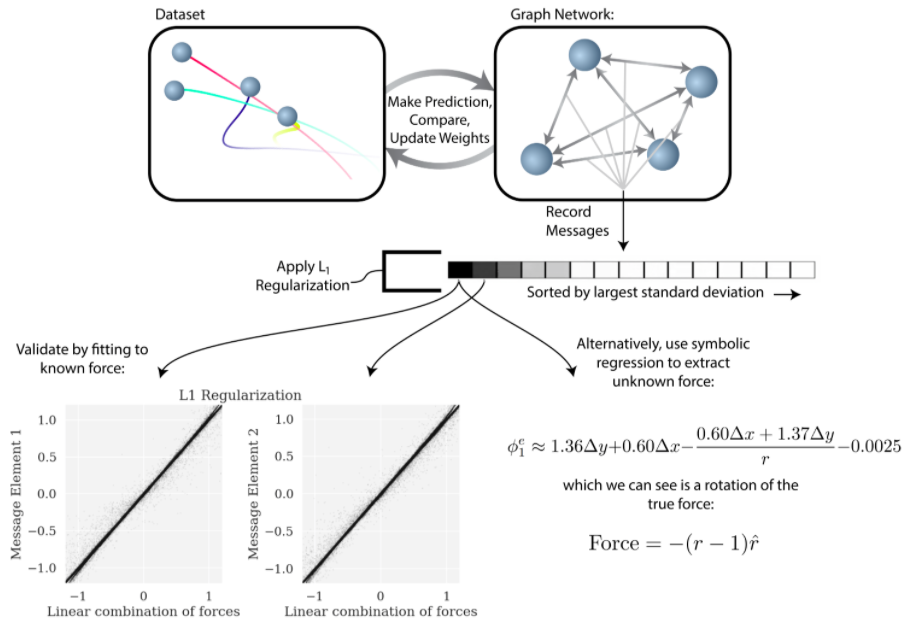

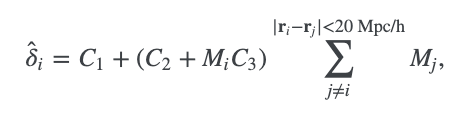

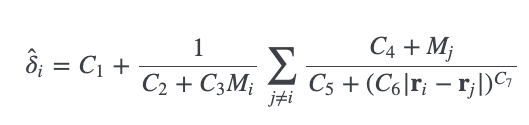

为了验证我们的方法,我们首先生成了一系列的 二维和三维的力学模拟。

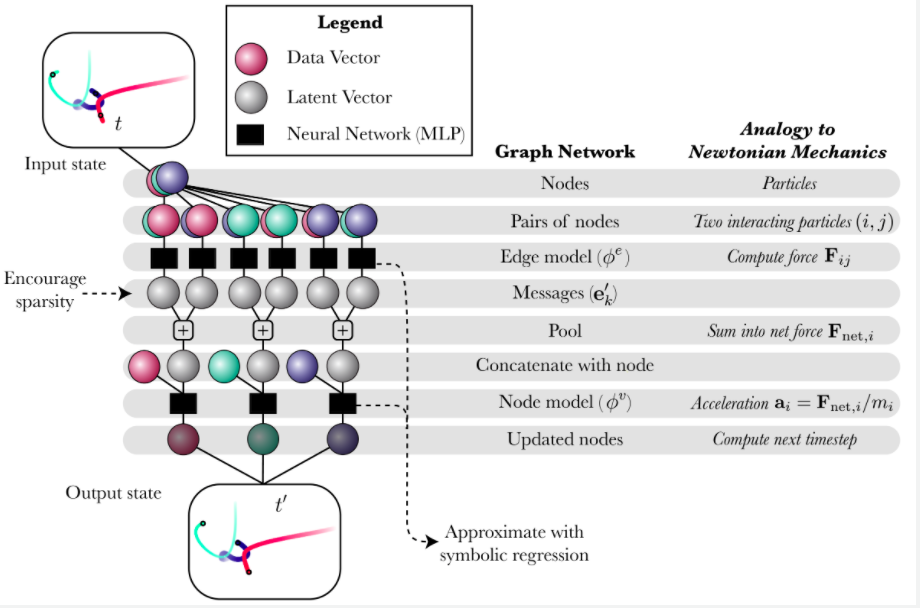

一个神经网络经历监督式学习,然后符号回归接近模型的内部函数

一个神经网络经历监督式学习,然后符号回归接近模型的内部函数

结论:符号表达式比图神经网络更稳定

登录查看更多

相关内容

Arxiv

15+阅读 · 2020年2月28日

Arxiv

4+阅读 · 2019年3月7日