苹果上线机器学习博客,背后隐藏着怎样的动作和野心?

本文转载自:AI科技大本营

作者 | 周翔

本周三(7 月 19 日),一个名为“Apple Machine Learning Journal”的博客在苹果官网悄悄上线,一同发布的还有一篇题为“Improving the Realism of Synthetic Images”的文章。这篇文章介绍了苹果在机器学习领域的最新成果,以下是内容摘要:

神经网络的大多数成功实例都是由监督训练得来的。但是,如果要想获得较高的准确性,就必须使用庞大、多样且精确标注的训练数据集,但是这类数据集成本很高。有一种方法不需要标记大量数据,它使用模拟器中的合成图像就可以用来训练模型。

由于不需要标记数据,这种方法的成本较低。但是合成图像可能会不够真实的,从而导致泛化至实际测试图像时不太理想。

为了克服这种缺陷,我们制定了一种细化合成图像的方法,用以提高图像的真实度。试验证明,使用细化后的图像进行训练可以大幅提高多种机器学习任务中模型的准确度。

详细内容请参阅AI科技大本营的下篇文章:《苹果机器学习博客解读CVPR论文:通过对抗训练从模拟的和无监督的图像中学习》

实际上,苹果仿照了 GAN(生成对抗网络)的模式。在 GAN 中,有 Generator(生成器)和 Discriminator(判别器),而苹果团队将 Generator 换成了 Simulator(模拟器)+ Refiner (精化器)。其中,Simulator 主要用于合成图像,Refiner 用来细化图像,而 Discriminator 要负责鉴别这是真实图像还是细化后图像。然后不停地的训练,一直到 Discriminator 分辨不出来为止。

不过,在文章中,AI科技大本营并未发现相关作者的署名。在查阅论文原文时发现,这篇文章实际上就是对苹果去年 12 月首次公开论文的解读,并不是什么新的成果展示。

这篇论文的标题为“Learning from Simulated and Unsupervised Images through Adversarial Training”(《通过对抗训练从模拟的和无监督的图像中学习》),第一作者是苹果深度学习研究院 Ashish Shrivastava ,已经被 CVPR 2017 收录。

目前,大多数的人工智能领域的论文都是首发在 ArXiv 上,苹果也已经在 ArXiv 上提交过几篇论文。有外媒分析称,由于发在 ArXiv 上的论文往往需要公布训练数据集,而苹果公司对此比较排斥,因此才会上线自己的技术博客。

根据官方介绍,苹果工程师将在此博客上定期发表他们在机器学习领域的工作和成果。此外,苹果还公布了一个邮箱地址,欢迎苹果以外的机器学习工程师、学生、以及研究人员发表意见。

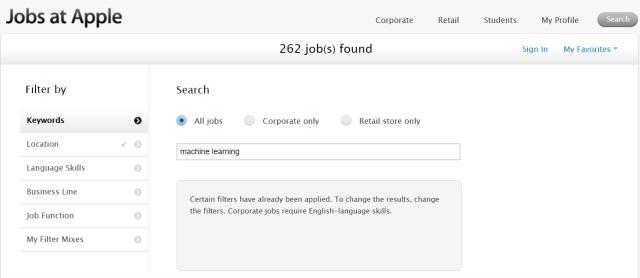

除此之外,AI科技大本营发现,在博客的底部,还有“ Jobs at Apple”一栏,显然,苹果希望通过这个平台招揽机器学习领域的人才。

Apple 的 AI 布局

自去年 3 月,谷歌的 AlphaGo 战胜世界围棋冠军、职业九段棋手李世石之后,已经有 60 年历史的人工智能迎来了全面的爆发,不同于前几次的热潮,这次的人工智能得到了包括谷歌、亚马逊、Facebook等大公司在内的大力支持。然而在外界看来,全球利润最高的科技公司苹果却在这一领域落后了。

实际上,人工智能对于苹果来说并不算“新东西”。

据 Backchannel 报导,早在1990 年代,苹果已经开始使用机器学习技术开发笔记识别程序(Newton 平板),这个研究成果在目前的苹果产品上依旧有用,这也是为什么苹果能很好地识别你的“狂草”。这跟苹果一直都设有专门的机器学习团队也有关系。

2011年,苹果又借着 iPhone 4S 首次推出了智能语音助手 Siri,然起 Siri 起了个大早,赶了个晚集。借着智能音箱的东风,亚马逊的 Alexa 显然占据了更多的报道篇幅。

不过,从2016年下半年开始,苹果明显加大了对人工智能的投入,并改变了以往封闭的态度,变得更加开放。

收购和扩张

据AI科技大本营不完全统计,自 2010 年以来,苹果已经收购了多家和人工智能有关的公司。

2010 年 4 月,苹果收购 Siri Inc. 公司。

2011 年 10 月,苹果在 iPhone 4S 上正式语音助手服务——Siri。到目前,Siri 已经成了苹果全线产品最重要的特性之一。

2014 年 4 月,有消息传出,苹果已经悄悄收购了自动语音识别技术公司 Novauris Technologies。

2015 年 10 月,苹果又被爆出收购英国语音技术初创公司 VocalIQ 的消息,VocalIQ 主要使用使用深度学习来改进语言识别,专注于通过语境理解用户发出的指令。由于 VocalIQ 此前已经同通用汽车建立了伙伴关系,此次收购,不仅将有助于苹果改进Siri,并有望进一步推进苹果的汽车项目。

就在苹果收购 VocallQ 一周之后,苹果又被证实已经收购创业公司 Perceptio。据报导,Perceptio 的目标是在无需借鉴外部数据库的情况下, 开发技术来运行在智能手机中的AI图像分类。

2016 年 8 月,苹果以 2 亿美元的价格收购位于西雅图的人工智能初创公司 Turi。Turi 主要帮助开发者在应用中加入机器学习和人工智能技术,其产品的具体使用场景包括推荐引擎、反欺诈、预测用户数变化、情绪分析,以及用户分类等等。Turi 的创始人——华盛顿大学教授 Guestrin 表示,苹果在西雅图正在进行长期研究,同时还有短期项目,并为苹果产品增加新功能。

2017 年 1 月,苹果宣布加入由 5 家科技行业巨头创立的非盈利人工智能 AI 研究小组,该小组这意味着苹果公司未来将进一步公布自己的 AI 研究。去年9月,Amazon、FB、谷歌、微软和 IBM 宣布联合创立 AI 小组,该组织的目标是研究和制定最佳方法,促进公众对人工智能的理解,并作为一个开放的平台,讨论和参与人工智能及其对人和社会的影响。

2017 年 2 月,据 GeekWire 报告,苹果正准备扩张位于西雅图的研发中心,方便 Turi 团队进驻,并加强人工智能和机器学习技术的研发。

2017 年 5 月,苹果公司又以 2 亿美元的价格收购了数据挖掘和机器学习创业公司 Lattice.co。该公司可将文本和图像等非结构化的“暗数据”转换成结构化数据,然后使用数据分析工具对其进行处理。

向学术圈示好

虽然苹果很早就一脚踏入了人工智能的大门,但是过去20多年,苹果的员工都不被允许对外谈论他们的长期研究项目。据圭尔夫大学机器学习教授 Graham Taylor 表示,苹果新入职AI组的员工不能在 LinkedIn 或 Twitter 表明自己的职位。

Yann LeCun 曾经这样评价苹果:我觉得苹果在 AI 研究领域没戏,因为他们有保密文化,一项开创性的研究工作是无法在秘密的情况下完成的。

于是,“闭门造车”的苹果在人工智能领域渐渐落在了谷歌、亚马逊、Facebook等竞争对手的身后。对于 iPhone,秘密行事的作风或许可以玩得通,但是在人工智能领域,这样做的直接后果就是招揽不到学术界的人才。

谷歌有 Geoffrey Hinton 坐镇,Facebook 找来了Yann LeCun,微软则拉来了 Yoshua Bengio 为其站台,就连百度都曾经拥有过 Andrew Ng(吴恩达)。

然而,直到去年 10 月,苹果才正式聘用了了第一个 AI 学者——卡耐基梅隆大学机器学习部门的副教授 Russ Salakhutdinov。在外界看来,这是苹果对学术圈的示好。

两个月之后,苹果终于首次对外公布了 AI 研究成果,该论文于 12 月 22 日提交给 arXiv.org,也就是如今发表在苹果自家博客上的文章。

如今,苹果又更进一步。不仅推出自己的技术博客,还欢迎外界的交流,并趁机插入自己的招聘广告。

AI科技大本营在其招聘网页上发现,目前苹果有 600 多个职位空缺,然而仅“Machine Learning”相关的工作就高达 262 个。就在去年 12 月,这个数字还是 142。苹果对机器学习的重视可见一斑。

Apple 对 AI 的应用

虽然苹果之前对自己在 AI 领域的进展一直讳莫如深,但是 AI 实际上已经渗透到苹果产品和服务的每个角落。

据库克透露,iPhone 的电池管理系统接入苹果研发的机器学习技术后,能学习用户的使用习惯,安排在特定时间执行特定任务,以最大限度延长电池续航。

此外,Apple Music 也会学习用户的音乐喜好推荐歌单,相册应用中也有图像识别技术的应用。

不过,苹果不满足于小打小闹,在今年 6 月的 WWDC 上,苹果发了两个大招:CoreML 和 HomePod。

CoreML 框架

在今年 6 月的 WWDC 上,苹果推出了面向开发者的机器学习框架——CoreML。

和 Tensorflow、Caffe 等深度学习框架不同,CoreML 是完全聚集于在设备端本地进行深度学习推理的框架,而其它框架除了支持本地设备端同时也支持云端,能够推理也支持训练。据悉,CoreML 是第一个较完善的手机端人工智能框架。

目前,苹果已经通过 CoreML 向开发者开放了负责图像处理的 Vision API:面部追踪、面部识别、地标、文本识别、正方形识别、条码识别、物体追踪、图像匹配;以及负责自然语言处理的Natual Language API:语言检测、符号化识别、词形还原、对话分段、实体名称识别。

CoreML 的目的就是让开发者通过这些 API,把机器学习集成到 App 里,创造更多可能性。

据介绍,为了方便开发者,苹果还定义了一个标准的模型格式(.mlmodel),提供了流行的框架模型到该格式的转换工具,比如你可以将你的 Caffe 模型转换成 CoreML 的模型格式。模型训练好了之后,只要拖放到 XCode 中就可以使用,苹果甚至把接口的Swift代码都给你生成好了,非常方便。

实际上,在今年 5 月的 Google IO 开发者大会上,Google 的工程副总 Dave Burke 宣布了一个专门针对移动设备而优化的 Tensorflow 新版本——TensorFlow Lite,允许开发人员在用户的移动设备上实时地运行人工智能应用。它将作为开源 Tensorflow 计划的一部分于今年晚些时候发布。

可以预见的是,人工智能的未来不只在云端,移动终端将会成为 AI 的下一个战场。

Siri + HomePod

同样,在今年的 WWDC 大会上,苹果还展示升级版的 Siri。

升级版的 Siri 支持一系列第三方应用,这个功能叫做 Siri Kit。此外,Siri 实现了更自然的语音、实时翻译、更精准的预测。

据苹果介绍,Siri 借助机器学习,还能更了解用户的兴趣,给用户推荐新闻、帮用户回复消息等等。

与 Siri 一同出现的,还有姗姗来迟的智能音箱——HomePod。HomePod底部设有7个环绕喇叭,内置低音炮,整个产品由A8芯片控制,支持实时声音建模。

苹果发布的信息显示,HomePod 目前可以播放音乐、新闻、天气及股票等信息,设置提醒,通报交通和附近的状况,并与 HomeKit 集成用于控制智能家居设备。

然而,苹果在智能音箱市场已然落后太多。来自 eMarketer 的数据显示,在今年一季度美国智能音箱市场中,Amazon Echo 的市场份额达到 70.6%,Google Home 则占到 23.8%,而其他厂商分食剩下的市场份额,为 5.6%。

而 HomePod 要到今年 12 月才能上市,售价为 349 美元,而亚马逊 Echo 才 179.99 美元,带触摸屏的 Echo Show 为 229.99美元,而最便宜的 Echo Dot 只需要 49.99美元,并且已经有超过 15000 项技能,远远超出 HomePod。虽然 HomePod 主打音质,但是未来能否成功还有待观察。

苹果在 AI 领域并不落后?

虽然苹果动作频频,但是外界普遍认为苹果在 AI 领域已经落后。今年 6 月,苹果公司CEO蒂姆·库克在接受《MIT科技评论》采访时,首次回应了这个问题。

通常,我们不会在产品发布前对外谈论它。不仅 AI,其他事也是这样:相较于很多人夸夸其谈,我们更习惯做成之后再对外宣布。许多人推销未来,但我们不是这样的。在本周的开发者大会上,所有我们所谈到的都是要在今年发布的东西。我们并没有大谈19年、20年甚至21年之后的才做的事,不是因为我们对其一无所知,只是我们不想夸夸其谈罢了。

人们不会想到高度集成化的机器学习,他们甚至无法察觉到它已被应用到苹果产品之中。iPhone 电池续航提升,这是机器学习的功劳。iPhone 中早已蕴含了诸多高科技,不过用户未能察觉。我们从来不觉得消费者会希望我们列出纤细说明“如何在产品中使用机器学习技术,人们并不关心这些。作为科技公司,我们关注产品背后的科技。消费者只关心产品是否好用。

不过,虽然库克认为苹果在 AI 领域并不落后,但是外界的看法短时间内还很难改变,毕竟谷歌、Facebook 等竞争对手的声势太大。

苹果想要在 AI 时代领先,一个技术博客是远远不够的。

参考资料:

http://www.techweb.com.cn/it/2016-08-28/2381291.shtml

http://tech.ifeng.com/a/20170720/44653483_0.shtml

http://finance.ifeng.com/a/20170607/15436278_0.shtml

http://www.guancha.cn/TMT/2017_06_20_414217.shtml

SELECTION 一周精选

7 月份五大令人惊叹的 iOS 库

CocoaChina

全球最大

苹果开发中文社区