2张图片就能「算出」一段视频,Reddit网友都惊呆了 | 旷视&北大出品

鱼羊 萧箫 发自 凹非寺

量子位 报道 | 公众号 QbitAI

只给AI两张图片,就能得到高帧率动态视频?

输入的两张图像,重叠后是这样的:

而算出来的视频,是酱婶的:

不错,这又是视频插帧算法的功劳。

极限操作玩得6,让老电影变丝滑的常规手法,这个名叫RIFE的AI算法同样信手拈来。

右边这支经典探戈,看上去是不是比左边丝滑多了?

不仅是老电影,飞行表演的精彩瞬间,也能一口气从每秒24帧提升到每秒96帧。

动图效果有所损失,不妨再来看一眼原视频。

这项新研究,来自旷视和北大。不仅能让老影像资料追上人民群众对高帧率的需求,支持2X/4X/8X高质量插值,它还有一个最大的特点:快。

量子位在Colab上用T4跑了一遍Demo,一个时长53秒的720p 25fps视频,插值到100fps仅用了2分19秒。

该项目现已开源,并且有官方Demo、第三方Windows应用可以试玩。

看过了RIFE的表现,网友们不由惊叹,这是要超越那只经常在各种修复视频里出现的插帧AI DAIN,引领一波新潮流的节奏啊?

一时之间,RIFE在Reddit上的热度飙升到了2.8k。

那么,这样的效果究竟是怎么实现的呢?

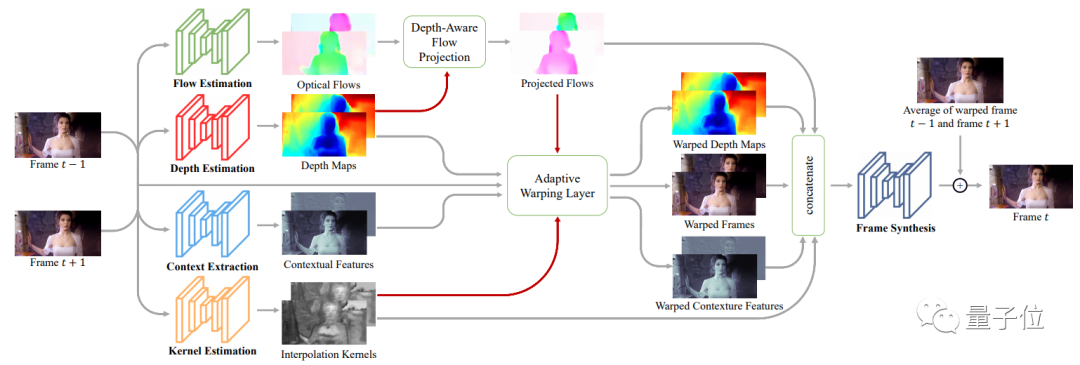

从双向估计,到一步预测中间帧

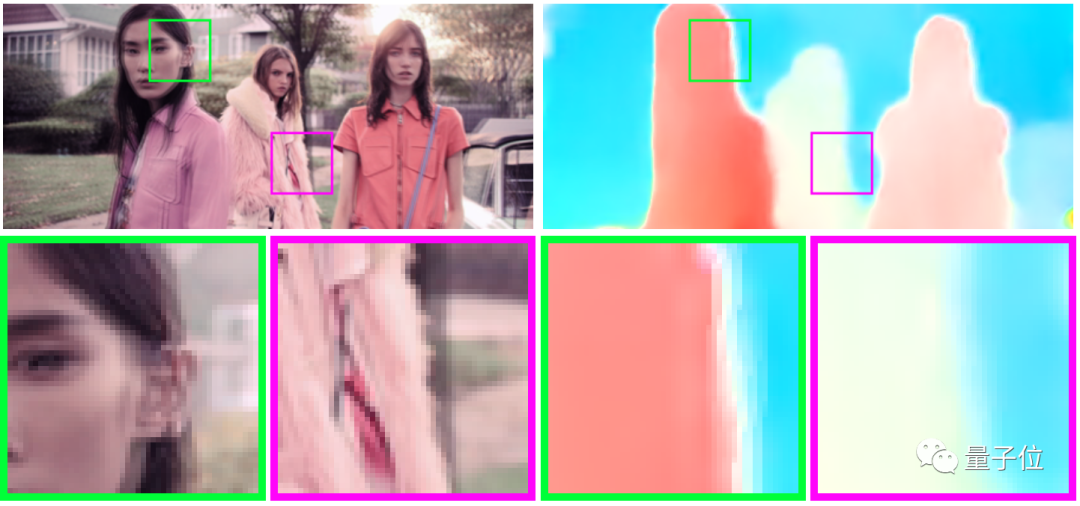

视频插帧,通常是用光流预测算法来预测中间帧,并插入两帧之间。光流,就像光的流动一样,是一种通过颜色来表示图像中目标移动方向的方式。

△稀疏光流与稠密光流

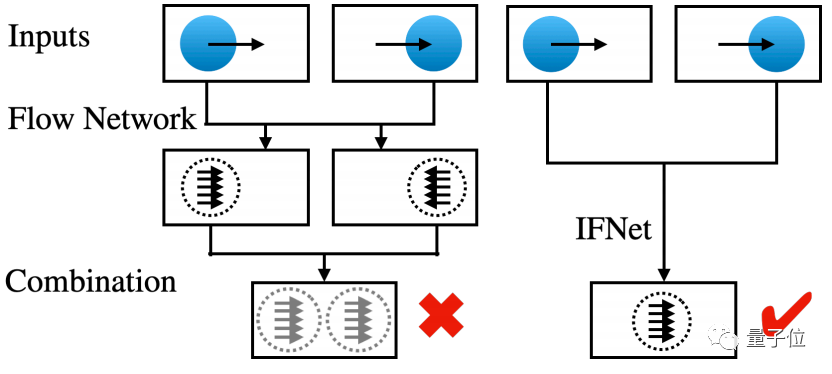

传统光流预测算法,通常根据前后两帧视频来预测中间的某一帧长啥样。

将预测完成的图像插进去后,视频看起来就会变得更丝滑。

以DAIN的算法为例,如果要预测t时刻的帧,就需要t时刻的前后两帧视频,通过光流预测算法来实现。

△DAIN的算法图

但是这一类的算法会产生一个缺点:在预测过程中,如果用前后两帧图像产生双向光流,用线性组合来估计中间流,预测出来的结果,在运动边界区域就会出现伪影。

这样的伪影,使得重建中间帧图像的效果不尽人意。

那么,如果换一种思路,直接先预测中间流呢?

相比于利用前一帧和后一帧进行两次估计,这里的IFNET (a Specialized and Efficient Intermediate Flow Network)算法,将直接采用线性运动假设,对中间帧进行一次估计。

效果也显而易见,相比于利用前后两帧的双向估计所产生的光流,利用IFNET估计出的光流效果非常清晰,而且几乎没有伪影。

利用这种方式重建图像,不仅光流边缘看得清楚,而且速度也更快。

论文提到,RIFE是首个基于光流的实时视频插帧方案。

由于中间帧预测,直接假设了前后两帧的变换是线性的,相当于每帧预测中直接少了一次估计。

那么,这个模型,究竟将插帧算法提升到了怎么样的水平?

运行速度远超其他方法

前文已经提到,RIFE最亮眼的一点是快。

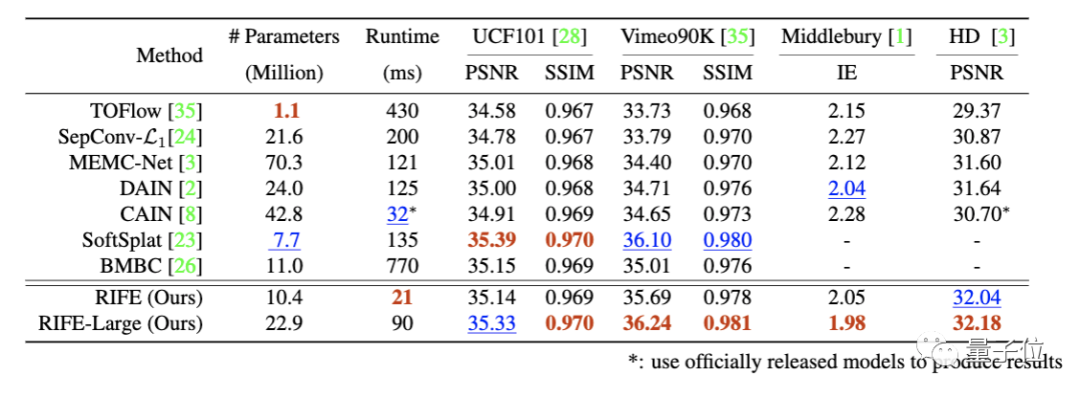

研究人员在UCF101、Vimeo90K、Middlebury OTHER set和HD benchmarks等基准上,将RIFE与英伟达的SoftSplat、上交大的DAIN等「前辈」进行了对比。

用来测试运行时间的是一个640×480的视频,使用的GPU型号是NVIDIA TITAN X(Pascal)。

从结果可以看出,在性能相当的情况下,RIFE基础模型的运行速度超过了所有对比方法。

而模型的大版本RIFE-Large,在性能超越SOTA方法SoftSplat的情况下,运行速度快出了30%。

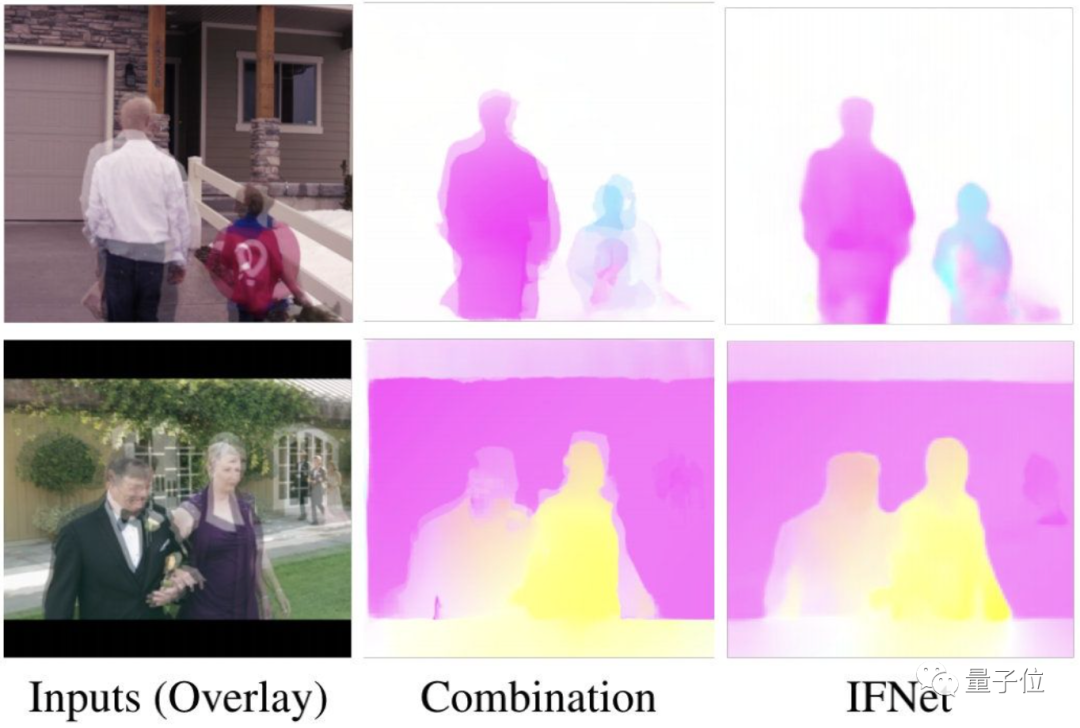

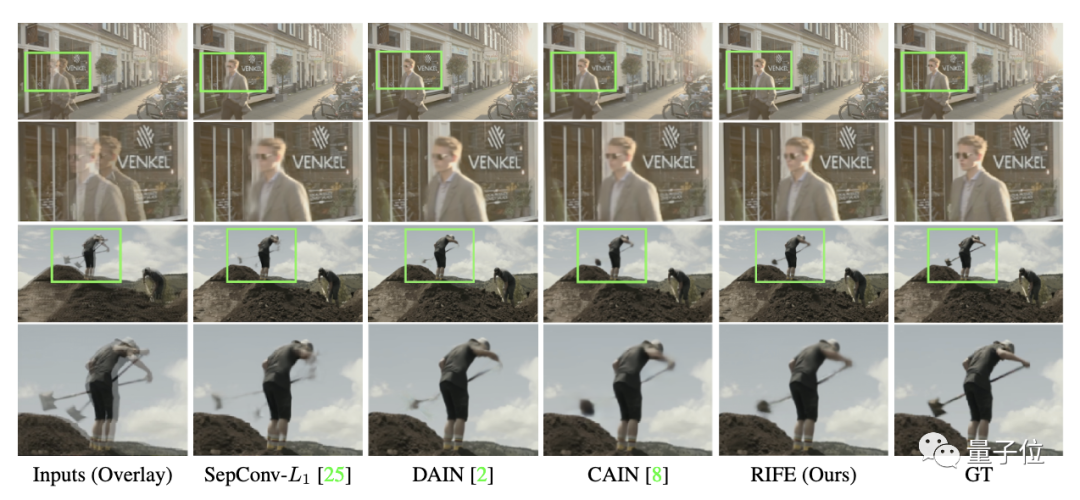

另外,研究人员基于Vimeo90K测试集,提供了可视化的对比结果。

可以看到绿框部分,SepConv-L1和DAIN产生了伪影,而CAIN铲子部分则出现了缺失,相对而言,RIFE生成的结果更为可靠。

安装包和colab都有,试玩无忧

效果这么美丽的模型,应该怎么使用?

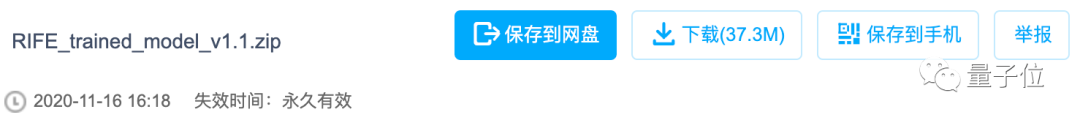

目前作者们已经给出了预训练模型的几种用法,从GitHub项目中可以直接下载网盘版的压缩包。

无论是用作者提供的demo、还是用你自己想要进行插帧的样本,都可以上手试玩。

当然,模型也有colab版本,可以直接在云服务器上玩模型。

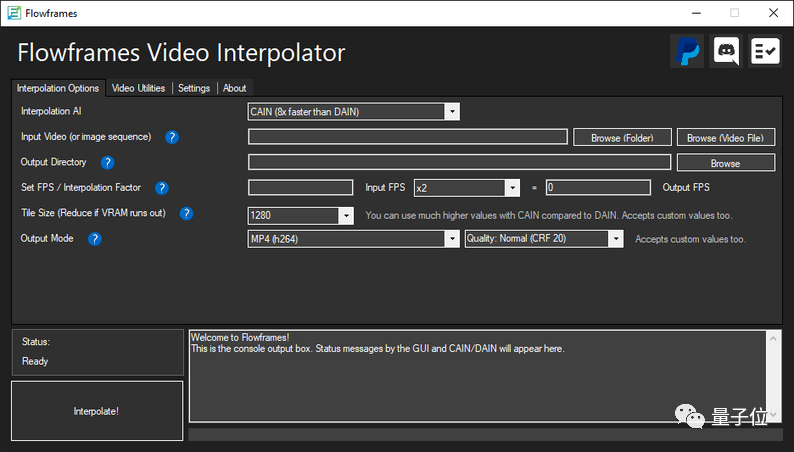

而且,已经有玩家做出了Windows版的软件,可以直接下载下来使用。界面看起来还挺简洁:

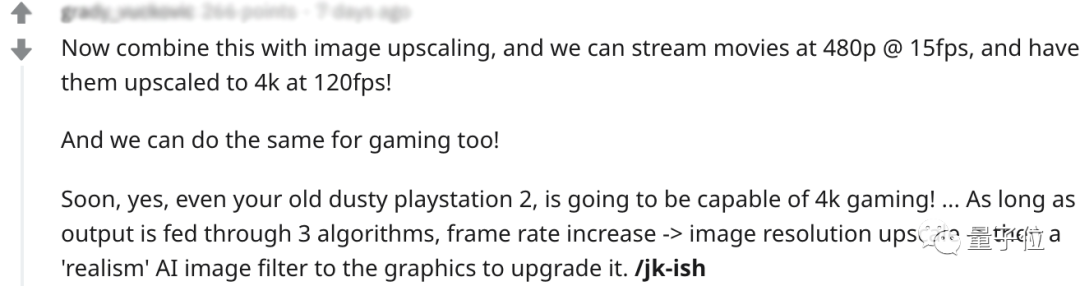

模型RIFE的出现,已经让一些游戏爱好者狂热了起来:

你们能想象吗,就算是已经吃灰很久的PS2,也可以达到4k游戏的水平效果了!利用这种算法,3步就能搞定!

不过,也有网友表示了对这种算法的担忧。

虽然这种算法速度快、性能高,但实际上存在一个问题:

这种算法,本质上无法联想到丢失的帧间信息,所以无法用在安防视频上。

对于这些方面的应用,未来还需要进一步考虑。

作者介绍

黄哲威,论文一作,目前是旷视的一名算法研究员,毕业于北京大学。

进入北大信科一年后,他获得了ICPC区域赛金牌,还成为了旷视科技智能计算组(IC组)的实习生,之后参加了NIPS 2017的Learning to Run比赛,使用Actor-Critic Ensemble算法获得了第二名。此外,在ICCV 2019顶会上,他的论文同样被收录。

张天远,毕业于北京大学,就读期间,论文曾经被ICML 2019、ICCV 2019、NIPS 2019等顶会收录。

衡稳,于北京大学获计算机应用技术硕士学位。

施柏鑫,来自北京大学,目前是北京大学信息科学技术学院的助理教授(博雅青年学者)、研究员、博士生导师。

周舒畅,旷视研究院AI计算组组长,本科毕业于清华电子系,博士毕业于中科院计算所,曾获NeuIPS 2017 Learning to Run Challenge第二名,美国国家标准技术研究所NIST TRAIT 2016 OCR冠军。

项目地址:

https://rife-vfi.github.io/

论文地址:

https://arxiv.org/abs/2011.06294

与DAIN效果对比:

https://www.youtube.com/watch?v=60DX2T3zyVo&feature=youtu.be

参考链接:

https://www.reddit.com/r/linux/comments/jy4jjl/opensourced_realtime_video_frame_interpolation/

https://www.reddit.com/r/MachineLearning/comments/jyvog1/d_better_than_dain_increase_videos_fps_with_rife/

http://hzwer.com/

http://tianyuanzhang.com/

https://eecs.pku.edu.cn/info/1339/9244.htm

https://www.linkedin.com/in/heng-wen-020321a0/

— 完 —

本文系网易新闻•网易号特色内容激励计划签约账号【量子位】原创内容,未经账号授权,禁止随意转载。

量子位年度智能商业大会启幕,大咖已就位!

李开复博士、尹浩院士、清华唐杰教授,以及来自小米、美团、爱奇艺、小冰、亚信、浪潮、容联、澎思、地平线、G7等知名AI大厂的大咖嘉宾齐聚,期待关注AI的朋友报名参会、共探新形势下智能产业发展之路。

滑动查看更多

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~