钢铁侠发飙!马斯克怒怼哈佛大学教授:你对通用人工智能一无所知

来源:新智元(ID:AI_era)编译自Fortune、Wired

如有侵权烦请联系删除

作者:张乾、肖琴

最近,哈佛大学教授Steven Pinker指责马斯克一边高喊人工智能会威胁人类,一边又做自动驾驶,是自相矛盾。马斯克在推特上隔空回应:Pinker并不懂通用人工智能和狭义人工智能的威胁。很多人也存在“非黑即白”的偏见。此外,前谷歌CEO施密特也认为,至少在下一个十年,机器还不可能奴役或消灭人类。

世上并没有那么多非黑即白的事情。

马斯克一边高喊人工智能是人类威胁,一边又在做L5自动驾驶,很多人认为他这种做法表里不一。最近,哈佛大学教授Steven Pinker就是直接跳出来指责马斯克的人。Pinker曾被《时代》列为“当前100位最有影响力的人”之一,声誉显赫。

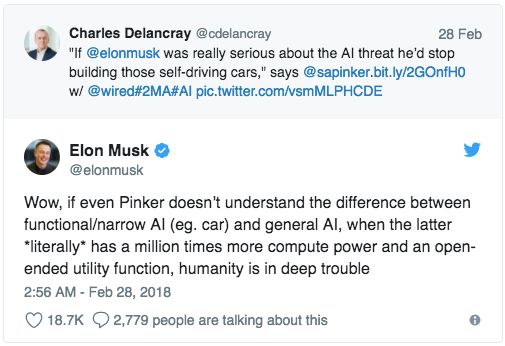

不过,“钢铁侠”马斯克也不是吃素的,他在推特下留言说:如果连Pinker都不清楚功能性/狭义人工智能(例如自动驾驶汽车)和通用人工智能之间的区别……人类就有大麻烦了。”

马斯克怒怼哈佛教授:不懂人工智能

“如果伊隆·马斯克真的认真对待人工智能的威胁,他会停止制造这些自动驾驶汽车,这是我们将要看到的第一种先进的人工智能。”Pinker在上个月24日的Wired杂志上称。目前,特斯拉汽车号称已经支持L5完全无人驾驶,但相关软件还未升级。

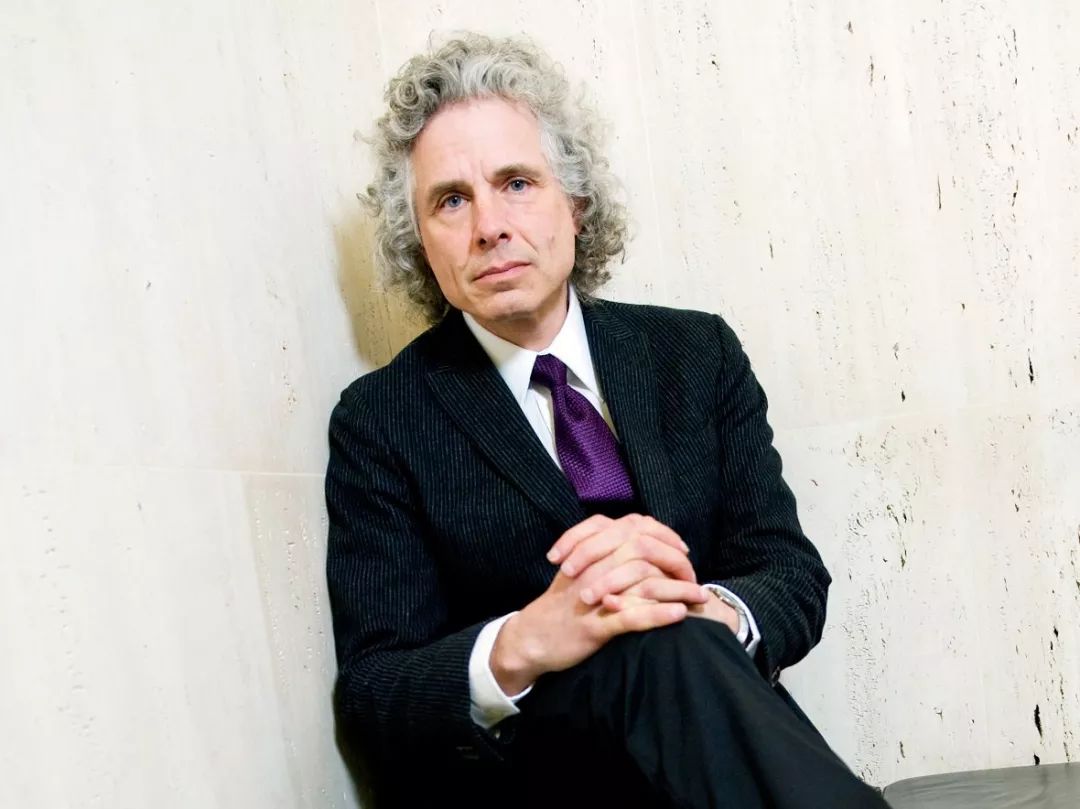

Steven Pinker

Pinker是哈佛大学教授,也是美国国家科学院院士,并两次入围普利策奖,获得9个名誉博士学位,被《时代》列为“当前100位最有影响力的人”之一。此外,在Wired杂志上,他还认为高度发达的外星文明倾向于和平与宽容,因此先进的外星人更可能是友好的。

Pinker半个月前说的这些话在当时并没有引起太多关注,但看热闹的不嫌事儿大,有好事的推特网友转发Pinker评价马斯克的上述言论,并手动@马斯克,一下子就引起了“钢铁侠”的注意。

“哇,如果连Pinker都不清楚功能性/狭义人工智能(例如自动驾驶汽车)和通用人工智能之间的区别,当后者拥有100万倍于计算机的处理能力时候,人类就有大麻烦了。”

很明显,马斯克认为Pinker这样声誉显赫的学者是不懂人工智能的,“非黑即白”的问题出现在了这名大教授身上。

开发自动驾驶可能会对开发通用人工智能做出一些贡献,这肯定会引发关于我们如何培训机器的道德问题。但是,正如马斯克所指出的那样,即使是完全完美的自动驾驶汽车,也不会出现边缘化或伤害人类的“想法”。

马斯克“非黑即白”的烦恼:自动驾驶不是通用人工智能

上个月,马斯克退出了他亲手创办OpenAI董事会。

OpenAI是一家非盈利的、用开放的方法研究通用人工智能、防止AI被大公司垄断的研究机构,马斯克是OpenAI最大的投资人之一。

官方宣称,马斯克的退出是为了避免OpenAI将来与特斯拉可能发生的利益冲突。消息一出,很多人认为马斯克不再觉得人工智能是人类的威胁,并全力推进特斯拉的L5。

而此次马斯克怒怼哈佛大学教授Pinker,也可以看做是对这种“非黑即白”的看法进行回应。实际上,马斯克并没有完全与OpenAI做切割,他仍然是OpenAI的捐赠者,并将继续为该团队提供建议。

此外,马斯克曾频繁警告人工智能的危险已经触及到它们可能用于控制武器或操纵信息来引发全球性冲突。物理学家霍金以及比尔·盖茨也以类似的方式警告说,AI在超过我们的生物智能时可以“取代”人类。

但这些担忧是关于所谓的“通用”人工智能(AGI),即系统能够复制所有人类决策。但像特斯拉的Autopilot、AlphaGo和Facebook的新闻推送算法等系统是马斯克口中的功能性/狭义人工智能,两者完全不同的,狭义的AI系统旨在处理一项离散任务。

人工智能多久“统治”人类?谷歌前CEO:起码还有一二十年的时间

虽然狭义人工智能并不会给人类造成威胁,但马斯克等人对通用人工智能的担忧并非杞人忧天,可至于多少年之后通用人工智能会成为人类的威胁,现在还没有准确的说法。

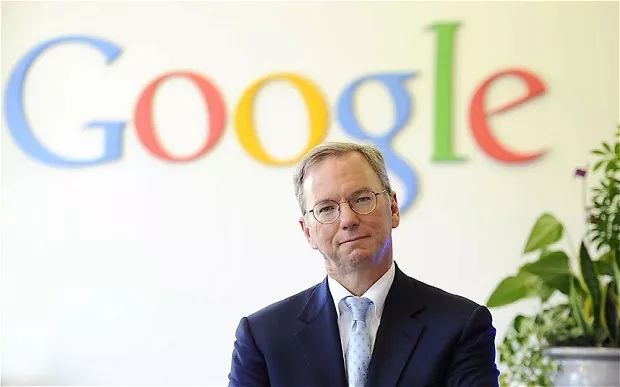

日前,谷歌前CEO Eric Schmidt在慕尼黑安全会议上发言时称,至少在下一个十年,机器人还不可能奴役或消灭人类。他说:

“每个人都喜欢谈论电影风格的世界末日场景,但我可以很自信地预测,这样的场景距离我们起码还有一二十年的时间。所以我们可以担忧,但那是很久以后的事情。”

谷歌前CEO Eric Schmidt

Schmidt的话并没有十分令人欣慰。

近年来,人工智能和机器人技术的飞速发展已经扩大了讨论的范围。整整一代人都是在科幻电影中长大的,电影描绘的是机器人的起义,几乎可以肯定的是,当我们想到机器人的未来时,这些场景正是我们想象的场景。

这样想当然是合理的,但不太可能。Schmidt接着说:

“另外一点,我想提醒大家,这些技术本身存在着严重的错误,它们不应该被用于生命攸关的决策。所以我不想坐在一架由电脑负责有关飞行的一切决策的飞机上。这项技术还不够可靠——在使用上存在太多错误。它可以建议,它使你更聪明等等,但我不会让它负责指挥和控制。”

最后一句话是关键。

研究者很清楚(尽管大多数普通人不这样认为),AI并不适合取代人类,因为它是为了增强人类的。人类的大脑很复杂。虽然普遍来说,40岁的人无法记住维基百科,也不能打败最厉害的扑克玩家,但典型的机器人并不能处理人类擅长的简单的即兴创作。

但事实上,AI和机器人擅长的大部分工作都是不需要技巧的工作,既简单而可重复的目标,这些目标都很容易定义和测量。机器人并不擅长即兴创作; 他们需要一套明确的规则,这些规则将越来越需要包含故障安全措施,以在发生故障时关闭机器。

尽管这些技术将会继续得到改进,但感知还不会出现。如果一个机器人要编程危险的机器人,它必须被编程为危险的。所以我们不是应该担心机器人,而是应该担心负责写代码的人。