近年来,深度学习的快速发展显著提升了生成式人工智能在文本、图像和音频领域的能力。然而,如何对这些生成内容的质量进行自动化评估仍是一个持续存在的挑战。尽管已有大量自动评估方法被提出,当前的研究仍缺乏一个系统性的框架,能够在文本、视觉和音频三种模态中全面整理这些方法。 为了解决这一问题,本文对三种模态下的生成内容自动评估方法进行了全面综述,并提出了统一的分类体系。我们识别出五种基本范式,这些范式构成了现有评估方法的核心特征。分析首先从文本生成评估方法入手,该领域的技术最为成熟。随后,我们将这一框架扩展至图像与音频生成领域,展示其广泛的适用性。最后,我们讨论了跨模态评估方法未来的发展方向,指出了值得深入探索的研究前景。

1 引言

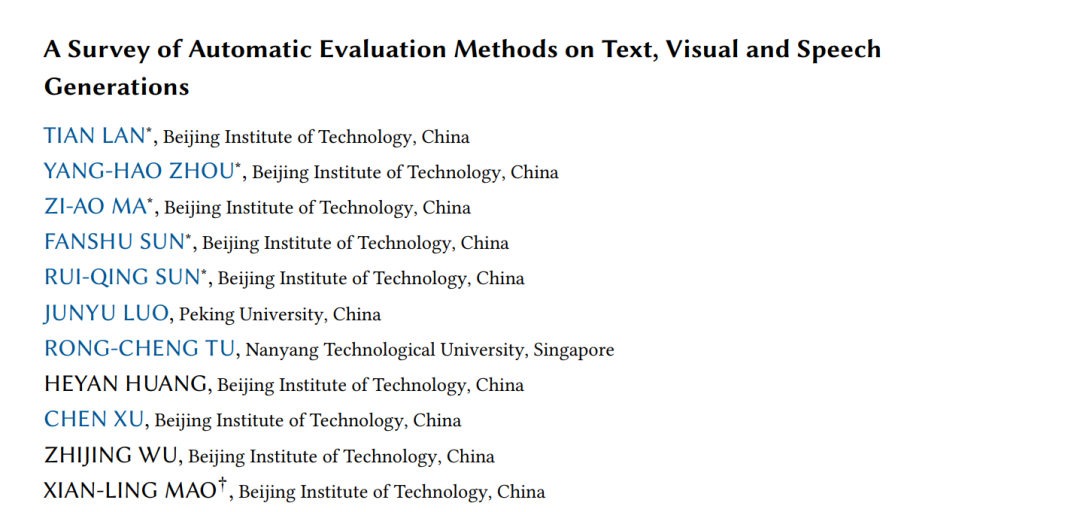

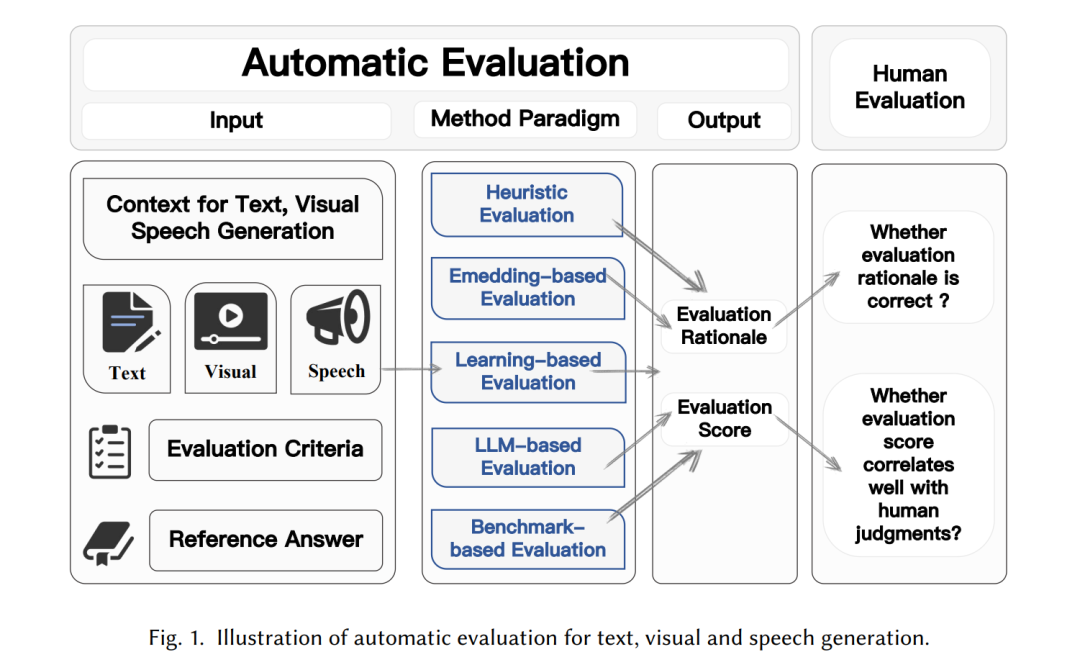

近年来,深度学习技术取得了显著进展,推动了各类生成模型在多个领域与任务中的快速发展【227, 277, 317, 377, 381, 479】。大型语言模型(LLMs),如 GPT-4 和 Claude,现已能够生成近似人类水平的对话【277】;扩散模型【105, 295, 317, 355–357】,如 DALL·E 和 Stable Diffusion【317】,则彻底革新了图像与视频的合成方式。这一快速发展带来了一个关键的研究问题:如何实现对模型生成内容的可靠且准确的自动化评估? 尽管人工评估仍是衡量生成内容质量的黄金标准,但其高昂的成本和不可重复性限制了在大规模应用中的可扩展性【167, 170】。因此,研究者纷纷致力于开发能够与人类评判高度相关的自动评估指标【180, 194】。如图 1 所示,自动化评估旨在根据特定的评估标准、参考答案与上下文,利用合适的评估方法对模型生成内容的质量进行判断。 尽管已有不少进展,目前该领域仍缺乏一个系统性综述,能够全面覆盖不同任务和模态下自动评估方法的发展现状。为填补这一空白,本文对文本、视觉与语音模态下的自动评估方法进行了全面回顾,并提出了统一的分类体系,以期为该快速演化的研究方向提供深入洞见。 我们首先对自然语言生成(NLG)领域中的自动评估技术进行了深入分析,该领域已取得最显著的进展【180, 194, 370】。具体而言,我们详细描述并剖析了已有自动评估方法的特征,并对这些方法进行了系统的元评估。在此基础上,我们将综述范围扩展至另外两个重要的生成式人工智能任务:视觉生成与音频生成。对于每个模态,我们总结了当前自动评估方法的发展现状,并探讨了未来值得关注的研究方向。 与相关综述的区别:现有关于自动评估技术的综述大多集中于自然语言生成任务中的某些特定方法,例如基于大型语言模型的评估方法【180, 194, 370】。相比之下,本文工作提供了一个覆盖文本、视觉与语音三大关键模态的统一评估框架。我们系统梳理了评估方法从传统启发式指标到现代基于大型语言模型的技术的演变路径。这一跨模态视角,有助于更全面地理解生成式 AI 系统中的评估方法体系。 在本节中,我们对自然语言生成(Neural Language Generation, NLG)任务的自动评估技术进展进行了全面回顾,涵盖开放式文本生成、摘要生成、机器翻译等任务。如图 2 所示,我们提出了一个系统的自动评估方法分类体系,NLG 任务的评估方法大致可归为五大类: 1. 启发式评估(Heuristic Evaluation):通过自然语言中的规则或启发式特征进行评估,例如基于词重叠的指标或生成概率。 1. 嵌入表示评估(Embedding-based Evaluation):通过计算参考文本与生成文本之间的语义相似度来进行评估【485】。 1. 学习式评估(Learning-based Evaluation):使用带有人工标注的数据训练神经网络模型,以自动判断文本质量。 1. 基于大语言模型的评估(LLM-based Evaluation):利用大型语言模型(LLMs)通过精心设计的提示词与链式思维推理(Chain-of-Thought)进行评估,该方法也被称为“LLM-as-a-judge”【180】。 1. 基准测试评估(Benchmark-based Evaluation):使用人工标注的基准数据集对模型在特定能力(如数学推理、代码生成等)上的表现进行测试。

接下来的各小节将对上述每一类评估方法及其代表性研究工作进行详细探讨。最后,在第 3.5 节中,我们将对这些自动评估范式的特征进行系统性比较与分析。

视觉生成的自动评估方法

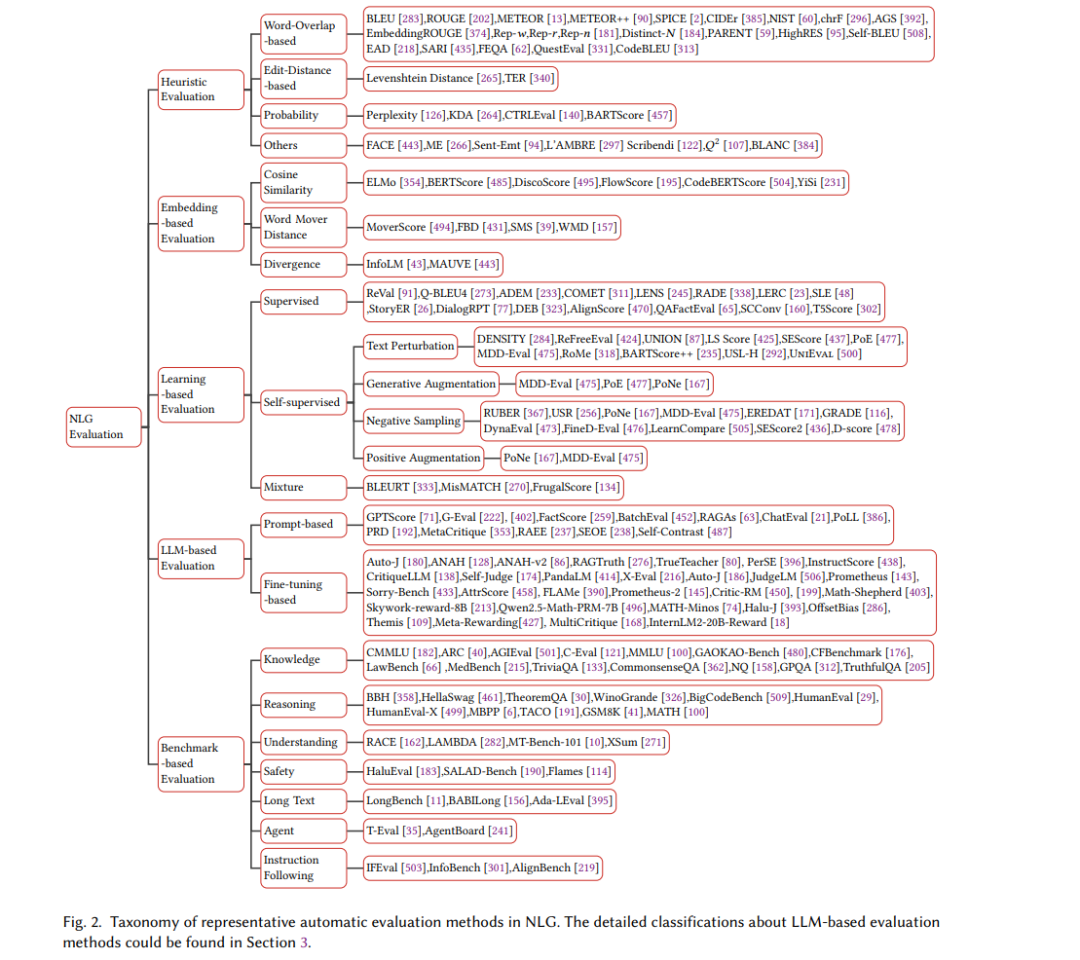

在前文中,我们已系统性地回顾了文本生成任务的自动评估方法。在此基础上,我们将评估方法的分类体系扩展到视觉生成任务,如文本到图像(text-to-image)和文本到视频(text-to-video)等内容生成任务。 如图 3 所示,现有的视觉生成自动评估方法主要沿着以下五种范式展开: 1. 启发式评估(Heuristic Evaluation):依赖人工设计的规则或特征(例如像素级差异),用于度量视觉内容的某些基础质量属性。 1. 嵌入表示评估(Embedding-based Evaluation):利用深度神经网络学习到的视觉特征嵌入,评估生成内容与参考内容之间的感知或语义相似度。 1. 学习式评估(Learning-based Evaluation):训练模型来预测人工标注的质量得分,使评估指标的输出更贴近人类主观判断。 1. 基于大语言/多模态语言模型的评估(LLM/MLLM-based Evaluation):借助大型语言模型(LLM)或多模态语言模型(MLLM),结合特定的提示词,对生成视觉内容在多个维度上进行细粒度的评估。 1. 基准测试评估(Benchmark Evaluation):使用精心构建的数据集与黄金参考标准,对系统输出进行直接比较,以评估其在标准任务上的性能表现。

在介绍上述各类评估方法及代表性工作之后,我们将进一步介绍当前最常用的视觉内容评估基准套件(第 4.1 至 4.6 节)。最后,在第 4.7 节中,我们将讨论当前面临的主要挑战,并提出未来研究的潜在方向。

音频与语音生成的自动评估方法

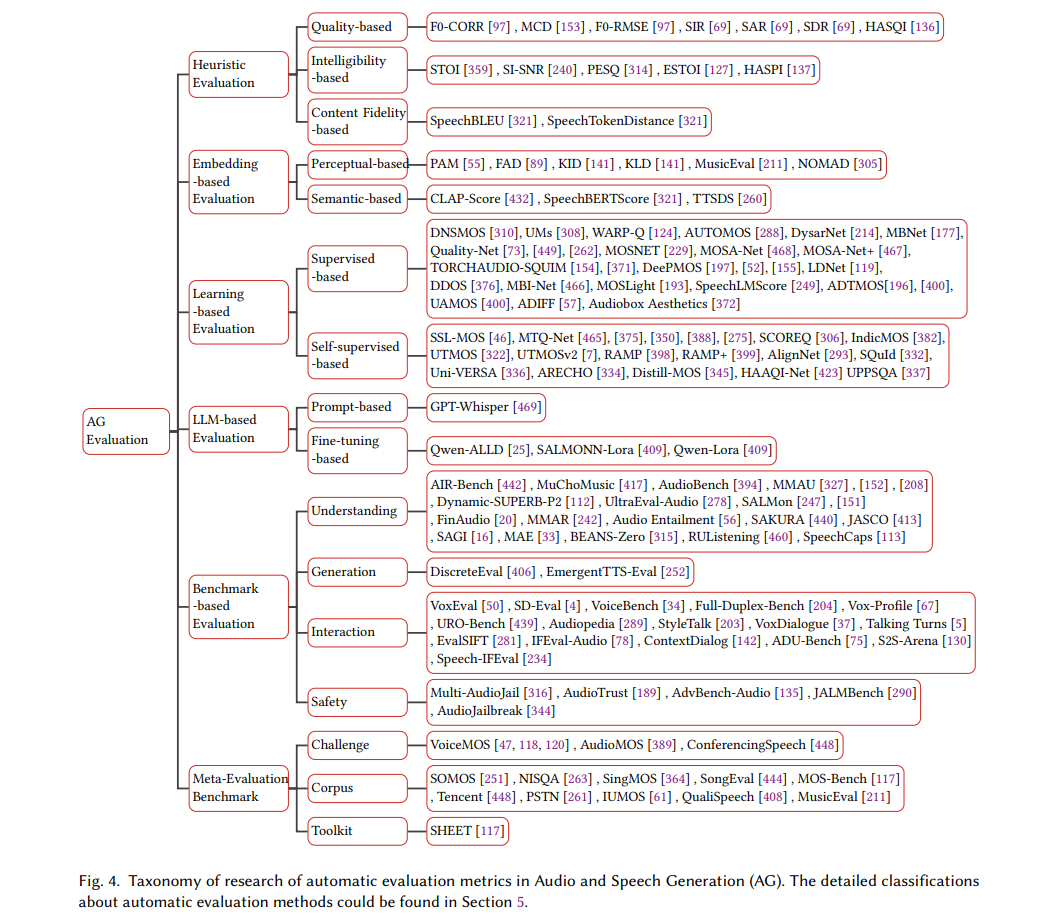

本节将回顾音频与语音生成任务中的自动评估方法的发展,包括文本转语音(TTS)、声音转换(VC)、文本转音频生成(TTA)以及生成式音频语言模型(ALMs)。随着这些系统生成能力的不断增强,相应的评估技术也在持续演进。正如图 4 所示,音频与语音生成的自动评估方法可归纳为以下五种范式: 1. 启发式评估(Heuristic Evaluation)

早期方法依赖基于规则的简单指标,如信噪比(SNR)、对数频谱距离(Log-Spectral Distance)以及韵律统计特征,用于衡量失真程度或保真度。这类方法计算成本较低,但在复杂韵律或说话人敏感的场景中,通常与人类感知的主观判断存在较大偏差。 1. 嵌入表示评估(Embedding-based Evaluation)

随着自监督学习的发展,评估方法开始利用从模型(如 Wav2vec【9, 329】、HuBERT【108】、VGGish【101】)中学到的音频表示,用以衡量声学相似性、说话人特征与时间动态等维度。这类嵌入能捕捉音频信号中的细粒度特征,比手工指标在感知相关性上更具优势。 1. 学习式评估(Learning-based Evaluation)

这类方法依赖于监督或自监督模型,通常以语音、通用音频或音乐数据为基础,结合人工标注或自动生成的质量评分进行训练。以语音生成为例,这类模型旨在模拟通用或专家级主观评估指标,如主观评分均值(MOS),从而自动预测诸如自然度、可懂度等关键感知属性。 在更广义的音频生成任务中,此类方法常基于配有质量标签的数据集进行神经网络训练,这些标签可能来源于人工标注,或借助大语言模型增强。例如,ADIFF【57】通过引入大语言模型生成的标签增强机制,提升了训练数据的多样性与表达力。尽管这些方法利用了大型模型优化标注过程,其核心仍基于监督学习,因此归入“学习式评估”范式。 1. 基于大语言模型/音频语言模型的评估(LLM/ALM-based Evaluation)

大语言模型(LLM)与音频语言模型(ALM)的发展,使得音频与语音生成的评估更具整体性。这些模型不仅能输出与 MOS 等效的评分,还可基于音频特性与语义内容提供解释性反馈与描述性评估。训练于大规模音频-文本语料库的 ALMs 在泛化能力上表现突出,通过在评估数据集上微调,其评估效果还能进一步增强。由于它们能够对语音与文本之间的多模态表示进行对齐,因此在可解释性与全面性上具有显著优势。这一范式标志着评估方法从传统学习范式向新一代 LLM/ALM 驱动的自动评估方法的转变。我们在第 5.7 节将对学习式与 LLM/ALM 式方法进行系统对比,聚焦评估效果与泛化能力。 1. 基准测试评估(Benchmark-based Evaluation)

为支持系统级的标准化对比,近年来涌现出若干用于 ALMs 与 MLLMs 的基准评估套件。这些基准旨在系统评估模型在语音、音频与音乐模态下的多维能力,包括理解、交互、推理与生成。 与文本到图像、文本到视频生成中的成熟基准相比,TTS、音频或音乐生成的评估协议仍相对欠缺。尽管诸如 LibriSpeech【280】、LibriTTS【462】等高质量数据集广泛用于语音生成模型的训练,并且如 TTS-Arena【268】提供了基于人机交互评分的排行榜机制,Seed-TTS【1】则构建了标准化、可靠的测试集,但它们尚未构成我们定义下的“通用、自动化、可扩展”的 ALM 多任务评估基准。 鉴于此,我们认为,构建一个统一、可扩展的语音与音频生成评估框架,尤其是在 ALM 级别,是一个重要而仍未被充分探索的研究方向。在这一背景下,我们将“基准测试评估”定义为:通过一组标准化任务自动评估 ALM 在语音与音频相关场景中的多模态能力(如理解、交互、推理与生成)。值得注意的是,最新的基准测试评估往往采用由语音/音频生成模型所生成的内容作为输入,来测试 ALM/MLLM 的理解与推理能力。虽然这些基准最初并非为生成评估而设计,但它们在评估语义一致性、事实对齐与音频文本匹配等方面提供了有价值的信号,对模型性能的诊断与优化具有重要意义。因此,这些新兴基准构成了我们所定义的 ALM 基准评估体系的核心基础。