摘要——深度学习已成为现代人工智能的基石,推动着众多领域的变革性应用。作为深度学习的核心要素,训练数据的质量与安全性深刻影响着模型的性能与可靠性。然而在训练过程中,深度学习模型面临着数据投毒这一重大威胁——攻击者通过注入恶意篡改的训练数据,导致模型精度下降或行为异常。尽管现有综述对数据投毒问题提供了宝贵见解,但大多采取宽泛视角统览攻防技术,缺乏针对深度学习场景下投毒攻击的专项深入分析。本文填补了这一空白,系统性地综述了深度学习中的数据投毒研究:首先从多维度对投毒攻击进行分类,深入剖析其技术特征与设计原理;其次将讨论延伸至**大语言模型(LLMs)**这一新兴领域的数据投毒问题;最后探讨了该领域的关键开放挑战,并提出推动学科发展的潜在研究方向。为促进后续探索,我们在https://github.com/Pinlong-Zhao/Data-Poisoning 维护了深度学习数据投毒研究的最新资源库。

关键词——数据投毒,深度学习,人工智能安全

https://arxiv.org/pdf/2503.22759

一、引言

过去十年间,机器学习(尤其是深度学习)在人工智能(AI)领域取得了显著进展,推动着各行各业乃至整个社会的变革性发展[1]。从图像识别[2][3]、语音处理[4][5]到自然语言理解[6][8],深度学习模型在众多应用中实现了突破性成功,大幅提升了智能系统的自动化水平与精确度。值得注意的是,**大语言模型(LLMs)的最新进展展现出卓越的学习与推理能力[9][13],推动AI向更高智能层级迈进,甚至被视为实现通用人工智能(AGI)**的潜在关键。这些进步主要得益于强大算力的支持与多样化、大规模训练数据的结合,二者共同构成了现代人工智能快速发展的基石。

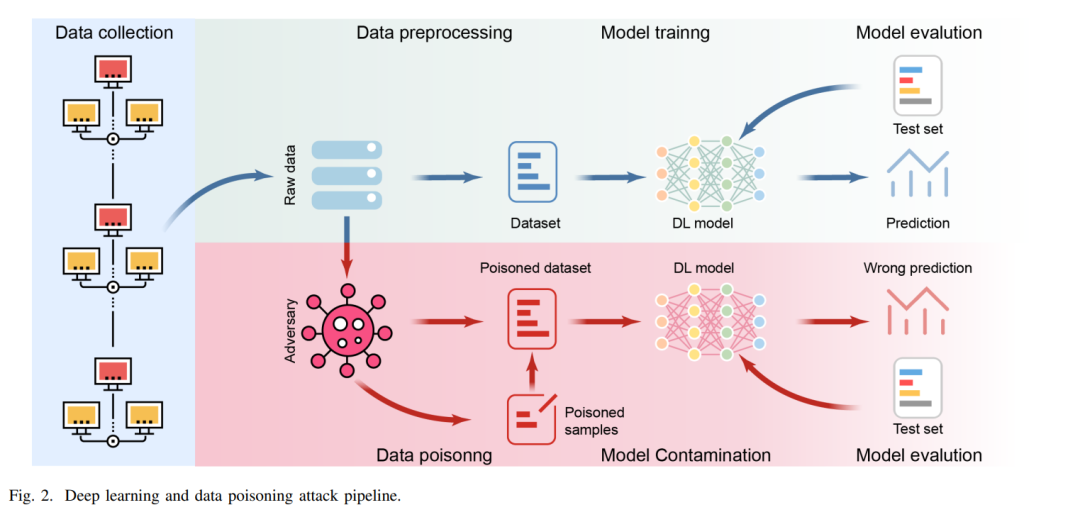

然而,随着AI系统在医疗、金融、交通等关键领域的广泛应用,其安全性与可靠性问题日益引发关注。AI模型的性能高度依赖于训练数据质量及对扰动的鲁棒性,但这一依赖性也使其暴露于多种安全威胁之下。攻击者可通过精心设计的策略破坏AI系统正常运行,导致关键任务中的错误决策甚至灾难性故障。其中,对抗攻击被公认为当前AI面临的最严峻风险之一——通过操纵输入数据或利用模型漏洞,此类攻击可直接损害模型性能,对AI应用的安全可靠构成严重威胁。

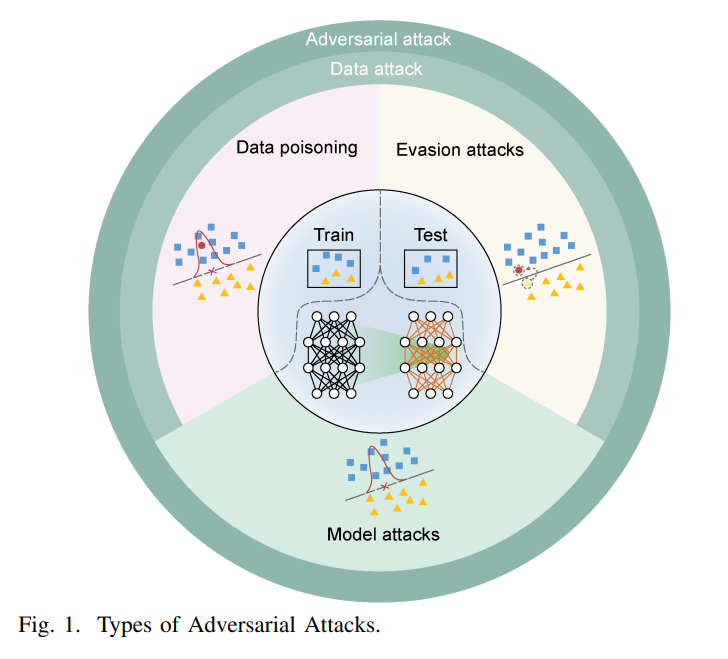

根据方法论差异,对抗攻击可分为以下几类(如图1所示): * 模型攻击[14][15]:通过篡改模型参数、结构或植入隐藏功能破坏模型完整性; * 规避攻击(亦称对抗样本)[16][18]:在测试阶段构造误导性样本干扰预测; * 数据投毒攻击(或称投毒攻击)[19][21]:在训练阶段向数据中注入恶意样本,从根本上降低模型性能或改变其行为。

相较而言,数据投毒攻击因发生于训练阶段而更具隐蔽性与破坏性。近年来,关于数据投毒攻击的综述研究逐渐增多[22][25],但现有工作多采用广义视角,涵盖传统机器学习与深度学习中的各类对抗攻防技术,缺乏针对深度学习模型投毒攻击的专项深入分析。尤其随着LLMs在关键应用中的广泛部署,其多阶段训练流程(预训练、微调、偏好对齐等[35])引入的潜在攻击面使得投毒风险尤为突出[34],但相关系统性研究仍显不足。 为此,本综述聚焦深度学习中的数据投毒攻击,旨在构建全面且结构化的分析框架: 1. 系统性梳理现有投毒方法,从多维度进行分类并剖析算法设计原理; 1. 首次系统探讨LLMs中的数据投毒问题,分析其多阶段训练范式下的独特攻击路径; 1. 为保持分析深度与专注性,本文暂不涵盖防御技术,但通过对攻击方法的系统整合,可为未来防御研究提供基础。

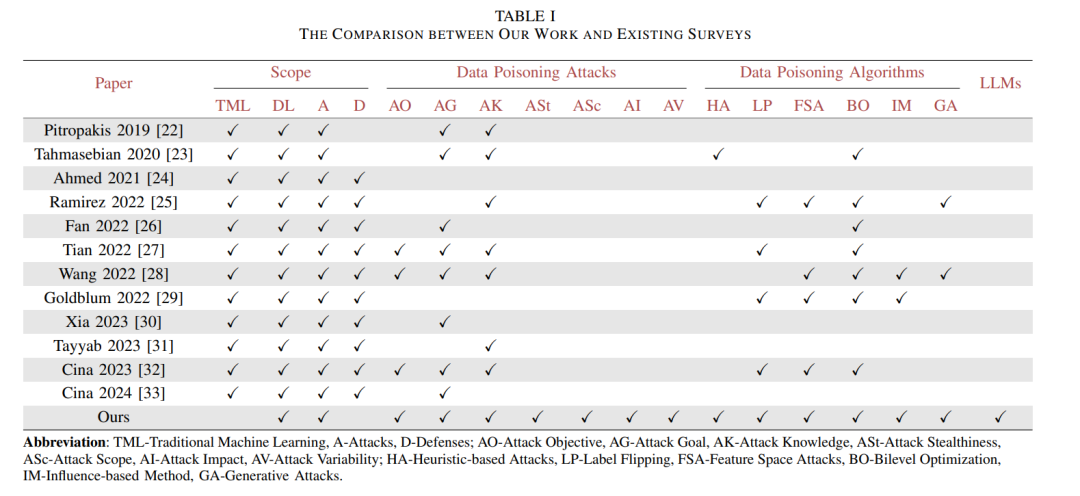

表I通过关键维度对比凸显了本工作的独特性:现有综述虽覆盖广泛的对抗攻防主题,但缺乏对投毒技术的细粒度分类,亦未涉及LLMs投毒;而本文不仅提出投毒攻击与算法的深度分类体系,更将讨论延伸至LLMs这一新兴领域。

主要贡献

全面认知框架:深入解析深度学习数据投毒的机制、影响与挑战,通过专注攻击策略分析间接支撑鲁棒防御机制开发; 1. 投毒攻击分类学:构建双维度系统分类——基于攻击特性的概念维度与基于算法原理的技术维度,为研究者提供结构化指南; 1. LLMs投毒首探:首次系统审视LLMs各训练阶段(预训练、微调等)的投毒漏洞,填补当前文献空白; 1. 未来研究方向:提出增强攻击隐蔽性、探索联邦学习/持续学习等动态环境中的漏洞、拓展多模态AI系统研究等前瞻路径,并强调标准化评估框架的必要性; 1. 开源资源库:维护开放资源库(https://github.com/Pinlong-Zhao/Data-Poisoning),集成论文、数据集与代码链接,持续更新以供追踪前沿进展。

全文结构

第二节:数据投毒基础概念; * 第三节:投毒攻击分类学; * 第四节:基于算法原理的投毒技术分类; * 第五节:LLMs投毒专题; * 第六节:未来研究方向; * 第七节:总结。