分布转移仍然是成功和可靠部署机器学习(ML)系统的重大障碍。只有理解基准测试根本无法捕捉所有可能发生的变化,才能长期解决这些漏洞;同样重要的是,通过仔细实验AI系统以理解它们在实际转移中的失败情况。本论文描述了我在建立可信和可靠的机器学习基础方面的工作。调查的工作大致分为三个主要类别:(i)设计现实世界分布转移结构的正式、实用的特征描述;(ii)利用这种结构开发在处理此类转移时具有证明正确性和高效性的学习算法;以及(iii)实验现代ML系统,以理解现实世界中重尾分布和分布转移的实际影响,包括平均和最坏情况。

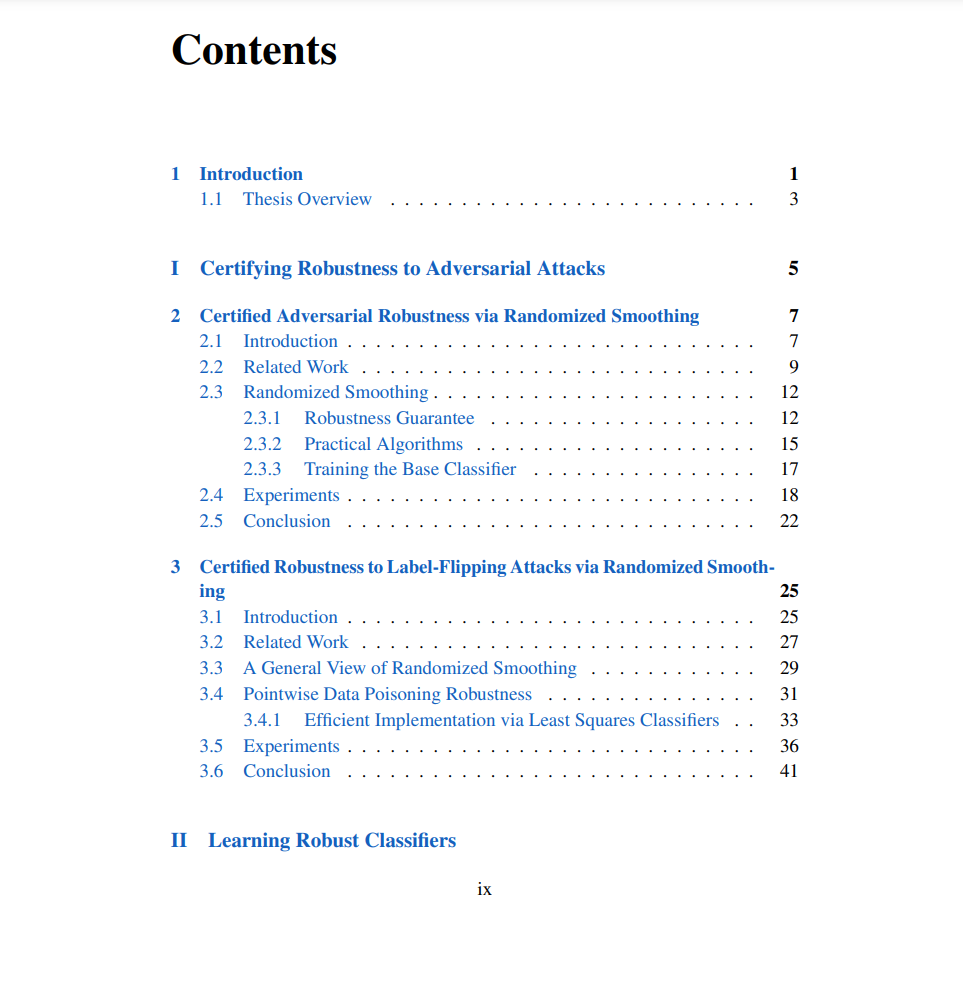

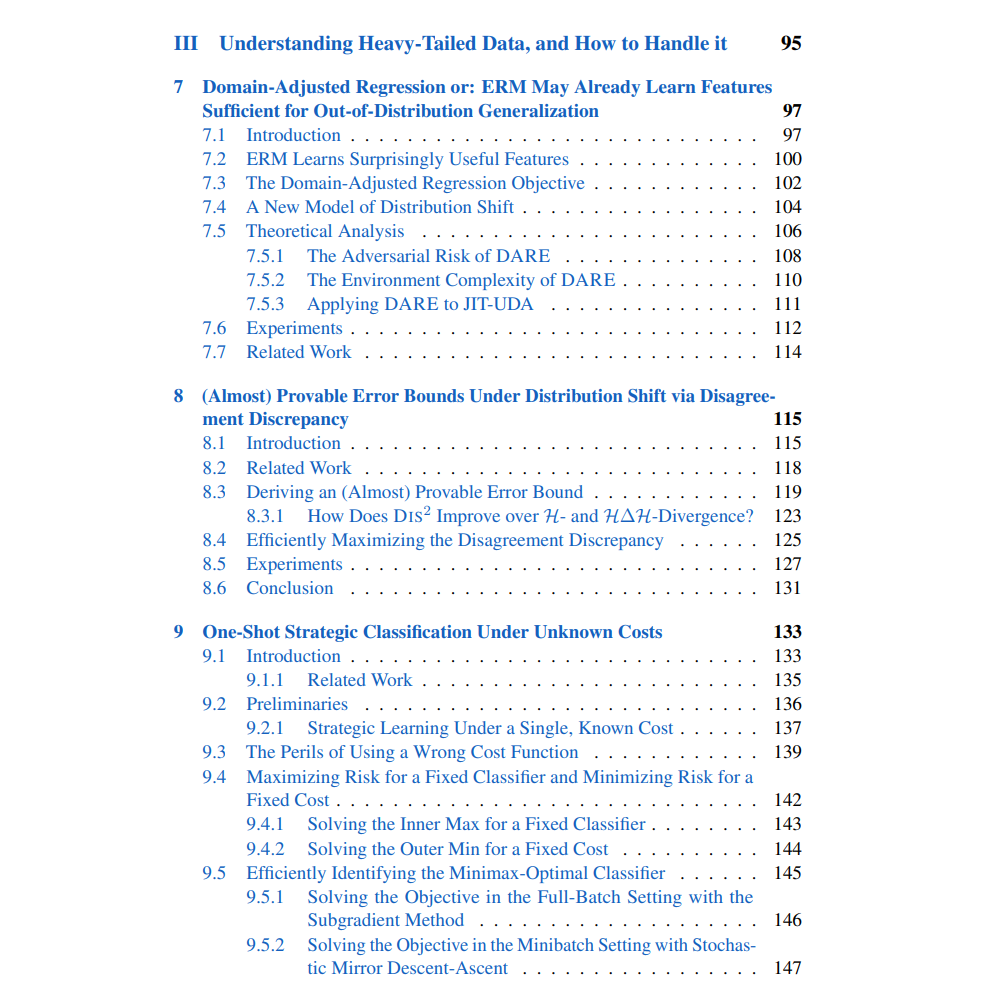

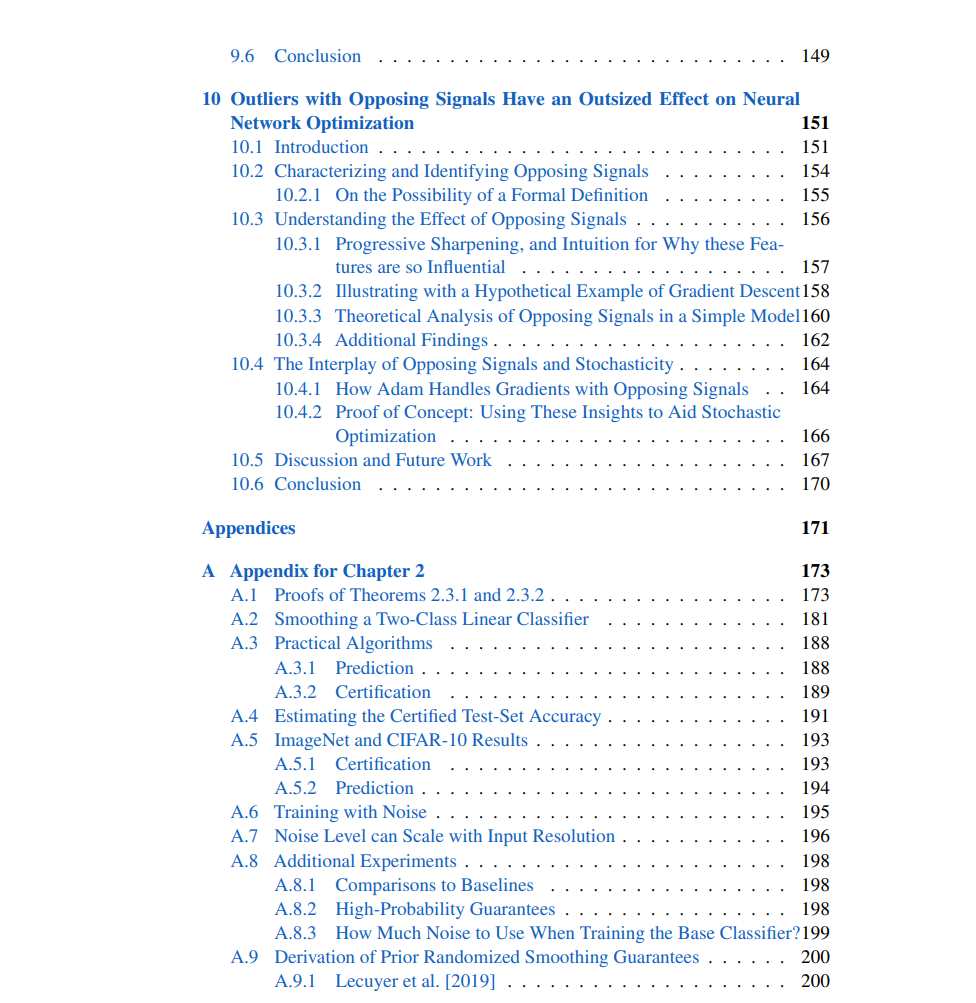

第一部分描述了对深度神经网络的对抗性攻击进行大规模认证的工作。所提出的方法可用于认证对测试样本、训练数据或更一般地任何影响模型最终预测的输入的攻击的鲁棒性。在第二部分中,我们重点关注转移的潜变量模型,借鉴了因果关系和其他现实世界变化的结构编码概念。我们展示了这些模型如何通过环境/干预复杂性这一新的视角对使用多个分布进行鲁棒深度学习的方法进行正式分析。环境/干预复杂性是域泛化和因果表示学习的核心统计度量,量化了误差和/或结构可辨识性条件作为可用训练分布的数量和多样性的函数。最后,在第三部分中,我们广泛探索了更好地理解和利用自然数据变化的方法,并展示了由此得出的见解如何促进新方法的设计,使其在现实世界中表现得更加鲁棒和可靠。

预测算法的评估标准及其价值在于其对未见测试数据的表现。在传统机器学习(ML)中,通常假设这些数据是相互独立且来自与训练数据相同的分布(这被称为IID假设)。然而,在现实世界中,这种条件几乎从未满足。IID假设作为一种有价值的抽象,为研究如何高效和可靠地从数据中学习提供了便利。但统计学家早已明白,这一假设是一种过度简化,现实世界数据的底层分布不断发生变化:例如时间上的变化、异质子群间的变化、由过去行为引发的变化等。由于现实与理想化的IID数据假设之间的这种差异,尽管一些算法在分布内的泛化能力很强,如经验风险最小化(Vapnik, 1999),但它们在现实世界中经常会在没有预警的情况下以高置信度失败。

尤其是,尽管现代深度神经网络在许多任务上表现出超人水平,但越来越多的证据表明,它们的惊人泛化能力主要限于测试数据与训练数据非常相似的情况下。特别是,这些模型似乎依赖于数据的统计信息表示,这些表示远远超越了简单的记忆训练数据,但通常无法让它们泛化到新领域或任务。这种情况甚至在对于人类来说几乎没有困难的表面上微不足道的分布转移中也会出现(Beery et al., 2018;Geirhos et al., 2018)。因此,现代最先进的生成和判别深度网络在部署时非常脆弱,在遇到微小的分布转移时容易出错(Su et al., 2019;Recht et al., 2019)。

在考虑如何解决这一弱点时,很容易想象那些促成深度学习实践成功的方法最终也会解决这个问题。过去十年ML研究的主要推动力是“基准方法”:通过在一系列代表性基准数据集上进行一致的、渐进的改进来推进一个或多个任务。尽管这种策略的成功是不可否认的,但显然它不足以实现真正鲁棒和可靠的ML未来。人工智能(AI)正在迅速应用于许多新领域,并且只会变得更加广泛,但在广泛依赖之前,其潜在的失败成本不断增加。同时,现实世界中引发这种失败的转移例子比比皆是:例如自动驾驶汽车遇到的简单景观和/或天气变化,或者用户为了增加他们期望结果的可能性而调整其行为(Hardt et al., 2016)。更糟糕的是,AI越来越多地被用于安全关键的环境中,这在面对有决心的对手时呈现出严重的安全漏洞(Sharif et al., 2016)。这种脆弱性仍然是进一步可信部署ML系统的重大障碍。

长期解决这些漏洞的方案必须基于以下理解:基准测试根本无法捕捉所有可能发生的变化。但同样显然的是,对所有分布转移的鲁棒性都是不可行的。相反,我们必须首先设计出对现实世界分布转移的精确、现实的数学定义:通过正式指定我们希望具备鲁棒性的转移“威胁模型”,我们才能在正式的鲁棒性保证方面取得可靠进展。同时,ML理论和实践之间(特别是在深度学习中)常常存在不匹配,因此仅有数学定义的转移是不够的。还必须仔细实验AI系统,以理解它们在实践中的失败模式——只有通过这种实验,我们才能理解并调和现实世界数据与我们对其数学理解之间的差异。这反过来将推动新型、更可靠和可解释的ML方法的发展,并在性能方面带来实际的下游收益。

本论文描述了通过结合这两种核心方法来建立可信和可靠机器学习基础的进展。具体来说,调查的工作大致分为三个主要类别:(i)设计现实世界分布转移结构的正式、实用的特征描述,包括良性和对抗性的;(ii)利用这种结构开发处理此类转移时具备证明正确性和高效性的学习算法;以及(iii)实验现代ML系统,以理解分布转移的实际影响,包括平均和最坏情况,以便未来的分析能更好地捕捉我们期望AI在未来遇到的各种困难。