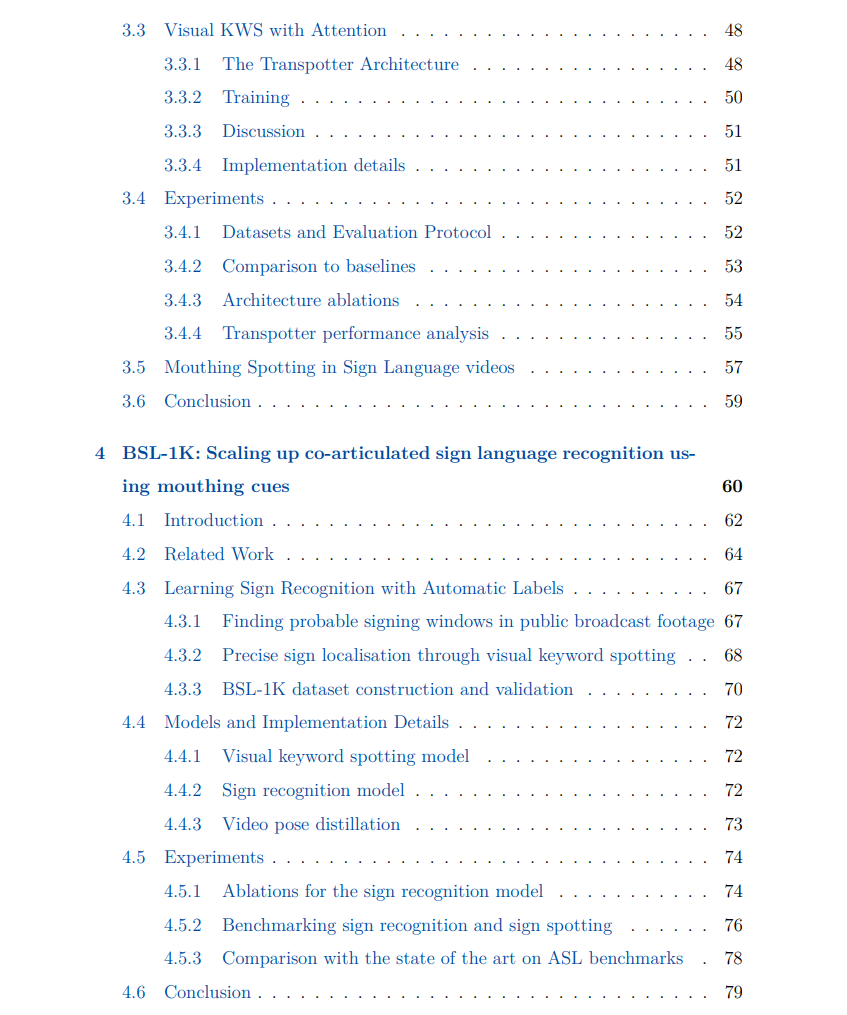

![]() 手语是一种视觉-空间语言,是聋人社区的自然交流方式。尽管近年来在视觉和语言任务上取得了进展,但自动手语理解仍然未得到充分解决。进展的关键障碍之一是缺乏合适的训练数据。在本论文中,我们旨在应对这一挑战。首先,我们专注于视觉关键词检测(KWS)——这一任务是确定关键词是否以及何时在视频中被表达——并利用手语者有时同时口型化他们所打出的词这一事实。我们最初提出了一种受目标检测方法启发的卷积KWS架构,在对说话者面部数据进行训练后,我们通过使用Transformers改进了视频和关键词表示之间的跨模态交互。随后,我们将KWS模型应用于域外的手语者口型化,以此作为定位手语的手段:通过利用弱对齐的字幕提供查询词,我们在现有的手语翻译电视数据中自动标注了数十万手语。其次,为了超越稀疏的口型化现象,我们提出了不同的手语检测方法,以在连续的翻译手语中自动标注手语:(i)在多实例学习框架中使用视觉手语字典,(ii)利用在视频到文本序列预测任务中训练的Transformer的注意力机制,(iii)通过一个强大的手语识别模型进行伪标签化,(iv)利用前述方法中的域内样本和手语表示相似性。这四种方法都利用了弱对齐的字幕,并增加了自动手语标注的词汇量和密度。结果是我们获得了一个大规模、多样化的监督数据集,促进了强手语表示的学习。第三,我们探索了需要预测手语序列的手语任务:拼指字母和连续手语识别(CSLR)。对于拼指字母,我们提出了一种弱监督方法,以检测和识别字母序列,并通过多假设损失函数从噪声监督中学习。对于CSLR,我们设计了一种多任务模型,能够同时执行手语检索,并在大词汇量场景中展示了有希望的结果。最后,我们探索了如何从弱信号中获得更强的监督,以解决更广泛的任务,超越手语领域。具体而言,我们的重点转向视频-语言模型中的动词理解——这对于在空间和时间中建模人与物体及环境之间的互动至关重要。为此任务,我们引入了一个动词聚焦的对比框架,包含两个组件:(i)利用预训练的大型语言模型生成用于跨模态对比学习的困难负例;(ii)施加细粒度的对齐损失。

手语是一种视觉-空间语言,是聋人社区的自然交流方式。尽管近年来在视觉和语言任务上取得了进展,但自动手语理解仍然未得到充分解决。进展的关键障碍之一是缺乏合适的训练数据。在本论文中,我们旨在应对这一挑战。首先,我们专注于视觉关键词检测(KWS)——这一任务是确定关键词是否以及何时在视频中被表达——并利用手语者有时同时口型化他们所打出的词这一事实。我们最初提出了一种受目标检测方法启发的卷积KWS架构,在对说话者面部数据进行训练后,我们通过使用Transformers改进了视频和关键词表示之间的跨模态交互。随后,我们将KWS模型应用于域外的手语者口型化,以此作为定位手语的手段:通过利用弱对齐的字幕提供查询词,我们在现有的手语翻译电视数据中自动标注了数十万手语。其次,为了超越稀疏的口型化现象,我们提出了不同的手语检测方法,以在连续的翻译手语中自动标注手语:(i)在多实例学习框架中使用视觉手语字典,(ii)利用在视频到文本序列预测任务中训练的Transformer的注意力机制,(iii)通过一个强大的手语识别模型进行伪标签化,(iv)利用前述方法中的域内样本和手语表示相似性。这四种方法都利用了弱对齐的字幕,并增加了自动手语标注的词汇量和密度。结果是我们获得了一个大规模、多样化的监督数据集,促进了强手语表示的学习。第三,我们探索了需要预测手语序列的手语任务:拼指字母和连续手语识别(CSLR)。对于拼指字母,我们提出了一种弱监督方法,以检测和识别字母序列,并通过多假设损失函数从噪声监督中学习。对于CSLR,我们设计了一种多任务模型,能够同时执行手语检索,并在大词汇量场景中展示了有希望的结果。最后,我们探索了如何从弱信号中获得更强的监督,以解决更广泛的任务,超越手语领域。具体而言,我们的重点转向视频-语言模型中的动词理解——这对于在空间和时间中建模人与物体及环境之间的互动至关重要。为此任务,我们引入了一个动词聚焦的对比框架,包含两个组件:(i)利用预训练的大型语言模型生成用于跨模态对比学习的困难负例;(ii)施加细粒度的对齐损失。

![]()

![]()

![]()

![]()

![]()

![]()