刚刚,Ilya现身NeurIPS 2024,宣布:预训练从此将彻底终结。短短16分钟的发言,足以震撼全场。是的,他的原话是——正如我们所知的那样,预训练毫无疑问将会终结,与此同时我们也不会再有更多数据了。原因在于,我们只有一个互联网,训练模型需要的海量数据即将枯竭,唯有从现有数据中寻找新的突破,AI才会继续发展。Ilya的预测是,以后的突破点,就在于智能体、合成数据和推理时计算。 未来,我们会走向何方?Ilya告诉我们:接下来登场的就是超级智能(superintelligence)——智能体,推理,理解和自我意识。

十年再登巅峰,Ilya感谢前同事

11月底,NeurIPS 2024时间检验奖公布,Ilya和GAN之父获奖。

论文地址:https://arxiv.org/abs/1409.3215Ilya感谢了自己的两位合著者Oriel Vinyals和Kwok-Lee,放出了下面这张图。

这是在十年前,2014年蒙特利尔NeurIPS 会议上一次类似演讲的截图。Ilya说,那是一个更加纯粹的时代。而如今,图中的三位青葱少年已经长成了下面的模样。 Ilya要做的第一件事,是展示10年前同一个演讲的PPT。他们的工作,可以用以下三个要点概括——这是一个基于文本训练的自回归模型;它是一个大型神经网络;它使用了一个大规模的数据集。

10层神经网络,只需几分之一秒下面,Ilya与我们探讨了「深度学习假设」。如果你有一个10层的大型神经网络,它就可以在几分之一秒内,完成任何人类能做的事。为什么要强调几分之一秒内?如果你相信深度学习的基本假设,即人工神经元和生物神经元是相似的,并且你也相信真实神经元的速度比人类快速完成任务的速度更慢,那么只要全世界有一个人能够在不到一秒内完成某项任务,那么一个10层神经网络也能做到。只要把它们的连接,嵌入到你的人工神经网络中。这就是我们的动机。我们专注于10层神经网络,因为在那个时候,这就是我们能够训练的神经网络。如果你能突破10层,你当然可以完成更多事。

下面这张PPT,描述的是他们的「主要想法」。核心观点就是,如果你有一个自回归模型,并且它能够足够好地预测下一个Token,那么它实际上会抓取、捕获、掌握接下来任何序列的真实分布。在当时,这是一个相对新颖的观点。尽管它并不是第一个被应用于实践的自回归神经网络,但Ilya认为,这是第一个令他们深信不疑的自回归网络:如果把它训练得足够好,那么你就会得到想要的任何结果。当时,他们尝试的是翻译。这个任务如今看来平凡无奇,当时却极具挑战性。

接下来,Ilya展示了一些可能很多人从未见过的古老历史——LSTM。不熟悉的人会觉得,LSTM是Transformer出现之前,深度学习研究者所使用的工具。它可以被看作是一个旋转了90度的ResNet,但更复杂一些。我们可以看到积分器(integrator),如今被称为残差流(residual stream),还涉及一些更为复杂的乘法操作。

Ilya还想强调的一点是,他们当时使用了并行化。不过并不是普通的并行化,而是流水线并行化(pipelining),每层神经网络都分配一块GPU。从今天来看,这个策略并不明智,但当时的他们并不知道。于是,他们使用8块GPU,实现了3.5倍的速度。

从这里,Scaling Law开始了最终,ILya放出了那次演讲中最为意义重大的一张PPT,因为,它可以说是「Scaling Law」的开端——如果你有一个非常大的数据集,训练一个非常大的神经网络,那么可以保证成功。从广义上来说,后来发生的事情也的确如此。

接下来,Ilya提到了一个真正经得起时间考验的想法——联结主义(connectionism),这样说深度学习的核心思想。这种理念认为,如果你愿意相信人工神经元在某种程度上有点像生物神经元,那么你就会相信,超大规模神经网络并不需要达到人类大脑的级别,就可以用来完成几乎所有人类能做的事。但它与人类仍然不同。因为人类大脑会弄清楚自己如何配置,它使用的是最优的学习算法,需要与参数数量相当的数据点。在这一点上,人类仍然更胜一筹。

所有这些,最终都引出了「预训练时代」。这个时代,可以用GPT-2、GPT-3和Scaling Laws定义。此处,ILya格外感谢了前同事Alec Radford,Jared Kaplan和Dario Amodei。这项技术,是推动我们今日所见所有技术进步的核心驱动力。

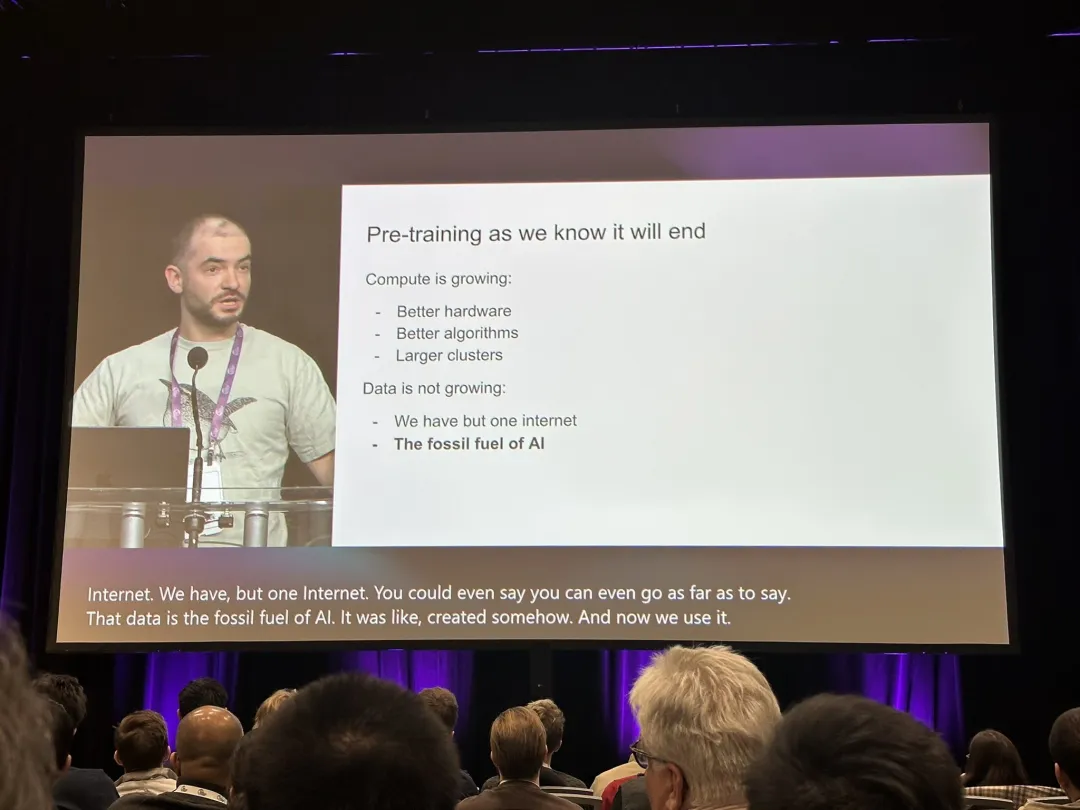

预训练时代,即将终结然而,我们所知的预训练路线,毫无疑问会终结。为什么?这是因为,尽管计算能力正通过更好的硬件、更优的算法和更大的集群不断增长,但数据量并没有增长——我们只有一个互联网。甚至可以说,数据是AI的化石燃料。它们是以某种方式被创造出来的,而如今,我们已经达到了数据峰值,不可能再有更多数据了。当然,目前现存的数据,仍能支持我们走得很远,但我们只有一个互联网。![]

接下来会发生什么?Ilya给出了下列预测。(或者只是提到他人的猜测)首先,智能体会有一些突破,这些能自主完成任务的AI智能体,就是未来的发展方向。其次,还会有一些模糊的合成数据,但这到底意味着什么?很多人都会取得有趣的进展。最后,就是推理时计算了,最引人瞩目的例子,就是o1。在预训练后,我们接下来该探索什么?o1给出了生动的例子。

下面,是一个来自生物学的例子。这张图,展示了哺乳动物的身体大小与大脑大小之间的关系。在生物学中,一切都很混乱,但上面这个紧密联系,却是一个罕见的例子。从人类及其近亲的进化分支上看,包括尼安德特人、能人等等,大脑与身体比例的缩放指数都不同。这意味着在生物学中,确实存在不同比例缩放的先例。如今我们所扩展的,可以说是第一个我们知道该如何扩展的事物。这个领域中的每个人,都会找到解决办法。而我们在相关领域,也取得了惊人的进步。10年前这个领域的人,还会记得当时是多么无能为力。过去2年进入深度学习的人,可能都无法感同身受。

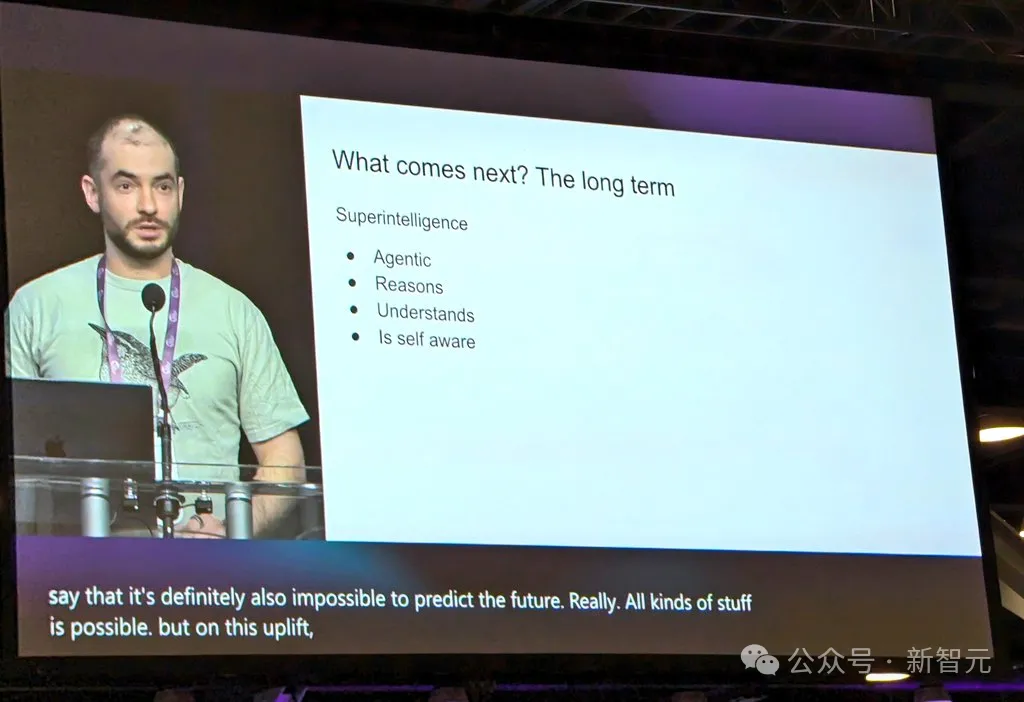

超级智能是未来,还会与意识结合最后Ilya谈到的,就是超级智能(superintelligence)了。它是公认的发展方向,也是研究人员们正在构建的东西。从本质上来说,超级智能与现在的AI完全不同。目前,我们拥有出色的LLM和聊天机器人,但它们也表现出某些奇怪的不可靠性——时常会感到困惑,但却能在评估中表现出远超人类的能力。虽然我们还不知道如何调和这一点,但最终迟早会实现以下目标:AI将真正具备实际意义上的智能体特性,并将正学会推理。由于推理会引入了更多的复杂性,因此一个会推理的系统,推理量越多,就会变得越不可预测。相比之下,我们熟知的深度学习都是可以预测的。举个例子,那些优秀的国际象棋AI,对于最顶尖的人类棋手来说就是不可预测的。所以,我们将来不得不面对的,是一些极其不可预测的AI系统——它们能够从有限的数据中理解事物,同时也不会感到困惑。同样,自我意识也是有用的,它构成了我们自身的一部分,同时也是我们世界模型中的一部分。当所有这些特性与自我意识结合在一起时,就会带来与现有系统完全不同性质和特性的系统,它们将拥有令人难以置信的惊人能力。

当然,虽然无法确定如何实现、何时实现,但这终将发生。至于这种系统可能带来的问题,就留给大家自己去想象吧。毕竟预测未来是不可能的,任何事情都有可能发生。参考资料:https://x.com/_jasonwei/status/1867696401830096970