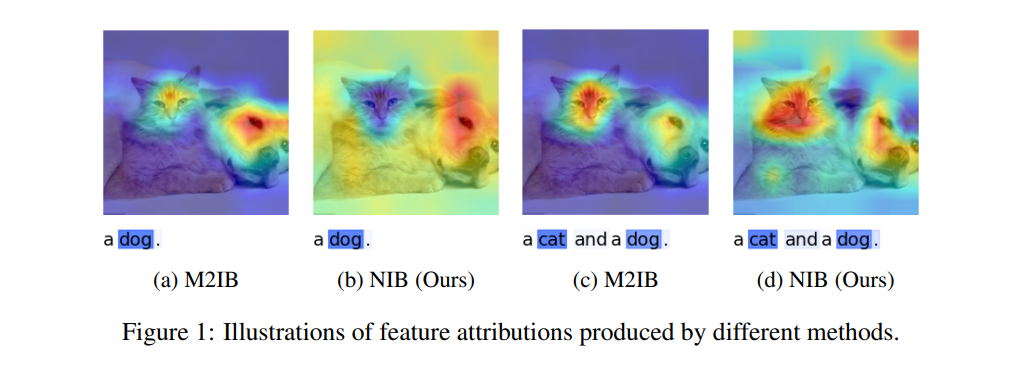

多模态图像-文本表示的识别任务引起了越来越多的关注,特别是像 CLIP(对比语言-图像预训练)这样的模型,展示了在学习图像和文本之间复杂关联方面的卓越性能。尽管取得了这些进展,确保此类模型的可解释性对于其在现实应用中的安全部署至关重要,例如在医疗领域。尽管为单模态任务开发了许多可解释性方法,但由于表示结构的固有差异,这些方法往往无法有效地转移到多模态环境中。信息理论中广泛应用的瓶颈方法已被用于提高 CLIP 的可解释性。然而,这些方法往往受到强假设或内在随机性的限制。为了克服这些挑战,我们提出了缩小信息瓶颈理论,这是一种全新的框架,根本性地重新定义了传统的瓶颈方法。该理论特别设计来满足当代归因公理,提供了一种更为强大和可靠的解决方案,旨在提高多模态模型的可解释性。在我们的实验中,与最先进的方法相比,我们的方法将图像可解释性提升了 9%,文本可解释性提升了 58.83%,并加速了处理速度 63.95%。我们的代码可以通过 https://github.com/LMBTough/NIB 公开访问。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日