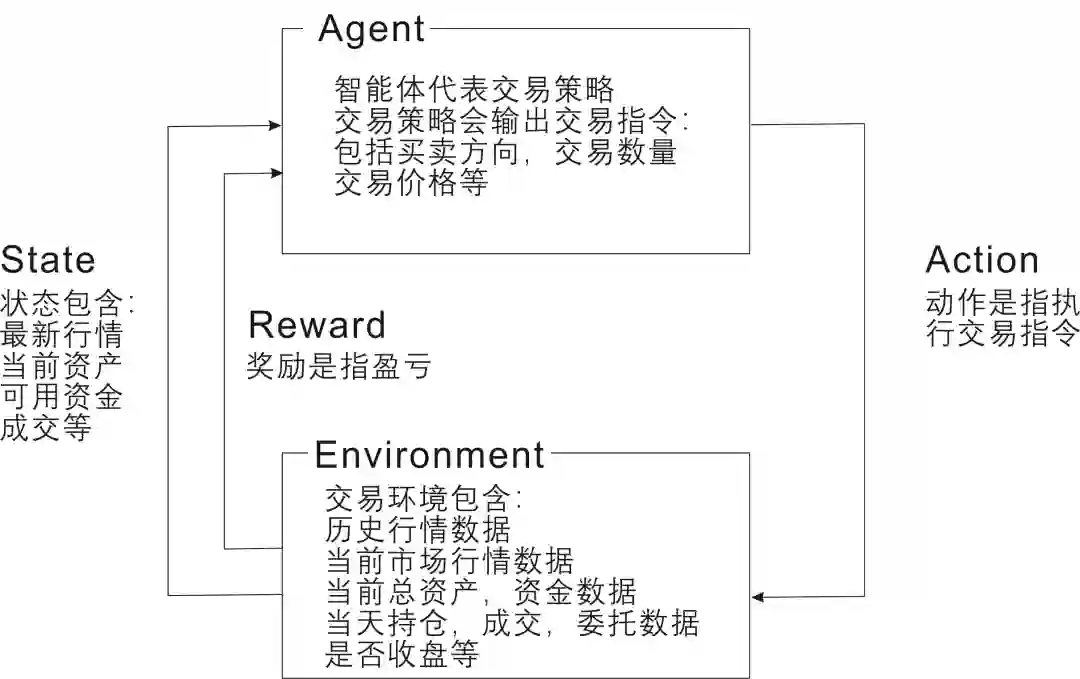

目前,深度强化学习(DRL)技术在游戏等领域已经取得了巨大的成功,同时在量化投资中的也取得了突破性进展,为了训练一个实用的DRL 交易agent,决定在哪里交易,以什么价格交易以及交易的数量,这是一个具有挑战性的问题,那么强化学习到底如何与量化交易进行结合呢?下图是一张强化学习在量化交易中的建模图:

市面上有很多研究机构和高校正在研究强化学习技术解决量化交易问题,其中比较知名的有“FinRL”,它是一个解决量化交易的开放源代码库,可为从业人员提供流水线式的策略开发的统一框架。 我们知道在强化学习中,智能体通过试错方式与环境进行持续交互学习,以取得最大累计回报。很荣幸, FinRL(有效地实现交易自动化)提供了有关定量金融中的深度强化学习的教育资源,为各种市场、基准财务任务(投资组合分配,加密货币交易,高频交易),实时交易等提供了统一的机器学习框架,下面是两篇FinRL团队已发表的相关论文:

那么FinRL库是怎么来的?有哪些内容组成,包含哪些模块呢?

这还得从强化学习的发展说起,下图是该团队汇总的强化学习到FinRL的发展过程,其中FinRL中包含了很多现有的强化学习算法的描述和实现。

一方面,FinRL库可帮助初学者了解量化金融并制定自己的股票交易策略。其允许用户简化自己的开发并轻松地与现有方案进行比较。在FinRL中,虚拟环境配置有股票市场数据集,智能体利用神经网络进行训练,并通过股票回测验证算法性能。此外,它包含了重要的市场摩擦,例如交易成本,市场流动性和投资者的风险规避程度。

另外一方面, FinRL具有完整性,动手指南和可重复性的特点,特别适合初学者: 在多个时间粒度级别上,FinRL模拟了各个股票市场的交易环境,包括NASDAQ-100,DJIA,S&P 500,HSI,SSE 50,和CSI 300。

FinRL采用模块化结构的分层架构。提供了自己开发的轻量级的DRL算法库ElegantRL(https://github.com/AI4Finance-LLC/ElegantRL),其中包含DDPG,TD3, SAC, PPO(GAE),DQN,DoubleDQN, DuelingDQN, D3QN,并支持用户自定义算法。 高度可扩展,FinRL保留了一套完整的用户导入界面。