今天,大多数的个性化服务,如推荐,都是由监督学习算法驱动的。但这些算法使用的数据是由同样的应用程序和算法收集的。这种反馈循环让人想起了在线学习问题。令人惊讶的是,在线学习算法在推荐系统等应用中并不常用。在在线学习算法中,强化学习(RL)和多臂老虎机算法看起来最有可能替代监督学习算法(Netflix; Spotify; 李等人,2016)。然而,在完全取代现有的监督方法之前,还存在许多障碍。在本论文中,我们从理论的角度关注其中的一些约束,以更好地了解在这些约束下RL和多臂老虎机算法的局限性,以及它们在实际应用中的使用如何受到影响。在这篇论文中,我们考虑了部署RL算法的三大障碍。但还有其他障碍,如模型错配、非稳态性和缺乏实时架构。

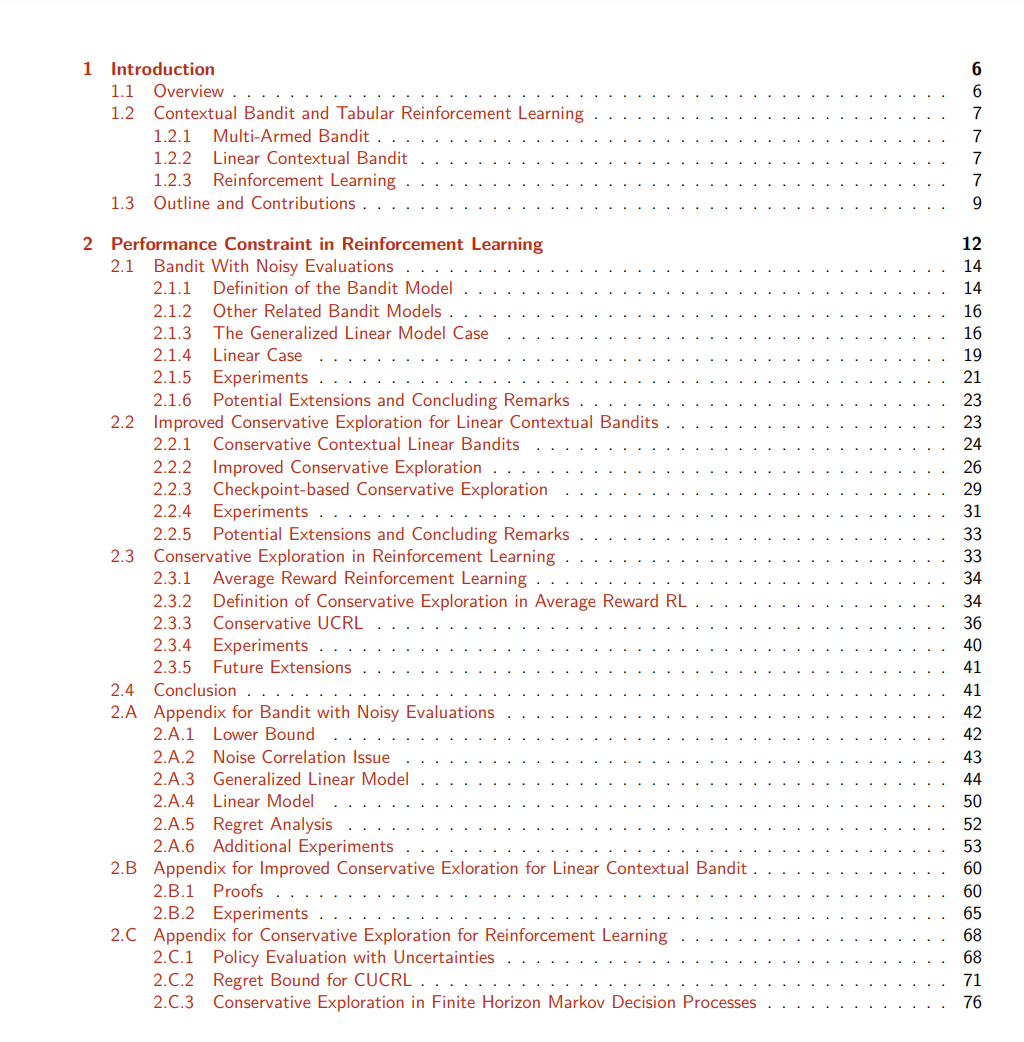

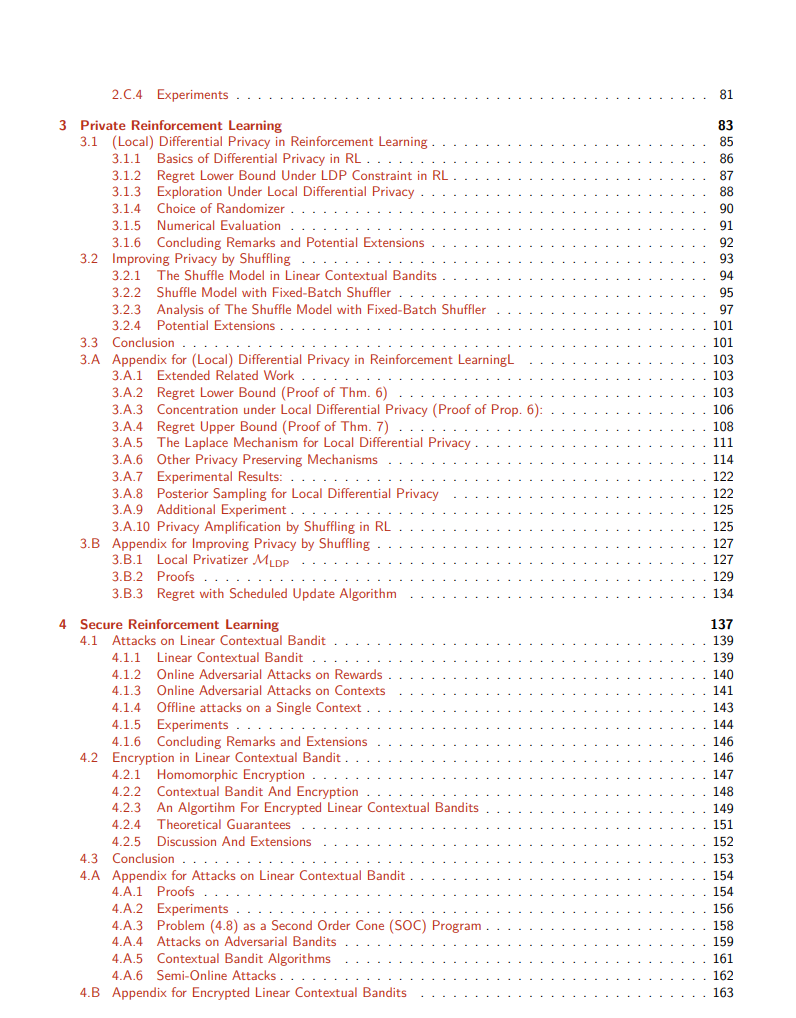

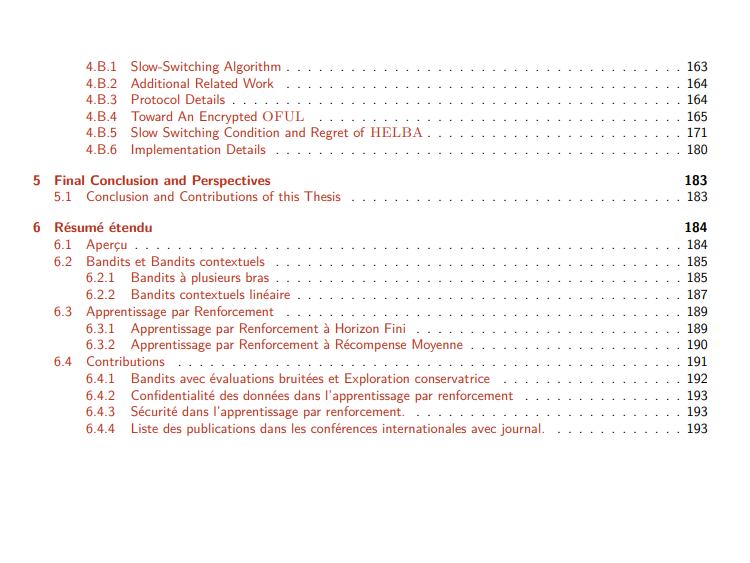

首先是确保在新部署的算法的学习过程中,其性能不会明显低于已经使用的方法,即基线策略的性能。后者往往是次优的。在这种情况下,希望部署一个与系统交互的强化学习算法,以在学习过程中的性能几乎永远不比基线差的约束下学习更好/最优的策略。

最近,在个性化服务中出现了另一个重要的问题,那就是算法使用的数据的隐私。例如,我们可以想到在推荐系统场景中通过推荐的项目泄露的信息。在RL中,用户数据中常常包含需要被保护免受第三方侵犯的敏感信息。受此观察所激励,我们在有限时域马尔可夫决策过程(MDPs)的背景下研究了隐私,要求在用户端对信息进行混淆。我们利用本地差分隐私(LDP)框架为RL提出了这种隐私的概念。我们为带有LDP保证的有限时域MDPs的遗憾最小化建立了一个下限,这显示了保证隐私对遗憾有乘法效应。这一结果表明,虽然LDP是一个吸引人的隐私概念,但它使学习问题变得更加复杂。

最后,我们考虑强化学习系统的安全问题。一个方面是了解对抗性攻击如何影响RL系统。在许多领域,恶意代理可能有动机强迫一个多臂老虎机算法进入所需的行为。例如,一个不道德的广告发布者可能会试图增加他们自己的收入,而不考虑广告商;一个卖家可能想要增加他们产品的曝光,或者挫败一个竞争对手的广告活动。我们表明,一个恶意代理可以在T步的时间范围内,通过对奖励或背景进行对抗性修改,强制多臂老虎机算法推荐任何所需的项目T ≠ o(T)次,而累积成本只是对数增长。RL的第二个安全方面是构建一个端到端加密的RL系统。事实上,多臂老虎机方法的一个关键方面是,它们需要观察上下文-即个体或团体级数据-和奖励,以解决连续的问题。在工业应用中的部署增加了对保护用户数据安全的方法的兴趣。我们引入了一个基于同态加密的安全多臂老虎机框架,允许使用加密数据进行计算。该算法只观察加密的信息(上下文和奖励)并没有解密的能力。从RL算法中的数据的安全性是保证的。