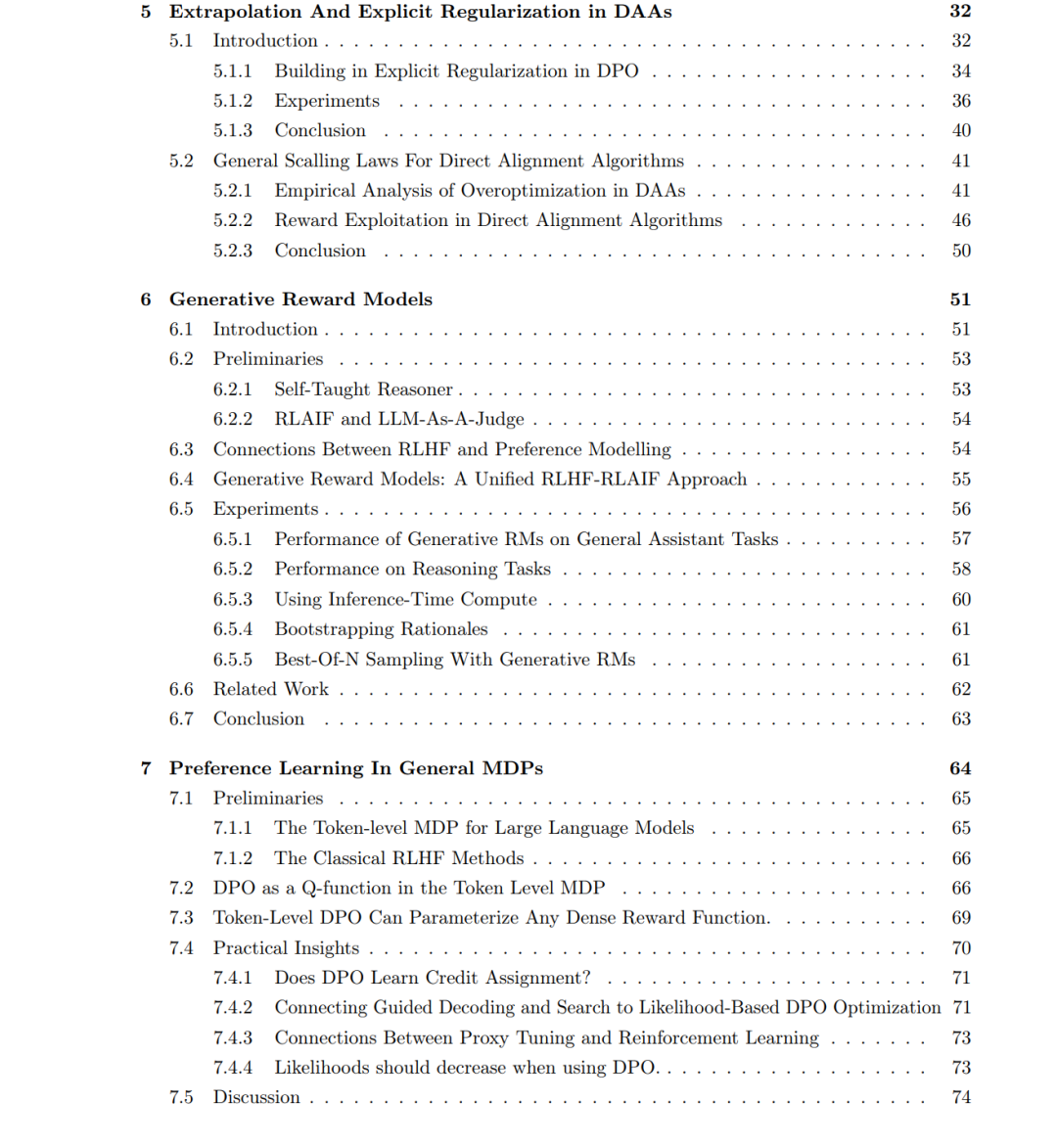

在本论文中,我们研究了基础模型(Foundation Models)后训练阶段——这一关键步骤旨在将预训练模型转化为可控且可靠的智能助手。 传统的后训练流程(尤其是“基于人类反馈的强化学习”,即 Reinforcement Learning from Human Feedback,RLHF)通常结合了指令微调(instruction tuning)、奖励建模(reward modeling)以及基于策略的强化学习(on-policy RL)。虽然这种流程有效,但其结构复杂、计算成本高,并且容易出现如“奖励黑客(reward hacking)”等已广为人知的问题。 本论文的核心贡献是提出并分析一种名为 直接偏好优化(Direct Preference Optimization,DPO) 的简单离线算法。DPO 能够直接从偏好数据中恢复最优的 RLHF 策略,而无需显式的奖励模型或基于策略的强化学习。我们首先介绍 DPO,并推导其理论保证。随后指出,DPO 实际上是一个更广泛目标的特例,该目标可理解为策略梯度方法(policy-gradient methods)的离线对应形式。这一在第 3 章中发展的理论基础,为构建数学一致的偏好优化方法提供了通用框架。 在第 4 章中,我们对 DPO 及相关方法进行了广泛的实证研究。结果表明,即使没有显式的奖励模型,这些算法仍会表现出与 RLHF 相似的奖励黑客现象。偏好驱动的训练过程同样遵循可扩展性规律(scaling laws),这凸显了对齐失败(alignment failure)的结构性特征。这一发现激发了我们开发更稳健的评估器与训练流程。 为此,第 5 章提出了生成式奖励模型(Generative Reward Models,GenRMs),即利用大型语言模型(LLM)作为“评论者”(critic)。我们提出通过迭代偏好优化(DPO)来训练这些评论者,使其更好地符合人类判断。实验结果显示,GenRM 能显著提升奖励建模的精度和分布外(out-of-distribution)鲁棒性。结合 DPO,这一流程为传统 RLHF 提供了一种有理论基础的替代方案。 最后,在第 6 章中,我们将 DPO 的理论扩展至一般马尔可夫决策过程(MDP),并展示了其在多步智能体强化学习(multi-step agentic reinforcement learning)中的应用。我们通过网页智能体(web agents)领域的案例研究表明,基于偏好的优化可以成为超越单轮对话的智能体训练基础。 综上所述,本论文在基础模型后训练对齐的理论与实践方面均取得了进展。我们贡献了新的算法(DPO、GenRM)、一个直接对齐(direct alignment)的统一理论框架、对奖励黑客现象的实证分析,以及对多步智能体场景的扩展。这些成果共同推动了基础模型对齐研究向着更简单、更稳健、更具可扩展性的方向发展,使其更好地契合人类价值观。