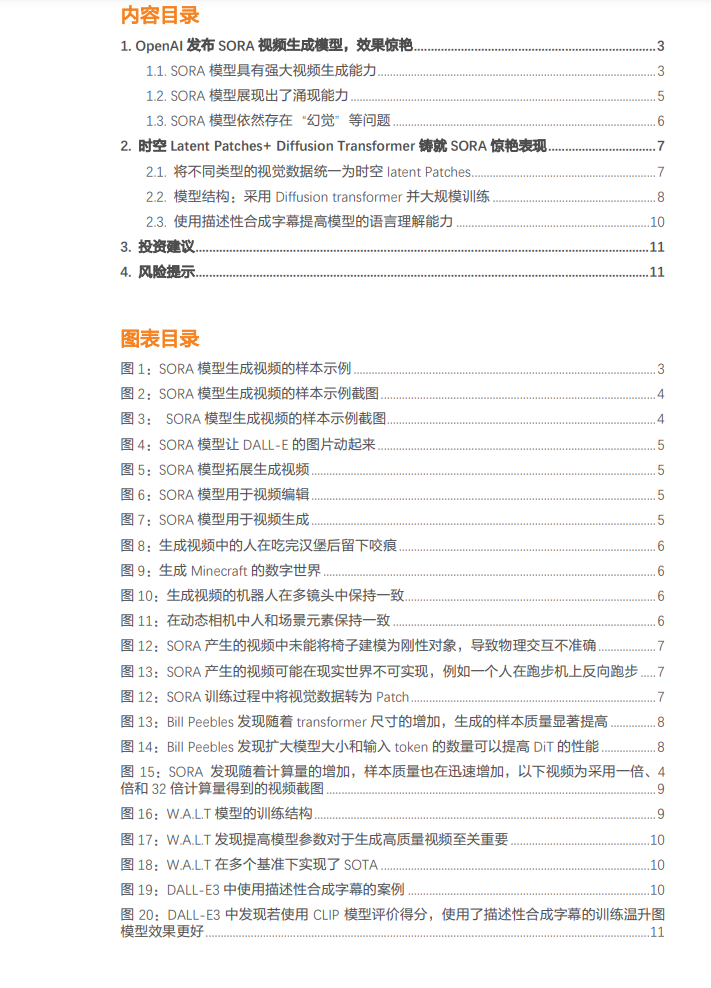

OpenAI发布了最新文生视频大模型SORA,可以生成1分钟长视频,效果显著,在生成的视频细节,内容一致性和指令遵循能力独树一帜 2月16日,OpenAI首次对外公布了SORA文生视频模型,SORA模型可以直接输出长达60秒的视频,并且包含高度细致的背景、复杂的多角度镜头,以及富有情感的多个角色。相比较而言,Runway Gen2、Pika等AI视频工具,都还在突破几秒内的连贯性,而OpenAI,已经达到了史诗级的纪录。OpenAI目前已经邀请了一支专业的创意人士测试,用于反馈其在专业环境中的实用性。 SORA模型在训练中将不同类型视觉素材统一为时空Latent Patch,采用Diffusion-transformer结构并大规模训练,再次展现“暴力美学” 从technical report窥探技术路径,OpenAI在文生视频领域再次展现“暴力美学”,SORA在模型结构上使用了Diffusion Transformer结构,采用了大规模的训练,在数据上将图片和视频统一压缩转换为时空Latent Patches并作为transformer输入,而这一步也使得模型能够在不同分辨率、持续时间和宽高比的视频/图像数据上进行训练,同时为了提高模型的理解能力,SORA使用了DALL-E3模型中的re-captioning技术,训练了一个caption模型为视频数据生成文字字幕。 SORA模型已具备了一定的涌现能力,虽然也存在“幻觉问题”,但我们认为文生视频的GPT-3时刻已来 SORA模型现在可用于视频生成,图片生成,视频编辑、视频链接和视频前后拓展等,我们认为未来有望重塑影视/动画/自媒体等诸多视频生产行业,同时SORA还展现出了一定的涌现能力,使其能够从物理世界模拟人、动物和环境的某些方面,包括3D连续,物体持续和long-range的连贯性,我们预计未来SORA也会逐步进化,如同GPT3到4一样有更强的能力,或许文生视频的GPT-3时刻已经到来。