随着人工智能(AI)能力(Üstün等, 2024;Team等, 2023;Gomez, 2024;Anthropic, 2024a;Radford等, 2023;Brooks等, 2024)和市场前景(Vipra和Korinek, 2023;McElheran等, 2024)的迅速扩展,开发基础模型的开发者、科学家和贡献者社区也在快速增长(Bommasani等, 2021)。这一领域的增长促使许多工具和资源被广泛采用,用于构建、部署、评估和管理大型基础模型(FMs)。然而,这些新兴实践通常不够成熟。许多优秀资源被忽视,部分原因是缺乏可发现性或对良好实践的认识。为了弥补这些差距,我们进行了有针对性的调查,不是科学文献(关于许多FM开发主题的文献已经存在(Albalak等, 2024;Zhao等, 2023a;Chang等, 2023)),而是FM开发的资源,如数据集、软件包、文档、指南、框架和实用工具。特别是,这些资源的策划是针对较新的、小型或中型开发团队的负责任开发实践。大型FM开发组织,如Google、OpenAI或Meta,拥有大量用户群,应该遵循比本综述中概述的更严格和特定产品的最佳实践。我们发布了基础模型开发备忘单,这是一份针对文本、语音和视觉模型的带注释工具库,并开放公众贡献:fmcheatsheet.org。

https://www.zhuanzhi.ai/paper/7abb31c9a45a5f6b472c9069ca8279b4

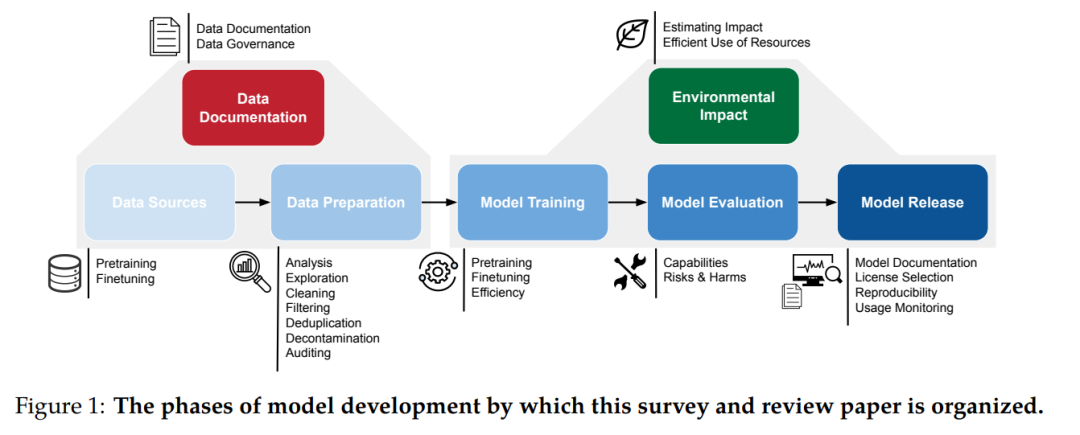

对于模型开发的每个阶段,我们的贡献总结如下:(i)相关工具和资源的调查,(ii)文献推荐实践和这些工具的使用综述,以及(iii)现有资源的局限性和遗漏的评审。备忘单作为调查和推荐实践的简明指南,由基础模型开发人员为基础模型开发人员准备。目标读者是包括学术研究人员、初创公司、研究实验室在内的一系列基础模型开发人员,他们可能是从头开始预训练,或仅仅进行微调,不论规模大小。 我们的调查和建议希望引起各开发阶段工具的广泛关注。首先,我们建议支持知情的数据选择、处理和理解的资源(第3和第4节)。未经充分尽职调查准备的数据可能导致意想不到的后果(如隐私风险、版权问题或生成敏感内容的风险)、边缘化(如无意中过滤掉某些分布)或意外的模型行为(如训练/测试重叠或安全漏洞)。接下来,我们调查了用于精确且有局限意识的工件文档资源(第5节)。当发布新数据集时,早期设置其治理标准可以避免后续的误用。基础模型训练可能在财务和环境上花费高昂。我们汇集了高效模型训练(第6节)和估算模型缩放行为及环境影响(第7节)的资源。提前了解这些数量可以帮助制定更高效的训练实践。一旦模型训练完成,我们提供了评估框架、风险分类和各种评估标准的基准(第8节)。最佳实践建议模型应针对其预期用途以及一些不可预见的误用或伤害进行评估。开发人员应为这些设置设计自然评估,而不是依赖现有但不适用的工具。我们的评估框架建议评估指标应情境化,以避免过度声称或误解报告数字的局限性。最后,我们的调查信息提供了负责任的模型发布和部署实践(第9节),以便开发人员可以做出知情的许可证和发布机制选择,以解决误用风险。 除了资源调查外,我们还审查了现有的工具和资源生态系统。对于模型开发的每个部分,我们检查了现有工具和常见实践的局限性、遗漏和改进机会。总结在表1中,我们发现:

数据来源、模型评估和监控工具在负责任开发需求和现实世界需求方面严重不足。例如,它们通常缺乏足够的文档、模拟实际用例或准确反映许可权限。

流行的模型安全性、能力和环境影响评估基准缺乏可重复性和透明性。

需要评估系统而不仅仅是模型的资源,以便在现实世界部署的背景下评估能力和影响。

我们开发了以下方法来指导这些工具和资源的收集以及我们的分析。首先,我们将模型开发管道划分为几个阶段,如图1所示。尽管图示如此,我们承认这些阶段经常是相互关联的,而不是顺序的。我们还包括了现有研究认为负责任开发所必需的类别,尽管它们经常被开发管道忽略:例如文档、环境影响估计或风险和危害评估。接下来,作者根据其专业领域或跨越多个开发阶段的模态(文本、视觉或语音)分配到这些阶段中的一部分。每位作者在其模型开发领域的文献中寻找以下形式的相关工具的混合体:(a)以库、API或接口形式存在的相关工具,(b)直接调查或指导开发决策的科学文献,以及(c)开发的框架或标准(如文档或风险分类)。由于类别的广泛性,文献调查不可避免地是不完全的,但反映了对每个领域中最突出的工具的专门搜索。某些开发阶段,如模型训练,有数以千计的可用库,因此我们制定了包含标准(如下所述),优先考虑某些品质:受欢迎程度、实用性和推进负责任实践。

包含标准

这些包含原则如下所述,是不完整和主观的,但我们仍然认为它们足够严格,可以形成一个全面而有用的资源汇编。资源的选择基于每个基础模型开发阶段的文献审查。包含的前提是一系列考虑因素,包括:该工具在Hugging Face或GitHub上的受欢迎程度,作为开发工具的感知帮助程度,文档的范围和质量,对开发过程带来的见解,以及在某些情况下,AI社区中有用资源的认知不足。例如,在第3.2节中,我们尝试包含更多低资源语言的微调数据目录,这些语言通常不如Hugging Face数据集中心更突出的语言受到关注。与大多数调查中主要分享学术文献不同,我们专注于工具,如数据目录、搜索/分析工具、评估库,以及选择性地总结、调查或指导重要开发决策的文献。此外,我们希望通过开放的社区贡献呼吁使覆盖范围更全面。

如何贡献?

我们打算将备忘单的网络版变成一个众包、互动的动态文档,带有搜索和过滤工具。要贡献这一资源,请按照网站上的说明进行:fmcheatsheet.org。贡献应遵循上述包含标准,范围限定为直接影响负责任基础模型开发的资源,如工具、工件或有用的上下文文献。贡献内容将由项目维护者审核,以评估资源是否符合上述的理想包含标准。

范围与局限性

我们汇编了指导模型开发的资源、工具和文献,我们认为这些对新生(以及常常是经验丰富的)基础模型开发者特别有帮助。然而,这份指南远非详尽无遗——在使用时需要考虑以下几点:

时间范围:基础模型开发是一门迅速发展的科学。本文件仅是2024年3月的样本。完整的备忘单更加全面,并对公众贡献开放:fmcheatsheet.org。

适用开发者:我们将这些资源的范围限定为中小型基础模型开发者。大型组织,具有商业服务和/或广泛用户群的组织,对于负责任开发有更广泛的考虑,这在本文中未列出。

开发阶段和模态:我们仅将数据模态范围限定为文本、视觉和语音,以及图1中概述的开发阶段。我们支持多语言资源,但承认在这里仍然存在显著的社区范围内的意识和采用差距。

用户提醒:我们提醒用户遵循标准实践来评估每个工具的安全性和可行性,特别是在他们的环境中。有时我们提供的资源包含相互矛盾的建议,因为了解社区观点的分歧是有帮助的。我们的注释旨在情境化这些资源,以帮助指导读者的判断。