项目的主要目标和目的是什么?

利用传统成像技术和深度神经网络进行物体检测已被广泛研究[1-5]。在传统成像中,利用深度神经网络可以实现高性能的物体检测。然而,低光子数或遮挡等不利条件会降低这些系统的性能。光子在长波红外(LWIR)光谱中含量丰富,因此这些领域被用于低照度条件下。

因此,人们通过长波红外光谱成像研究了低照度条件下的物体分类 [6-8]。然而,与可见光范围的同类产品相比,低红外摄像机通常成本较高,空间分辨率低得多,而且需要更笨重的光学器件。可见光谱成像是一种有效的物体检测技术,但在光子匮乏的环境中,传统相机的噪声会降低分类性能。

在任何成像领域,遮挡等不利条件都会降低物体分类能力。三维(3D)积分成像(InIm)是一种著名的 3D 技术,它通过捕捉 3D 场景的角度和强度信息来工作 [8-11]。三维成像也与二维成像相对,后者指的是由摄像头获取的传统二维成像,不提供深度信息。在弱光环境下,三维 InIm 重建图像与传统的二维成像相比具有更高的信噪比 (SNR),因为三维 InIm 在最大似然意义上对读取噪声占优势的图像是最佳的[9,12]。

我们建议利用基于三维积分成像的新型被动传感技术,研究 CMOS 摄像机在低照度下的物体分类,并与长波红外摄像机进行比较。在低照度下或使用移动设备以三维方式被动探测、识别和可视化目标和场景的能力,对于美国海军感兴趣的应用(包括以士兵为中心的应用)将非常重要。我们将证明,使用 CMOS 摄像机或长波红外摄像机在低照度下进行三维被动成像,在可视化、透过遮挡和遮蔽物(如树木、树叶等)以及实时三维目标识别和跟踪方面有很大优势。低照度下的三维信息可为美国海军作战人员提供新的信息利用工具。我们的三维传感方法基于多视角三维整体成像,以记录视差并提取目标的距离和三维轮廓。通过摄像机阵列被动积分成像获得的三维信息是根据摄像机的不同位置推断出来的。这是一种被动传感采集技术,适用于主动传感技术不足的情况,以及需要非控制照明条件/场景的情况。

与使用主动照明测量飞行时间的激光雷达不同,这种多模式被动传感方法使用环境光或热成像的二维图像传感器。我们已经解决了可靠的性能驱动传感的基本问题,如记录和重建三维场景所需的光照度、传感器在像素参数(大小/间距/数量)和视差几何方面的要求。此外,我们还试验了长波红外摄像机和激光雷达传感器。我们将它们的性能与使用 CMOS 摄像机的积分成像系统在劣化环境中的性能进行了比较,以研究这些图像传感器在极低光照水平下可视化和探测被动三维场景和物体的能力,这在以前的报告中从未报道过。

与其他 3D 方法相比,所提出的方法有很多优点。立体相机在深度估计精度方面存在问题,尤其是在有遮挡物和环境恶化的情况下。RGB-D 传感器通常基于飞行时间 (ToF) 技术或结构光 (SL)。飞行时间 (ToF) 3D 成像系统由一个无源 CMOS 图像传感器(相机)和一个有源调制光源(如激光或发光二极管)组成。主动光源用于照亮场景,场景的反射光通过专用传感器采集。发射光和反射光之间的相位差用于估算场景中物体的距离和深度信息。测距相机可用于将深度信息与二维强度线索相结合。ToF 要求高精度的波延迟测量,以便估算相应的深度信息。它通常用于室内和短距离应用。此外,在有遮挡物和劣质环境的情况下,它们的性能可能不佳。

我们的调查和实验结果表明,在低照度和遮挡条件下进行的实验中,3D InIm 检测模型在可见光谱下的性能平均优于传统 2D 成像系统在可见光和长波红外光谱下的性能。同样明显的是,对于传统的二维成像系统而言,低红外光谱中的物体检测性能优于可见光谱中的物体检测性能。这也是低红外摄像机在低照度和恶劣环境条件下成像的普遍应用的原因。然而,我们的实验证明,在低照度和遮挡条件下,可见光域三维整体成像可能优于基于低红外光谱的二维和三维成像系统。与传统的长波红外成像相比,三维可见域积分成像系统能以更高的 F1 分数和明显更高的精度分数进行物体检测。[22-23]

在实现这些目标方面取得了哪些成就?

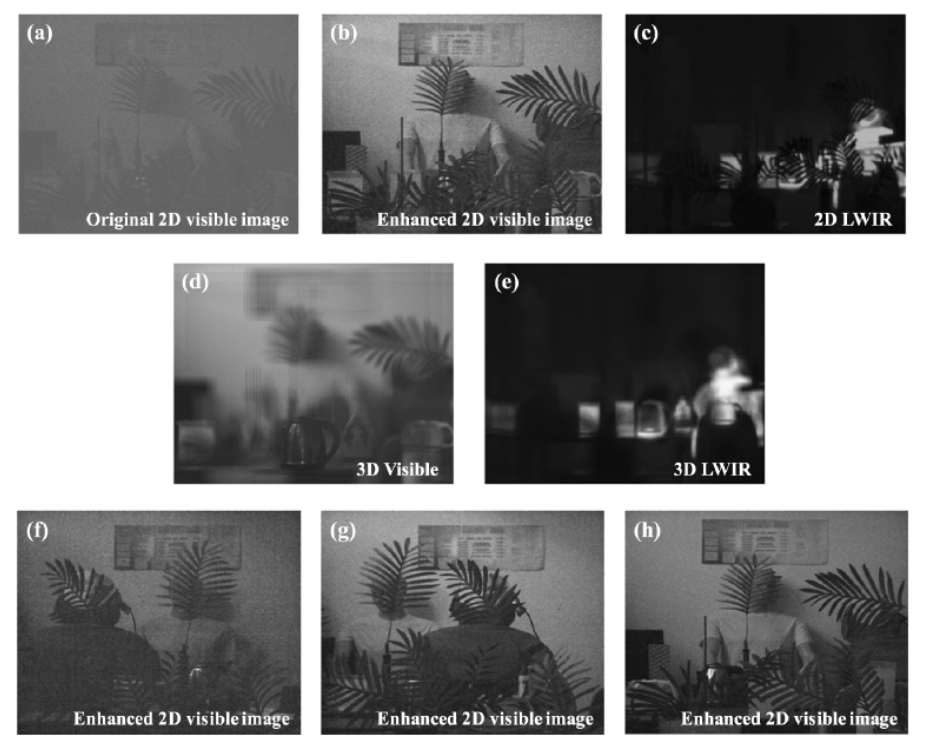

我们已经完成了该项目的任务和目标,包括:1)开发专用算法,并利用可见光范围图像传感器进行实验,利用被动积分成像技术在退化环境中识别物体。劣化条件包括光线不足、遮挡和模糊、雾等。我们设计并实施了用于数据收集和实验的完整系统,开发了使用卷积神经网络和深度学习的专用算法,并与统计算法进行了比较,还将我们提出的方法与传统系统进行了比较,以在低光照度和其他不利条件下进行物体识别。图 1 展示了场景的样本图像,其中包括各种待分类的物体和存在退化的环境。这些场景包含所有物体的冷热两个版本。

该项目的最终目的是比较可见光和长波红外光谱中目标检测的性能。为减少训练阶段的偏差,训练场景由可见光和长波红外摄像机同时拍摄。这样,就可以用完全相同的 LWIR 和可见光谱场景进行训练。每个场景都包含热物体和冷物体。

我们最重要的发现是,在不利条件下,使用专用算法在可见光范围内进行被动 3D 成像的性能可能会超过 LWIR 成像。美国国防部广泛使用近红外成像仪。因此,如果利用更多数据(包括实地测试)进行更多测试和性能评估,证实这些结果,那么这一发现将具有变革性意义。可见光范围照相机远比长波红外照相机价格低廉、结构紧凑,我们的发现会给美国国防部带来极大的兴趣和益处。

我们开发了专用算法和三维被动成像方案,并在可见光域和长波红外(LWIR)成像中,在弱光环境和存在遮挡物的情况下进行了目标检测和分类。获得了初步的实验结果。我们使用被动三维积分成像技术在弱光环境和遮挡物下捕获了测试图像。之所以选择被动三维积分成像,是因为它在最大似然意义上对读取噪声占优势的图像是最佳的。这在弱光条件下具有优势。在弱光条件下,需要对图像进行去噪处理,然后才能用于三维场景构建。因此,物体检测流水线包括对捕捉到的元素图像进行弱光增强,利用积分成像进行三维重建以减轻遮挡等不利条件的影响,最后利用深度学习的卷积神经网络进行物体检测和分类。

我们已经使用了被动式 3D InIm [16-23],并将其性能与主动式 3D 成像进行了比较,以便在退化环境中进行物体识别。3D InIm [22-22] 是通过从不同角度记录场景的多个二维元素图像来实现的。这些图像可以通过带有小透镜阵列的单个图像传感器、相机阵列或安装在平移台上的单个相机拍摄。然后,通过光学或计算重建方法对二维元素图像进行整合,以获取场景的三维信息。计算重建是通过虚拟针孔的光线反向传播来完成的。重建深度可设置为捕捉到的元素图像景深范围内的任意值。

在本项目中,使用深度神经网络进行了目标检测和分类。不过,我们认为,使用统计技术可能会显示,可见光范围光谱下的被动三维积分成像性能优于其 IWIR 同类产品。本报告中使用了多种最先进的卷积神经网络和深度学习算法来处理捕获的多维图像,如不同版本的 "只看一遍"(YOLO)网络。卷积网络检测模型可确定图像中物体的边界框,并同时对其进行分类。输入图像被划分为 S X S 个网格单元。每个单元预测物体出现的概率。如果确定该单元中存在物体,则预测其周围方框的坐标以及这些方框的置信度得分。每个边界框预测五个参数 [x、y、w、h、c]。(x, y) 坐标代表物体在框内的中心位置,(w, h) 代表边界框的高度和宽度,c 是置信度得分。每个单元格还预测对象的条件类别概率。单个方框的条件类别概率与置信度得分的乘积就是每个方框的特定类别置信度得分。这些分数表示类出现在方框中的概率以及预测方框与对象的匹配程度。

图 1. (a) 低照度二维可见光测试图像样本(每像素 3.3 光子)。(b) 使用去毛刺和 ICA 预处理管道增强后的二维图像。(c) 与(a)中场景相对应的低照度二维近红外测试图像样本。(d) 在高咖啡壶(3.68 米)平面上重建的与 (a) 中场景相对应的低照度三维可见光测试图像样本。用于重建的二维元素图像已使用前几节所述的预处理管道进行了增强。(e) 与(a)中场景相对应的低照度 3D 长波红外测试图像样本。(f)、(g)和(h)是在可见光域进行去噪增强后的其他二维图像样本。[22]

对于可见光谱,使用 YOLO 网络来训练低红外光谱的物体检测网络。在长波红外光谱中,热物体和冷物体具有不同的对比度。因此,针对长波红外图像训练了两个检测器。一个只针对热物体,另一个则同时针对热物体和冷物体。我们的目的是研究这两种方法的检测性能。最后,我们希望将这两种方法在低红外光谱和可见光谱下的物体检测结果进行比较。

低红外光谱和可见光光谱的图像分辨率是不同的。图像分辨率取决于传感器像素密度和工作波长。可见光范围成像的分辨率比低纬度红外成像要高得多。可见光范围成像的分辨率比近红外成像高出一个数量级以上。因此,与传感器像素密度相比,小波长造成的分辨率差异要大得多。可见光照相机的传感器像素密度与近红外光谱照相机不同。我们可以减轻不同像素密度的影响。这可以通过改变可见光摄像机所拍摄图像的单位像素信息来实现。如果我们假设场景是在准轴向,并且两台相机之间没有明显的角度间隔,那么这种方法是有效的。这些条件是上一节假设条件的一周形式。因此,满足这些条件不成问题。满足这些条件后,我们就可以使用基于样条插值法将像素值从一帧图像转移到另一帧图像,从而完成修改每个物体像素信息的任务。

可见光和长波红外训练图像都通过透视多样性、镜像翻转和环境退化进行了增强。测试图像将在低照度条件下采集。因此,在训练数据集中引入的环境退化必须反映测试图像的大致拍摄条件。

在低照度条件下,可见光谱相机捕捉到的图像的单位像素光子数非常低。在光子匮乏的条件下,由于光子数量少,捕捉到的图像主要是相机噪声。我们的目标是找到一种简单的方法,对低照度条件下的噪声进行近似估计。这种近似估计值有助于指导我们为神经网络训练增加数据。需要注意的是,我们并不希望找到一种严格的方法来复制低照度成像的确切条件。事实上,复制测试数据集的精确条件可能会导致网络出现偏差。

总之,我们利用可见光和长波红外成像技术,对低照度条件下和模糊环境中的物体检测和分类进行了研究。结果发现,就我们的目的而言,使用 YOLO 的 CNN 深度学习提供了最佳结果。但是,二维成像无法检测到遮挡物体或弱光物体。在这里,我们使用三维整体成像来看穿遮挡物。这样,YOLO 网络即使在遮挡环境中也能检测到三维物体。我们测试了各种弱光条件,以检查物体检测管道的鲁棒性。据观察,即使曝光时间只有 3-4 毫秒(每个像素 3-4 个光子),我们也能通过适当的算法(包括元素图像的预处理去噪和通过整体成像进行三维重建)检测到物体。我们计划对可见光和长波红外光谱的物体检测管道性能进行广泛的测试和严格的分析,并在弱光条件下对遮挡和非遮挡场景的这两种性能进行比较。