深度学习(Deep Learning, DL)作为机器学习(Machine Learning, ML)的一个强大分支,因其能够通过深度神经网络(DNNs)自动从大规模数据集中提取层次化特征,近年来得到了广泛应用。这一能力推动了多个领域的发展,包括医疗保健、计算机视觉、自然语言处理以及自动化系统等。然而,在资源受限的终端设备(如智能手机和物联网设备)上运行深度学习模型仍面临显著挑战,主要包括计算能力受限、能耗控制以及对低延迟的需求。 本论文旨在解决在异构多处理系统芯片(Heterogeneous Multi-Processing System-on-Chips, HMPSoCs)上进行深度学习推理时的优化问题。此类系统通常集成了 CPU 集群、GPU 和神经网络处理单元(Neural Processing Units, NPUs),各自具有不同的能效、性能和精度取舍。研究聚焦于多处理器协同利用,以提升推理的延迟表现、电源效率与吞吐量。在准确性、性能和功耗之间进行优化与平衡,是实现资源受限设备上高效推理的关键目标。 本研究的核心贡献如下:

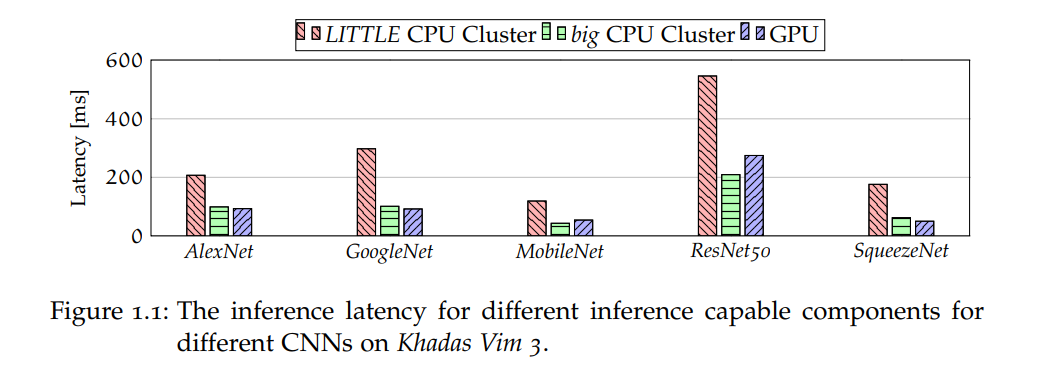

1. 基于层级切换的延迟优化(Layer-Switching):

提出一种预配置的层级切换策略,将深度学习模型的每一层分配给能够最小化整体推理延迟的处理器(CPU 或 GPU)。该方法特别适用于增强现实(AR)和虚拟现实(VR)等对延迟高度敏感的应用,确保其在不牺牲实时性的前提下实现理想性能。

2. 结合 DVFS 与层级切换提升能效:

为了解决在满足延迟约束的同时优化功耗的问题,研究结合了动态电压与频率调整(Dynamic Voltage and Frequency Scaling, DVFS)与预配置的 CPU/GPU 层级切换方法。该方案在不牺牲性能的前提下,最大限度降低了处理器功耗,使深度学习模型能够在电池供电设备的功耗范围内运行,并维持目标延迟表现。

3. NPU 集成与准确率、功耗、性能之间的权衡:

专为深度学习设计的 NPU 可显著提升能效与性能,但量化操作可能会引入精度损失。为此,提出一种选择性量化的方法,即仅对部分网络层进行量化并在 NPU 上运行,其余层保持全精度。此方法在准确性、能耗与计算性能之间实现了更优的平衡。

4. 基于多处理器流水线执行的吞吐量优化:

为提升系统吞吐量,研究设计了一种基于流水线的执行策略,预先将模型划分至 CPU 集群、GPU 和 NPU 的不同处理阶段,使得多个处理器可并行处理不同部分的模型。这种方式支持视频处理等高吞吐量应用所需的帧率(FPS),同时保持较低的功耗和延迟开销。

5. 框架实现与发布:ARM-CO-UP

本研究的一个重要成果是开发并发布了名为 ARM-CO-UP的框架,该框架支持在 HMPSoCs 上高效执行深度学习推理。其主要功能包括处理器切换、流水线执行、DVFS 控制,以及执行时间与功耗的层级分析。ARM-CO-UP 专为支持 CPU、GPU 与 NPU 之间的协同执行而设计,是一个灵活可扩展的工具,可用于实验不同的优化方案、切换策略及执行模型,对推动资源受限终端设备上的深度学习部署具有重要意义。 本论文的研究成果有助于推动先进人工智能(AI)技术在日常设备上的部署,使得深度学习模型能够在资源受限的环境中高效运行。所提出的集成式框架为该领域的持续探索提供了实用且可扩展的解决方案。