机器学习模型容易受到一系列攻击,这些攻击利用了训练模型中的数据泄露。差分隐私 (Differential Privacy, DP) 是量化隐私风险并提供可证明的攻击防御保证的黄金标准。然而,在差分隐私下训练机器学习模型通常会导致显著的效用下降。在本论文中,我们探讨了如何在差分隐私机器学习中有效地从数据中学习和生成数据。

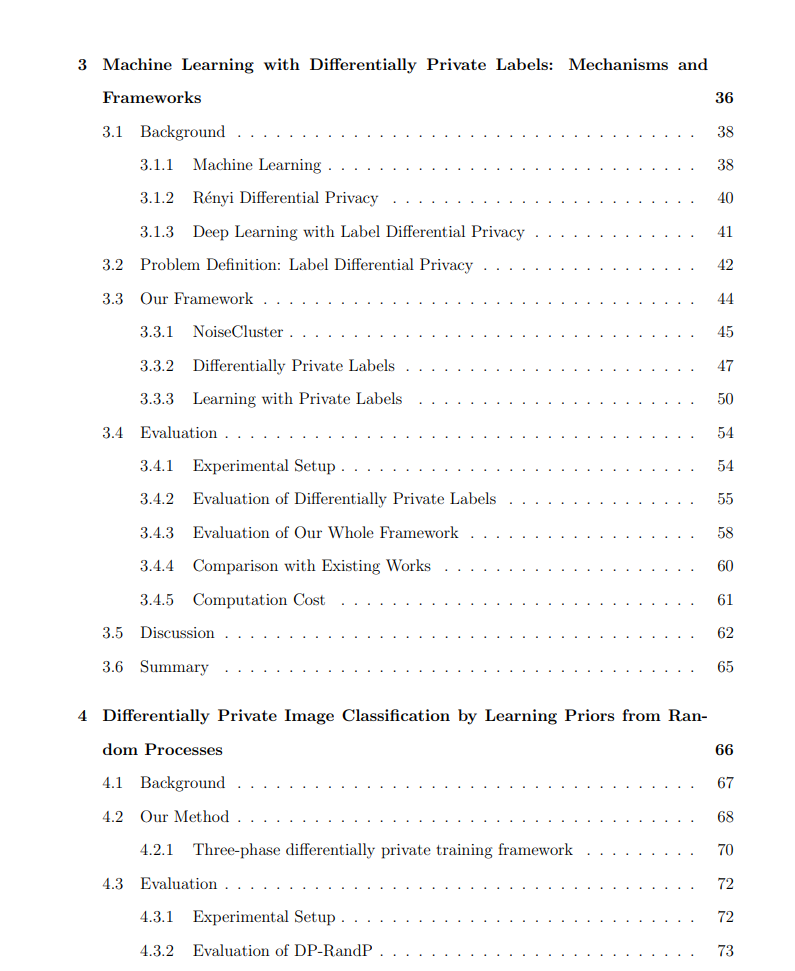

为了在保护隐私的情况下有效地从数据中学习,识别可以利用的先验信息类型至关重要。首先,我们研究了标签差分隐私 (label-DP) 设置,其中特征信息是公开的,而标签信息是私密的。我们研究了如何通过利用公共特征减少噪声添加量并减小噪声影响,从而提高模型在标签差分隐私下的效用。

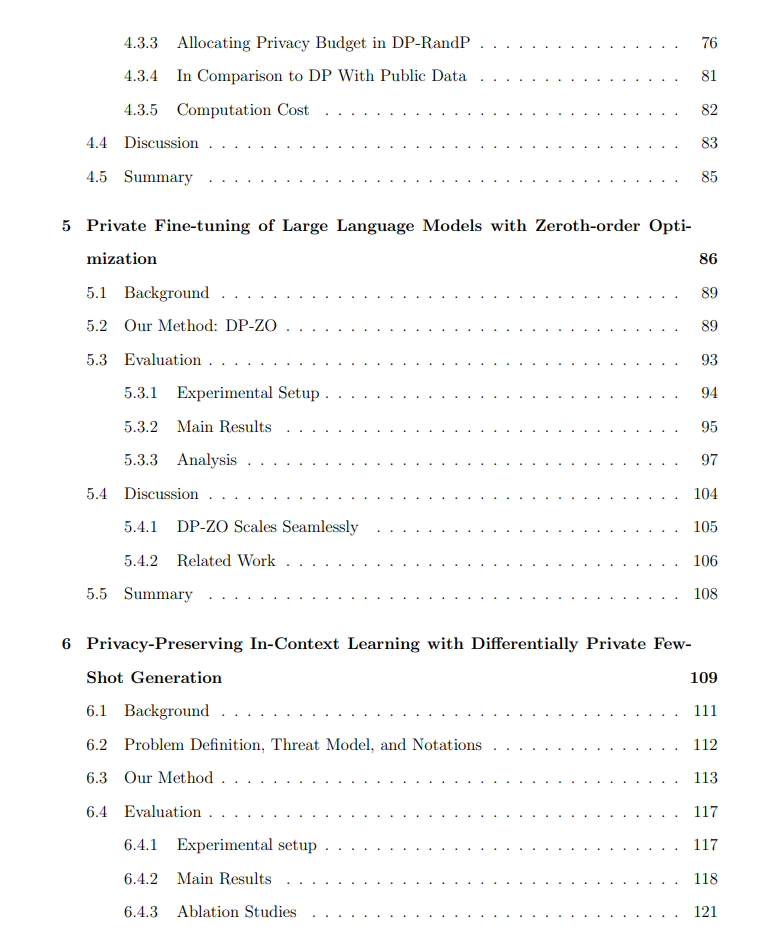

其次,我们研究了如何利用合成图像来改善差分隐私图像分类。尽管这些合成图像是在没有访问真实世界图像的情况下生成的,并且在非隐私训练中仅具有有限帮助,但我们发现这些合成图像可以为差分隐私图像分类提供更好的先验信息。我们进一步研究了如何最大化使用这些合成先验信息,从而释放其全部潜力以改进隐私训练。

第三,我们研究了零阶优化(zeroth-order optimization)的私有化,该方法已被证明在微调大语言模型时可以达到与随机梯度下降法 (SGD) 相竞争的性能,并提出了差分隐私零阶优化 (DP-ZO)。我们的关键见解是,在零阶优化中,从私有数据中派生的信息仅为一个标量。因此,我们只需要对这个标量进行隐私处理。这对隐私非常友好,因为我们只需要对标量添加噪声,而不是高维梯度。

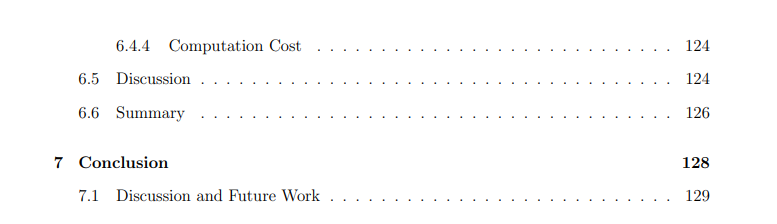

第四,针对差分隐私的合成数据生成,我们研究了仅通过 API 访问大型语言模型而不进行微调的情况下私密生成数据的方法。我们提出的方法能够为大型语言模型的上下文学习 (in-context learning) 提供隐私保护,并支持无限查询。

总而言之,本论文探讨了如何在差分隐私机器学习中有效地从数据中学习和生成数据,并为设计实际中的隐私保护机器学习模型提供了方向。