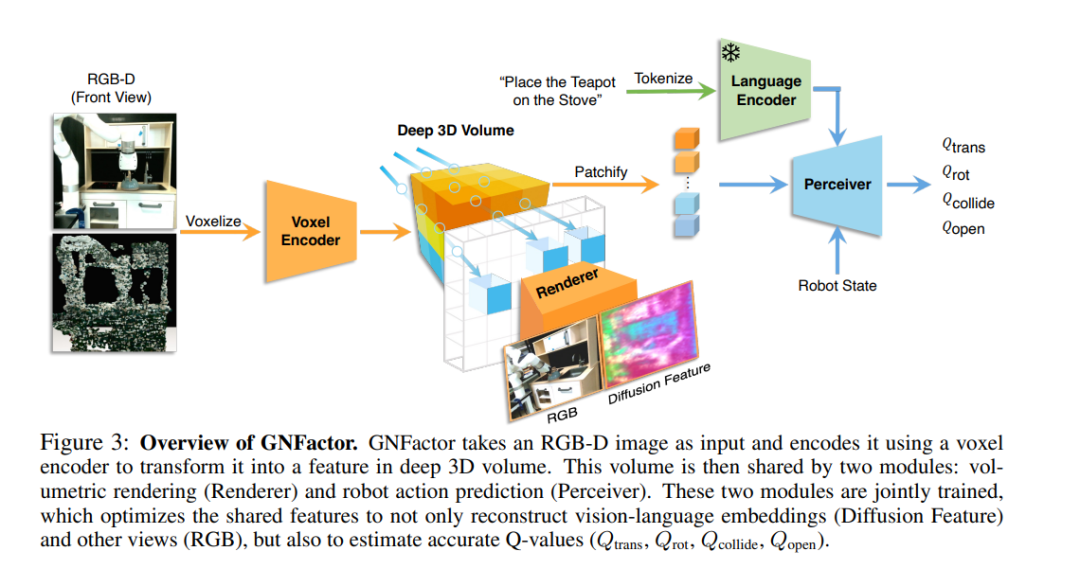

在机器人学中,开发能够在非结构化现实环境中根据视觉观察执行各种操纵任务的智能体是一个长期存在的问题。为了实现这一目标,机器人需要对场景的3D结构和语义有全面的理解。在本文中,我们提出了GNFactor,一种基于可泛化的神经特征场的多任务机器人操纵视觉行为克隆智能体。GNFactor联合优化了可泛化的神经场(GNF)作为重建模块和感知器Transformer作为决策模块,利用共享的深度3D体素表示。为了在3D中融入语义,重建模块利用视觉语言基础模型(如稳定扩散)将丰富的语义信息提取到深度3D体素中。我们在3个真实的机器人任务上评估了GNFactor,并在有限的演示次数下对10个RLBench任务进行了详细的消融。我们观察到GNFactor在已见和未见任务中比当前最先进的方法有实质性的改进,展示了GNFactor强大的泛化能力。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

152+阅读 · 2023年3月29日