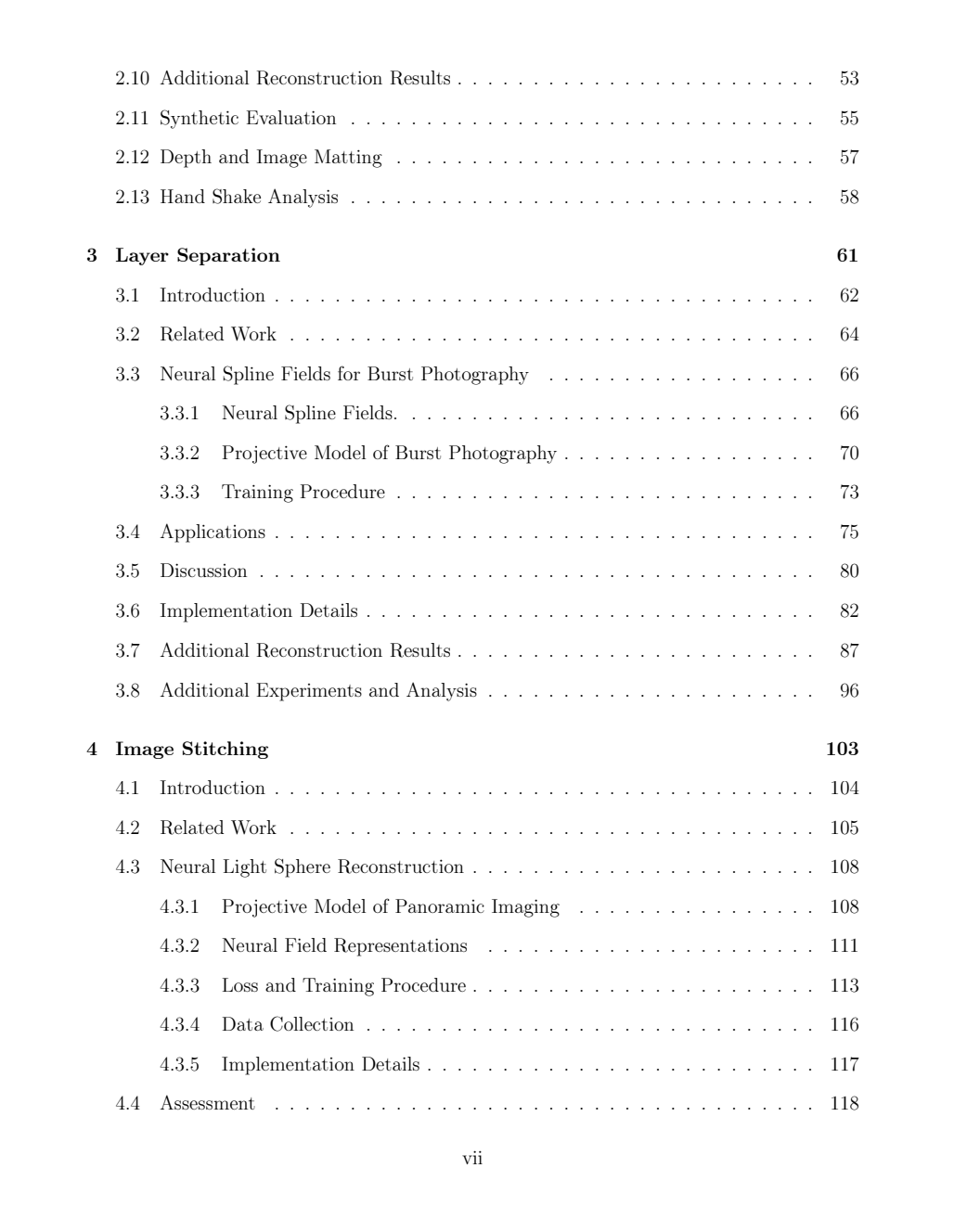

在过去的二十年中,移动成像经历了深刻的变革,手机迅速超越了其他所有形式的数字摄影,成为最主流的影像工具。如今的手机配备了多种成像技术——如激光深度测距、多焦相机阵列以及分像素传感器——同时还集成了诸如陀螺仪、加速度计和磁力计等非视觉传感器。再加上用于图像与信号处理的片上集成芯片,使得手机成为一种功能强大的口袋级计算成像平台。

与此相对应,近年来我们也见证了神经场(neural fields)的快速发展——这是一类通过训练小型神经网络,将连续的空间输入坐标映射到输出信号的技术,能够在无需显式数据表示(如像素阵列或点云)的情况下重建复杂场景。

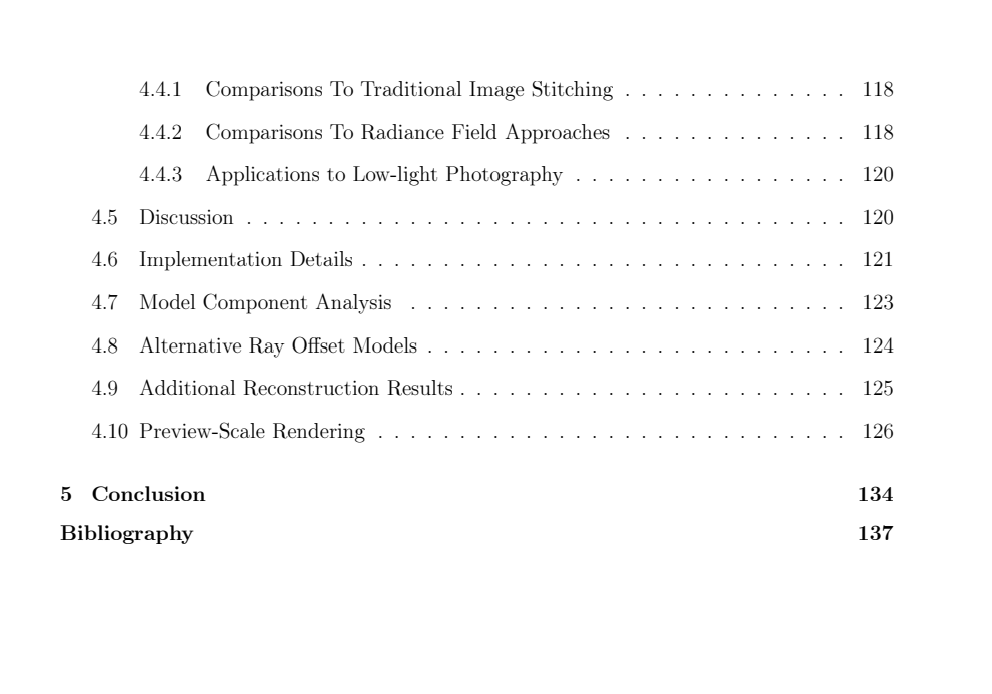

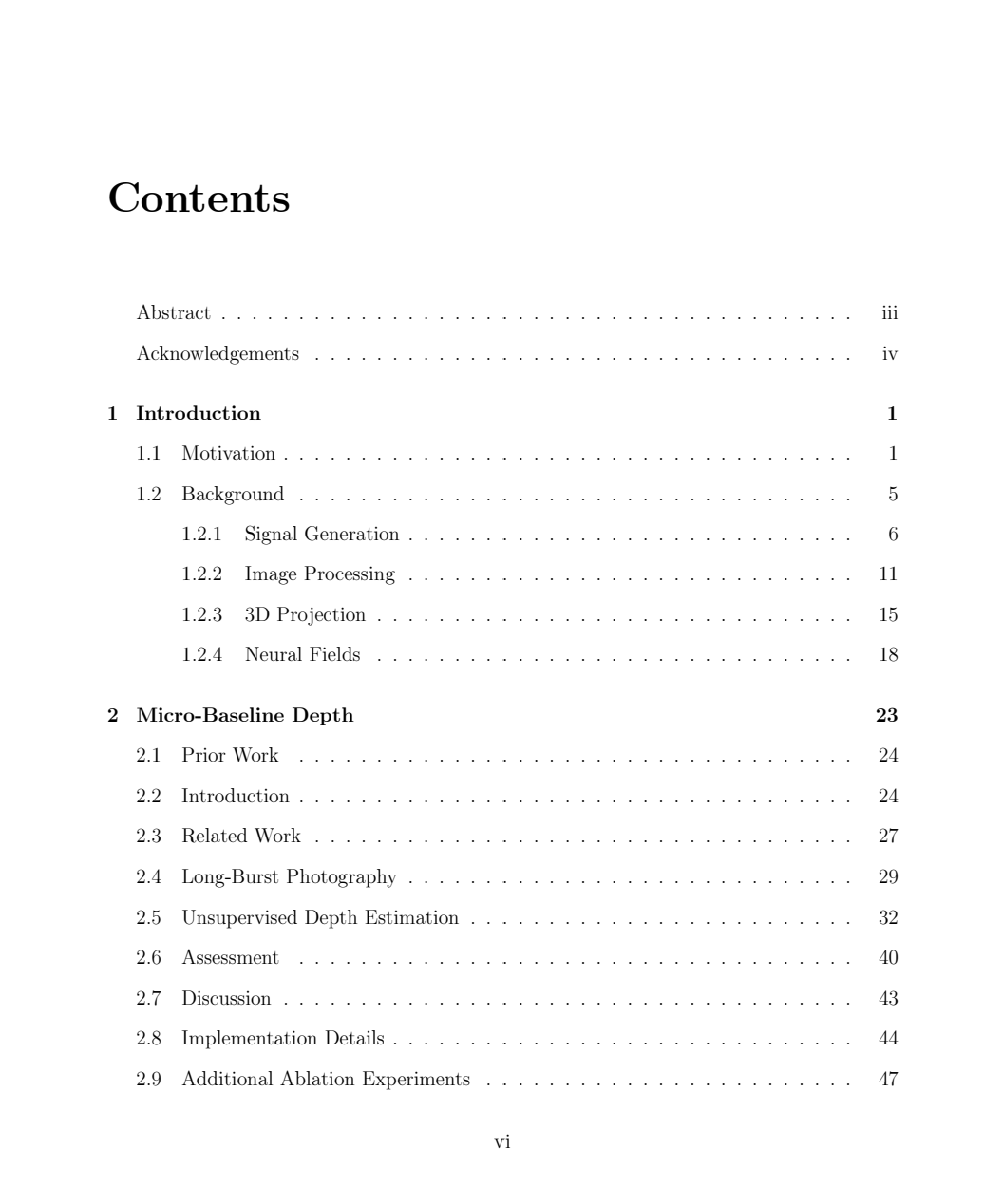

在本论文中,我展示了如何通过精心设计的神经场模型紧凑地表示复杂的几何结构与光照效应,从而支持诸如深度估计、图层分离和图像拼接等应用,直接从“自然环境下采集的移动摄影数据”中实现这些功能。这些方法在不依赖复杂的预处理步骤、有标注的真实数据或机器学习先验的情况下,依然超越了现有的先进方法。相反,它们依赖结构良好的、自我正则化的模型,通过随机梯度下降解决困难的反问题,直接拟合手机采集的原始测量数据。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

214+阅读 · 2023年4月7日