强化学习(RL)是提升国防安保行业无人机与机器人系统效能最具前瞻性的方法之一。本文在异常检测(AD)系统中探讨了强化学习作为模型选择标准(MSC)方法的潜力及其相关问题。强化学习算法使此类系统能够适应环境互动并从中学习,从而优化对复杂动态威胁的响应。通过这种方式,系统可引入具备更优决策流程的新状态,提升作战行动效能,同时让强化学习驱动的系统既能学习新场景,又能在实时环境下执行精细防御行动。因此,强化学习在国防领域的重要性可概括为改变威胁识别方式、威胁响应方式乃至防御策略构想方式的革新潜力。整合强化学习的自治系统能够在不可预测环境中运转,精准评估威胁,并几乎完全无需人工干预执行防御措施。这种多功能性在现代战争中至关重要,因为应对数年前未知威胁的首选方案正是此类系统。然而,将强化学习融入自主防御系统仍面临重大挑战:强化学习算法在多样化关键场景中的稳定性与准确性提升、自主决策的法律与现实影响、以及学习算法遭受对抗性操纵可能引发的威胁。此外,此类系统必须在国际国内标准框架下开发部署,以满足特定要求并建立应用公信力。本文通过案例研究与理论分析,深入探索这些战略应用与议题,全面阐述强化学习提升自主防御功能的技术路径,同时剖析相关重大难题,旨在论证强化学习具有定义国防技术发展轨迹的潜力,可在威胁不断升级的背景下增强国家安全体系。

强化学习(RL)是机器学习最重要的分支领域之一,专注于智能体在当前情境下为实现最高累积奖励而进行的决策行为(Sutton, R. S., & Barto, A. G. 2018)。这种方法尤其适用于无法用规则描述的环境——例如剧烈变化的战场态势,或其它无法通过明确定义规则调控行为的场景;因此该类技术可成功应用于军用自主控制系统(如无人机与机器人)。自控系统作为现代战术战略的核心要素,因其能最大限度减少人员直接参战从而降低伤亡风险,现已成为提升作战效能的关键。其中,无人飞行器(UAV)、无人地面载具(UGV)及机器人系统可执行从纯侦察监视到作战打击的多样化任务。

强化学习的整合已带来革命性变革,各系统能基于历史经验学习并实时决策,尤其在不可预测或敌对环境中效果显著。强化学习在自主防御系统中的典型应用体现于无人机与机器人平台:这些平台通过自主作战实现在多样化条件下机动并独立响应威胁。强化学习算法使系统无需针对所有突发状况单独编程,即可优化运动轨迹决策、目标识别及威胁规避策略。例如,自主无人机可被设定任务目标以穿越复杂环境、识别追踪目标,并协同其他无人机达成整体作战使命。强化学习通过增强战场机器人系统决策能力,使其能执行拆弹排爆、地雷探测乃至危险区域人员搜救等任务。基于持续行动结果学习机制,这些机器人的实战效能不断增强(Chen, X., & Liu, B. 2020)。从国家战略防御视角看,强化学习在自治防御系统的应用高度敏感。美国国防高级研究计划局(DARPA 2021)指出,强化学习通过提升不同自治系统效能助力军队获得竞争优势。军事领域的强化学习应用推动了全自主系统发展,大幅降低人工干预需求并优化军事资产配置。然而,强化学习融入自主防御系统仍存在亟待突破的瓶颈:除伦理冲突与自主系统军事行动法律地位问题外,责任归属与决策透明性难题,以及意外冲突升级风险(Smith, R. J., & Jones, A. M. 2019)均可能危及强化学习防御系统的稳定性。

自主防御系统

在定义自主防御系统时,此类技术被阐释为通过最小必要输入和指令进行操作或控制,并融合算法、人工智能及机器学习以实现实时决策执行(McLean, A. 2023)。这些系统由无人飞行器、机器人系统及人工智能自主载具等技术集合构成;其中部分系统用于监视、侦察、任务获取和作战目的,几乎无需人工操作员指挥。若缺乏对自主防御系统作用的理解,则难以充分认知现代战争形态(Smith, J. 2024)。其主要优势包括:首先,提升作战效率;其次,减少人力介入;第三,实现力量集约化;最后,构成战略核威慑屏障。无人机可在战场上空保持较长效滞空时间,这对规划决策至关重要。这使得数十至数百名操作员即可控制数百上千台机器人资产,从而在不扩编兵力的前提下提升军事编队整体作战效能(Brown, P. 2024)。然而在所有深度强化学习(DRL)技术中,强化学习(RL)因其能助力达成该目标而更适用于全自主防御系统。强化学习是一种将训练行为与决策融合的学习机制,模型通过奖励目标选择与惩罚不良特征来构建实践体系。总体而言,强化学习可应用于目标识别追踪、随机环境学习能力培养,以及开发防御型自由机动自主系统(AS)的新型任务规划方法。毋庸置疑,自主防御系统在军事领域属新兴事物且具备显著优势:高强度持续作战能力、规避人员伤亡风险及高效预警能力。强化学习的融合更提升了系统适应性,使其成为当代战争中至关重要的战略工具(Turner, M. 2024)。

动态对抗环境中的强化学习

强化学习(RL)是应对动态环境的强大工具,因其能在该类环境中学习最优策略。系统可随环境变化优化策略,使智能体在不可预测环境中有效运作。在机器人领域,强化学习已用于开发能适应地形变化或障碍物的机器人系统,从而提升操作效率。模型驱动强化学习、元强化学习等方法可训练智能体实时学习更新环境变化的能力。在防御战略中,强化学习必须应对动态环境、突发威胁及其他对抗行为。因此需采用对抗训练、多智能体强化学习(MARL)等方法。此类系统能在短时间内识别消除网络威胁,增强关键资产防护效能。值得注意的是,强化学习在非防御领域(如金融算法交易、自动驾驶)的成功应用,提供了可转化至防御场景的实践经验——例如应对市场管理信息系统(MIS)的交易策略生成。强化学习在高风险不可控环境中的成功案例,有力佐证了其在防御领域更广阔的应用前景。

基于强化学习的防御系统架构

1.传感器、执行器与决策模块的强化学习算法集成

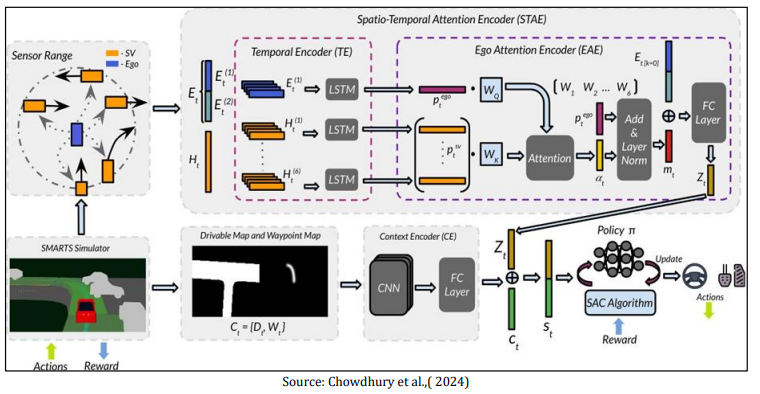

强化学习(RL)驱动的防御系统架构通常包含若干核心组件:传感器、执行器及机器人决策单元。传感器负责采集环境态势数据,这对强化学习至关重要。例如在自主无人机中,摄像头、激光雷达(LiDAR)与雷达等传感器将实时数据传输至强化学习算法以供决策(Ranjan等,2020)。执行器作为模型物理执行单元,负责实现强化学习模型的决策输出,例如调整无人机航迹或触发防御机制(Bhatnagar等,2022)。前文所述决策模块包含强化学习算法,其接收传感器数据并根据习得策略生成行动指令。这些组件必须实现无缝互操作,以确保数据流畅交换与行动及时执行(Gao等,2023)。该架构需精心设计以应对防御场景的耦合性与不确定性,这使得接口设计与集成成为刚性需求(Mousavi等,2021)。

图:RL驱动防御系统的组成和流程示意图

2.仿真环境在强化学习模型训练中的作用

仿真环境对防御系统强化学习模型训练具有关键价值。它们提供基于合成数据的训练环境,使算法在实战部署前获得充分训练。通过模拟特定作战环境与威胁态势,强化学习模型可在规避实弹测试风险的前提下实现能力提升(Lillicrap等,2015)。真实场景模拟是强化学习算法高效训练的另一要素,因其能复现复杂动态的现实环境(Tamar等,2016)。此外,仿真支持迭代优化——训练模型根据仿真评估的性能数据进行持续修正(Schulman等,2017)。此类高拟真仿真环境率先验证强化学习在动态对抗环境中的效能,并有助于解决模型实战部署前的潜在问题(Baker等,2019)。

3.实战部署挑战与软硬件协同设计考量

强化学习在防御系统部署中面临的主要现实问题包括:核心挑战在于仿真训练模型转实战部署时的性能落差。仿真环境与现实条件的差异可能导致实战表现不佳甚至完全失效(Tachet等,2020)。这要求采用软硬件协同设计策略——即针对特定系统同步设计处理器/传感器等硬件资源与强化学习模型等软件组件(Xia等,2019)。此外,强化学习算法在物理系统的实时性实现及不可控因素处理亦存重大难点(Kahn等,2017)。设计过程必须权衡关键因素:机载硬件的日常算力限制,以及确保强化学习模型在可靠性与响应时间方面满足严苛条件(Sutton & Barto,2018)。

强化学习在自主防御系统的战略应用

强化学习(RL)正成为提升军用无人机作战效能的前沿技术。基于强化学习的方法可优化任务期间无人机航迹规划与传感器控制,有效规避危险态势(Gao, Y.等,2021)。此类学习机制确能增强无人机环境适应能力,从而提升情报收集效率。在目标接战、任务分配与追踪领域,强化学习算法显著提高无人机战场目标定位与高精度追踪能力。自适应导航是强化学习在无人机的另一重点应用方向,通过训练无人机在拥挤敌对地形中的机动策略,实现实时决策并提升作战区域生存几率。协同强化学习技术已应用于无人机集群通信支持,使集群能够协同达成任务目标(Kuwata, Y.等,2019)。该技术在搜救行动、广域空中监视及突击作战中效果显著。强化学习在自主地面载具的控制应用,则实现复杂地形的路径点规划、后勤最优补给路线决策及战场态势自适应(Liu X等,2020)。机器人应用中,强化学习在拆弹排爆与救援任务中发挥关键作用——机器人通过历史处置经验学习,显著提升爆炸物处理精度与效率(Kalashnikov, D.等,2018)。多智能体强化学习对地面自主作战单元的协同防御至关重要:多类型机器人系统可协同工作、交换信息并同步行动节奏以高效应对威胁。水下无人机及海军防御系统中,强化学习算法用于在广阔模糊水域探索最优作战路径与策略。海洋极端环境下,强化学习驱动系统可改进路径规划、威胁识别及规避策略。此类系统能适应海洋环境的非线性特征、水文动态及敌对潜艇/水雷等风险因素。海军对抗期间需持续强化声纳等海洋探测器与强化学习的融合应用(Ma, H.等,2022)。